在近日于美国硅谷计算机历史博物馆(Computer History Museum)举行的美国国家工程学院(National Academy of Engineering)区域研讨会上,产业专家提出了工程领域面临的四大挑战:一是培育下一代的工程师,二是创造一种比HTML更具互动性的媒介,三是开发真正安全的物联网(IoT)系统,四是对大型数据中心面临的带宽危机做出回应。

曾任职于苹果(Apple)、迪斯尼(Disney)与惠普(HP),并曾在1970年代于Xerox PARC协助引领个人计算机(PC)概念的资深研究员Alan Kay认为,工程师们应该花时间到中小学的教室去提供像是培训“(职棒)小联盟”的服务:“我们得发展一种工程师文化;我们的服务理念必须直接传承给下一代…孩子们是不能等待的。”

不过他接着补充指出,要在工程技巧与教学技巧之间找到正确的平衡点很困难,也就是该如何有效地吸引年轻学子投入工程领域?举例来说,他讽刺地认为目前风靡各大学的大量开放性在线课程:“很恐怖…你需要有一些把互联网当成合法毒品以外工具的洞察力。”

Kay参与了一项美国国家工程学院于2002年发起、目标是定义出2020年工程师需求的计划,但该目前几乎没有任何符合该计划的进展,因此他呼吁工程师们能想得更远、定义大胆的行动方向:“工程师们为何不能自我‘重整(re-engineer)’?我们需要一种想象力放大器,让我们自己能因应未来无法预料的挑战,像是气候变迁等等。”

与数字世界的互动接口需要升级

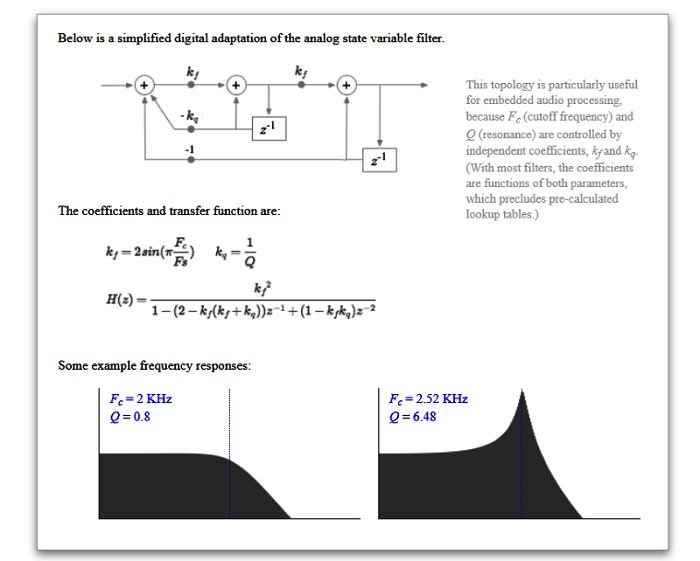

在Apple参与iPad开发的用户接口专家Bret Victor则让现场听众预览了一种令人惊艳的智能互动接口;如下图所示,对一个滤波器的描述能让用户对相关联的电路图、方程式与图表做改变,并看得到改变之后三者的变化。

*能提供互动体验且相互关联的电路图、方程式与图表程序代码

(来源:Bret Victor)*

他亲自示范如何移动各种元素:“这展示了图表、方程式与电路图是如何共舞,让你与系统之间取得其他方式无法提供的亲近感;”并表示有一些Google的工程师正尝试在他们即将出版的、专门讨论机器学习的数字刊物中利用这些技巧,他们可能会:“在每一篇文章中放进像是真人实境秀(100 hours)那样的东西,因此我们已经克服最困难的挑战。”

Victor表示,这种新的程序代码技术,可望催生一票精通写程序的绘图家;无论如何,这将带来更丰富、更高互动性的体验:“我们已经在让计算机快速移动位方面做得很好,但那些位所呈现的,仍像是我们习惯的印刷纸张;我们是把因特网当成大型传真机用。”

大会主持Vint Cerf认为,这种新技术将开启全新种类的读写方法,不过他也指出,底层的软件可能还要100年的时间才能跟着改变;其他人则认为,这种技术成就是从信息时代转移到某种体验的广泛行动之一;也有人指出,大型砖列触控显示器的开发也是另一种提供更丰富互动体验的尝试之一。

因应物联网的不安全感

安全专家Peter Neumann探讨了他参与的政府项目,目标是为可证明安全的系统铺路;他目前担任美国国防部先进研究计划署(DARPA)旗下CRASH (Clean-Slate Design of Resilient, Adaptive, Secure Hosts)专案的首席研究员,旨在打造能抵抗网络攻击的自愈系统。

Neumann指出,这类系统非常有必要,就算今日的设备采用硬件信任根(root-of-trust),例如ARM的TrustZone,能根据监测系统的电力使用情况或传送干扰能量脉冲,来防范跨频道攻击(side-channel attacks)或故障注入(fault injections):“我们已经来到了一个无法相信任何事情──无论软件或硬件──的地步,系统嵌入的最高级加密也无法保证安全。”

“若缺乏安全性,物联网无法长期生存…如果我们持续让事物上线,让它们能直接或透过其所在网络被破坏,就没有希望;”他认为那些标榜能保障物联网安全的厂商宣传,都是“不切实际的诈欺”,一切都是虚无飘渺。

CRASH项目已经为64位MIPS系统开发了一个正式规格,采用特殊的指令集:“如果没有正确的凭证,就无法链接相关联的对象,例如整个数据库或是某个应用程序;”Neumann表示:“我们正在使用正式方法来证明这种功能机制无法被绕道或是伪造──有鉴于这种架构,有希望能催生安全的物联网设备。”

从1970年代就从事安全系统开发的Neumann指出,他们开发的功能系统与以往他看过的都不相同,是真正跨出了崭新的一大步,但他也认为这个任务十分艰巨,参与这个原本预计为期四年之研究项目的研究人员们已经工作了六年:“我们可能会往第八个年头迈进。”

而他强调,就算该机制成功,也不能保证无坚不摧:“你仍会面临密钥管理问题、阻断服务攻击以及像是Snowden (编按:泄漏美国监听计划的美国中情局前探员)那样的内部泄密者,而这才是最糟的情况。”

数据中心带宽面临严重瓶颈

目前负担近四分之一整体因特网流量的Google,其连网部门负责人Amin Vahdat叙述了该公司目前面临的艰巨任务:“我们在连网方面需要大量协助,运算技术发展已经来到了一个十字路口,而连网技术将在运算技术发展过程中扮演超重要角色。”

根据阿姆达尔定律(Amdahl’s Law)每MHz运算需要1Mbit/s速率I/O的规则,Google拥有5万台服务器的丛集,就需要5 Pbits/s的带宽;相较之下,整个因特网总计需要的只是200 TBits/s的对半带宽;他表示:“这是一个(25MW)数据中心建筑中的一个丛集,而我们在全世界各地有数十做这样的建筑…因此我们需要所有的数据中心拥有比整个因特网还大的带宽。”

但Vahdat指出,随着互联网流量以及Google业务的成长,问题只会更严重;要因应网络升级又不中断服务,需要基础架构的改变;他举出Google面临的挑战案例,并介绍该公司最近为处理互连流量(peering traffic)推出的Espresso系统,牵涉了扩展做为因特网流量路由基础之边界网关协议(border gateway protocol,BGP)的功能。

Vahdat表示,BPG无法预测约只要20%时间的任务最短路径,但利用Espresso,Google基本上是在服务器上采用特殊应用讯号,来维护自己的路由映射(route map)与流量状况:“这种实时控制回路非常强大…也是我们打造储存与运算基础设施的方法,而现在我们将之应用于连网;”但他表示可以预见接下来五年升级网络带宽的方式,在那之后则状况不明。

而Vahdat也认为,数据中心应用的处理器技术将比网络技术先碰壁;关于这个挑战,他提及美国加州大学柏克莱分校教授David Patterson在同一场大会上的演说,Patterson是Google最近发表之张量处理单元(TPU)论文的作者之一,他表示TPU是新兴特殊应用处理器风潮的一部分,随着攸关晶体管性能提升的摩尔定律趋缓,这类处理器将越来越流行。

编译:Judith Cheng

本文授权编译自EE Times,版权所有,谢绝转载

关注最前沿的电子设计资讯,请关注“电子工程专辑微信公众号”。