采用 FPGA 器件来加速LLM 性能,在运行 Llama2 70B 参数模型时,Speedster7t FPGA 如何与 GPU 解决方案相媲美?证据是令人信服的——Achronix Speedster7t FPGA通过提供计算能力、内存带宽和卓越能效的最佳组合,在处理大型语言模型(LLM)方面表现出色,这是当今LLM复杂需求的基本要求。

像 Llama2 这样的 LLM 的快速发展正在为自然语言处理(NLP)开辟一条新路线,有望提供比以往任何时候都更像人类的交互和理解。这些复杂的 LLM 是创新的催化剂,推动了对先进硬件解决方案的需求,以满足其密集处理需求。

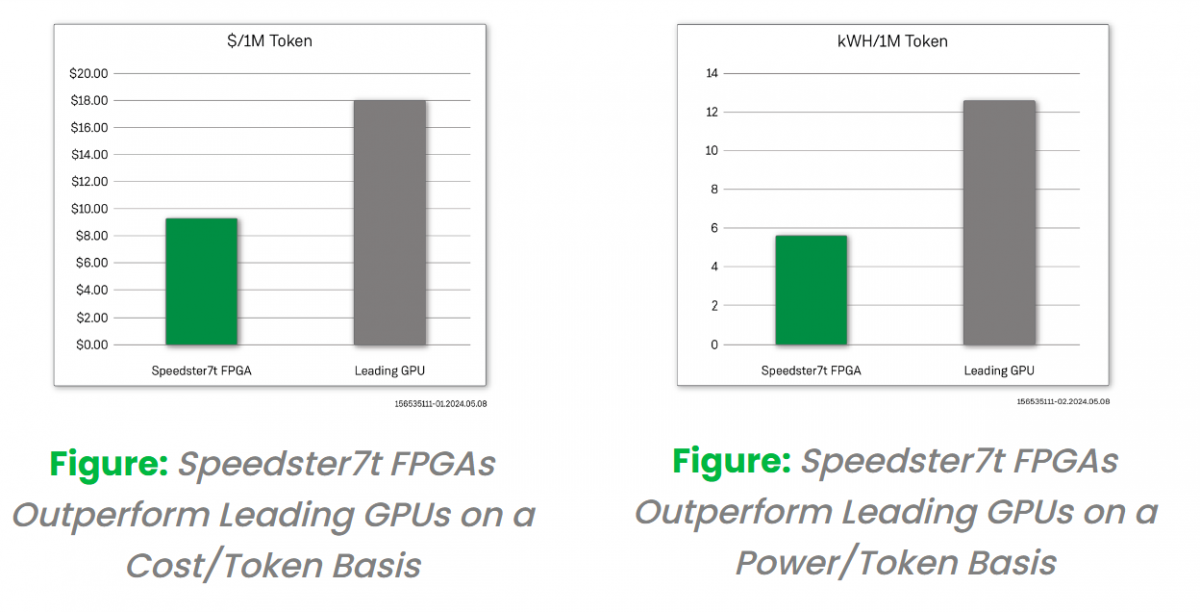

我们的基准测试突出了 Speedster7t 系列处理 Llama2 70B 模型复杂性的能力,重点关注 FPGA 和 LLM 性能。这些测试(可根据要求提供结果)显示了Achronix FPGA对于希望将LLM的强大功能用于其NLP应用程序的开发人员和企业的潜力。这些基准测试展示了 Speedster7t FPGA 如何超越市场,提供无与伦比的性能,同时降低运营成本和环境影响。

2023 年 7 月,Microsoft 和 Meta 推出了他们的开源 LLM,Llama2 开创了 AI 驱动语言处理的新先例。Llama2 采用多种配置设计,以满足各种计算需求,包括 700 亿、130 亿和 700 亿个参数,使其处于 LLM 创新的最前沿。Achronix和我们的合作伙伴 Myrtle.ai 对700亿参数的Llama2模型进行了深入的基准分析,展示了使用Speedster7t FPGA进行LLM加速的优势。

我们在 Speedster7t FPGA 上测试了 Llama2 70B 模型的推理性能,并将其与领先的 GPU 进行了比较。该基准测试是通过对输入、输出序列长度 (1,128) 和批处理大小 =1 进行建模来完成的。结果表明,Speedster7t AC7t1500在LLM处理中的有效性。

FPGA 成本基于由 Speedster7t FPGA 提供支持的 VectorPath 加速卡的标价。同样,我们在此分析中使用了可比GPU卡的标价。使用这些成本信息和每秒产生的输出令牌数量,我们计算出基于 FPGA 的解决方案的 $/token 提高了 200%。除了成本优势外,在比较 FPGA 和 GPU 卡的相对功耗时,我们观察到与基于 GPU 的解决方案相比,产生的 kWh/token 提高了 200%。这些优势表明 FPGA 如何成为一种经济且能效高效的 LLM 解决方案。

Achronix Speedster7t系列FPGA旨在优化LLM操作,平衡LLM硬件的关键要求,包括:

高性能计算 – 具有高性能计算能力的尖端硬件对于管理 LLM 推理核心的复杂矩阵计算至关重要。

高带宽内存 – 高效的 LLM 推理依赖于高带宽内存,通过模型的网络参数快速馈送数据,而不会出现瓶颈。

扩展和适应能力 – 现代 LLM 推理需要能够随着模型规模的增长而扩展并灵活适应 LLM 架构的持续进步的硬件。

高能效处理 – 可持续的 LLM 推理需要硬件能够最大限度地提高计算输出,同时最大限度地降低能耗,从而降低运营成本和环境影响。

Speedster7t FPGA 提供以下功能,以应对实施现代 LLM 处理解决方案的挑战:

计算性能 – 通过其灵活的机器学习处理器 (MLP) 模块支持复杂的 LLM 任务。

高 GDDR6 DRAM 带宽 – 确保以 4 Tbps 的内存带宽快速处理大型 LLM 数据集。

大量的 GDDR6 DRAM 容量 – 可容纳 Llama2 等扩展的 LLM,每个 FPGA 的容量为 32 GB。

用于 LLM 的集成 SRAM – 提供低延迟、高带宽的存储,具有 190 Mb 的 SRAM,非常适合存储激活和模型权重。

多种本机数字格式 – 适应 LLM 需求,支持块浮点 (BFP)、FP16、bfloat16 等。

高效的片上数据传输 – 2D NoC 超过 20 Tbps,简化片上数据流量。

扩展横向扩展带宽 – 支持多达32个112 Gbps SerDes 满足 LLM 需求,增强连接性。

自适应逻辑级可编程性 – 使用 690K 6 输入 LUT 为 LLM 的快速发展做好准备。

在快速变化的人工智能和自然语言处理领域,使用 FPGA 而不是 GPU 来加速 LLM 是一个相当新的想法。该基准测试展示了设计人员如何从使用Achronix的FPGA技术中受益。Achronix Speedster7t系列FPGA是这一变化的关键技术,在高性能、高带宽存储器、易于扩展和电源效率之间实现了出色的平衡。

基于详细的基准分析,将 Speedster7t FPGA 与领先的 GPU 在处理 Llama2 70B 模型方面的能力进行比较,结果表明 Speedster7t FPGA 能够提供高水平的性能,同时大大降低运营成本和环境影响,突出了它在未来 LLM 创建和使用中的重要作用。

如果希望进一步了解如何使用FPGA器件来加速您的LLM程序,以及 FPGA 加速 LLM 解决方案的未来发展机遇,请联系Achronix,获取详细的基准测试结果,并帮助您确定Achronix FPGA技术如何加速您的LLM设计。