“虽然我们已经经过机器学习、深度学习、生成式AI,到现在讨论更多的是怎么样能够落地企业AI,但我们离无处不在的AI其实还有很长的路要走。”英特尔中国软件技术合作事业部总经理唐炯日前在一场企业AI开放软件生态媒体会上指出,要推进AI无处不在,需要考虑三件事:

首先是加速创新。尽管生成式AI令人感到惊喜,但很多创新还没有真正落实到每个用户或企业的AI应用上。为了开发出真正不可或缺的“AI杀手级应用”,必须加快创新步伐,激励更多开发者致力于AI领域的开发和创新活动。

其次要使AI价值最大化。AI的互动不仅限于手机和PC等设备,更重要的是要为个人和企业带来实际价值。这意味着需要探索如何最大化AI的价值,包括在云、边缘和端侧的部署,以及如何将最合适的工作负载匹配到最合适的平台上,从而优化成本结构。

最后要实现灵活部署。AI技术覆盖了从算力基础到操作系统、数据库、大数据,再到应用的整个技术堆栈。为了实现不同软件模块在不同设备和不同硬件架构上的灵活部署,需要对AI解决方案进行解构,以便减少手动编码需求,并确保数据保护。

英特尔中国软件技术合作事业部总经理唐炯

开放

在唐炯看来,企业在部署AI解决方案时面临的最大技术挑战,来自于技术堆栈的复杂性和跨硬件平台效率的差异性,这决定了不可能有单一厂商能够提供全面的AI解决方案,而是需要多方合作。

因此,在加速创新方面,英特尔选择了关键词“开放”——即向围绕软件、围绕应用、面向个人和企业的开发者提供一个更加开放的资源平台,例如PyTorch、TensorFlow和Python等可编程的开放环境,以支持开发者进行应用创新。

同时,考虑到AI基础架构变得越来越多样化,在算力层面进行更多的兼容性优化就显得尤为重要。通过提供oneAPI、OpenVINO等开源工具,英特尔为开发者在异构底层平台上的兼容性和一次性编程的便利性方面提供了巨大支持。

关于可靠性,众所周知,AI推理当前还存在的一些“幻觉”问题,所以一方面要确保数据的可靠性和隐私性,另一方面要提升推理的准确度。“面对消费级应用,90%-95%的准确度是可以接受的,但在企业级AI层面,这个数字就完全无法接受。”唐炯表示,当前,英特尔正在与合作伙伴共同为客户提供更多的POC机会,帮助他们降低成本,并且能够让更多开发者的创新能够在集群化、可靠的测试平台上得到验证和优化。

开源

唐炯强调说,对开放AI生态系统的长期投入、以及对合作伙伴的支持至关重要,只有这样才能为用户提供更好的、更适合的AI解决方案。因此,英特尔希望推动解决方案的解构,以便实现灵活部署并减少手动编码,同时保护数据。这种解构策略旨在使生态合作伙伴专注于自身优势,通过合作提供定制化、高效的AI解决方案,从而促进AI在企业中的实际应用。

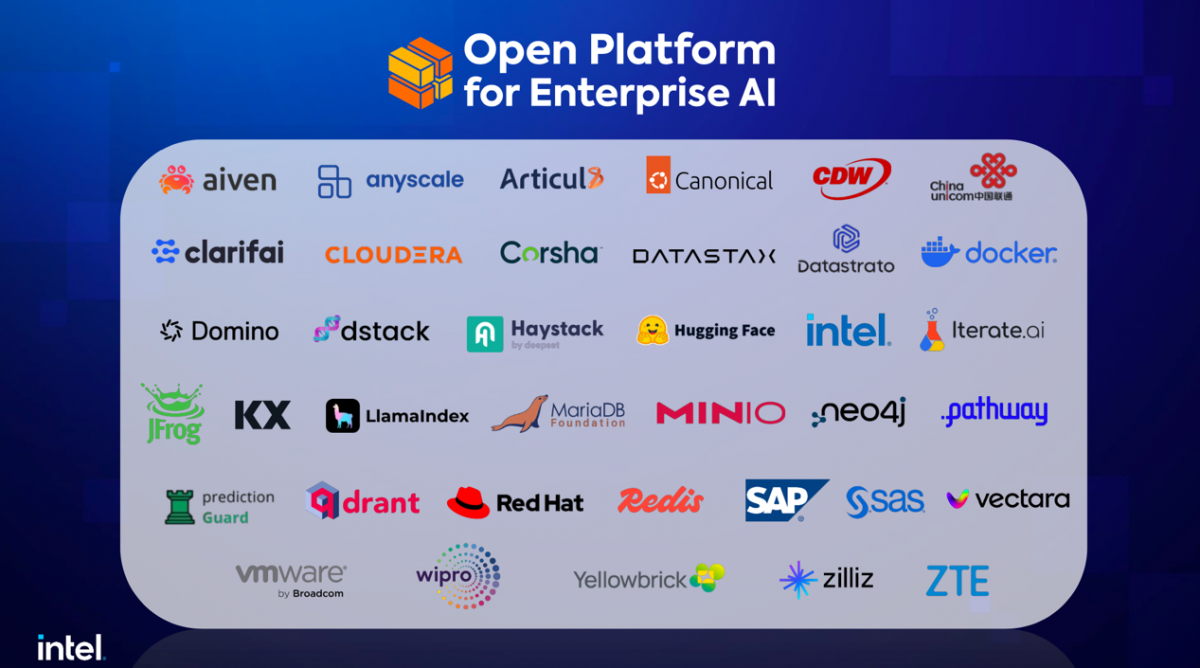

在全球范围内打造的AI开源社区“Open Platform for Enterprise AI”(OPEA)正是上述理念的体现,旨在促进更多的厂商共同开发企业级AI应用,共享各方的代码和模块,最终形成开放、透明的平台,让完整的企业级AI落地应用。

换言之,未来虽然会有更多的异构计算、创新应用和数据管理与治理方案,但是通过一个开放、透明的平台,通过开源社区的贡献,使得大家能够更便利地了解到自身所处的位置、能够在整个解决方案当中所做的贡献以及可优化之处,不至于因为某一个大模型选择错误而将整个应用推倒重来、重新编码,从而拥有更加灵活的配置方式。

在谈及AI时代与云计算时代对打造“开源开放生态”有哪些异同话题时,唐炯认为两者之间在很多底层逻辑上有着本质的区别:在云计算时代,通过任务调度和资源的多用户共享,实现了规模经济和成本效益,使得服务商能够通过细分CPU使用时间来降低成本并提高利润。然而,AI时代的计算需求改变了这一模式,因为无论是AI加速器还是GPU都是持续运行的,没有空闲时间,导致AI的成本结构与传统云计算截然不同。同时,为了在AI时代实现价值最大化,还需要将基础架构与AI应用紧密结合,并考虑在云、边缘和端侧的部署策略。

此外,AI时代除了调度之外,更多还是要考虑如何充分释放有限的算力,这就对硬件环境和算力利用提出了新要求。开发人员必须要考虑到异构计算环境中的负载协调、底层与应用层之间的高效接口匹配,以及数据安全和可靠性的重要性。考虑到应用的灵活性,还需要能够轻松地“热插拔”不同的大模型以适应不同的需求,减少因模型或数据库变更而需要修改整个应用或代码的情况。

也正是在这些因素的推动下,需要打造覆盖算力、基础设施、软件和应用等多个层面解决方案提供商的AI生态系统。这些提供商在专业领域各有优势,英特尔希望通过AI开源生态的不断完善,推动各个合作伙伴可以专注于自己的强项,实现优势互补,从而有效落地AI应用。

生态伙伴

东方国信副总裁兼CTO查礼着重强调了生态的重要性。他表示,智算时代中,硬件环境、交互体验、开发模式和应用构建的变革,是最值得注意的四个方面。比如原来主要集中在通算密集型应用的硬件环境,需要切换到包含GPU、ASIC等的密集型计算;再比如模型的适配,或是在不调整硬件的情况下,通过软件提升模型微调和推理的能力等等。

应用构建方面,从传统的LAMP技术体系,转向需要行业模型、知识库和工具链(如RAG和Agent)的现代构建方式,OPEA恰好涵盖了这些变革。这些变革为企业IT系统带来了由AI驱动和赋能的新机遇,作为软件开发商,东方国信希望构建一个由AI驱动并赋能的、重塑的企业IT系统,并与生态伙伴一起,共同推进国内企业级AI系统的发展。

“大模型作为智能时代的先驱,其主要作用是提升人类处理非标准化数据的能力”,孟凡军谈到。由于企业决策者对AI的理解程度有所不同,因此更需要像OPEA这样的框架,帮助企业理解AI价值、并推动AI的规模化应用。海鑫智圣总经理孟凡军强调了与英特尔在云端AI处理和边缘端部署方面的合作,特别是面临云、边、端精度统一的挑战时,他认为可以通过与底层芯片在云、边、端的紧密合作和底层拟合,实现数据集和精度的统一。

星环科技生态合作部总经理张雷则从近期《黑神话:悟空》带来的设备升级潮谈起,指出硬件销售和应用普及的每个阶段都有其特定的“抓手”,尤其是对于AI应用厂商而言,开发用户易于使用的AI产品是实现规模化的关键。

他强调指出,AI发展与数据密不可分,虽然许多大模型依赖公共知识和数据,但要在企业端实现大数据的真正落地,必须结合企业的私有化数据。星环科技与英特尔一直在企业端合作处理大模型和私有化数据,未来还将继续深化这一合作。