今年SIGGRAPH(计算机图形专业组)大会期间,黄仁勋(NVIDIA CEO)与Mark Zuckerberg(Meta CEO)炉边对谈时都提到每个企业和个人,未来都会拥有自己的AI agent(智能体)。Mark将企业和个人的智能体,与邮箱、网站和社交网络做比。他认为AI智能体也会成为如此这般的企业或个人标签。

黄仁勋则以“Jensen AI”黄仁勋本人的AI为例,“在Jensen AI里面注入我写的、我说的所有内容,用我回答问题的方式对它进行精调(fune-tune)。”“随着时间推理、使用过程中的积累,Jensen AI就能成为真正出色的个人助手和伴侣,回答问题、给出点子。”

生成式AI的重要性显然是已经无需赘言的。但要知道,这番对谈的场合是SIGGRAPH。SIGGRAPH以往作为一个专注于图形图像技术的顶会,真正被AI技术大举“入侵”应该是从去年开始的——而且是甫被“渗透”,AI就占据了C位。

黄仁勋在对谈开场说,SIGGRAPH现在是计算机图形图像、AI、机器人、模拟等技术相关的重要会议。今年NVIDIA在SIGGRAPH上发表的20篇paper全部都和生成式AI、模拟相关。从某种程度上来看,虽然SIGGRAPH存在的历史远比NVIDIA公司成立至今的时间更久远,但NVIDIA GPU产品的角色转变,就是SIGGRAPH探讨主题变迁的写照。

不过好在,SIGGRAPH的学术和技术呈现,很大程度还是在于AI与计算机图形学的交叉,尤其是AI for Graphics。借助NVIDIA在今年SIGGRAPH上的产品发布,及黄仁勋参与的两场炉边对谈,我们来谈谈AI和图形世界的交汇,及AI技术正对图形产生怎样深远的影响。

从图形图像设计师、艺术家、开发者实际去用生成式AI工具的角度,我们大致将这些工作分三步概括。

先把生成式AI带到OpenUSD

基于我们参与NVIDIA媒体活动的历史,如果要我们列举AI对于图形技术的帮助或变革,则至少可以给出如下两个大方向:

(1)从内容呈现角度,以DLSS为代表的AI超分、帧生成、光线重建等画面加强技术。此前黄仁勋就说过现在玩游戏,玩家看到的画面,每8个像素可能就只有1个像素是渲染出来的,另外7个都是AI生成的。

于是游戏、专业视觉设计的画面帧数、清晰度都因为AI得到提高。就像最近大热的《黑神话:悟空》,如果没有AI超分和补帧,大部分玩家大概都玩不起视觉质量这么出色的游戏。

(2)从内容创作角度,借助生成式AI,做3D内容生成。现在国内已经有数字艺术家开始用Stable Diffusion做贴图生成;还有一些CG创作者构建了新的工作流,通过文生图(text-to-image),和图生3D(image-to-3D)来辅助生成动画中的某些3D模型——彻底颠覆了以往先做概念图、三视图、建模等传统工作流程。

NVIDIA自己面向游戏modder推出的RTX Remix工具中,某些特性也可以归类到此间:不仅是为老游戏加上光线追踪和DLSS特性;基于老旧的游戏画面,生成式AI能推理出现代化的材质、贴图,并予以替换,重塑高清和增强纹理。

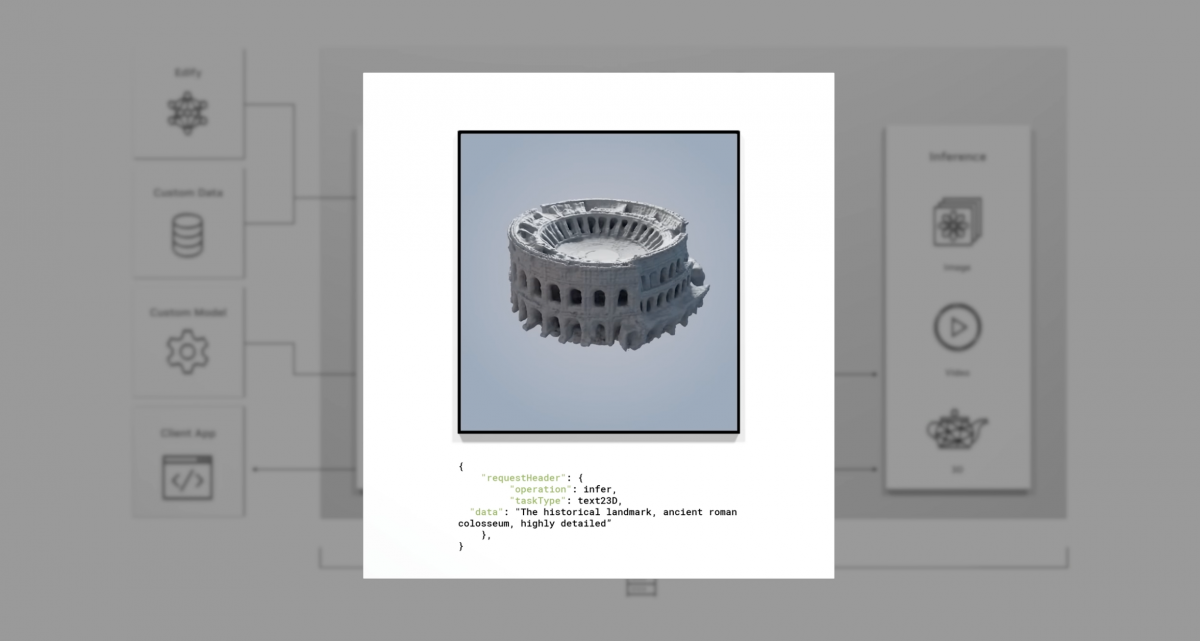

另外,还有个颇具代表性的3D内容生成应用,是去年发布的NVIDIA Picasso——其中就有个text-to-3D文生3D服务(基于Edify 3D模型),即借助文字描述就能生成相当细节化的3D几何体。

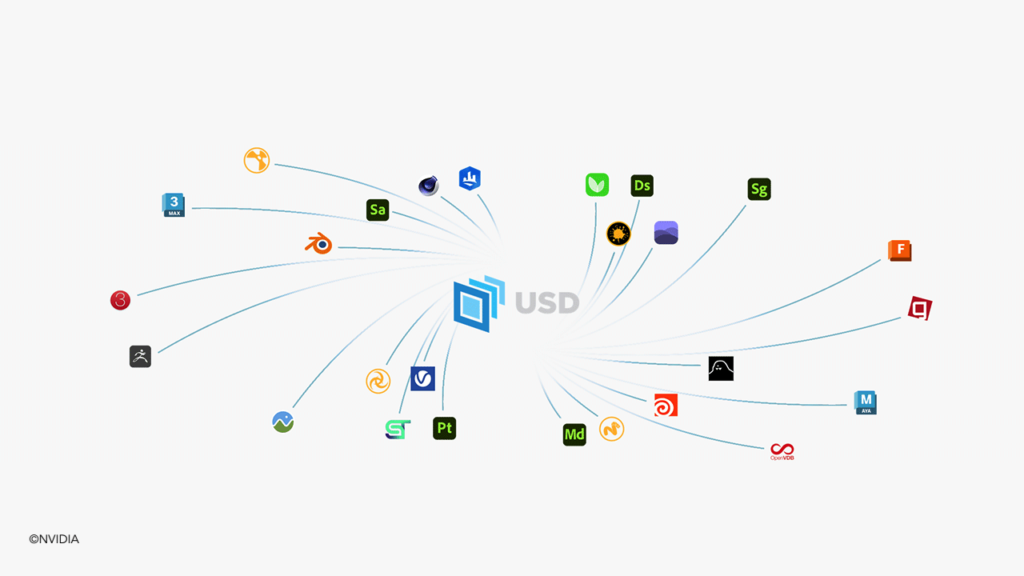

值得一提的是,Picasso生成的3D模型,乃至NVIDIA的元宇宙Omniverse,都是基于USD格式表达的。USD相对于3D图形,可类比为HTML相对于web;USD是3D数据表达的某种标准。它最早由Pixar提出,广泛应用于3D动画、CG等领域。

去年8月份,OpenUSD联盟(AOUSD)成立,Pixar、Adobe、苹果、Autodesk、NVIDIA、Linux基金会都是初始成员。OpenUSD的存在,让不同厂商的设计工具能够采用统一的语言来表达图形世界,实现内容间的互通。也很容易想见,作为元宇宙的Omniverse和更多协作设计工具,为什么会选择OpenUSD。

从某种程度来看,OpenUSD也成为了不同生态之间的开放接口。比如NVIDIA年初就宣布和苹果合作,将RTX渲染的画面传输到Vision Pro里面,面向Vision Pro开发者的Omniverse SDK也进入到了抢先体验阶段。此前NVIDIA还与作为开发者的Kantana、PTC和Rockwell自动化等合作,在Vision Pro中也能看到物理级精准、作为工业应用的AR渲染...

也就是说,作为3D图形的表达语言,基于OpenUSD做生成式AI开发,能够解决的问题会变得更多样。今年NVIDIA就特别提到要将OpenUSD应用到两个新的领域:机器人、计算流体力学CFD模拟——后者应当和工业设计工程是相关的。

有关机器人,NVIDIA构建了OpenUSD到URDF(Universal Robotics Data Format)格式的“连接器”,也就是让最广泛使用的机器人模型格式,与OpenUSD相兼容——只不过目前这项工作应该还处在早期;有关CFD模拟,自然是令其以OpenUSD格式来进行渲染。这两项工作对于推进OpenUSD与Omniverse生态,具备了相当的价值。

更重要的是,去年SIGGRAPH上NVIDIA首次提到几个Omniverse Cloud API,包括有ChatUSD、RunUSD、DeepSearch。其中ChatUSD是个对话AI,和它进行自然语言对话,就能按照需求生成USD Python代码,也就是生成3D场景中的对象、在场景中的摆放;而RunUSD用于检查开发者写的USD内容的兼容性、可用性;DeepSearch顾名思义,可用于搜索3D资产数据...

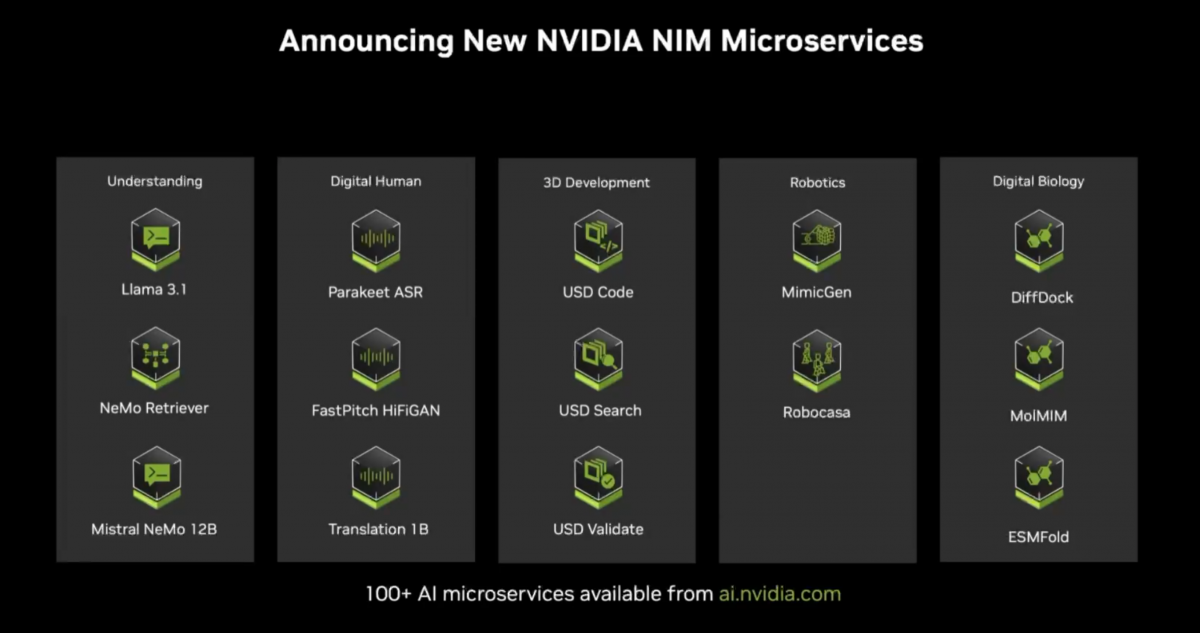

今年SIGGRAPH有了对应的三个重要发布——让它们的能力不再仅作为Omniverse Cloud API存在:新发布的模型以NIM(NVIDIA Inference Microservice)微服务的形式,当前可在NVIDIA API Catalog之上预览。

这三个新的生成式AI工具分别是:USD Code——理解OpenUSD语言,包括几何体、材质、物理和空间等要素的生成式AI模型,也就能够回答有关OpenUSD的问题,生成OpenUSD Python代码;

USD Search,使用自然语言或者图像输入,就能在大型3D和图像数据库中进行搜索;USD Validate,基于OpenUSD标准和发行版本,检查文件的兼容性,并生成RTX渲染的路径追踪图像(通过Omniverse Cloud API)。

然后装进NIM容器里

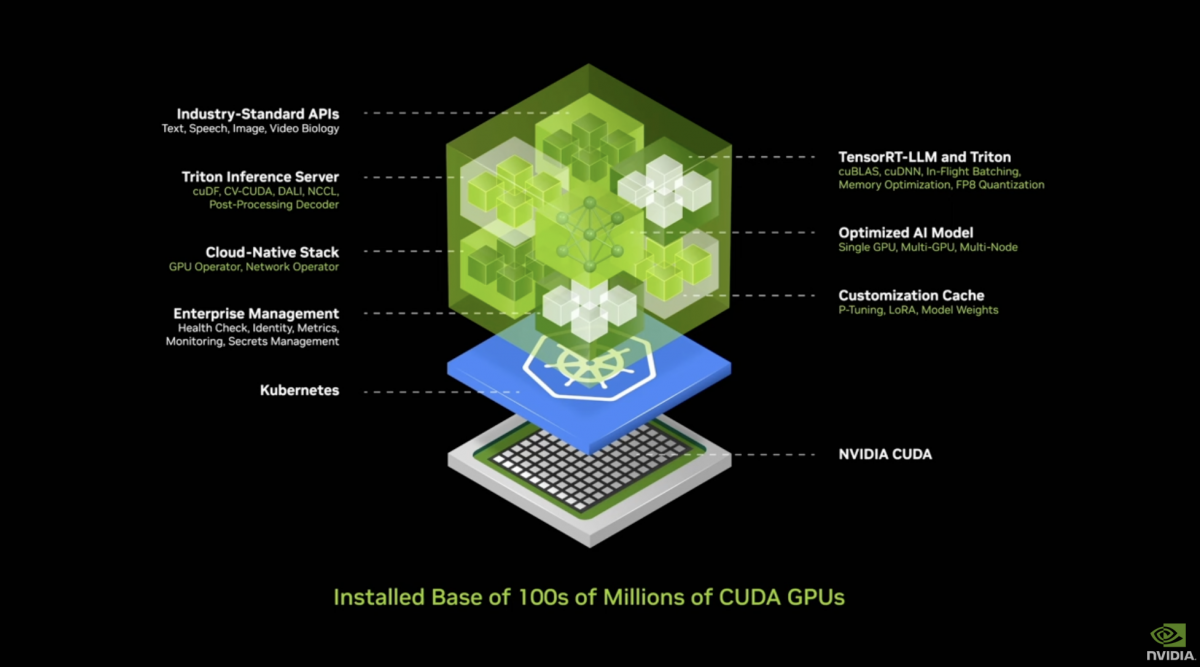

而这三个模型和能力,也都以NIM微服务的形式面向开发者提供。有关什么是NIM的问题,此前我们也数度撰文解释过。NIM内部本身有一大堆东西,除了AI模型之外,还有各种运行所需的依赖包、软件栈,及相关优化,面向开发者提供标准API接口。

简单用一句话总结:NIM是面向开发者简单部署生成式AI的全面解决方案,“是个简单的,面向现有产品平台嵌入即用的,达成差异化生成式AI特性、并具备出色竞争力优势的微服务”;不需要企业和开发者去费心巴力地处理相关AI乱七八糟的工作,显著降低部署AI的难度;用英伟达的话来说是做到AI的开箱即用。

所以对于企业或行业而言,NIM的价值简而言之是让生成式AI技术快速、真正投入到生产中。

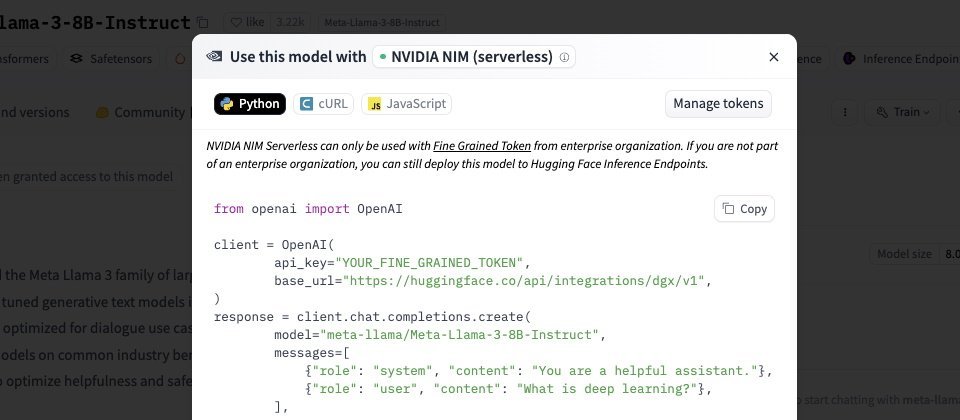

而且NVIDIA在宣传中也在反复强调NIM的性能。所以Hugging Face面向开发者提供基于NVIDIA NIM的Inference-as-a-Service,跑在DGX Cloud上时,据说其吞吐相比于没有采用NIM的服务快了最多5倍(今年中Computex上提供的初步部署数据还是3倍)。

目前NVIDIA已经发布的NIM微服务应当已经超过了100个,里面包括来自谷歌、Meta、微软、Mistral等的模型,跨不同领域及不同模态。本次新发布的NIM,即纳入NIM麾下的新模型包括Llama 3.1、NeMo Retriever、Mistral Nemo 12B等。像Llama 3.1这样的模型是刚发布的次日,NVIDIA就提供了对应的NIM。

媒体会问答环节,Kari Briski(NVIDIA生成式AI软件产品管理副总裁)表示NVIDIA关注社区当前流行的模型,及这些模型的授权方式和训练数据;同时基于NVIDIA自身关注的垂直领域和业务单元,以及客户需要,来考虑NIM的发布。

“Hugging Face上有75万模型,开发者很难搞清楚哪些质量高,哪些可以用于业务生产,哪些需要商业授权。”Kari谈到,“而如果是NIM,开发者可以相信这是充分审查、优化过的。”

前文提到USD Code, USD Search, USD Validate,作为推进AI for Graphics的3D开发模型,也自然成为本次发布的一众NIM微服务的组成部分。

同时NVIDIA也预告了很快会到来的,相关于OpenUSD和3D开发的新的NIM,包括有:

- USD Layout——基于文字输入,来组合多个OpenUSD场景;

- USD SmartMaterial——针对3D对象,智能预测和应用真实材质;

- fVDB Mesh Generation——由点云数据,生成基于OpenUSD的网格(mesh),藉由Omniverse API渲染;

- fVDB Physics Super-Res——针对单个或一系列帧,执行AI超分,生成基于OpenUSD的高分辨率物理模拟;

- fVDB NeRF-XL——用Omniverse API生成大规模NeRF...

本届SIGGRAPH上,和图形图像相关的NIM发布,还包括用于文生图的Edify NIM获得升级。Getty Images基于此对其API服务做出了更新,不仅有更高的分辨率、更好的画质,而且更贴合提示词要求,亦可在提示词中做相关摄影的焦距、景深等参数控制;

Edify 3D NIM也正式走向商用,也就是前文提到text-to-3D模型的NIM微服务。基于Edify 3D NIM的Shutterstock生成式3D服务进入商用——今年3月GTC上,Shutterstock才刚刚发布了该服务的抢先体验。

除了生成3D内容以外,Shutterstock的服务现在也提供针对3D场景,生成光照和360°背景的能力——主要是基于Edify 360 HDRi模型。这项特性目前开始提供抢先体验。

基于这些新的模型、NIM或商用服务的发布,有没有感觉在AI for Graphics众多技术的加持下,未来可能真的不需要多少3D图形专业知识,普通人也能快速进行3D设计?这和AI在非图形领域的应用也是类似的,好像人人都能画图、人人都能编程、人人都能写曲子那样。

“除了生成式AI以外,我不记得还有哪项技术能以这么快的速度影响个人、企业、行业,乃至科学的不同领域:气候、生物、物理科学......在我们面对的任何领域,生成式AI都是根本性变革的核心。”这是黄仁勋在与Mark Zuckerberg炉边对谈时说的。而AI for Graphics显然是其中的一环。

接下来,要让AI变得更可控

将生成式AI真正应用于内容创作或潜在的各行各业,固然能够让工作变得更为省时省力。但AI的一大问题在于结果的不可控。比如说用Stable Diffusion做个文生图,出图结果未必是艺术家预期的。

此前我们采访的数字艺术家普遍将这个过程称作“抽卡”——能不能抽到想要的,得听天由命;高算力GPU的快速出图,固然能够大幅降低抽卡成本,结果不可控的问题仍然是存在的。

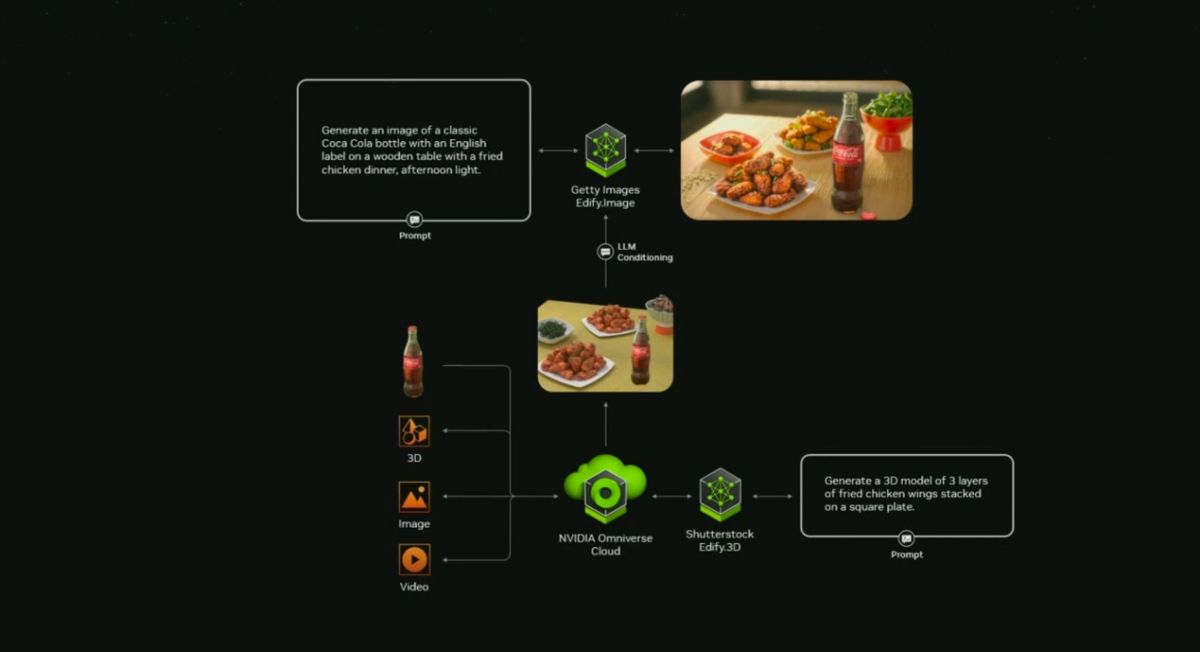

SIGGRAPH期间,黄仁勋在与《连线》杂志资深撰稿人Lauren Goode的炉边对谈中举了个例子,用Edify.Image模型,生成一张图片:文本提示是,午后光照下的一张木头桌子上,有一瓶可口可乐,旁边还有炸鸡。从PPT来看,出图效果固然相当不错,但其中细节是不可控的,比如具体多少炸鸡,可乐怎么摆、何种视角等。

为了解决可控性问题,NVIDIA提出的方案是首先借助于本文、图片、视频等多模态信息的数据,在Omniverse Cloud里面生成3D场景(包括可以用Edify.3D做text-to-3D操作)。黄仁勋在此对Omniverse的注解是“一个能够将不同模态数据,进行组合,形成内容产出的地方”。

在Omniverse设计环境中,就可以对各种资产做聚合、增减和更改。设计师和艺术家们因此有了完全的主动权——更重要的是相较单纯的text-to-image流程,这套方案是能够进行团队协作的。

然后对此场景进行2D渲染,并作为Edify.Image或者其他生图大模型的输入,也可以搭配其他文本提示词,最终生成完全贴合需求且更为精美的照片。在这样的图片中,包括可乐与炸鸡的位置关系、景别等在内的特定需求和因素都做到真正的满足与可控。

目前WPP已经开始采用这套工作流,而且给可口可乐公司做全球广告方案就是他们最早的用例。所以设计行业最早接受生成式AI的洗礼是有道理的——发展到现在,这个行业已经在做AI相关不同工作流的重整和探索了。

黄仁勋形容这个流程有些类似于RAG(retrieval augmented generation),一般我们说RAG是让生成式AI更可控的常规方案,只不过此例更准确地说是“3D augmented generation”。

按照这个思路往下走,不单是图形图像领域,当生成式AI进入到生产或工作流程中,则添加中间节点,做“增强生成”,会是未来AI最终产出结果实现可控、减少模型不确定性的关键解。

最后做个总结:首先全面推广OpenUSD标准与生态,将这种格式、标准用在设计领域、用在数字孪生和元宇宙里头——“OpenUSD是第一个,从不同的工具、将多模态数据聚合到一起、令不同工具和生态间可做交互、而且作为虚拟世界出入口的格式”——这是黄仁勋对于OpenUSD的总结。

OpenUSD扩展到机器人与工业控制领域,就是这番话的写照。然后面向OpenUSD,去做生成式AI模型与技术,令这些AI模型可以为图形图像及潜在更多领域做贡献:包括理解、验证USD格式,可做3D资产搜索,及各类直接生成3D内容的AI。

再把这些AI以NIM微服务的形式,提供给开发者和企业客户,降低AI开发门槛的同时,加速生成式AI全面投入商用和生产。最后,基于已构建的AI模型和NIM微服务,力求通过工作流的创新,打造更为可控、可协作的AI。

NVIDIA的这套逻辑还是相当清晰和脚踏实地的。我们过去半年也和不少数字艺术家、图形图像设计工作者,以及工具链上游的模型开发者交流过。短短半年内,AI对该领域的变革是深刻而迅速的。

当很多人在质疑生成式AI能不能用来生产时,不单是SIGGRAPH这种顶会将其作为首要议题探讨,很多行业参与者已经用它来赚钱、产生行业价值了。