今年初的CES展上,Intel宣布进军汽车市场;当时还发布了旗下的“第一代软件定义汽车(SDV)SoC”芯片产品。

最近Intel又发布了面向汽车座舱的Arc(锐炫)车载独立显卡,具体型号Arc A760-A。对Intel的PC产品熟悉的读者应该知道,Arc是过去两年Intel面向PC热推的显卡品牌,我们此前也分别体验过Arc A750和A770;原来A760的型号是要分配给汽车的。

这是一颗AI算力标称229 TOPS的独显,被Intel称为“目前座舱中最强大的GPU”,“重新定义了智能座舱性能天花板”。Arc A760-A预期的上车时间是2025年。

就像PC平台配独显的思路,图形和AI能力因此赋予座舱,也能轻松摘取性能冠军。隔壁高通的座舱芯片仍以集成GPU的SoC为主,而英伟达做的则主要是ADAS/自动驾驶芯片,Intel的独显也就有了市场机会——但这绝对不是全部。

Jack Weast, 英特尔院士、英特尔公司副总裁、汽车事业部总经理

用PC和数据中心的思路,来做汽车座舱

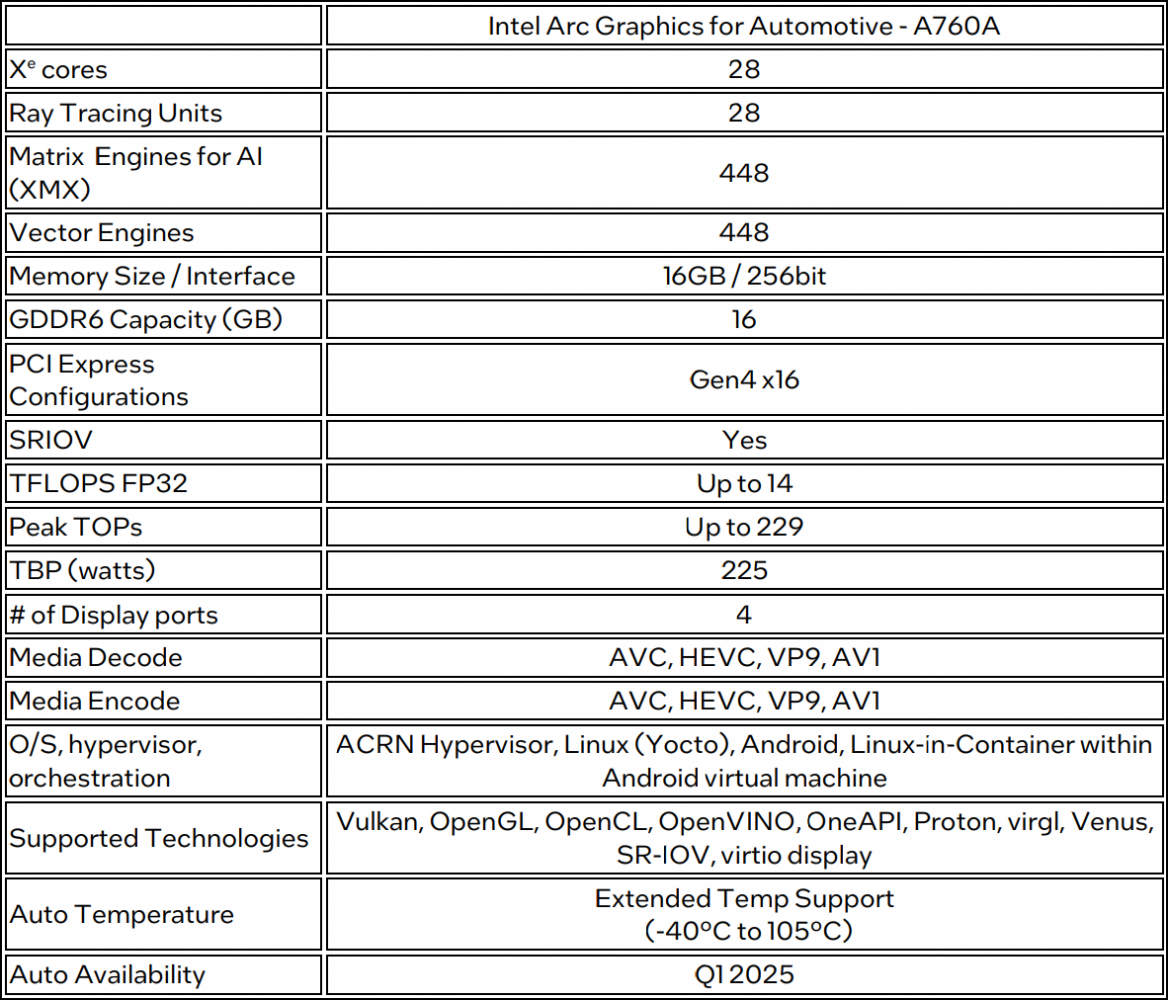

照例先来看看Arc A760-A这颗芯片的配置:采用ACG-G10 die,28个Xe核心,也就是448个矢量引擎。对Xe架构熟悉的读者不难发现,这应该是一颗在规格上和PC平台上Arc A750很相似的GPU——同为ACM-G10,binning到28个Xe核心(核心频率上相较A750略低);配16GB GDDR6显存;TBP 225W...

所有Intel Alchemist的特性,这颗芯片也基本都有。包括它也支持光线追踪,配有XMX矩阵扩展引擎;显示引擎方面强调支持4路显示输出,4K分辨率;媒体引擎支持HEVC, VP9, AV1等主流格式编解码——适配IVI使用场景......对这颗芯片相关规格感兴趣的读者,可以去关注我们此前撰写的与其同源的A750的体验文章。

不过在面向汽车时,Arc A760-A自然有一些特有技能。符合车规要求,包括宽温、严苛环境的高等级可靠性、稳定性是基本属性。另外Intel在新闻稿中提到基于Linux、汽车软件与优化的驱动;图形方面特别强调支持OpenGL与Vulkan,支持“高性能3A级游戏”;

SR-IOV(Single Root Input/Output Virtulization)虚拟化方面,“在虚拟机环境中提供40%性能提升,增强安全性、隔离性和鲁棒性”;另从国外媒体的报道来看,这颗GPU也支持至多6路摄像头输入...具体规格参见下面这张表:

实际上,基于既有优势平台,一个架构覆盖多应用领域是当代芯片企业的常规操作,英伟达、高通也普遍是这么做的。不过我们依然能从发布会的只言片语体会到,Intel在汽车中贯彻PC和数据中心的思路、为汽车带来PC和数据中心平台的经验和设计。

比如Jack Weast(英特尔院士、英特尔公司副总裁、汽车事业部总经理)谈到Intel正制定新的行业标准SAE车辆平台电源管理标准(J3311),“将PC电源管理理念引入到汽车平台”;李映(英特尔公司副总裁、英特尔中国软件和先进技术事业部总经理)则在谈AI座舱开放软件平台时,提及这是“基于同样的开放思路,和合作伙伴一起打造PC、云时代开放软件架构”;

高宇(英特尔中国区技术部总经理)则说,得益于AI PC上的积累,车载平台也实现了与中国本土大模型的快速适配;乃至在发布会上,Jack宣布为提升座舱体验,Intel和EPIC Games合作,将虚幻引擎“从个人电脑带入汽车”,“在车里打最顶级的电脑游戏”——称得上相当的PC主义了。

在接受采访时,Jack说PC生态“给予了我们相当的基础优势”;但汽车与PC也有诸多不同之处,除了众所周知的车规级可靠性、稳定性要求,还有像是“来自数据中心的虚拟化特性”,Jack谈到,”我们今天发布的独显就特别支持SR-IOV。”

“PC、数据中心,和现在的汽车,的确存在极大相似。”李映谈到,“从软件架构角度来看,汽车底层系统级别,更像是数据中心,包括虚拟化、不同的域和安全等各方面考虑;但上层用于体验,典型像是AI应用,又和PC非常相似;与此同时,汽车的部分传统legacy应用又是基于移动端的。”

“未来的软件架构需要将这三种不同的用户体验、生态进行融合。Intel在数据中心有软硬件方面的投入和基础,PC端更不用说,另外通过IBT将移动端的能力嫁接到x86平台。”李映强调,“可能在业内也很少能找到这样一个技术企业,具备这样的能力能够将三个不同的生态融合在一起。”

Jack还有个说法很有意思:“今天我们谈到的不少应用场景,典型像是生成式AI、LLM大语言模型,都是发端自数据中心,是数据中心的软件定义架构,而不是来自手机和平板世界。”“LLM、AI,拥抱虚拟化、编排(orchestration)、容器(container)等技术都是当代软件定义汽车架构的组成部分。Intel在过去几十年内就构建和驱动了这些技术。”

“汽车架构、软件生态、使用场景和市场预期,这些都和Intel过去的强项对映,尤其是我们在数据中心、AI PC上的专业能力。”有关Intel做汽车芯片的业务逻辑,我们在年初CES的报道文章中已经做了详述。

座舱为什么需要229TOPS算力?

我们知道GPU的主要价值除了图形渲染,就是AI加速了。这也是台式机和服务器产品上Intel GPU发展至今的努力方向。

图形渲染是GPU的本职工作。除了前文提到Intel打算把虚幻引擎引入到车内,这次发布会活动展示与舱内图形渲染最相关的应该就是滴水OS的3D HMI交互了。滴水OS是中科创达开发、面向中央计算的整车操作系统。

耿增强(中科创达联合创始人兼执行总裁)介绍说,过去6个月中科创达和Intel一起将滴水OS移植到Intel车载平台上。而这款操作系统的一大优势就在于基于KANZI的3D引擎实现的“情景化HMI”体验。钱强(Rightware CEO)说,车上的HMI体验应该是“一镜到底”,而非单纯多层级的卡片式。

真正“沉浸式”、连贯的体验,应当包含有“3D仪表、汽车、环境、天气、地图、车辆配置器、时间变化等”,“所有的东西一镜到底”。钱强认为“这是未来的趋势”。

所以滴水OS的3D HMI人机交互界面覆盖从车启动、3D地图到泊车等“一镜到底”的主要应用场景。具体到呈现上,包括汽车本身、周遭场景——多样化的视觉体验,无论是沙地场景、汽车驶过造成的扬沙,还是雨天地面的反射和溅起的水花,亦或汽车内饰的完整呈现...据说这一大型交互场景演示渲染包含650万三角形,基于Arc A760-A做到了实时交互的60fps满帧运行。

高宇在采访中说,即便是这样一个大规模的图形渲染HMI交互场景,“也只吃了(A760-A)30%的算力”,“剩下70%可满足AI大模型需要,实现3D+AI大模型的并发。”所以在Intel看来,Arc A760-A的图形和AI算力,都是座舱需要的。

高宇认为Arc A760-A是现在为数不多真正实现了本地推理AI大模型落地的座舱芯片产品。一方面,这款显卡支持14B参数量以上的模型——且6B模型首token时延0.058秒,吞吐量88 tokens/s——应该是基于智谱GLM模型的测试结果;而不少30-40TOPS算力的NPU跑6B模型首token都可能>3秒。

另一方面,充沛的算力令其可实现多模型并发,比如同时运行两个7B模型,或者4-5个2B模型。“OMS、DMS以及舱内的很多CV类应用都可能都需要用到AI。”加上多个大模型并发需求,“是那些几十TOPS的NPU根本做不到的。”

“我们认为这是用户需要的。今天也和我们的合作伙伴一起展示了,他们基于这样的性能能做什么。这就是我们认为这个算力级别会成为舱内体验所需标配的原因。”Jack补充道。

若要列举座舱AI应用场景,高宇提到AI智能座舱要担纲虚拟副驾、出行伴侣、商务秘书、创意助手、健康管家等不同职务。

虚拟副驾是指在驾车者可在双手不离方向盘的情况下,进行各种操作,包括现在很流行的“车书问答”——即LLM能解答某些在汽车说明手册上才能找到的复杂操作;出行伴侣则涵盖导游、家庭亲子互动之类的特性;商务秘书是让座舱成为生产力助手,进行商务会议、总结会议纪要、实时翻译等;

创意助手借助车载摄像头记录的照片和视频,进行AI剪辑、照片分类;健康管家可以融合车内的不同传感器,通过多模态感知能力,监测驾车者的身体健康、疲劳与压力水平,提出坐姿调整建议、调节车内照明与温度等...

“英特尔的dGPU是当下能够在座舱内运行如此大规模大模型的唯一选择。”高宇总结说,座舱本地进行AI推理无需依赖网络、即时响应、保护隐私安全,以及借助RAG等技术能够做到高度个性化定制,都是需求Arc A760-A本地算力的依据。

生态建设及软件架构关键词:开放

有了芯片和算力基础,上层生态兴盛与否才是Intel座舱战略能否延续的关键。

据说除了AI模型供应商、操作系统供应商、应用开发者在发布会上站台以外,参与发布会的还有国内TOP 20的主机厂和诸多Tier 1企业。虽然Intel并未透露任何有关芯片上车及定点数量信息,不过Jack提到这次发布的芯片预计2025年上车做商业部署,“芯片和开发板都已经准备就绪。”“而且我们有庞大的软件生态,也已经准备好了。对我们的车载dGPU感兴趣的汽车制造商很快就能用上。”

这里Jack提到的软件生态,必然包括CES初代软件定义汽车SoC芯片发布以来的生态建设工作。但实际上,如本文第一部分所述,这也很大程度上是指Intel在AI PC及数据中心领域积累的生态。

李映谈Intel的AI座舱软件方案,更是将思路扩展到了Intel网络与边缘计算——毕竟汽车本身就是一种相对特殊的边缘系统。一旦涉及到Intel的边缘平台,主旋律无疑就是“开放”了——前不久我们在Intel NEX Summit大会的报道中就剖析过。

所谓的“全栈开放软件生态”也为现在要构建的AI座舱软件生态,打下了基础。

无论是包括ACRN, Linux, Celadon在内的组合方案,Intel深度参与并融入中国开源生态,还是跨操作系统生态支持——包括前文提到的IBT技术,以及Intel在AI软件栈和开发工具方面的投入和方向,都能反映“开放的软件架构/生态”。本文不再对Intel的“开放生态”多做着墨。

相对于在数据中心和英伟达一较高下,Jack也将“开放”思路作为Intel在汽车领域与竞争对手对垒时的优势项。“客户需要更具(性能)伸缩性,能够做到软件复用、从高端到入门车型全覆盖的解决方案;他们需要更为开放的生态系统,去追求差异化。而不是大家都用上相同的解决方案。”

“在Intel的平台上,汽车制造商有(在各层级)选择的自由。”关注Intel数据中心及行业边缘策略的读者,对这番话应该会非常熟悉——这体现的更是Intel的整体技术战略。所以并不意外,Intel对于“未来AI座舱软件架构”有如下展望:

以本地算力为主的“座舱AI计算中心”,集中传感、控制、计算等资源,“通过多系统的虚拟化整合、打包,实现底层优化,保证不同颗粒度的异构任务调度和高效内存管理”;“提供跨平台推理引擎优化和支持”;还要协同利用好云上算力;

另外更重要的是此处提到的AI Task SDK & API,“通过优化计算能力和模型服务的网关实现”。上层应用通过统一的API调度软件平台提供的各种AI服务,如文生图、意图识别、语音处理等;AI Task SDK根据实际情况编排本地和云的AI算力。

“基于统一API标准,应用和大模型供应商可专注于业务开发;OEM和Tier 1供应商可以更灵活、便捷地从ISV供应商中组合参考组件,构建定制化AI解决方案”;最终“提高开发效果、降低成本”。

这应当算得上是计算机科学思路指导下、软件定义汽车的标准答案了,毕竟现在的汽车还不是单纯的计算机。可能对于的确在形态和应用上更贴近PC的座舱而言,这的确是一种行之有效的思路,只不过这需要各环节参与者进行生态共建。

本文最后,我们想再提一提Jack对于Intel做软件定义汽车芯片优势的看法:即现代软件定义汽车的系统架构更靠近数据中心,而非源自手机或平板。这一点原本是我们在采访中提问Intel相较高通这类驾舱芯片竞争对手有何优势时,Jack提到的论点。

他打比方说手机和平板擅长做的始终是单用户、单操作系统环境负载;“对于数据中心而言,里面有不同的操作系统、海量的用户。”而汽车制造商未来要拥抱的方向更靠近后者,“需要不同的操作系统,同时维系兼容性;他们需要拥抱容器或虚拟机之类来自数据中心的概念。”

“这对汽车行业而言是个巨大的转变,和过去那套全部都是嵌入式实时操作系统的时代不一样。这也是生态系统在演进的例子,是我们都需要协同合作的未来。”

无论这种强调数据中心优势,以此表明在汽车领域优势的说法是否确切,软件定义汽车的未来都确如Jack所言。而且这个说法,其实与李映展望的未来AI座舱软件架构所体现的内核也是高度一致的:相当的Intel,且完美表征了Intel一路走来的PC与数据中心血统。