最新的数据显示,OpenAI在全球最大人工智能训练项目上所花费的计算量,从2012年开始就以每年10倍的速度在增长。以ChatGPT为例,2022年11月,当GPT-3版本的ChatGPT第一次发布的时候,参数量约为1750亿。然而仅仅几个月之后,新版GPT-4的参数量就达到了惊人的1.5万亿。毫无疑问,今后随着AI模型变得越来越复杂,功能越来越强,加之每天都在产生的数据又会反哺AI模型的训练,这些AI训练数据集的规模和算力还会保持非常高的增长速度。

“能在如此短的时间内取得如此惊人的增长,有赖于处理这些海量数据的服务器内存技术的不断发展。”Rambus内存互连芯片业务部门产品营销副总裁John Eble说。

Rambus内存互连芯片业务部门产品营销副总裁John Eble

他用下图做了进一步的解释:这是一段经过简化的AI训练管道,最左边是AI数据存储,比如OpenAI SDXL应用就有超过1亿张图片作为训练所用的数据集存储在左边管道中;在数据准备阶段,所有的图像都要被规整成统一的规格、大小、像素、尺寸,以便于更加高效的利用上述资源去降低延迟,此时主内存的需求量就上升到1TB左右;而到了训练阶段,主内容的容量需求通常来说被认为是GPU内存的两倍,而且带宽需求也更高。

为了解决从客户端系统到高性能服务器的广泛应用所面临的性能和功耗挑战,固态技术协会(JEDEC)于2020年7月正式发布了下一代主流内存标准DDR5 SDRAM的最终规范(JESD79-5),为全球计算机内存技术拉开了新时代的序幕。

市场调研机构Omdia分析指出,预计到2024年,DDR5将占据整个DRAM市场份额的43%;Yole Developpement则预测称,DDR5的广泛采用从2022年的服务器市场开始,2024年,手机、笔记本电脑和PC等主流市场将开始广泛采用DDR5,出货量明显超过DDR4,两种技术间完成快速过渡。

更智能的DDR5 DIMM架构

DDR4是2014年下半年发布的第四代DDR SDRAM,而DDR5虽然是第五代,但与DDR2、3和4的升级迭代相比有了很大的变化。前几代产品的迭代重点主要集中在如何降低功耗上,移动和终端应用是其主要推动力;而DDR5的主要推动因素,则是因为新型处理器内核数量越来越多,导致现有的内存带宽跟不上节奏,必须进一步提高带宽的需求。

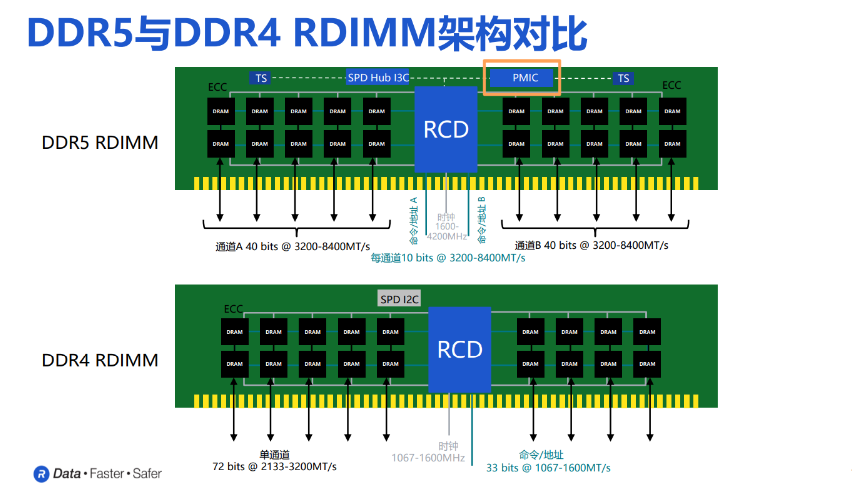

当前,DDR5内存已经开始转移到了双通道架构。从下图可以看出,DDR5 RDIMM架构中数据流的通道比特率是32,再加上8位ECC,就能够在连接器上有着各自所需要的存储和吞吐量,以及内存性能。

同时,上图中的双通道 RCD 在主机端以 DDR5 速度运行,运行速度与 DRAM 相同,每个引脚的开关频率比 DDR4高出一倍多。根据JEDEC今年4月发布的最新数据,DDR5每通道最高频率速度达到了8800MT/s。

显然,更高的数据传输速率至关重要。这些数据信号所需的连接器引脚数量的增加,以及主电源电压从1-1.2伏降至1.1伏,这些因素促使业界决定采用专用的电源管理IC,帮助实现更加精细的电压控制。

在DDR5模块中增加PMIC和相关的无源组件,是从DDR4到DDR5最显著的变化之一。具体而言,之前几代的DDR是将内存电源电压调节放置在主板上,通过连接器将多个电源传输到模块上。但DDR5是将电源管理集成到内存模块(DIMM)上,主板可以为内存模块提供单一的高电压电源。

John Eble指出,由内存模组上的PMIC向模组提供输入高压12V电源,避免了通过模块连接器从主板向内存模组组件输出如1V的电压,大幅降低了输电网络上的电阻(IR)下降问题。后续根据不同应用场景的性能需求,还可以对不同组件和每个DIMM和模组上需要的电压进行单独的编程。

在实际工作中,模块的一侧设置了四个金手指用于12伏输入电源,配有四个开关降压调节器,其中两个采用双相配置,还有两个低压差调节器,为模块上的各种组件产生了共五个不同的电压供应和电压水平。PMIC可以针对其所在的特定模块进行调整,随着用户增加内存容量,能够以递增的方式为服务器添加电源管理。这样一来,极大地简化了主板设计,减少了所需的面积,并降低了电源系统过度配置的浪费。

第一代面向所有服务器类别的DDR5 PMIC芯片

针对不同的电流输出水平,JEDEC目前定义了三种不同的PMIC,它们都共享相同的封装尺寸、引脚布局和寄存器集,每种设计的电源效率都针对其目标应用的预期电流水平进行了优化。这其中,极高电流的PMIC 5020目标是约30安培的最大持续直流电流,是三种服务器PMIC中最新定义的。

而新推出的Rambus PMIC5020将使未来几代 DDR5 RDIMM 的性能和容量达到新的基准。这一全新的Rambus服务器 PMIC 芯片产品系列与 Rambus DDR5 RCD、SPD Hub 和温度传感器 IC 一起组成一个完整的内存接口芯片组,适用于各种DDR5 RDIMM 配置和用例。

DDR5 RDIMM上的Rambus服务器PMIC

DDR5 RDIMM上的Rambus服务器PMIC

John Eble对《电子工程专辑》表示,之所以要设定三种不同规格的PMIC,原因在于为了实现更高的数据传输速率,DDR5需要更严格且精准的电压范围、极低的噪音和较低电压下的高可靠性。这种架构变化真正解决了电阻下降的问题,允许对模块上的电压进行更精细的控制,并使得内存带宽和容量得到了显著提升。因此,所有的DDR5 RDIMM和新的MRDIMM都将使用PMIC,但它们会根据不同内存模块容量、速度和配置的电流需求来选择不同的SKU。

这些 PMIC SKU 都针对目标输出电流范围优化了其功率效率曲线。众所周知,效率对于数据中心运营商而言至关重要,毕竟每提高一个百分点的效率都会降低总体拥有成本(TCO),并带来更环保的解决方案。

于是,大多数速率高达 60,400MT/s 的DDR5 RDIMM使用PMIC 5000高电流版本和PMIC 5010低电流版本。而新发布的PMIC5020,主要用于数据速率达到7200MT/s的第四代DDR5、第一代的MRDIMM模组。此外,一些6400MT/s数据速率+256GB的内存模组,也会使用超高电流的PMIC5020。

目前,高电流PMIC 5000支持的最大持续直流电流大约为20安培,主要针对标准到四阶模块,容量为64GB、96GB和128GB;低电流 PMIC 5010 面向容量较低的市场,支持的最大持续电流约为 12 安培。

在谈及为什么要把PMIC放到DDR5内存模块上的话题时,John Eble的看法是,在实际应用中, DIMM的设计遵循通用工程实践,即提供单路高压、低电流电源轨,并尽可能靠近使用点,然后,在那个节点上生成所需的电源组合。他为此从三个方面进行了解读:

首先,通过将PMIC放在模块上,可以对输出电压进行精细的控制,并且可以以特定于模块的方式进行设置;其次,将PMIC放在模块上可以更好地扩展电源资源。因此,可以在增加容量的同时增加电源管理资源,并且可以真正减少系统中的过度设计;第三,这种架构肯定解决了IR Drop问题。

如果从设计者角度来看,这样的架构会带来四方面的挑战:

- 散热。PMIC会产生热量,而且它靠近对热非常敏感的DRAM。因此,进行热模拟并确保热量以一种不会影响模块的方式消散,这一点非常重要。

- 如何将PMIC及其无源元件安装在模块上。因为模块尺寸是固定的,要为PMIC腾出空间,确保其功率完整性达到最佳状态,且不会造成任何干扰或散热问题,是一个很大的挑战。

- 确保 PMIC上的开关稳压器不会将任何不需要的噪声引入 DIMM 的其他部分。

- 确保PMIC可靠且强大。现在的PMIC位于可维修模块上,可能会经受压力考验,需要内置特殊电路来处理这些可能的压力条件。

John Eble强调称,Rambus提供完整的、经过预先验证的DDR5 RDIMM芯片组,“对客户、客户的用户,以及整个生态系统的推动来说是多赢的。”一方面,DDR5 RDIMM完整芯片组具有经过验证的互操作性和优秀的时序、功率优化,供应链供给也足够稳健;另一方面,它能给客户提供单一的来源支持,帮助他们减少在交付、实际安装、调试等方面所需要耗费的时间和精力。