人工智能初创公司 Etched 最近宣布了一项重大突破,他们推出了名为 "sohu "的新型 Transformer ASIC,声称速度比英伟达的 H100 GPU 快 20 倍。

Transformer是谷歌开发的一种设计深度学习模型的架构,目前已成为 ChatGPT 中 OpenAI 的 GPT-4o、Antrophic Claude、Google Gemini 和 Meta 的 Llama 系列等模型背后的动力源。Etched 希望创建一个仅用于处理Transformer模型的 ASIC,并制作了一款名为 Sohu 的芯片。

哈佛华人辍学生创办的AI芯片公司

据了解,Etched 成立于 2022 年,是一家专门开发人工智能计算硬件,尤其是大型语言模型 (LLM) 硬件的公司,主要是通过专门针对Transformer架构进行优化的硬件,从根本上削减 LLM 推断成本。

Etched 由两位哈佛辍学生 Gavin Uberti(前 OctoML 和前 Xnor.ai 员工)以及 Chris Zhu 创立。

Uberti 曾在编译器领域做过暑期实习生,之后他和 Chris Zhu 开始在一家芯片公司工作。这让他接触到了 Etched 背后的底层硬件理念。

两人于 2022 年从哈佛大学退学,并招收了 Uberti 的大学室友 Wachen。他们很快开始招聘芯片行业资深人士。

作为 Etched.ai 联合创始人,Chris 目前正在开发下一代 LLM 加速器系统。在此之前,Chris 曾在哈佛大学担任各种计算机科学课程的教学研究员。Chris 还曾在亚马逊和 AvantStay 担任软件工程师实习,分别专注于后端物联网基础设施和 AWS 全球收入运营。

此外,Chris 还曾在哈佛本科资本合伙公司担任分析师,并在麻省理工学院担任研究员。更早之前,Chris 还曾担任波士顿大学 PROMYS 的初级辅导员。

截至 2024 年,Etched 共有 35 名员工,并已在 A 轮融资中成功募集到 1.2 亿美元。

Primary Venture Partners 和 Positive Sum Ventures 领投了此轮融资,并获得了 Hummingbird、Fundomo、Fontinalis、Lightscape、Earthshot、Two Sigma Ventures(战略)和 Skybox Data Centers(战略)等机构投资者的支持。

值得一提的是,该公司的天使投资人包括 Peter Thiel、Stanley Druckenmiller、 David Siegel、Balaji Srinivasan、Amjad Masad、Kyle Vogt、Kevin Hartz、Jason Warner、Thomas Dohmke、Bryan Johnson、Mike Novogratz、Immad Akhund、Jawed Karim 和 Charlie Cheeve。

泰尔奖学金主任亚历克斯·汉迪 (Alex Handy) 在一份声明中表示:“投资 Etched 是对人工智能价值的战略押注。他们的芯片解决了竞争对手不敢解决的可扩展性问题,挑战了同行普遍存在的停滞不前现象。Etched 的创始人体现了我们支持的非传统人才——从哈佛辍学,进军半导体行业。他们付出了艰苦的努力,以便硅谷的其他人可以继续安心地编程,而不必担心他们正在研究的任何底层技术。”

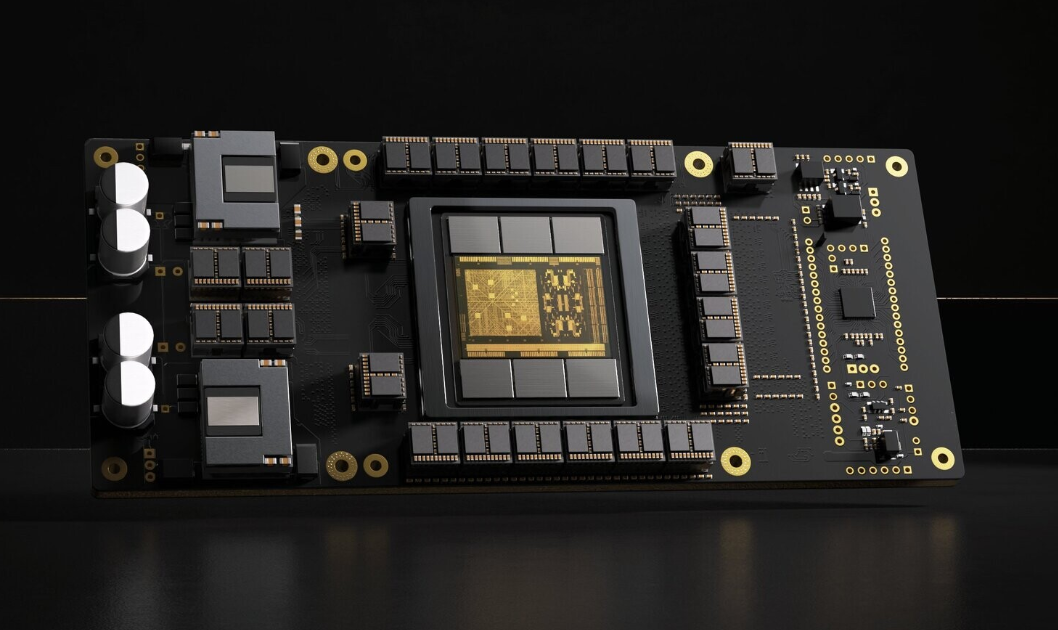

比NVIDIA H100快20倍的Sohu

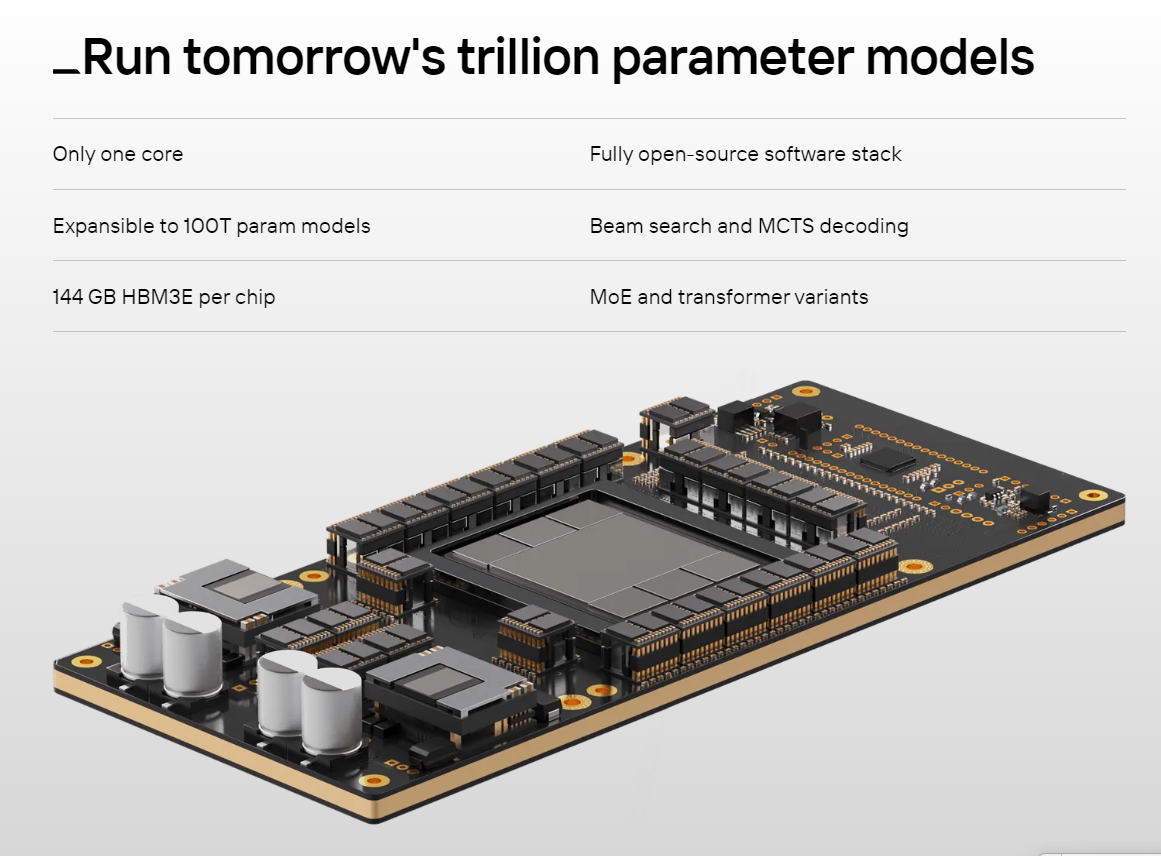

上文提到,Etched 的芯片名为 Sohu,是一款 ASIC(专用集成电路),该芯片支持多达 100 万亿个参数的人工智能模型,是 GPT-4 1.8 万亿个参数设计的 8 倍。

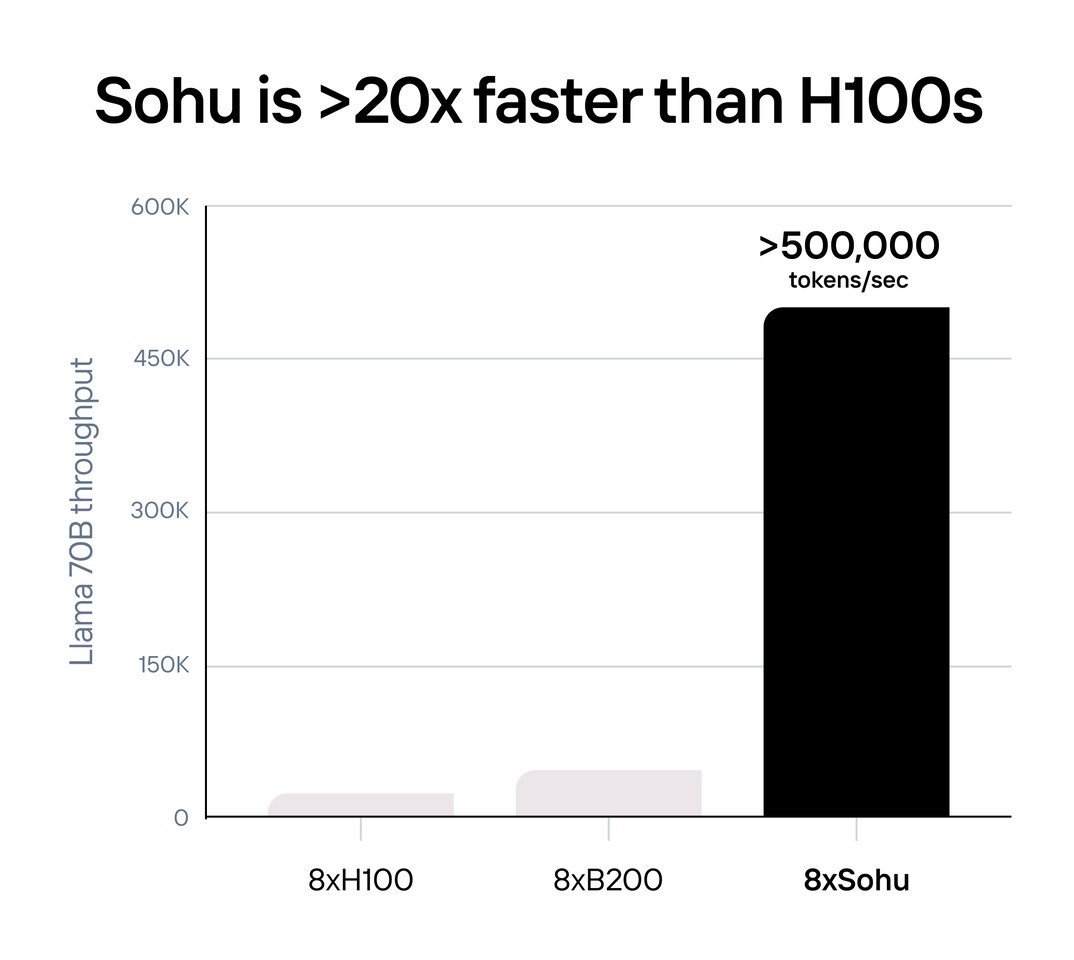

据称,Sohu 的性能要比英伟达公司最新、最好的产品高出整整一个数量级。一台服务器配置 8 个英伟达 H100 GPU 集群,每秒可处理 25,000 个 Llama-3 70B 模型,而最新的 8 个 B200 "Blackwell "GPU 集群每秒可处理 43,000 个模型,而 8 个Sohu集群每秒可输出 500,000 个模型。

在制程方面,Sohu采用台积电 4 纳米工艺制造,配备 144GB HBM3E 内存。

Sohu实现了 90% 的 FLOPS 利用率,而传统 GPU 的利用率仅为 30-40%,这就意味着能效的提升。

鉴于前沿模型的开发成本超过 10 亿美元,而硬件成本则以百亿美元计,因此拥有一个专门为特定应用供电的加速器有助于更快地推进人工智能的发展。

Sohu是如何实现比NVIDIA H100快20倍的?

Uberti 表示,通过专注于Transformer,以可预测的方式将数据从芯片移动到内存,Etched 的 Sohu 芯片可以将更少的空间分配给内存,将更多的空间分配给决定芯片原始计算能力的晶体管类型。

Eteched 效率的另一个方面是该芯片有一个大核心。这样一来,由流式多处理器协调不同核心计算所进行的低效计算就会减少。

Etched 的创始人预计,运行这些模型的芯片的需求将会增加,特别是一旦它们每分钟用于为 AI 软件提供数百万次服务。

他们还表示,通过将 AI 架构硬编码到芯片中,他们的设备可以减少返回答案的延迟,解锁新的用例,例如 AI 代理或实时语音对话。

Etched 表示,由于其架构更简单且用例单一,其芯片的速度比 Nvidia 的 GPU 快20倍。