近日,英国《金融时报》报道称,全球最大的云服务公司亚马逊云科技(AWS)已经暂停了英伟达上一代Grace Hopper芯片的采购,全面转向下一代Grace Blackwell芯片(GH200)订单。

针对此事,AWS在一份最新声明中回应称:“从Grace Hopper芯片到Blackwell芯片的过渡仅适用于超级计算机Ceiba项目,AWS将继续提供基于英伟达Hopper芯片的其他服务。”

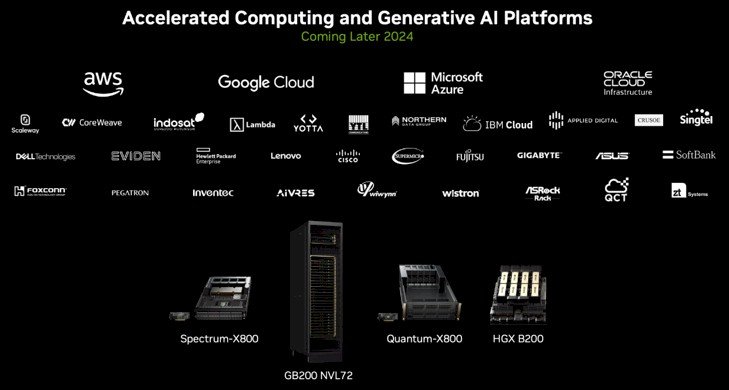

包括AWS在内的云服务提供商是英伟达数据中心AI芯片的“大客户”。截至目前,Grace Hopper仍是用于训练人工智能大模型的旗舰芯片。Blackwell是英伟达在今年3月GTC大会上发布的新一代GPU芯片,预计要等到明年发货。“需要明确的是,AWS并未停止来自英伟达的任何订单。”AWS的声明写道:“在与英伟达的密切合作中,我们共同决定将Ceiba从Hopper迁移到Blackwell芯片,这将实现性能的飞跃。”

H100等基于英伟达Hopper架构的芯片已于2022年9月投入全面生产,Grace Hopper超级芯片,也称GH200,将多个H100与高速内存、连接性和中央处理器一起封装在一起。

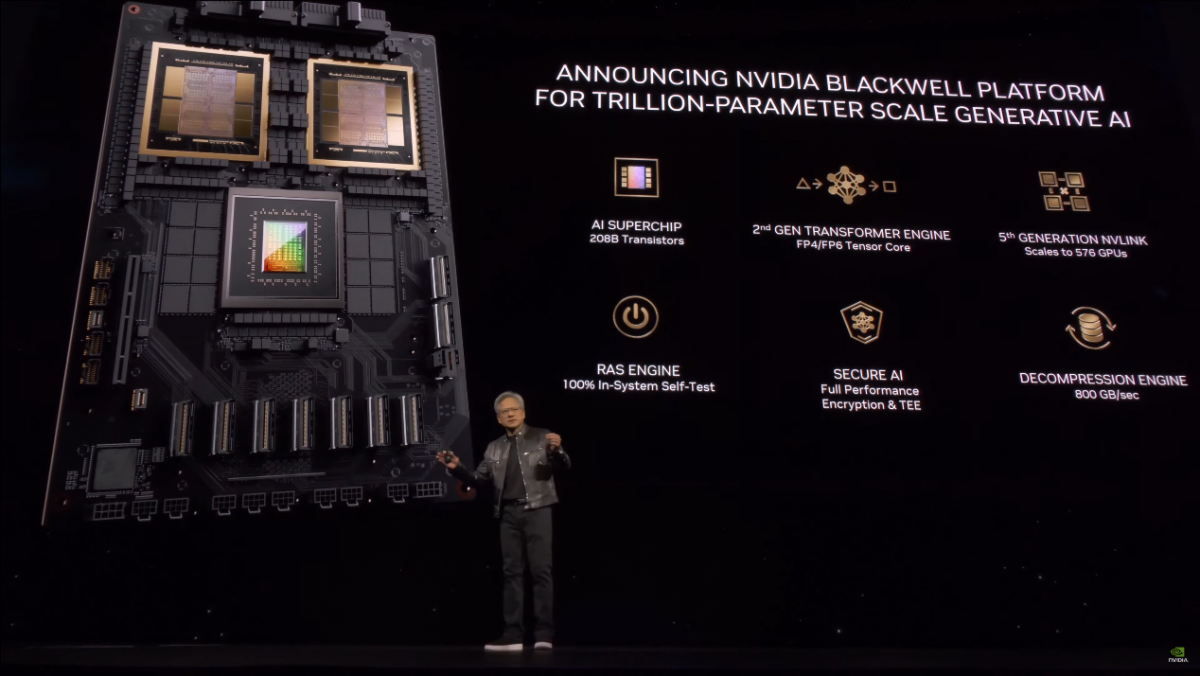

此前3月的GTC大会上,英伟达推出了新一代Blackwell架构的GPU,距离其前一代处理器Hopper开始向客户发货仅过了一年。

当时,英伟达首席执行官黄仁勋表示,如果要训练一个1.8万亿参数量的GPT模型,需要8000张Hopper GPU,消耗15兆瓦的电力,连续跑上90天。但如果使用GB200 Blackwell GPU,只需要2000张,同样跑90天只消耗四分之一的电力。除了训练大模型外,生成Token的成本也会随之显著降低。

更大的差异在系统性能层面。黄仁勋介绍称,在1.8万亿参数的GPT-MoE推理性能层面,Blackwell集群的性能可以达到Hopper集群的30倍之多。

用老黄的话总结来说,就是“(新一代芯片)买的越多,省得越多。”但产品迭代太快,的确让服务器厂商措手不及。是沿用一年前的设计用旧芯片?还是继续等等,升级到新款?

Project Ceiba用行动表明了态度,AWS在声明中强调,考虑到这两代芯片间隔的时间很短,换芯举措是“合理”的。

据悉,该项目是AWS与英伟达共同构建的超级计算机。3月时曾有媒体报道称,英伟达在发布Blackwell芯片后,Ceiba原先的设计已被废弃,将采用新的GPU。据英伟达方面称,新的Ceiba系统将使用总共超过2万个Blackwell GPU构建,GPU的数量较原先的计划增加了22%。

AWS的澄清对投资者至关重要,因为英伟达芯片市场需求被视为衡量整个AI和云计算行业健康状况的重要指标。

截止发稿前,英伟达方面没有就此事发表评论,称需要在发布财报前遵守静默期的规定。

5月22日(周三),英伟达发布了截至4月28日的2025财年第一财季财报,期内实现营收260.44亿美元,同比上涨262%,远高于市场预期的247亿美元;净利润148.81亿美元,同比上涨628%,高于预期的129亿美元;非美国通用会计准则(non-GAAP)每股摊薄收益为5.98美元,同比上涨629%,高于预期的5.19美元。

其中,第一财季数据中心营收较2023年同期激增427%至226亿美元,网络相关产品营收(主要是Infiniband)较去年同期暴增三倍以上至32亿美元;游戏相关营收则年增18%至26.5亿美元。

黄仁勋在财报电话会议表示,今年Blackwell有望带来非常多营收。Blackwell预计在第二财季(5-7月)出货、Q3扩产,客户Q4底前即可在数据中心安装这些最新芯片。他还提到,英伟达推出产品的节奏是一年一次。这暗示英伟达每年都会发布最新芯片或平台。