今年英伟达GTC分析师沟通会上,英伟达CEO黄仁勋提过一个很有趣的观点,如果说万物皆可数字化,那么万物就都可token化——token是生成式AI领域的常用术语,它是指AI模型读取和生成的单位信息,比如可以是一个单词。

除了文本、图像之外,“其实我们还数字化了很多东西,包括蛋白质、基因、脑波等等——只要我们理解其结构,或者从中抽象出特定的模式,能够理解其内涵,就能做数字化。”黄仁勋说,“那么或许就能够对它们做‘生成’了。”生成的“token可以是化学、医疗、动画、机器人、3D图形”,“如果我们能够生成文本的下一个token,那就能生成图像、视频、机械臂的下一个token”。

这段话的大意很清晰:生成式AI有着广阔的未来,且深入到各行各业。英伟达入驻市值万亿俱乐部的第一波推手是AI,第二波推手则是生成式AI。这从英伟达股价的两次分水岭就看得出来。黄仁勋亲手将DGX-1交给OpenAI的“历史珍贵画面”放出的时机还是相当好……

所谓的第一波推手,是2012年AlexNet首度用英伟达游戏显卡去跑,人们发现GPU用于AI的潜力;第二波生成式AI浪潮——也就是ChatGPT引爆的这一次,不仅是GPT背后的OpenAI用的是英伟达GPU,还在于在ChatGPT发布之前,英伟达就已经在反复强调Transformer的重要性,以及为Hopper架构特别加入了Transformer引擎——几乎是精准踩中半年后的市场爆点(图1)。

这一次再度稳固了英伟达在HPC AI领域的地位,万亿市值顺理成章,季度营收三位数飙升持续。撰写本文时,我们采访爱芯元智联合创始人、副总裁刘建伟,他也特别提到:“生成式AI是一场成本驱动型的生产力革命,将重塑千行百业。”

图1:生成式AI成为AI芯片企业追逐的新热点。

不过,对于生成式AI,包括英伟达自己在内的几乎所有市场参与者都认为,该技术仍处于发展早期——尤其是企业AI市场。前不久的Intel Vision活动上,Intel给出的数据是2023年仅有10%的企业机构在生产中发布、应用了生成式AI技术。IDC预计未来3年内,全球企业在生成式AI上的开销会增长大约3.8倍。可见生成式AI的市场发展空间还相当大。

换句话说,AI市场还远未发展到成熟阶段,现在的市场交锋还相当早期,鹿死谁手也未为可知。其实在ChatGPT席卷全球以前,全球AI芯片初创企业就已经如雨后春笋般落地生根了。在英伟达持续占据制高点的AI时代下,如今驱动生成式AI向前的AI芯片市场又走到了哪儿?

英伟达的“强”与“弱”

从2019年开始,《电子工程专辑》和《国际电子商情》在多篇文章中提到过英伟达于AI时代很强。有些提到了股价,有些提到了营收,有些提到了数据中心AI HPC市场份额。这些数字大趋势至少到现在都还没怎么变过。

真正的问题恐怕是,英伟达究竟“强”在哪儿?过去提到的这些数字又是怎么达成的?我们自己总结了几个关键点。

其一当然是底层硬件,不过不是GPU这么简单。芯片能够基于领先的架构、领先的制造工艺和领先的封装技术,是能在战局内称“强”的基础。不过,这在生成式AI时代并不是全部。早在10多年前,英伟达首席科学家Bill Dally找黄仁勋谈面向HPC开发networking技术的问题。黄仁勋问他:“我们为什么要做networking?我们不是一家开发GPU的公司吗?”

虽然老黄后来还是全力支持了对应技术的开发,但他当时的质疑是合情合理的。这个问题延伸开去可能还囊括了英伟达为什么要收购Mellenox,为什么要做DPU,为什么要做交换芯片和交换机,为什么要研究封装之间的光通信技术……英伟达“不是一家开发GPU的公司吗”?

今年GTC上英伟达发布的GB200 NVL72是个很具代表性的东西。英伟达宣称Blackwell的推理能力相比于前代Hopper,达成了30倍的提升。这里的30倍当然不是芯片层面的,摩尔定律、超越摩尔或任何摩尔都做不到隔代30倍性能提升;特定数据格式的支持强化,以及更重要的NVLINK互联技术升级、NVSwitch芯片引入,才是GB200 NVL72整个系统在多模态模型推理上达成30倍性能提升的关键。

这些都是“底层硬件”,只不过是扩展到了系统层面,互联、存储、解热都是其中关键。解决跨节点通信的瓶颈,显然是生成式AI时代相最关键的组成部分之一。这些东西,对英伟达来说都属于“生态”;也是很多在PPT上吊打英伟达的竞争对手难以逾越的障碍。

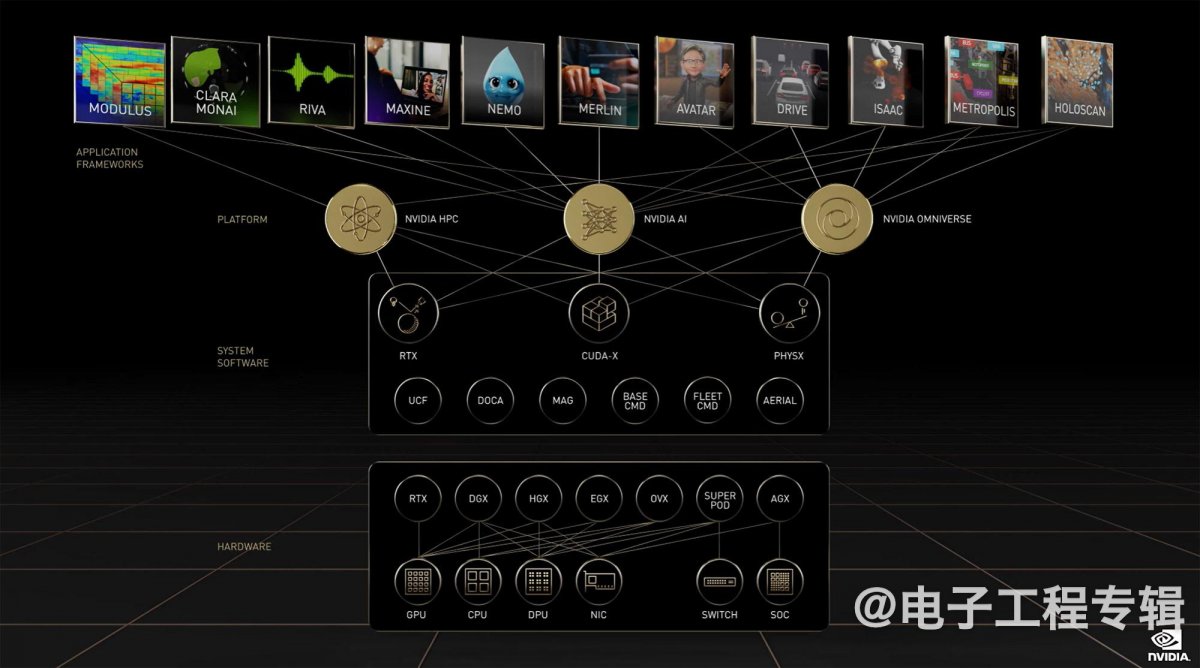

其二是软件,或者说足够俯瞰其他竞争对手、以CUDA为基础的生态。前些年生成式AI还没这么火的时候,英伟达宣传中的平台三板斧是NVIDIA AI、NVIDIA HPC和NVIDIA Omniverse(如图2所示)。这两年后两者的宣传力度明显减弱了。

图2:英伟达的三大平台。

实际上,就算不探讨CUDA和TensorRT之类在效率和完备程度上都明显高出竞争对手几个数量级的中间件和库,在更靠上层的应用层——预训练模型、合成(synthetic)数据生成,以及AI部署之类的服务,加上英伟达还亲自写了一堆具体的常用应用框架——这个所谓“端到端”的上下层构建,都是现阶段的竞争对手难以望其项背的。

今年GTC上,英伟达发布了一个名为NIM(NVIDIA Inference Microservice)的微服务——简单来说是为企业打包的生成式AI服务,企业可以基于这一服务选择模型,做模型的fine-tune和guiderail,并且落地为企业能用的生成式AI。或者说NIM就是英伟达面向企业用户简化生成式AI在企业或产品中去用的工具。

英伟达高层说RAG对企业而言,是个实验性质的技术,是企业应用AI技术的PoC,而现在是时候正儿八经地上企业AI了,NIM就是为此准备的。无论这番判断对不对,这都足够表明英伟达于企业AI市场是快人三步的——竞争对手Intel此时才刚刚开始强调RAG的重要性。

那么在现如今的企业AI市场,英伟达是不是就不可战胜了呢?英伟达的致命软肋恐怕在生态的封闭性上。说英伟达的AI生态是封闭的可能有些武断,毕竟英伟达也在对开源软件做贡献。但从高抽象层级来看,英伟达构建的生态是相对封闭,或者至少应该说是自有的、排他的。

开放 vs 封闭

英伟达的强势,这两年的确对很多竞争对手产生了影响。比如早年还是香饽饽的Graphcore,今年2月还传出公司寻求出售的消息。此前Graphcore尚未撤出中国市场时,我们采访Graphcore就了解到这家作为同在AI训练赛道的芯片企业,是以瞄准几个关键应用市场,不奢求与英伟达正面冲突为发展策略的。

还有一些大算力AI芯片企业从出生伊始就强调避开AI训练竞争,转而专注AI推理赛道。近些年地缘政治问题的引入,又让竞争格局变得更加复杂。

不过在这其中有个颇为典型的英伟达挑战者代表:Intel。虽然Intel在数据中心CPU领域的市场份额过去这两年下滑严重,但毕竟仍然是头把交椅。眼瞧着通用处理器市场价值正在被加速器蚕食,Intel祭出XPU策略也就成为一种必然:所以Intel的GPU、AI加速卡相继推向市场,甚至还有IPU这样的硬件。

Intel外宣现在强调的,一方面是CPU基于扩展指令集层面的加速也能满足许多AI应用的需求,企业基于这样的方案不需要对现有基础设施做“翻新”(greenfield investment),以可控的成本来应用AI技术;另一方面当然是“我们也有GPU和AI芯片”。

在我们看来,Intel于此局的困境在于一方面入局太晚,另一方面则是逃不脱其他所有竞争对手面临的问题:英伟达的软硬件生态优势。芯片、板卡乃至合作的OEM厂商现在是有了,那是不是要再仿照英伟达那样,自下而上建一套完整的自有生态?答案一定是否定的。

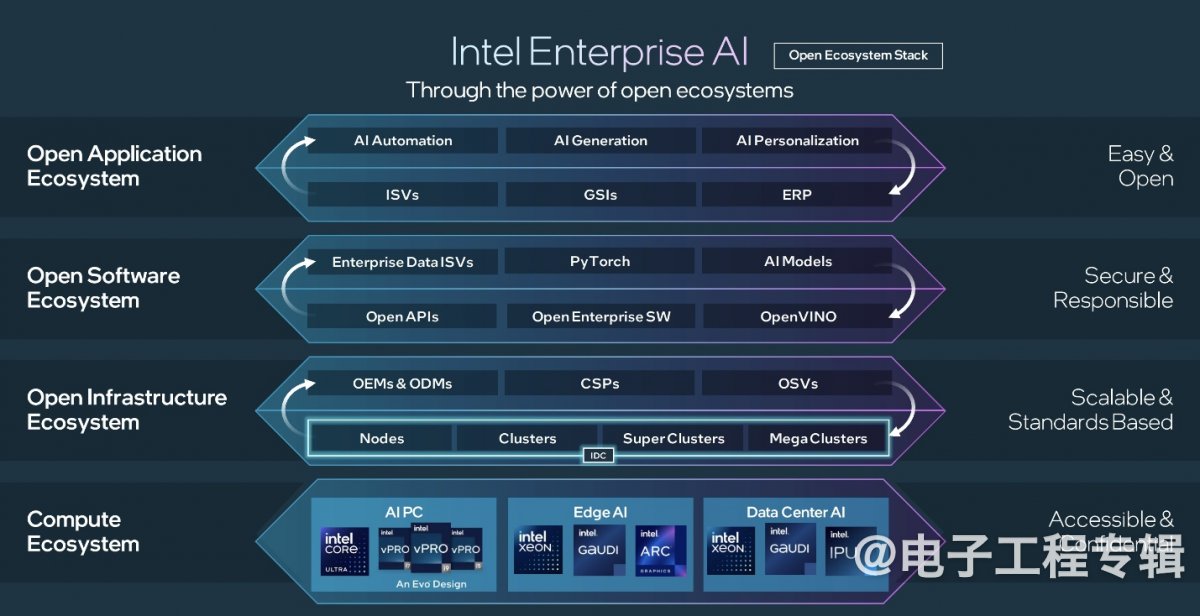

图3:Intel的企业AI生态栈。

从前两年开始,Intel就正式向媒体全面宣传,自己在软件方面的投入有多大:oneAPI、OpenVINO这两个在角色和层级上类似英伟达CUDA, TensorRT的软件也多有见诸报端。

作为开发AI应用的软件基础,Intel主导的这两款软件自然是不可或缺的,但抛开软件完善与成熟度不谈,它们和英伟达这一方最大的差别,在于强调“开放”。最典型的案例是oneAPI甚至能支持英伟达GPU,而OpenVINO作为推理引擎,通过插件能支持Arm平台。

而且,软件生态只是其中一方面。在Intel的企业AI全栈结构里,除了底层芯片没什么可说的,在基础设施(OEM、CSP和OSV等角色)、软件和应用生态等层面,Intel都强调“开放”(图3)。

比如说在跨节点互联的问题上,Intel表示要持续构建、加强Ethernet以太网标准和生态,而不要专制的Infiniband;芯片封装与die之间的互联也要保证是面向业界的开放标准;就连推向市场的IPU,不仅支持Intel处理器,也会支持第三方方案;甚至2026年要问世专为AI准备的NIC,会以chiplet的形式集成到其他处理器产品中;上层软件解决方案,即便Intel会面向企业推出参考平台或打包方案,其中的各组成部分也是开放的……

仔细想一想,在Intel描述的这个全栈结构里,英伟达作为芯片制造商几乎每个层级都亲力亲为,不仅身兼OEM、CSP等多重角色,而且模型甚至应用层都做了不少东西。Intel的思路与之是完全相反或相对的。

今年的Intel Vision活动,Intel恨不得全程强调“开放”“有选择”,以及“不能锁定在一家供应商”。据说Intel的企业AI开放平台先期成员就有不少,而分板块的某些标准组织内成员都是曾经Intel的竞争对手。显然在生成式AI时代,大家都不希望市场被英伟达一家吃尽。

我们认为,以Intel为代表的市场竞争者推行企业AI“开放”策略是种必然,是历史上不同领域竞争的常见路径。尤其像Intel这样的选手,现在如果还不拥抱开放,基于标准联合合作伙伴构建生态,则势必陷入败局。

从企业客户的角度来看,考虑成本、现有基础设施、业务需要、不被一个封闭生态绑架等现实问题,“开放生态堆栈”都不失为一种重要的选择。即便这个比方或许不够准确,智能手机市场,iOS和Android生态的格局,也是能够予人启示的——这是一种高抽象层级、历史上被反复验证过的可能性。

终将触达边缘的生成式AI

随着生成式AI逐渐普及到各行各业,生成式AI发展的算力和能源分配未来会有两个趋势。其一是持续往推理倾斜。“生成式AI时代,数据中心的AI主要任务将从训练转化为推理。”刘建伟谈到。

施耐德电气去年发布的报告显示,从AI负载(功率)的角度来看,2023年AI训练占到负载总量的20%,推理大约为80%;2028年训练负载会持续降低到15%。“其实训练的需求也在增加,只不过生成式AI推理应用增加更快”。

其二,AI和生成式AI也要全面走向边缘和端侧,以达成现在很流行的说法“AI everywhere”。同样是施耐德电气的报告,2023年中心(Central)负载占比95%,边缘(Edge)占比5%;预计到2028年这个值将会变化到50%:50%。

无论这一预期是否准确,在整体市场价值持续增长的情况下,边缘AI市场的增长会明显快于数据中心AI。刘建伟也说:“在生成式AI时代,端侧和边缘侧AI能力在整个系统中的占比会越来越重。”这其中的原因被说得够多了,包括数据安全与隐私、模型的可定制性与弹性,特定行业、企业、个人的不同需要,都是云上生成式AI满足不了的。

“比如端侧2b模型可以改变我们和各种机器交互的方式,从传统的、单一的命令行或图形界面转变为自然语言+图形界面+手势动作等多模态交互方式。边缘几十b的模型就能用来做个人或公司的知识库、智能助理等”。这是现阶段个人和企业应用生成式AI的价值体现。

Intel在近一年的AI哲学宣传中,反复强调边缘AI的重要性——说到底还是因为部分行业边缘,及PC端侧是其优势市场。英伟达也在谈“边缘”,尤其是机器人、重工业领域,当然还有高算力需求的AI PC。

但在更为广阔的AIoT领域,生成式AI的竞争空间却大得多了,也远不是英伟达和Intel可以左右的。价值重心的倾斜,行业的持续发展,以及大把市场非英伟达这样的巨擘可掌控,自然任谁都期望能在这样的潜力市场上分一杯羹。

今年IIC Shanghai活动上,我们采访芯原执行副总裁、IP事业部总经理戴伟进时,他就特别提到芯原“除了通用大模型技术上的提升”,“还非常注重怎么把大模型推理从数据中心转到边缘设备”。芯原目前在手机、汽车、PC三类边缘设备上做尝试,未来“深入研究,甚至可以到更小的设备上。”这个过程需要“在芯片架构、数据、模型等层面做创新。”

所以英伟达有Efficient AI相关研究,模型剪枝、稀疏化等都是常规,据说最新研究成果AWQ(Activation-aware Weight Quantization)权重量化能让某些网络权重降到2bit。Intel这边则也在过去一年多的时间里,努力着眼把生成式AI模型搬到轻薄型笔记本AI PC上,比如BigDL-LLM就是Intel在对外宣传中反复提到的成果。

图4:爱芯元智AI芯片。

“在边缘使用生成式AI,对模型而言,需要尽量压缩模型大小,降低对芯片内存带宽的需求;对芯片而言,需要尽量降低芯片的功耗”。刘建伟的说法和戴伟进是相似的,除了芯片层面着眼于低功耗与高能效,“爱芯元智一直在和产业链合作伙伴积极探索更具性价比的边缘侧端侧生成式AI解决方案”。

“边缘侧生成式AI一定会到来。”刘建伟表示,“当前阶段的生成式AI还处于向上探索边界、不断提升模型大小的过程中;但已经出现了控制模型大小,提升模型能力的探索。”我们认为在边缘生成式AI方向上,爱芯元智的思路和落地产品是颇具代表性和借鉴价值的。

生成式AI和传统AI在算子指令层面变化不大,“主要创新来自模型结构,也就是指令组合使用方式的不同,以及对算力需求的增长。”刘建伟在谈到爱芯元智时说,“爱芯元智AI处理器以算子为指令的设计思路,其结果就是2022年量产的AX650N,今天依然是市场上跑Transformer网络最佳的处理器,例如跑SwinT的能耗比达到199FPS/W。”

“爱芯元智在Github上,已经有大量基于Transformer网络的应用demo”。“客户也已经在AX650N这颗产品上实现了基于Transformer网络的应用落地。例如通过文字搜索图片、例如实现开集检测等”。

与之配套的,“设计AI处理器,需要AI应用、软件工具链、硬件团队紧密配合,合理分工,尽量做减法的(方式)去做设计。即AI处理器的技术架构需要有相应的组织架构与之匹配,才能够将AI处理器真正落地。”刘建伟在阐述生成式AI在边缘落地的理念时谈到,“今天AI处理器和AI应用的交界面AI指令集(算子集)虽然逐渐收敛,但并没有完全收敛。因此需要一个具有高效进化能力的One Team来匹配。”

据说这是“爱芯通元AI处理器展现出高效率、高能效率,软件工具链成熟易用,架构迭代速度快、客户支持响应快等优势”的关键;应当也是值得边缘AI芯片企业借鉴的。值得一提的是刘建伟还提到,爱芯通元AI处理器目前“对外授权”,“通过授权爱芯通元AI处理器的方式,帮助业界解决NPU碎片化问题,加速AI落地,推进普惠AI。”看起来着力于边缘的AI芯片企业,现如今也正尝试扩展属于自己的生态。

就像爱芯元智创始人、董事长仇肖莘博士所言,“用AI颠覆传统技术,用AI重新定义产品,今天的人工智能已经出现在各行各业,并不断影响着社会的运转方式,归根结缔是通过技术手段让人工智能惠及生产和生活的每个角落,用普惠AI造就更美好的生活”。

图5:有人说生成式AI时代下,大部分信息都将由AI生成,人类将难以分辨计算机生成信息的真假。

如果说ChatGPT为生成式AI的发展打了个样,那么毫无疑问在接下来的几年,生成式AI就会深入到千行百业,及人们生活的方方面面。年初的Intel Foundry活动上,Intel CEO Pat Gelsinger在媒体访谈中说,分析师普遍预计半导体行业2030年达万亿美元市场规模是在生成式AI爆发之前;显然生成式AI的到来令破万亿成为一个非常保守的估计。可见这片市场的待开发状态,单半导体领域就可见一斑了。

IDC数据显示,2024年全球企业预期花在生成式AI上的钱大约是400亿美金,到2027年这个值会增长到1510亿。预计2026年80%的企业都会用上生成式AI技术。与此同时2026年之前,至少50%的边缘计算部署会融入机器学习技术。2030年AI会成为边缘应用中市场价值最大的负载类型。

针对生成式AI现如今的发展,本文主列举了三家企业的例子:英伟达、Intel和爱芯元智。这几家企业分别代表了生成式AI热点下,云上AI的固有市场顶流,传统数据中心挑战者,以及AI将全面走向边缘的市场领衔参与者。

他们的发展策略及思路是能够反映芯片领域内,生成式AI的发展现状的。除了生成式AI无论于数据中心还是边缘、端侧,都仍处在发展初期阶段以外,我们能从中看到各路市场参与者的跃跃欲试和各显神通。毕竟这么大的蛋糕,谁不想分一块呢?更有趣的厮杀将会在未来5年内愈演愈烈。

本文为《电子工程专辑》2024年6月刊杂志文章,版权所有,禁止转载。免费杂志订阅申请点击这里。