“就在我以为我已经出局的时候,他们却把我拉了回来。”迈克尔·柯里昂(阿尔·帕西诺饰)在《教父》第三部中说道。服务器处理器的情况也大致如此:它们的功能越强大、能效越高,数据中心的工作负载就越会把它们拉回到更遥远的起点。

随着数据中心的规模、复杂性和连接性不断扩大,其耗电量也随之增加。根据国际能源署的数据,数据中心和数据传输网络排放的温室气体占能源相关温室气体排放总量的1%。据估计,2022年全球数据中心的耗电量为240TWh至340TWh,约占全球耗电量的1%至1.3%(不包括用于加密货币挖矿的能源)。1据一些消息来源称,这一比例甚至达到3%,位居各个行业(例如航空、航运、食品和烟草)之首。

尽管人们在提高处理器效率方面做出了巨大努力,但人工智能工作负载的快速增长导致能源消耗在过去十年中大幅增加,每年增长20%至40%。从2017年至2021年间,亚马逊、微软、谷歌和Meta云的总耗电量增加了一倍多,到2021年已达到约72TWh。1

目前数据中心的主要人工智能工作负载是深度学习、机器学习、计算机视觉和流媒体视频、推荐系统以及最近新增的自然语言处理。人工智能任务耗费大量计算能力,大型语言模型的要求尤其高。Google的PaLM语言模型相对高效。然而,其训练需要25亿petaFLOPS的计算量;也就是说,它的训练计算强度比AlexNet高500万倍以上,而AlexNet是2012年推出的用于机器视觉任务的卷积神经网络,它的出现预示着人工智能时代的到来。2

根据非正式消息来源,OpenAI于2019年推出的GPT-2接受了3亿个文本数据标记的训练,并拥有15亿个参数。OpenAI的GPT-3(也被称为ChatGPT)接受了约4000亿个文本数据标记的训练,并拥有1750亿个参数。最近的ChatGPT模型GPT-4的细节尚未公开披露,但估计其规模在4000亿到1万亿个参数之间,训练数据集高达约8万亿个文本标记。3换句话说,训练GPT-3的工作量大约是GPT-2的150,000倍,而训练GPT-4所需的计算量约为GPT-3的50倍到120倍。由于推理会对计算资源造成压力,OpenAI还限制了用户向GPT-4发送消息的数量。4

大多数人工智能任务的工作负载与算术运算(通常是矩阵-矩阵或矩阵-向量乘法)相关,无论是训练还是推理(数据获取除外)。训练AI模型的计算强度等于训练时间、所用计算实例数量、峰值FLOPS和利用率的乘积。因此,功耗与时间(训练或推理)、并行计算实例(CPU、GPU、TPU、AI加速器等)的数量、实例的计算能力(如FLOPS)和利用率(即训练模型时GPU运行任务的时间比例)呈线性关系。

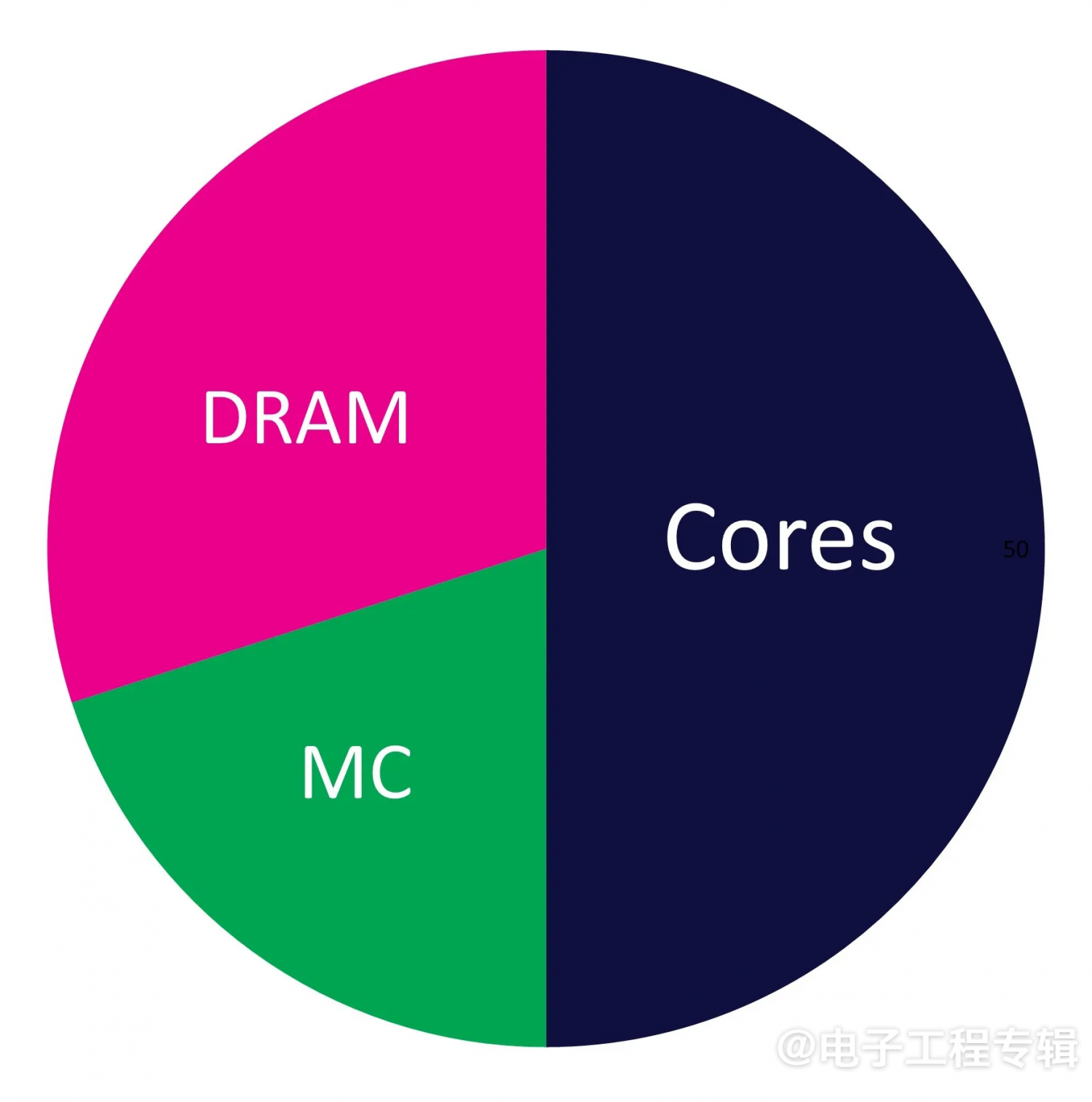

图1显示了典型GPU的功耗分析5,其中内核消耗了总功耗的约50%,片外内存和内存控制器消耗了剩余的50%(CPU的分析类似)。

图1:典型GPU的功耗分析:内核(50%)、内存控制器(20%)和DRAM(30%)。(来源:Zhao等人,20135)

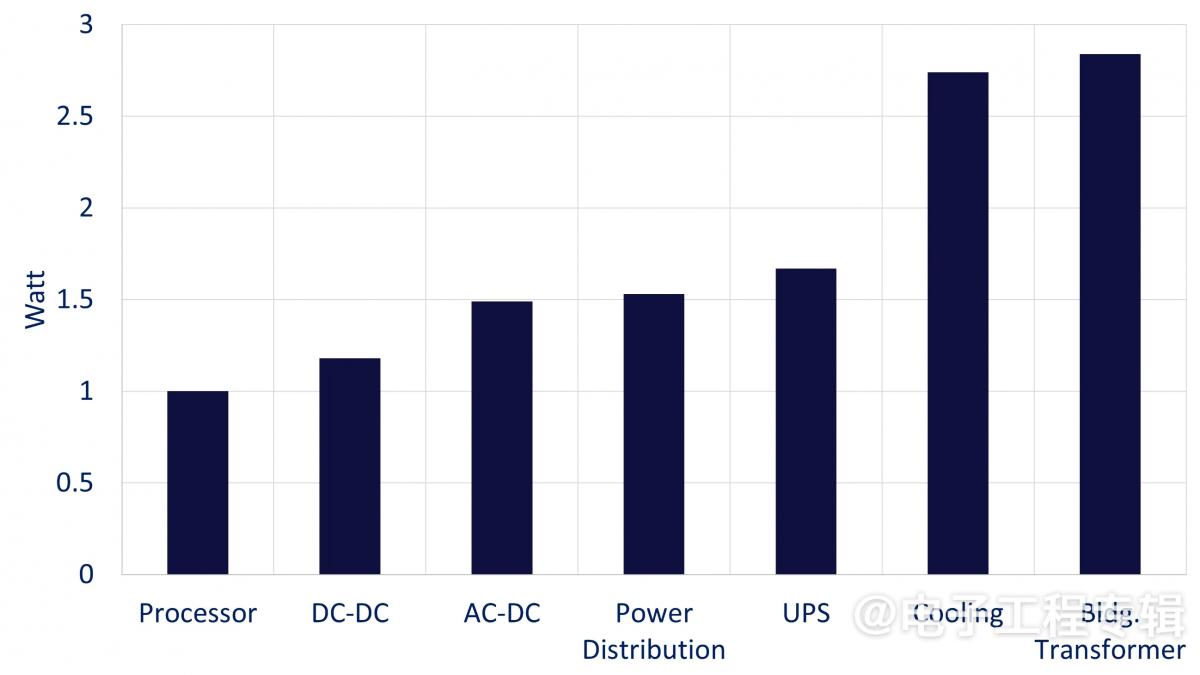

因此,服务器处理器的功耗是很大的。根据基础设施提供商Vertiv的一份报告,服务器处理器节省1W的功耗可使整个数据中心总共节省2.84W的功耗。6图2说明了处理器节省1W的功耗对数据中心不同组件的影响,进而总共可节省约3倍的电力。例如,处理器节省1W,DC/DC电源转换可节省0.18W,AC/DC电源转换可节省0.31W,等等。值得注意的是,每节省1W的处理器功率,就能节省1.07W的冷却功率。

图2:处理器每节省1W功率,数据中心各单元累计节省的功率。从左到右,条形图绘制了整个数据中心的累计功耗节省情况。(来源:Vertiv,20236)

目前的平均机架密度约为每个机架10kW。7因此,即使在服务器处理器上节省几个百分点,也可在机架层面节省大量电力,并对电力使用和温室气体排放产生积极影响。

虽然处理器性能的提升受限于功耗,但其他因素也不容忽视。通常情况下,我们追求的是下式所示指标的最大化:

性能÷(成本×面积×功耗)

其中,性能是指每秒的浮点或整数运算次数,而芯片成本、面积(mm2,掩模板尺寸有限)和功耗(W)则不言自明。从环保角度来看,首要目标是最大限度地提高性能功耗比。在提高性能的同时降低功耗通常是一个相互矛盾的要求。这里存在一个不利于上式最大化的恶性循环,因为它的变量是相互关联的,它们相互依赖于晶体管密度(技术节点)、晶体管数量、内存大小、时钟频率、驱动电压、内核和线程数量、晶圆产量等等。

我们已经在实践电源管理技术,如电压频率缩放和时钟门控。逻辑综合和物理设计优化也能帮上忙。下一步是什么?

环栅技术将提高单位面积的驱动电流,同时改善沟道控制,从而降低静态(泄漏)功率。将标称核心电压(VDD)降至0.65V将进一步节省动态功耗(与基于FinFET的处理器相比)。新型先进逻辑方法不断涌现,如准CMOS,通过修改电路拓扑,可显著提高性能功耗比。8

此外,针对特定应用的最佳性能功耗比可能无法通过通用处理器实现,而是要通过专门设计的特殊处理器架构来实现性能功耗比的最大化。全定制ASIC处理器已被部署到视频和推荐系统以及人工智能训练和推理中;这种趋势还将继续发展,并能获取更高的性能功耗比。在这种情况下,专用指令集处理器(ASIP)的指令集架构针对特定应用进行了优化定制,是获得额外环境效益的可行解决方案。

像芯粒(也即将大号的处理器分割成更小的裸片,以获得更低的成本和更高的产量)这样的封装技术,也可以改进电源管理,目前这种技术已被采用。芯粒可以使有效裸片面积大大增加到超出掩模版尺寸,并且业已证明,数千个小内核与智能能源管理相结合,可以实现最佳的性能功耗比。

虽然所有这些方向都属于处理器设计的范畴,但也应考虑重新定义人工智能模型的新算法,使其所需的计算能力和内存带宽更少,就像卷积神经网络中所发生的(即压缩)那样。

参考文献

1Rozite et al. (July 11, 2023). “Data Centres and Data Transmission Networks.” International Energy Agency.

2Roser, M. (Dec. 6, 2022). “The brief history of artificial intelligence: The world has changed fast – what might be next?” Our World in Data.

3Bastian, M. (March 25, 2023). “GPT-4 has more than a trillion parameters.” The Decoder.

4Hines, K. (July 19, 2023). “OpenAI Increases GPT-4 Message Cap To 50 For ChatGPT Plus Users.” Search Engine Journal.

5Zhao et al. (Dec. 1, 2013). “Optimizing GPU energy efficiency with 3D die-stacking graphics memory and reconfigurable memory interface.” ACM Transactions on Architecture and Code Optimization, 10(4), pp. 1–25.

6Vertiv. (2023). “Energy Logic: Calculating and Prioritizing Your Data Center IT Efficiency Actions.”

7CoreSite. (2023). “Facing the Data Center Power Density Challenge.”

8NeoLogic. “Powering the Next Generation Processors: A New VLSI Design Paradigm.”

(原文刊登于EE Times欧洲版,参考链接:Server Processors in the AI Era: Can They Go Greener?,由Franklin Zhao编译。)

本文为《电子工程专辑》2024年6月刊杂志文章,版权所有,禁止转载。免费杂志订阅申请点击这里。

- AI的目的不就是取代实体人?一个实体人的耗电量是多少?AI耗电与实体人耗电有个损益平衡点吧?过了这个点,AI不就更环保了?这意味着这是一个什么样的过程呢?明说吧!被取代的实体人何去何从?生孩子的前提是认识到自己和后代不会被AI取代?