去年8月,由30名IBM研究实验室科学家组成的团队推出了一款全新芯片,旨在大幅提高高能耗深度学习推理的能效,同时保持运算精度。这款名为Hermes的模拟内存芯片将数字电路与相变内存(PCM)结合在一起,这样神经网络的计算就可以在内存电路中进行。

这种处理器与内存的搭配无需像典型的人工智能加速器芯片那样,在内存和处理单元之间无休止地移动大量数据。重要的是,分析表明,该芯片在执行计算机视觉人工智能任务时与数字芯片一样出色,而功耗却低得多。

率先推出该芯片的IBM欧洲研究院团队负责人Abu Sebastian及其同事Manuel Le Gallo-Bourdeau和Vijay Narayanan在其博客中明确表示,他们现在已经展示了实现快速、低功耗模拟人工智能芯片架构愿景所需的许多构件。正如该团队的一位IBM科学家告诉笔者的那样,“我们仍处于芯片的研究阶段,但我们现在要尽可能多地构建硬件,以准确了解它的功能,并找出向前推进的最佳方法”。(编者注:这位科学家接受了我们的采访,但要求不公开身份。)

耗电的人工智能

人工智能的功耗问题源于一种被称为冯·诺依曼瓶颈的现象,这一瓶颈以现代计算机架构的先驱约翰·冯·诺依曼的名字命名。在这种情况下,CPU和内存是独立的实体,因此数据和计算必须在两者之间不断来回穿梭。这一过程会产生瓶颈,因为处理速度通常比检索数据或将数据写入内存的速度更快。

长期以来,设计人员一直在使用内存缓存、流水线和分层内存方案等变通方法来解决瓶颈问题。最近,芯片巨头们专门开发了加速器芯片来承担新兴的人工智能处理任务。例如,NVIDIA已经从其GPU技术中取得了长足的进步;谷歌开发了张量处理单元;英特尔提供了多种解决方案,包括可针对人工智能计算进行编程的FPGA;高通则为移动设备设计了人工智能加速器芯片。

尽管如此,人工智能的高能耗需求及其不断增加的运算量要求采用更节能的方法,而这正是模拟内存计算将发挥关键作用的地方。

模拟内存芯片可以直接在内存中执行计算,从而规避冯·诺依曼瓶颈。模拟计算方案只需要几个电阻器或电容器,因此可以将它们移到内存中,消除内存和处理器之间的分离,从而提高能效,远远超过数字芯片。

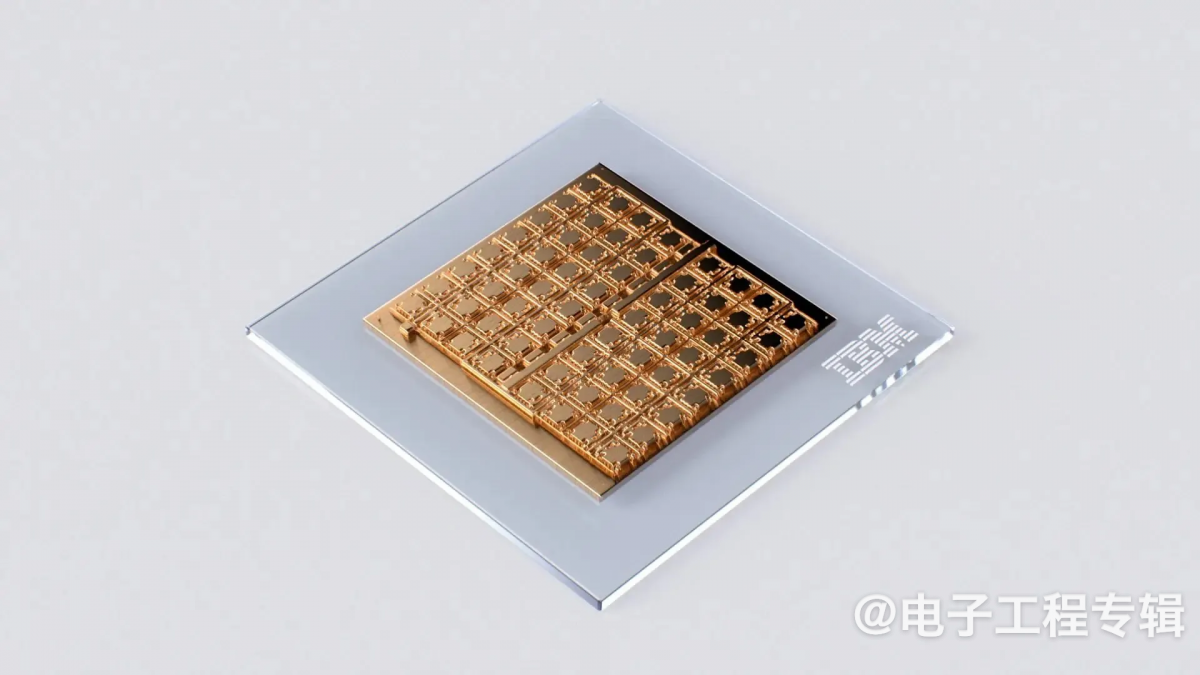

IBM在其最新的模拟人工智能芯片中采用了这种方法。该芯片采用14nm CMOS设计和制造,包含64个计算内核,每个内核都有自己的PCM阵列,以及一个轻型数字处理器,用于激活和累加等额外的神经网络运算(如图所示)。片上通信网络将这些内核连接在一起,芯片中心的另一个数字处理单元可以处理要求更高的神经网络计算。

尽管IBM使用PCM技术使其与众不同,但在模拟AI芯片领域,IBM并非孤军奋战。例如,英特尔实验室的研究人员一直在研究静态随机存取存储器和其他技术;美国初创公司Mythic专注于多级闪存;斯坦福大学、圣母大学、加州大学圣地亚哥分校和清华大学的研究人员开发了一种神经形态芯片,被称为NeuRRAM,它使用电阻式随机存取存储器。

对于IBM来说,PCM是一个合乎逻辑的选择,因为该公司已经花了至少十年的时间为存储应用开发这种材料,其中包括多电平PCM芯片。PCM本身是一种非易失性随机存取存储器,加热时会在低导电非晶相和高导电晶相之间切换。基于这些材料的器件可以利用相变,将电导的变化编码为突触权重,然后用于计算操作。重要的是,正如IBM的最新结果所示,记录这种连续值(而不仅仅是数字器件的1或0)对于深度神经网络运算非常有效。

在与其他基于类似技术的芯片(包括NeuRRAM以及Mythic和TSMC开发的芯片)进行基准测试时,IBM的技术可以在能效相当的情况下,将矩阵向量乘法(人工智能运算的基础)的执行速度至少提高15倍。值得注意的是,在使用人工智能训练用彩色图像数据库CIFAR-10进行测试时,该芯片在图像识别方面的准确度也高于其他芯片,这对模拟内存计算虽然节能但容易出现计算误差的观念提出了挑战。

“相变存储器的优势在于它足够稳定,可以进行一些相对准确的计算。”这位IBM科学家表示,“我们已经开发出准确编程的技术,并对误差进行了详细表征。我们的准确度足以满足神经网络的要求。”

英特尔实验室研究科学家Hechen Wang多年来也一直从事模拟内存计算的研究,他也认为这种方法可以实现卓越的能效。“研究人员大约在五年前开始研究模拟内存,现在我们有IBM、imec、GlobalFoundries、台积电和三星等公司和学术团体开始研究这项技术。”他表示,“如果我们想要进行非常高效的AI计算,就需要将处理单元置于内存阵列内部,甚至是内存单元内部。

“英特尔实验室正在寻求内存计算的多种途径,并探索一系列内存技术。至于哪种内存才是正确的方向,我们还没有得出结论。”

尽管如此,Wang仍然认为,IBM和其他公司最新的模拟内存开发成果正在对这一“热门”领域产生积极影响。“IBM的研究成果已经发表在Nature杂志上,说实话,我做梦也没想到会发生这样的事情。”他表示,“很多人会阅读这些刊物,我希望这些结果能够打开他们的思路,吸引更多的人关注这一领域。”

下一步

自从在Nature Electronics杂志上发表研究结果以来,IBM欧洲公司的研究人员已经明确表示,他们相信自己的工作证明了模拟AI可以提供必要的计算精度,与传统的数字加速器相媲美,而且能效更高。随着人工智能技术的兴起,节能又准确的推理硬件变得至关重要,研究人员的目标是创造出能够执行端到端推理运算的模拟内存芯片。

与此同时,IBM欧洲研究院告诉笔者,它打算利用PCM器件上可达到的高突触密度,制造出能够运行整个网络操作的大型芯片,以超越数字加速器竞品。

“一旦我们真正展示了这项技术的前景,并且有更多的人愿意在这一领域投资,那么我们就可以组建多支由数百名研究人员组成的团队来从事这项工作,从而使芯片投入生产模式。”这位IBM科学家表示,“所以现在,我们将继续努力。”

(原文刊登于EE Times欧洲版,参考链接:Could IBM's AI Chip Reinvent Deep Learning Inference?,由Franklin Zhao编译。)

本文为《电子工程专辑》2024年6月刊杂志文章,版权所有,禁止转载。免费杂志订阅申请点击这里。