前不久,我们大致梳理了Intel在生成式AI时代的发展战略。Intel Vision活动谈这件事的背景在于:生成式AI技术对企业客户的未来至关重要。但现阶段正处于企业应用AI技术的早期:企业目前需要易于部署、具备伸缩性的AI解决方案,同时要求这样的方案是可靠、安全的。

另一个暗含的背景是:市场上虽然已经有了对应的解决方案(NV...),但对企业客户而言成本高(基础设施的greenfield investment)、没有选择性。所以Intel认为,无论从客户需求的角度,还是从市场现状的角度,现在都是Intel推动企业AI战略的好时机。如果要总结Intel在活动上谈到的企业AI战略,我们认为大致上有3个方向:

(1)从云到边缘、端侧,生成式AI都要触达;

(2)以开放的方式,从硬件到软件,与合作伙伴共建围绕开放标准的生态,构建端到端、给予用户选择的生成式AI架构;

(3)要从系统层面着眼,解决生成式AI未来的性能需求问题,所以Intel不仅发布了Xeon 6与Gaudi 3处理器,还宣布了IPU, AI NIC等networking相关产品计划,与此同时还准备着眼提供系统层面的参考设计...

可能还要增加一点:软件非常重要,所以从软件以及上层应用的角度,一边强调开放性,一边强调为企业客户提供更加完整、便于部署,还确保了安全与可靠性的方案。建议还没有看过前篇的读者,先看一看Intel的企业AI战略框架,再阅读本文。

其实在Intel Vision活动期间,Intel中国也特别召开了一场媒体座谈会,聊了聊Intel此次宣布以“开放”为基调的生成式AI战略,在中国国内是如何落地和体现,并且谈到了Intel对于构建开放生态的更多思考。

“开放是自然演变”

我们之前一直在说,现在数据中心的AI市场格局,决定了Intel要打这副牌并握有胜局,就必须拥抱开放、合作。李映(英特尔公司副总裁、英特尔中国软件和先进技术事业部总经理)在谈有关软件的开放、开源的问题时,他说这“不是个选择问题,而是自然演变、自然发展的过程”。

“Pat(Intel CEO)在Vision活动上放出开放平台、企业AI的那张图。我们很少能看到新诞生的联盟就有那么多参与者。”这里李映说的应该是Intel企业AI开放平台(Open Platform for Enterprise AI)的初期参与者,“我数了一下,至少有20家。”“开放、开源的范围会变得很大。”

Intel在这一开放平台中起到的作用,“第一是兼容性,即我们如何提供整体架构去解决不同玩家之间互联互通、兼容性问题,是大家彼此之间价值的共同体现。”李映说,“另一点更重要的,不是说哪个技术一定是Intel提供。更重要的是,我们要推动这样的标准框架,如何保证更多、更开放的玩家在一起,保证进程的整体发展方向。”这是在李映看来,与此前传统的同类框架很大的不同。

除此前我们提到OpenVINO现在还支持Arm平台,oneAPI支持NVIDIA GPU,这里还有个例子。如上篇文章所说,在做跨GPU、跨系统、跨节点时,Intel准备采用开放标准的高速SerDes,以及新的基于Ethernet以太网的协议,来构建AI基础设施。

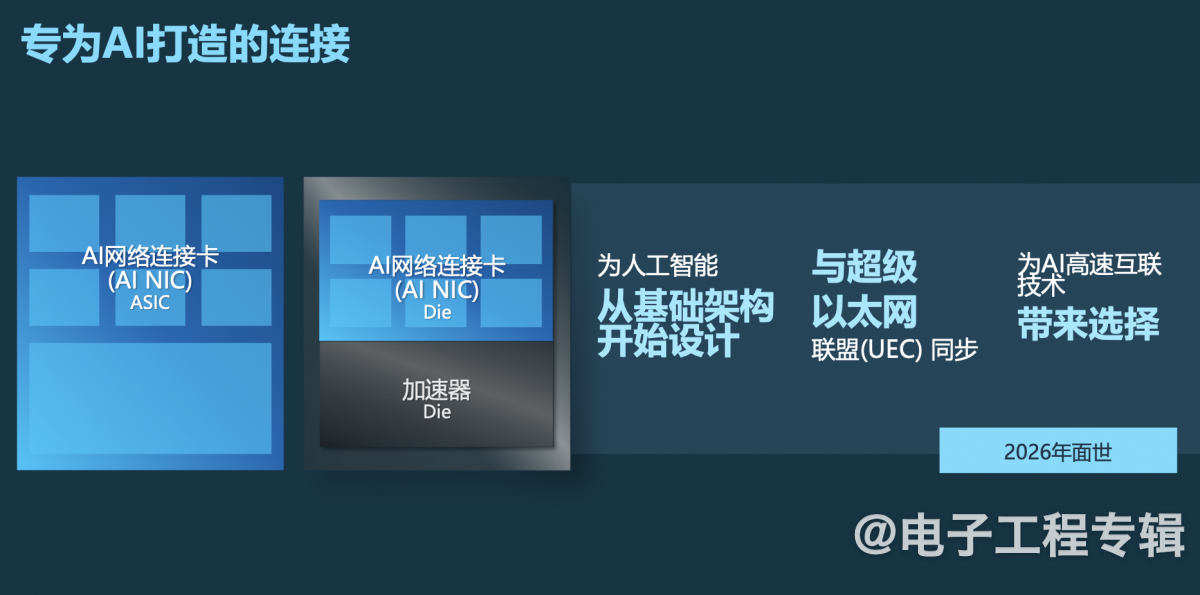

实际在去年7月,包含诸多云服务提供商、芯片制造商、系统供应商就联合组建了UEC超级以太网联盟,期望构建基于以太网的完整通讯栈架构,用于高性能networking,主要就是为了适配AI和HPC。去年我们就撰文探讨过Ethernet和Infiniband的差异,谈到原生Ethernet在用于HPC时的弱势,而Ultra Ethernet解决方案就是期望将以太网的用户基础与弹性结合起来,在新的时代为AI和HPC服务。

Intel必然是UEC的成员和支持者。“UEC联盟成立之后,相应的白皮书、文档初版也出来了。”张宇(英特尔中国网络与边缘事业部首席技术官、英特尔高级首席AI工程师)说,“Intel在其中做了很多贡献。”“这个协议是开放的,Intel能用,友商能用,生态合作伙伴也能用。”“开放带来的好处是最终用户选择多了,成本就可以打下来。”

这里补充一则信息是本文的上篇没有提到的。Intel预计要在2026年推出的AI NIC未来会有两种形态:一种是独立网卡的形式;另一种是chiplet,“不同的AI加速器可以将AI NIC(的chiplet)集成到加速器芯片中”。不知道Intel是否会对外出售这样的chiplet...

不过可以确认的一点是有媒体问到下半年Intel要推出的IPU是否支持第三方处理器,Intel的回答也是肯定的。“我们提供的网络产品很灵活,也很开放,可以接不同类型、种类、厂家的处理器。”张宇说。

实际上AI NIC预期会有chiplet存在方式,多少也能看出Intel Products联合Foundry业务搞开放生态的初步形态——意即将来会有极大概率看到Intel的AI NIC和其他厂商的处理器或加速器做融合,则IPU支持三方处理器也就理所应当了。不得不感叹,现在的Intel跟10年前的Intel还真是大不一样…

AI技术必须是“可及”的

基于“开放”思路,自芯片到OEM系统、到软件中间件、到上层应用的整体架构,具体的搭建方式,我们可能还要等一等后续Intel的参考平台。不过现有数据中心基础设施的AI利用,却已经有了实例。

这也是Intel的企业AI架构想要强调的:有选择、可基于现有基础设施做brownfield investment,兼顾成本考量。Intel推行这一思路的逻辑也很好理解,一方面客户当然希望能用更低的成本获得新技术,另一方面则在于Intel实际上是数据中心或企业IT基础设施的既有市场霸主。

从英伟达这些年一直在大声呼吁加速计算要全面席卷各行各业,就知道通用处理器CPU仍然是占据一席之地的。而CPU当然是Intel的天下。

庄秉翰(英特尔公司市场营销集团副总裁、中国区数据中心销售总经理、中国区运营商销售总经理)在媒体问答环节说:“目前真正部署生成式AI来提升竞争力的企业只有约10%,另外90%还没有完全部署生成式AI。”...“目前的企业利润结构大多是基于通用数据中心的应用——尤其现在CPU迭代非常迅速,每代CPU又会带来新的性能提升和能耗减少。”

“所以在现有业务的增长上,企业依旧非常需要通用数据中心。”庄秉翰表示,“从去年下半年开始,通用数据中心建设又恢复到原来的节奏。”与此同时,即便是新一代智算数据中心,大部分部署GPU等加速器的基础设施,仍然采用Intel的CPU。(从这个角度来看,GB200/GH200还真的是基础设施greenfield investment)

“也有一些企业在找寻是否可以用CPU来做大规模推理...很多案例比如130亿参数规模以下的大模型(推理),CPU就可以做到的。”“我们也看到一些客户愿意尝试用CPU做大规模推理。”

“对企业而言,大模型现阶段也处在初始阶段,不需要立即部署很大的GPU集群——这对运维和开发而言都是很大的挑战。”加上Intel现在也提供GPU和AI芯片,庄秉翰强调智算数据中心对Intel而言也是重要的市场机会。

梁雅莉(英特尔公司市场营销集团副总裁、中国区云与行业解决方案部总经理)在演讲中提到Intel处理器与AI解决方案在中国市场的合作案例,似乎就很有代表性。比如Intel和金山云的合作,“在其第七代性能保障型云服务器X7中引入第四代至强可扩展处理器进行针对性优化。”“我们在 Stable Diffusion、Llama2、ChatGLM2 三款十分流行的大模型基础上做了调优,并发布优化的模型镜像。”

至强处理器中的AMX加速,令Stable Diffusion推理性能提升4.96倍;“Llama2和ChatGLM2模型上,优化后的模型推理性能也分别取得了2.62倍和2.52倍的显著提升。”Intel认为与金山云的合作体现了:第一“便捷的部署”,不需要专门部署AI推理服务器;第二“成本优化”;第三,这样的通用数据中心在AI之外,还能灵活用于其他负载,“敏捷切换”。

京东云基于第五代至强处理器做智能营销、智能客服;在智能制造领域,与TCL华星光电合作,提升产品良率;教育行业,和华东师范大学合作开发大模型一体机,提高教学效率等...都是Intel与中国客户,现阶段就AI深入不同行业,也印证了庄秉翰所说企业AI所处阶段的具体案例。

强调AI要扩散到边缘

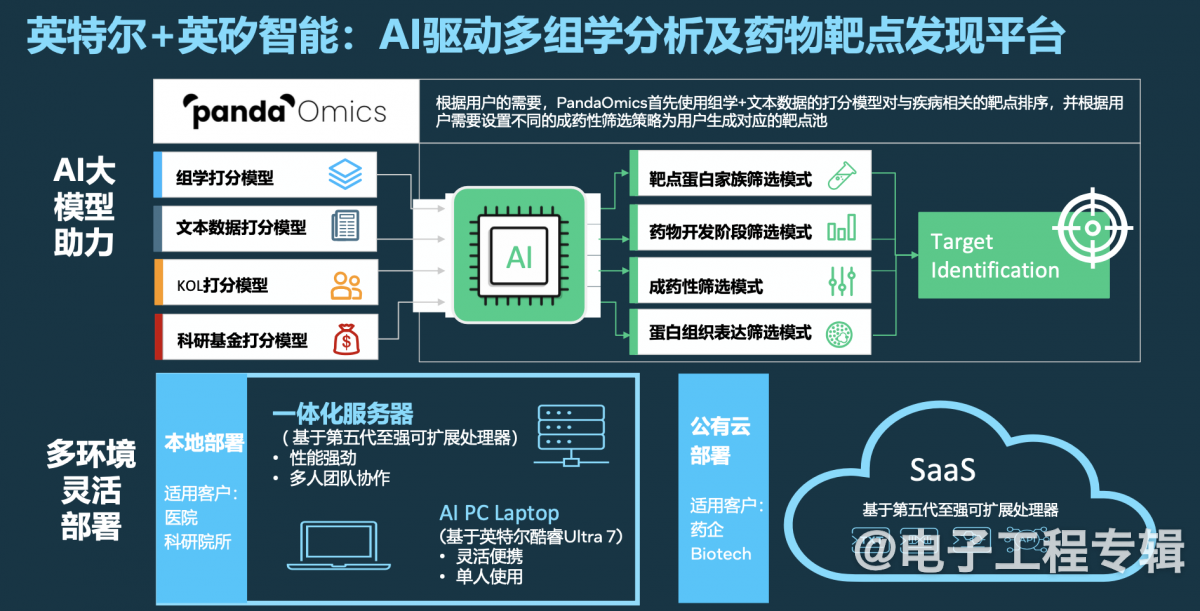

与此同时,梁雅莉提到的好几个案例实际都是“云边协同”的:不仅在云上部署AI,而且边或端侧也借助本地算力来实现一些AI特性——比如与英矽智能的合作:从公有云、本地服务器、PC三个层面,为AI药物探索和发现提供支撑。不单是数据中心层面,这个案例我们在前不久的商用AI PC发布会报道文章中就提过,AI PC之上构建了个科研助手ChatPandaGPT。

“要选择最适合企业的人工智能策略,基于该策略选择最适合的基础设施和架构。”“有时候需要用GPU,有时候就需要CPU;有时候会用到云端算力,还有的时候会用到AI PC,用到边缘。这是完全不同的策略。”这在Intel看来是最终AI落地必然考虑经济适用问题的可持续方案。

戴金权(英特尔院士、大数据技术全球首席技术官、大数据分析和人工智能创新院院长)提到,“因为AI无处不在,你会发现不管是数据中心,还是边缘端都会用到AI。”这对开发者也提出了对应的要求。

不过“通过本地到边缘再到数据中心,这样一个统一的开发平台、开发体验,在不同的硬件平台——包括不同的硬件能力、硬件资源,为开放人员提供类似的开发体验和应用部署等,Intel做了非常多的工作。”

郭威(英特尔公司市场营销集团副总裁、英特尔中国网络与边缘及渠道数据中心事业部总经理)列举了一个在我们看来,于边缘格外有代表性的案例:英特尔与科东软件合作,应用于工业领域的AI智能机器人。实际上这个例子我们在商用AI PC国内发布会活动上也见到过,当时科东软件就演示了通过麦克风发出自然语言指令,就能指挥机械臂工作。

此前还未引入AI技术时,机械臂的操控是需要工程师重新编程并测试的。而生成式AI让机器人“具备自我学习、自我生成的能力”。郭威介绍说,“根据客户需要,自动生成PLC逻辑控制器代码,并将代码用在机器人的运动控制上。也就让终端客户降低了设备使用成本,不需要庞大的编程团队。”

在这个过程中,“酷睿Ultra处理器通过CPU, GPU和NPU共同工作。因为控制器并不单是机械臂,还用到了机器视觉。”比如让机械臂捡起某个对象,首先就要求借助双目摄像头和CV识别对象、明确对象所在位置。更复杂的,“机器视觉还用于故障检测”,“以前故障检测需要大量有故障、瑕疵的设备照片数据做训练,客户首先就需要有这样的数据,才能把模型训练出来。”

而生成式AI,“能够根据有限照片自动生成很多有瑕疵设备的照片”——这就是我们此前常说的合成(synthetic)数据生成工作了,有了数据就能将用于故障检测的模型训练出来。“设备不光做到了1+1=2,还能够推出1+2=3。这是人工智能时代,设备的变化。”

更多边缘和端侧应用案例,本文不再多做列举。

面向中国的AI软件生态工作

最后再简单谈谈软件。实际上前篇对Intel在生成式AI时代的软件栈构建,已经有了比较详细的解释——这部分就不做赘述了。但李映特别谈到了Intel面向中国的软件生态,“重点和总部战略是一样的”,同时将“总部战略与中国软件生态、中国软件未来的创新和发展,做有力结合”,则有了以下三方面。

首先还是底层的“硬件赋能”,而且“有英特尔中国的软件工程师和我们的客户针对新的硬件进行优化”,保证Intel的硬件在真实场景能够达成最优。

其二是“中间层提供差异化”。李映举了两个例子。Intel软件生态与openEuler、龙蜥的合作,“将Intel最新的创新第一时间与龙蜥和openEuler紧密结合”。所以“Intel对中国开源的Linux生态,已经和国际同步,甚至某些领域领先于国际上的其他Linux发行版”。以及,Intel“通过本土软件团队、本土工程师,对大模型和Intel技术进行优化和发布”。

第三是与合作伙伴共建AI应用,这部分强调和ISV的合作。商用AI PC的那场发布会就有30+家ISV参与,“很多ISV应用都是和Intel软件团队共同合作、共同加速”。还包括去年和联想共同举办基于AI PC的用户大赛,“大赛有5000多名开发人员加入”,“创意和点子、整个大赛的规模都超出了我们的想象”。这个层面的合作显然是AI尽快落地、创造AI价值的关键。

从Intel Vision 2024全篇来看,上述几乎每一点Intel都在和英伟达走相反或相对的路子。强调“开放”是基于英伟达构建的AI生态是相对封闭、强调自有的;强调“可及”是因为Intel能够基于现有数据中心方案做AI扩展,而英伟达更偏向全新的基础设施投入;强调“边缘”则在于Intel于边缘领域的既有优势,尤其是相比于英伟达的优势。

加上合作伙伴也寻求在生成式AI时代都能分一杯羹,Intel的这些策略逻辑还是相当通顺的。不过能否在生成式AI一役初期与英伟达一较高下,就要看Intel接下来在其构建的全栈各环节如何做更具体的布局了。