今年英伟达GTC主题演讲,相关Omniverse元宇宙有个小亮点,黄仁勋亲口宣布Omniverse Cloud将支持苹果Vision Pro,也就是Omniverse Cloud里面的视觉内容,现在可以串流到Vision Pro眼镜里了。

Vision Pro作为Omniverse的入口,可以承载英伟达版本的元宇宙。最直观的变化是,以后可以用Omniverse里面的各种设计工具,包括什么CAD之类的,借助Vision Pro眼镜来做设计。虽说只是云上内容的串流——和苹果的软硬件架构乃至生态关联性都没那么大,但苹果和英伟达这两家公司这些年来如此微妙的关系,似乎在这一刻达成了罕见的和谐。

要我们说,前年底到去年一整年生成式AI旋风扫过整个地球之际,英伟达的几场GTC都把最大的篇幅给到了AI,曾经C位的Omniverse惨遭冷落。但今年的这场GTC,虽然还不能说Omniverse是绝对C位,但起码主角地位还是在的。

据说今年GTC上播的很多芯片宣传片,都是基于Omniverse物理模拟打造的,“展示的一切都是homemade。”黄仁勋说,英伟达的“灵魂”所在,是交汇了计算机图形、物理和AI的Omniverse虚拟世界。

仔细想想,元宇宙让你从VR眼镜中看见的,首先就需要图形显示;其次图形显示最好得要符合现实世界的物理规律,比如说光线反射、弹簧落地后如何弹起、不同材料的观感和物理特性等,因为只有这样的元宇宙,才会让人们感觉到“符合直觉”;

然后就是元宇宙里需要AI,不管是你个人的人物形象说话,唇形和你的说话内容匹配需要应用AI模型;还是对话对象反馈可能是生成式AI——日通元宇宙里有很多ChatGPT——以提供不同服务的方式与你对话,只不过这些ChatGPT都有自己的形象,有各自专注的领域;抑或工业元宇宙的数字孪生要用来做现实世界的模拟仿真...AI都是不可或缺的~

不过说起来,Omniverse今年的地位究竟为什么提高了呢?

元宇宙还在扩建

我们一直说Omniverse作为一个平台,有两个重要职能,一是设计协作,二是数字孪生。这两个职能本身也高度关联。对于“设计协作”这个职能而言,Omniverse里面提供了各种设计工具,包括来自Autodesk, Adobe, 西门子等的工具。以相同的标准和格式(OpenUSD),将设计在不同的工具间做串联,并且其中融入了英伟达的渲染、物理模拟技术。

而“数字孪生”(digital twin)本身就是一种数字设计、数字构建。各行各业首先将其产品做完全的数字化,从一个具体的物件,变成数字可描述的计算机对象;尔后以高保真的方式,在数字世界里构建、模拟或仿真这样的产品。最终模拟出来的东西,就是数字孪生。数字孪生的价值,是可以直接被数字化操纵、运行,以此可用于指导现实世界那个“物理孪生”的构建和运行。

Omniverse的用户借助Omniverse来构建新的工具和服务。比如说宝马用Omniverse构建车厂的数字孪生;亚马逊用Omniverse打造仓储、物流的数字孪生...

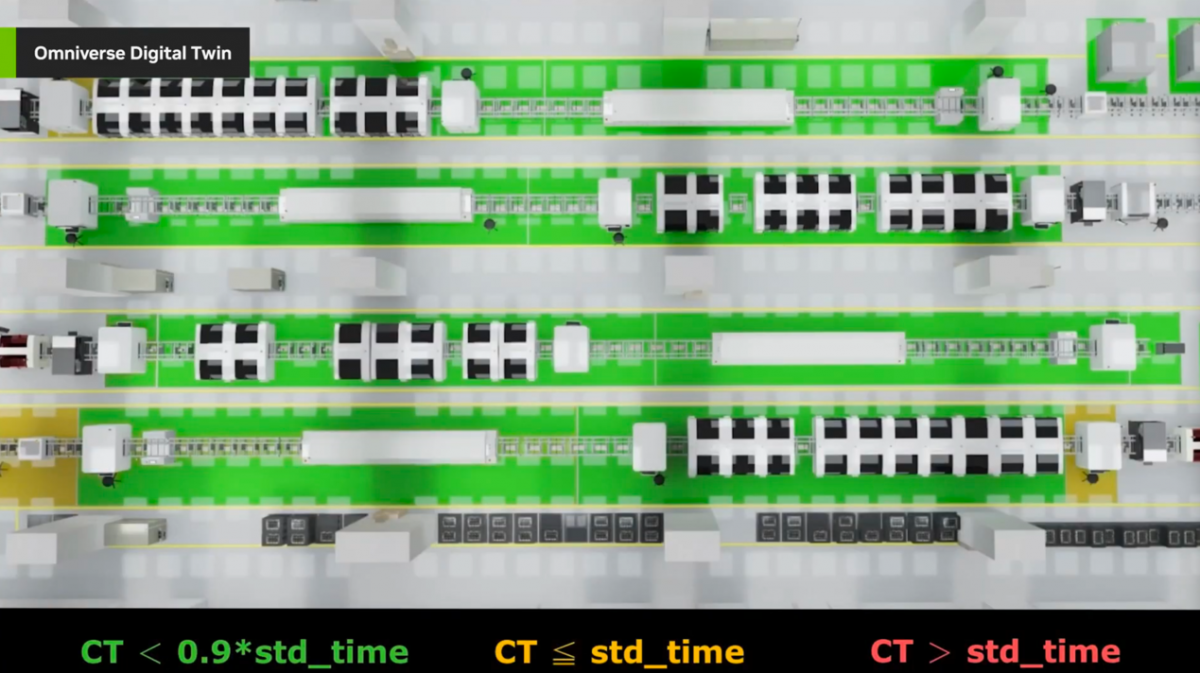

今年有个有趣的数字孪生实例,黄仁勋说,“数字孪生的范围在扩散,帮助企业第一时间完美地构建很复杂的东西。”纬创(Wistron)作为英伟达的ODM合作伙伴,据说用Omniverse打造了英伟达DGX与HGX工厂的数字孪生。“纬创在物理级精准的数字环境中,测试和优化工厂布局...”“Omniverse数字孪生帮助纬创快速测试新布局,在现有环境中适配新的工艺、提升运营能力,并且基于实时的IoT数据,监测生产线上每台设备的实时操作。”

如果我们没理解错的话,这就属于用英伟达的技术,来造英伟达的产品了——双方互为客户。从这个角度来看,英伟达这次又宣布Ansys, Synopsys, Cadence接入到Omniverse或者其他相关加速计算的合作(包括Cadence借助英伟达GPU构建自己的超级计算机、Synopsys和台积电正式启用加速计算光刻的cuLitho等),都是类似的奇妙关系。

原本英伟达的供应商,现在也纷纷成为了英伟达的客户,加速计算、元宇宙果然还是有魅力的...颇有一种万物皆可加速,万物皆可元宇宙、以及未来万物皆可tokenized的即视感...所以黄仁勋再度重申了“加速计算已经到达临界点”,“通用计算动力不足(run out of steam)”。

实际上,即便近些年英伟达市值飙升万亿,营收三位数增长,就企业市场及数据中心的角度来看,包含Omniverse数字孪生在内的“加速计算”都只能算是小众。去年英伟达发布cuLitho加速库时,当时我们听闻foundry厂的数据中心超九成算力都还是来自CPU是颇为震惊的;可见千行百业的加速计算普及还任重道远。

所以英伟达现在的工作,无疑是大力推广加速计算,大力推广NVIDIA AI、HPC和Omniverse。在前年的GTC上,我们就谈过Omniverse Cloud的发布,把Omniverse直接带到云上,就是为了让Omniverse覆盖更多用户。去年SIGGRAPH顶会上,英伟达似乎是首次提到了Omniverse Cloud API——当时宣布ChatUSD, DeepSearch都会以API的形式交付给开发者。

今年GTC上,英伟达应该算是正式发布了Omniverse Cloud API。

元宇宙的API

那这个所谓的Omniverse Cloud API究竟能用来做什么呢?英伟达举了三个例子。其一是那些3D软件开发者可以将Omniverse的Viewports嵌入到其软件中,这样一来他们的软件就能以实时渲染3D对象了——当然是从云上串流下来的。已经在这么用的是西门子,具体应该是融入到西门子Team Center X里面(或Siemens Xcelerator平台)。

西门子CEO Roland Busch说,他们的客户借此就能进行大规模工程数据集的可视化,而且是可交互的。这就属于典型的数字孪生直观呈现了,这其中实际还采用生成式AI做了3D对象和背景的生成。Demo展示的是HD Hyundai的货轮——真正的数字孪生。西门子未来应该还打算将Omniverse Cloud能力融入到更多软件中,实现跨部门和工具的协作。

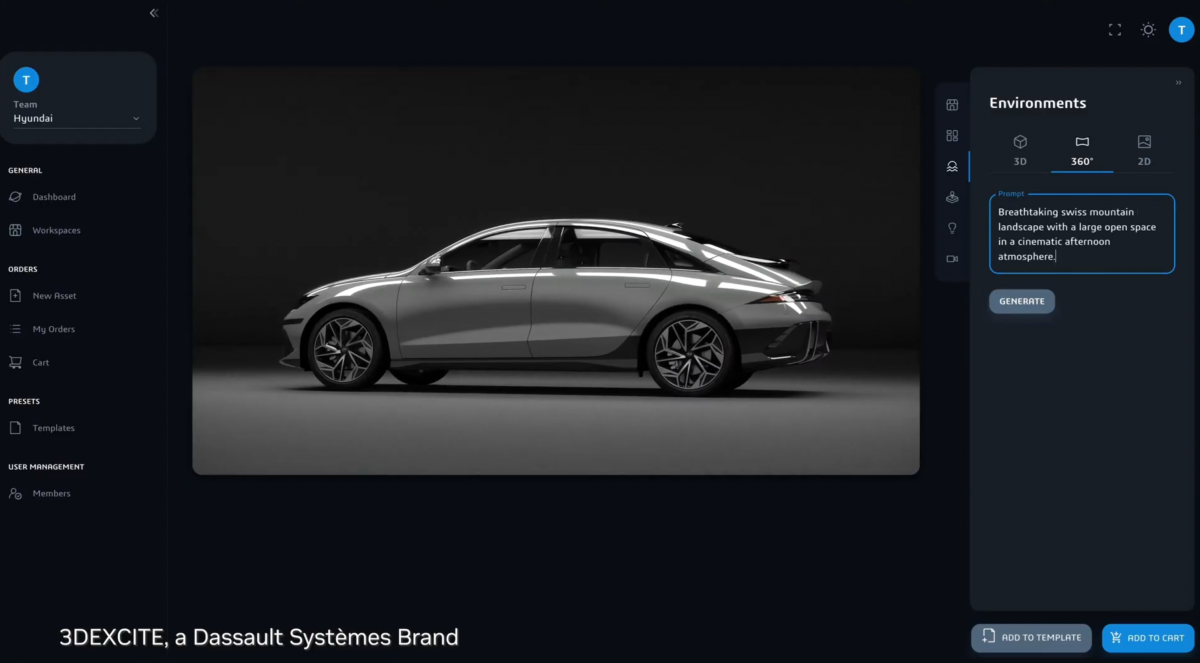

第二个例子是达索系统,3DEXCITE采用Omniverse Cloud API,这里另外强调的应该也在于把Edify(一个具备3D资产生成能力的模型)生成式AI工具,和Omniverse Cloud的能力都放进他们的应用里。

还有一个例子是自动驾驶汽车、机器人相关的。AI开发者需要很多的传感器数据来对感知AI系统做训练、测试、验证。这个过程需要做传感器模拟,那就需要搭建一个物理级精准的虚拟环境。

Foretellix就选择了Omniverse Cloud API来做这件事,据说在采集真实世界传感器数据方面节省了一大笔开销。这个例子以往我们也听过,不过是作为Omniverse企业级应用部署到企业内部的,在这里则是基于Omniverse Cloud API,对企业开发者而言应该会轻量很多。

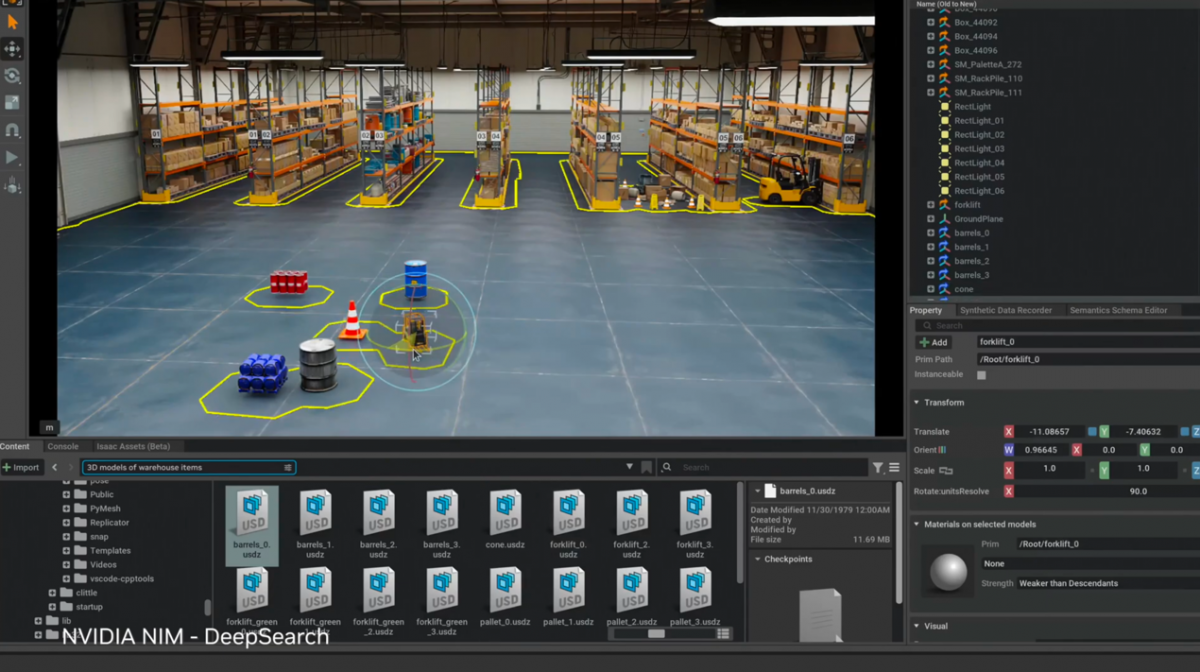

值得一提的是,前文提到的ChatUSD, DeepSearch都是降低OpenUSD这种格式的使用门槛的,它们本身是帮助生成USD,获取USD资产的生成式AI对话工具。这两个工具去年就做过展示,也算是Omniverse的入门工具了,亦为扩大Omniverse生态的组成部分——典型的生成式AI为元宇宙服务的例子。

总的来说,借助Omniverse Cloud API,开发者可以直接把Omniverse相关技术能力,带到自己的app和工作流中。“ISV也能用上Omniverse,包括跨不同工具的互操作性(尤其OpenUSD标准格式)、物理级别的实时渲染、跨用户和设备的协作能力。”Omniverse Cloud API今年晚些时间会在微软Azure云上提供。

前文提到的西门子、Ansys、Cadence、达索系统、Hexagon、Rockwell Automation、Trimble等涵盖设计、工程、模拟等领域的企业都会去用Omniverse Cloud API。

把AI带到现实世界

在《电子工程专辑》4月刊封面故事里,我们详述了图形与AI未来的和谐共生。其中有一个观点是这样的,我们现在谈论的AI,尤其生成式AI,现阶段主要在数字世界发挥作用。所以生成式AI最早“抢夺”工作的对象,通常是内容创作领域的一批人,包括文字、图像、视频内容创作...

如果要让生成式AI抢走更多现实世界的活儿,则图形世界的数字孪生构建、模拟,最终体现到物理孪生的机器人身上,这个过程是不可或缺的。所以我们始终在强调一个观点:数字孪生或者说元宇宙,其实是AI在物理世界全面发挥作用的媒介。前文形如Foretellix的例子就是个典型。

或者说Omniverse里面的Isaac Sim,如果训练机器人捡东西,绕过障碍物、识别对象位置形状、如何拿起之类的过程,就是基于AI技术,在数字孪生的虚拟世界里进行的。最终,现实世界的机器人也就能掌握对应的技能。机器人、汽车之类的应用,似乎是数字孪生的终极服务目标。这也是元宇宙最务实的一大价值。

黄仁勋把这个过程里的AI称为“physical AI”。而且英伟达在这个逻辑里的全流程都有布局。下面这张图就阐释了该逻辑链条中三个最主要的环节。“要让AI理解物理世界,要进入下一波AI浪潮,我们需要这样3台计算机。”

第一台计算机是AI计算机(DGX),AI相关的训练工作,“万亿参数的模型”,“里面可能有合成数据生成(synthetic data generation),可能会有很多人类行为的例子”,“AI观察我们人类,理解人类的行为,并且尝试让他们自己去适应对应的环境”。

最终的理解要转到机器人身上,也就需要围绕AGX为核心的机器人系统。从芯片的角度来看应该是很多人熟知的Jetson(虽然其实我们对于什么Jetson, AGX之类的市场概念一直都是相当蒙圈的,因为英伟达提出相关产品的市场概念实在是太多了)。这应该也是英伟达现阶段有Efficient AI研究,期望将生成式AI更高效地放进Jetson边缘的原因之一。

“而在这两者中间,还需要另外一台计算机。”黄仁勋说,“提供给机器人各种例子,然后需要进行机器人强化训练的反馈,让机器人的行为真正变得有效(align the robot)。”“它们就会越来越适应物理世界。”

“所以我们还需要一个模拟引擎,为机器人准备的数字世界,机器人有这样一个场地来学习如何做好一个机器人——这样的地方就是Omniverse,而跑Omniverse的计算机就是OVX。”

为机器人提供支撑的这套技术链路里,Omniverse与AI达成了和谐统一,这也应该算得上是图形与AI的和谐统一,是英伟达GPU图形渲染与AI加速的逻辑自洽(虽然其实在这个例子里,OVX本身可能已经体现了这一点)。

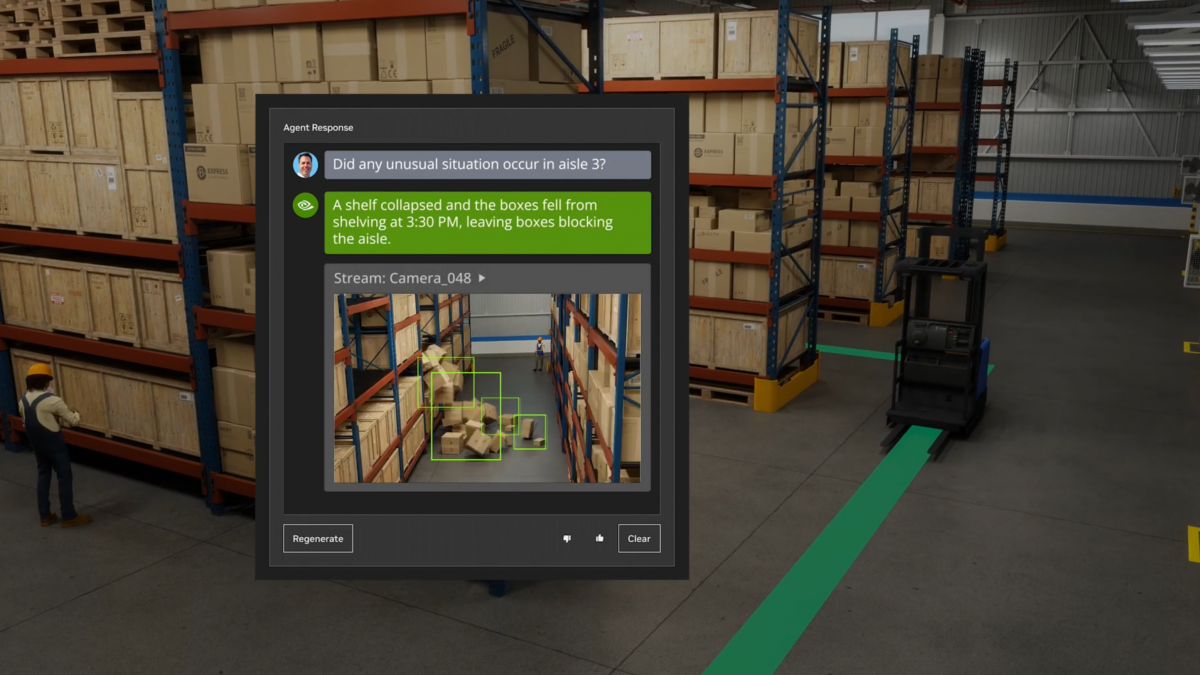

黄仁勋为此展示了仓库的例子——10万平方英尺的仓库,其中有运货的各种机器人(运货叉车之类的也是机器人)。这些机器人就是完全自主工作的,机器人与机器人、机器人与环境、机器人与人之间都可交互。

比如说某个货架的货物掉落,挡住了某条运货路径,则AI很自然地会发挥作用,以重新规划运货路线。工厂运维人员也可以直接问生成式AI,工厂内部是否有异常,生成式AI马上就能报告情况。

其中具体的构成组件这里就不谈了,包括NVIDIA CuOpt路径规划、Metropolis应用框架之类,此前我们都撰文谈过。不过很显然,工厂与机器人的数字孪生,以及各种AI构成,在此表现得相当明确。

最后一步,当然还有部署到真实世界中去的过程。如果不把话讲到元宇宙,以及AI照进现实世界那么大,更务实的说法是,英伟达期望借助这些产品和技术,来攻坚在黄仁勋看来数字化价值潜力极大的工业市场。即便科幻小说似乎是把这个世界描绘成机器人密布的未来世界的,那么这个价值大概还可以再往上加。

再往下就该去谈机器人、汽车,以及这次新发布的Project GROOT了。这就不是本文要谈的重点了。今年GTC有关Omniverse、数字孪生、元宇宙的内容不单是前面提到的这些,还有Earth Climate地球气候研究数字孪生的更进一步,乃至6G网络借助Omniverse虚拟世界的模拟测试等等...

似乎是在Meta早前悉数押宝元宇宙之后,大众对于元宇宙的质疑声就没断过。在我们看来,一方面是大众对“元宇宙”的理解似乎被带偏了,数字孪生的一点点构建都属于元宇宙的添砖加瓦;另一方面其实元宇宙的构建,自其提出之日起就没有停过,只不过可能并不是以很多人预期的方式。

之前我们总在说,游戏是元宇宙最基本的雏形,尤其是那些开放世界游戏。一个硕大的世界,光影效果在尽可能模仿现实世界,玩家可以在其中与不同的人、物做交互,还可以交易、聊天...这不就是最基本的元宇宙吗?而NVIDIA ACE游戏版这样的技术,让每个NPC都具备更高的智商,能和你聊各种你想聊的事,就是元宇宙的精进。

换句话说,数据存储、通讯、计算,以及计算机科学、图形学、AI的每一步发展,其实都在为元宇宙添砖加瓦。就好像现在的游戏和过去的游戏,算力水平需求、图形特性及NPC智能程度,都早已经不是当年可及。它们都会成为元宇宙的技术构成要素。

- 呵呵,不在职场,看热闹。

数字孪生或者说元宇宙不就是打造本次人类文明的诺亚方舟? - 元宇宙对于Nvidia来说,只是充当“卖铲人”的角色,行业未来兴起会带动自己收入增加,行业没有未来也不妨碍他们,自然会不遗余力去宣传。真正把元宇宙当作收入来源的公司,才是真正需要深入思考文章标题的主角。