电子工程专辑讯 近日,三星宣布将开发下一代人工智能芯片Mach-1,Mach-1 AI 芯片目前正在开发中,计划在年底前推出原型机。

三星正在开发的Mach-1是一款片上系统(SoC)形式的人工智能加速器,旨在减少图形处理单元(GPU)和HBM芯片之间的瓶颈。也就是说,希望Mach-1能通过多种算法,将内存和GPU芯片之间存在的问题能减少到目前的八分之一,将效能提高八倍。

Mach-1已经通过FPGA技术验证,目前正进行系统芯片(SoC)的物理定型阶段。三星电子设备解决方案部门主管Kye Hyun Kyung表示,芯片将在年底前准备就绪,明年初正式推出由Mach-1芯片驱动的人工智能系统。

当前HBM大热,SK海力士作为主要供应商占据市场半壁江山,三星或将企图通过AI芯片与SK海力士的HBM市场进行竞争。

HBM因AI应用而火,起初英伟达的HBM供应商主要是SK海力士,SK海力士在这一市场占据主要份额。现在随着AI芯片需求的大幅提升,三星与美光快速入局,并加大该市场的份额。

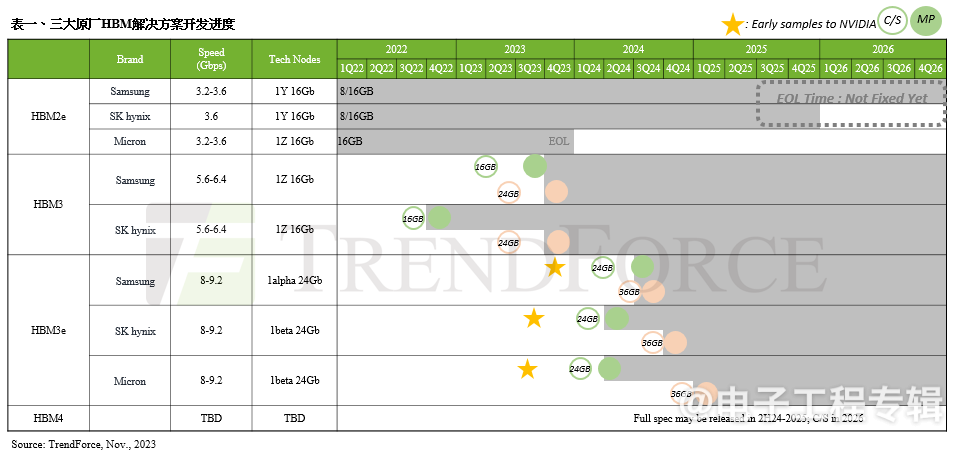

如下图可见,美光在HBM3这一代产品中并未入局,在今年3月,美光已经官宣HBM3e的量产,英伟达H200 Tensor Core GPU将采用美光8层堆叠的24GB容量HBM3e内存,并于今年第二季度开始出货。

在3月, SK海力士宣布,公司率先成功量产超高性能用于AI的存储器新产品HBM3E,将在3月末开始向客户供货。这是公司去年8月宣布开发完成HBM3E后,仅隔7个月取得的成果。

三星在2024年第一季度,其HBM3产品陆续通过AMD MI300系列验证,其中包含其8层与12层产品,加快了追赶SK海力士的步伐。在今年2月,三星表示已开发出 HBM3E 12H,这是一个 12 堆栈 HBM3E DRAM,也是迄今为止容量最高的 HBM 产品。三星表示,将于今年开始量产该芯片。

三星Mach-1目标似乎并不是跟AWS Trainium或NVIDIA H100等面向云端的高性能AI处理器企业们竞争,而是定位于需要低功耗、小尺寸和低成本的边缘计算市场。不过Mach-1仍可能与AWS Inferentia等其他面向推理的解决方案竞争。