根据Omdia等市场研究机构数据,英伟达(Nvidia)今年将从数据中心GPU中获得 870亿美元的收入,同比增长150%。由于领先优势太明显,所以最近英伟达首席执行官(CEO)黄仁勋声称“英伟达的 GPU非常好,即使竞争对手的芯片是免费的,但它也不够便宜”。

黄仁勋进一步解释说,就 AI 数据中心的总拥有成本(TCO)而言,英伟达 GPU 的定价并不重要。

别看价格,看“疗效”

近日,黄仁勋回到了母校美国斯坦福大学,根据斯坦福经济政策研究所(SIEPR)放出的一段经济峰会视频, SIEPR前 Trione 主任John Shoven、斯坦福大学经济学名誉教授 Charles R. Schwab 问道:“你们制造了最先进的芯片,但将面临足够好而且便宜得多的竞争对手,A(AMD)会是威胁吗?”

黄仁勋表示:“我们的竞争比地球上任何公司都激烈,在某些情况下,甚至英伟达和客户之间也是竞争对手。此外,英伟达还积极帮助正在设计替代 AI 处理器的客户,甚至向他们透露了即将推出的英伟达芯片路线图。”

黄仁勋指出,英伟达的 GPU 是可程序设计的,可打造擅长某种特定算法的芯片,且公司平台已成为各大云计算公司的重要标准,从金融服务到制造业等各种客户都会被英伟达硬件吸引。

黄仁勋称,英伟达以“完全开放的方式”运作,同时与业内几乎所有其他人合作。“我们的芯片只是一部分,当你看到现在的计算机时,它不像是普通的笔记本电脑,它是一个数据中心,你需要运营它。所以购买和销售芯片的人考虑的是芯片的价格,而运营数据中心的人会考虑运营成本。当然,公司会很清楚总体拥有成本,如部署时间、性能、利用率和灵活性。就数据中心的总拥有成本而言,英伟达GPU的定价并不重要,我们的TCO要比竞争对手好很多。所以即使竞争对手的芯片是免费的,它也不够便宜。”

近一年来,随着生成式 AI 和大模型的发展对算力提出更高要求,以英伟达GPU为主的AI芯片开启了一轮又一轮的涨价,A100和H100这些主流产品成了硬通货,甚至涨价也买不到。是否真如黄仁勋所言,其他AI芯片厂家一点机会都没有?3月29日,在IIC Shanghai同期举办的GPU/AI芯片与高性能计算应用论坛上,将邀请代表性的国内外AI 芯片厂商与大家探讨这个问题,欢迎点击报名参会。

你看不惯我,又干不掉我

不过这个说法与英伟达最近的新闻大相径庭,因为有人指控他们的商业行为和垄断集团卡特尔(Cartel)行为相似,还有客户因为订单被延后,不敢下订单给竞争对手。

黄仁勋在结束对 Shoven 的回答时强调,英伟达的目标是“以无与伦比的 TCO 保持领先地位”、“英伟达所做的一切都是通过艰苦的工作和创新实现的,没有运气成分,也没有什么是理所当然的。”

英伟达推动了 AI 产业蓬勃发展,使其成为全球第三大最有价值公司。黄仁勋最新言论肯定会引起争议,因为他否定一大批竞争对手,如 AMD、英特尔及拥有 ASIC 和其他定制 AI 芯片的竞争对手。

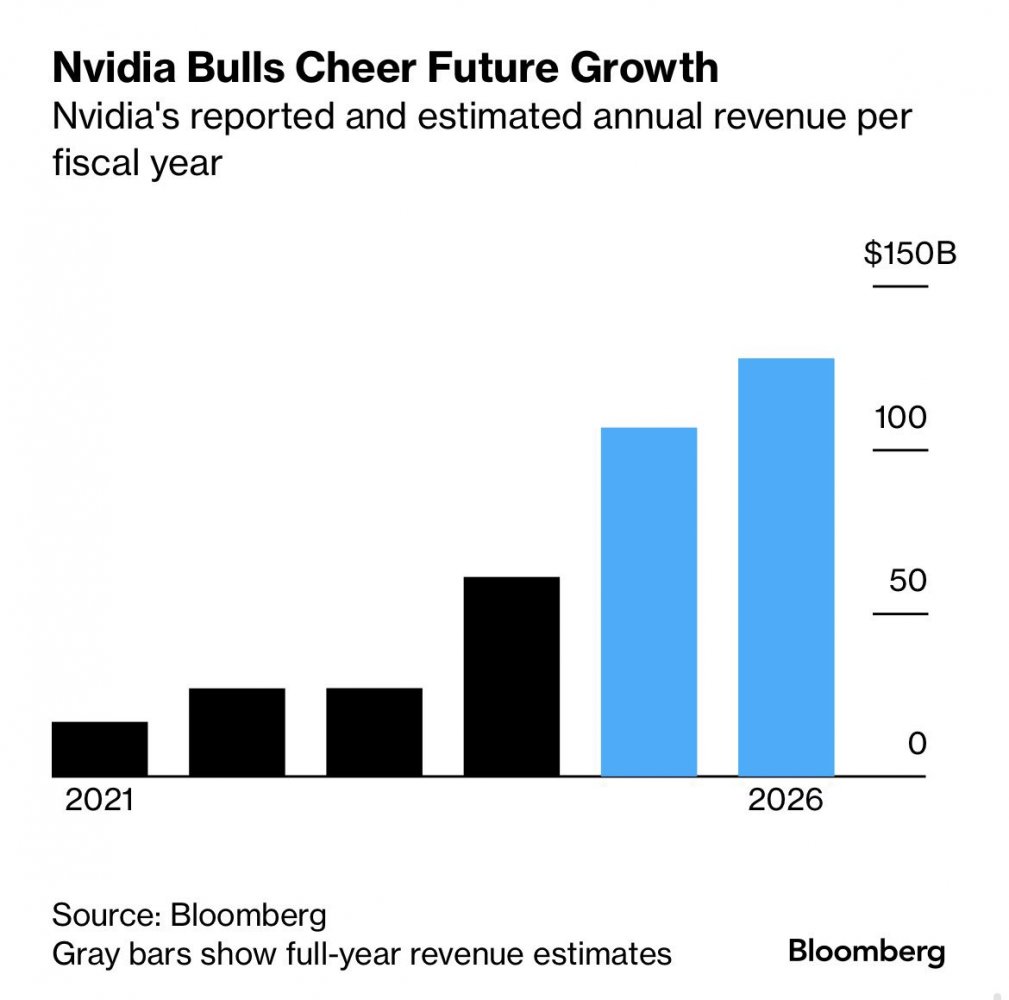

尽管英伟达竞争对手可能对黄仁勋的言论持不同意见,但英伟达在 AI 领域的领导地位显而易见。预计到2026年,英伟达将获得高达1300亿美元的收入,比23财年高出五倍(几乎比2021年增加了1000亿美元)。这意味着整体营收将增长 125%,而这些数字是该行业过去从未见过的,这一切都归功于数据中心和 AI 加速器需求所带来的巨大 AI 需求。

竞争对手需要证明他们能提供匹敌甚至超越英伟达的价值,才可能改变市场格局,为了推翻英伟达主导的CUDA计算平台,业界联盟也已成立。

AMD MI300正快步追来

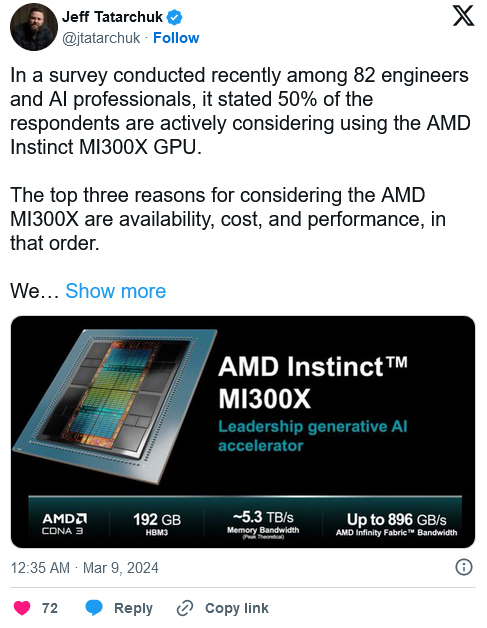

事实上,AMD MI300系列这一代还是可圈可点的,也吸引了大量用户。TensorWave对82名高级工程师、AI专家进行的独立调查显示,大约50%的受访者表示对AMD MI300X GPU充满信心,原因是相比NVIDIA H100系列不但性价比更高,而且供货充足,不会因为缺货而加价。TensorWave自己也采购了AMD MI300X。

AMD Instinct系列产品其实已经发展了很多代,但此前无论性能还是市场接受度都远逊于对手。

这一代的MI300X实现了性能飞跃,相比H100内存容量多2.4倍、带宽高1.6倍、FP8、FP16浮点性能都高1.3倍,FlashAttention 2、Llama2(700亿参数) 1v1对比测试领先20%,Bloom(1760亿参数)、Llama2(700亿参数) 8v8测试领先60%、40%。

AMD还打造了MI300A,首次在数据中心同时集成了CPU、GPU,但目前尚未铺开。

AMD首席执行官苏姿丰此前预测,AMD AI芯片2024年的收入将达到35亿美元,大大高于此前预计的20亿美元。

当然,AMD在开发支持、生态建设方面还存在较大的差距,仍需努力追赶。

拓展阅读:下一代DGX GPU服务器将采用液冷

据此前报道,黄仁勋还在会议中确认,其下一个 DGX GPU服务器很快就会到来,暗示着Blacwell B100 GPU加速卡距离发布已经不远了——官方只说2024年内,消息称已提前到二季度。另一个令人兴奋消息是这代产品将会采用水冷散热,黄仁勋直言整个系统非常壮观(magnificent)、非常迷人(beautiful)。

在此前的一次会议中,戴尔确认英伟达明年还会推出升级版B200 GPU,最高功耗可达1000W,甚至有说法称会有恐怖的1400W。而目前的主力AI GPU H100和升级版H200最大功耗为700W,核心面积814平方毫米,均只需风冷。

AMD MI300X则需要750W,但是面积也更大一些达到了1017平方毫米。

如今服务器和数据中心使用浸没式液冷散热已经稀松平常,但也有很多专家对这种发展途径持反对态度。

Moor Insights & Strategy的创始人、CEO兼首席分析师Patrick Moorhead就明确提出,为了提高性能,并控制合理的功耗、发热,我们已经穷尽了手段,但接下来该怎么办?上液氮吗?是时候重新思考了。