电子工程专辑讯 近日,谷歌公司推出的人工智能(AI)模型Gemini在生成人物图像时出现疑似“反白人”的问题,在社交媒体上,Gemini生成的图片与历史不符这些图像大多以有色人种代替白人。

这一失误表明,人工智能在处理种族概念时仍有困难。例如,OpenAI 的 Dall-E 图像生成器就因大规模延续有害的种族和民族刻板印象而备受指责。然而,谷歌试图克服这一问题的努力似乎适得其反。

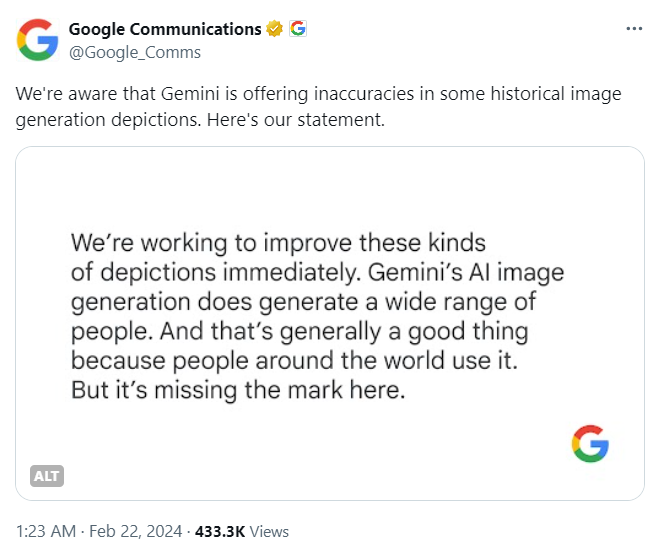

谷歌对此表示,正在努力解决Gemini的人物图像生成的最新问题,同时决定暂停Gemini的人物图像生成,并将很快重新发布改进的版本。

与ChatGPT一样,Gemini 也是通过在大量“数据”的基础上进行训练。有专家们早就警告过,人工智能工具因此有可能复制这些信息中的种族和性别偏见。

这件事,也是谷歌在人工智能领域与 OpenAI以及其他参与者较量时的一次挫折与挑战。

在2月初,谷歌对人工智能聊天机器人进行重大的品牌重塑,Bard更名为Gemini,是OpenAI的ChatGPT的主要竞争对手。Gemini对全球用户允许访问权限,Android用户可以下载新的Gemini专用Android应用程序,iPhone用户可以在iOS上的谷歌应用程序中使用Gemini。

Google 的高级副总裁Prabhakar Raghavan表示,Gemini一款创造力和生产力工具,它可能并不总是那么可靠,尤其是在生成有关时事、不断变化的新闻或热点话题的图片或文本时。它会犯错。正如我们从一开始就说过的,幻觉是所有 LLM 面临的一个众所周知的挑战。Gemini会尽量根据提示给出符合事实的回答,但我们还是建议大家依赖谷歌搜索,我不能保证双子座偶尔是否会产生令人尴尬、不准确或令人反感的结果,但我可以保证,只要我们发现问题,我们就会继续采取行动。人工智能是一项新兴技术,在很多方面都有帮助,潜力巨大,我们会尽最大努力安全、负责任地推广它。