AI这个巨大的风口上,每天都有新闻在刷新人们的认知。在OpenAI推出文本转视频大模型Sora火爆全网后,一家2016年成立的初创公司Groq又凭借其同名大模型火出圈。

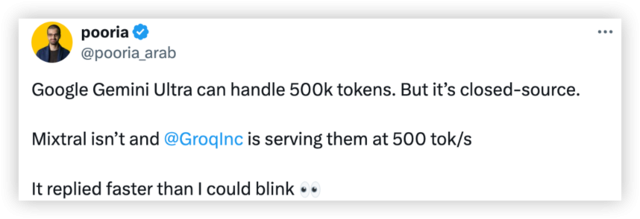

在传统的生成式AI中,等待是稀松平常的事情,字符一个个蹦出,半天才能回答完毕。但在Groq模型启动器上运行的大语言模型(LLM),能够每秒输出近500个token,有网友将其与GPT-4、Gemini对标,看看它们完成一个简单代码调试问题所需的时间,没想到Groq完全碾压两者,输出速度比Gemini快10倍,比GPT-4快18倍。

当模型收到提示后,几乎能够立即生成答案。这些答案不仅真实可信,还附有引用,长度更是达到数百个单词。(不过就答案质量来说,Gemini和GPT-4更好。)

科普一下什么是tokens,以及在大模型中是干什么的。在大模型训练、推理、生成的时候,会把文本切分成最小单元即token。比如你问ChatGPT一个问题,ChatGPT会先把你完整的话切成tokens再进行计算。当ChatGPT回答的时候,也不是一下子全部输入出来,而是一个token一个token的蹦出来。

有网友震惊地说:它回复的速度比我眨眼还快。

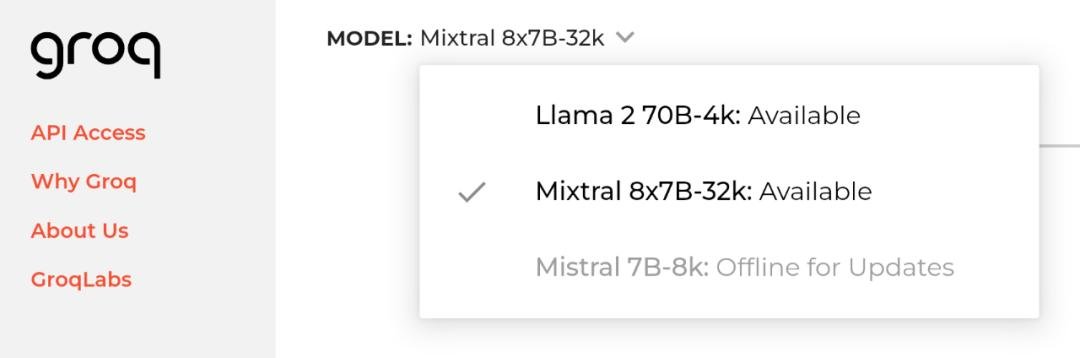

目前,Groq还提供100万token的免费试用,进入官网,目前有两种可以自选的模型:Mixtral8x7B-32k,Llama 270B-4k。 地址:https://groq.com/

也可以在Poe上免费体验Groq:https://poe.com/Mixtral-8x7b-Groq

与此同时,Groq API也向开发者提供,完全兼容OpenAI API。Mixtral 8x7B SMoE可以达到480 token/S,100万token价格为0.27美元。极限情况下,用Llama2 7B甚至能实现750 token/S。

Groq可不是卖模型的,人家是做芯片的

其实Groq并不是OpenAI那样的大模型公司,它只是一个模型启动器,主页运行的是开源模型Mixtral 8x7B-32k和Llama 270B-4k,目的是为了展现其主力产品——针对大型语言模型(如GPT和Llama)AI推理设计的语言处理单元(LPU,Language Processing Units),这是一种专用芯片(ASIC)。

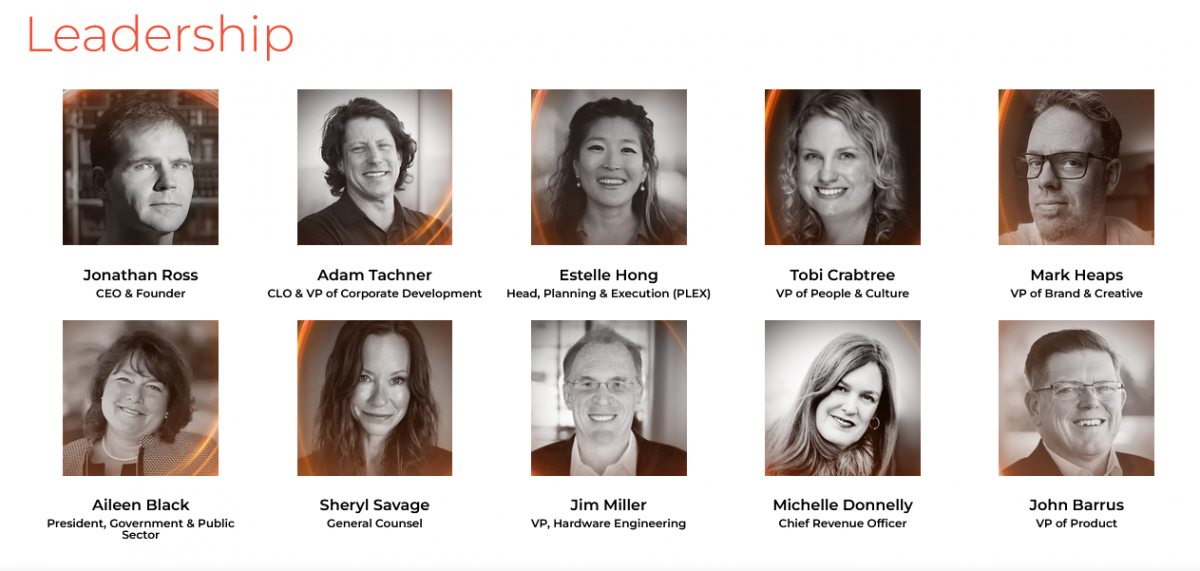

这家公司由前谷歌(Google)资深工程师乔纳森·罗斯(Jonathan Ross)创立,他曾经也是Google自研AI芯片TPU的设计者之一,被称为“TPU之父”。 联合创始人道格拉斯·怀特曼(Douglas Wightman)也来自谷歌TPU团队,并先后创立了四家公司。该公司首席技术官吉姆·米勒(Jim Miller)曾是亚马逊云计算服务AWS设计算力硬件的负责人,CMO曾主导了苹果Macintosh的市场发布。

这样的技术背景帮助Groq迅速确立了在处理单元创新领域的领导者地位。

Ross 曾表示,“Groq 的存在是为了消除‘富人和穷人’,并帮助人工智能社群中的每个人发展。 而推理是实现这一目标的关键,因为‘速度’是将开发人员的想法转化为商业解决方案的关键。”

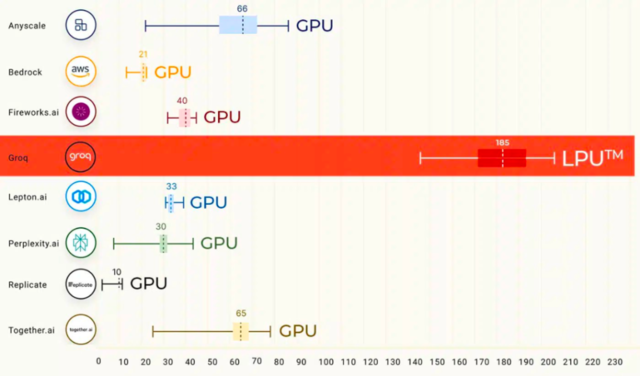

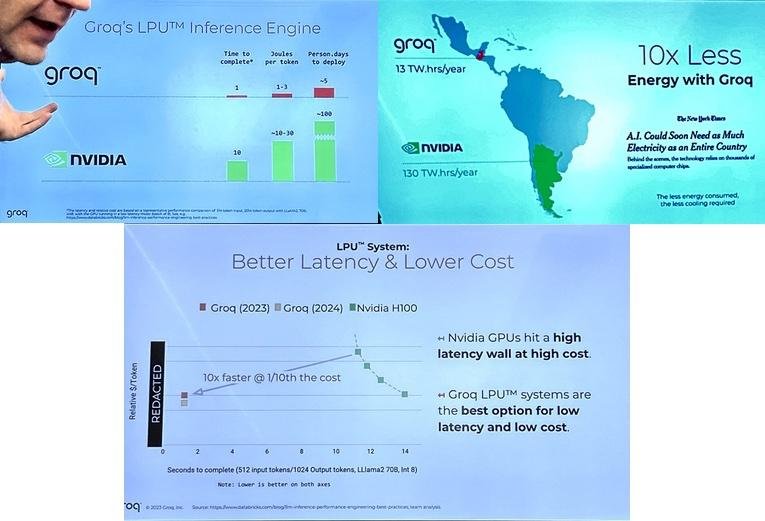

据Groq官网的测试资料显示,Groq LPU在LLMPerf排行榜上超越了基于GPU的云服务提供商(如英伟达)。由Groq LPU驱动的Meta Llama 2模型推理性能是顶级云计算供应商的18倍,在大语言模型任务上,LPU比英伟达的GPU性能快10倍,但价格和耗电量都仅为后者的十分之一。

具体在能耗方面,英伟达GPU需要大约10到30焦耳才能生成响应中的tokens,而Groq LPU芯片仅需1到3焦耳,在推理速度大幅提升10倍的同时,其能耗成本仅有英伟达GPU的十分之一,这等于是性价比提高了100倍。

图片来源:GIT HUB

速度之源是全新的TSP架构和SRAM

卓越的token吞吐量、低延迟性能、更低的功耗和价格,使得Groq一跃成为NVIDIA、AMD和Intel等AI推理硬件市场的直接竞争者。

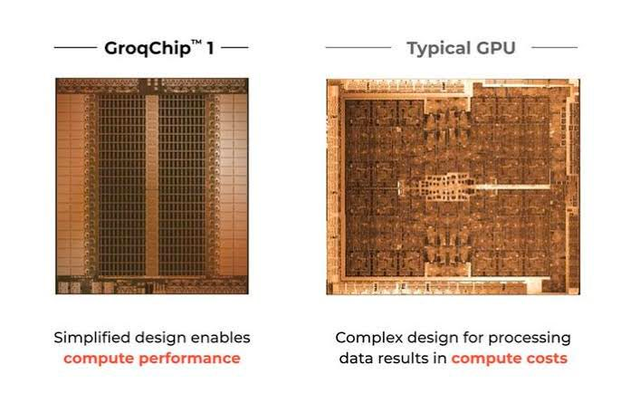

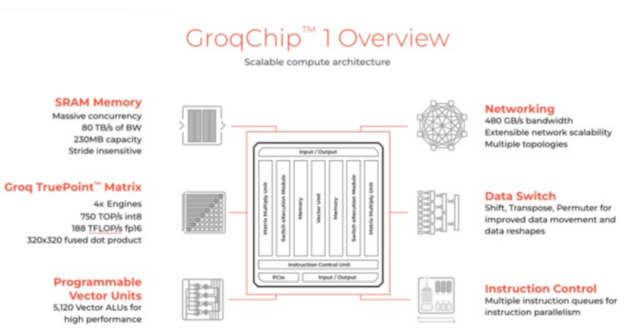

Groq LPU基于新的张量流处理器(Tensor-Streaming Processor,TSP)架构,其内存单元与向量和矩阵深度学习功能单元交错,从而利用机器学习工作负载固有的并行性对推理进行加速。

在运算处理的同时,每个TSP都还具有网络交换的功能,可直接通过网络与其他TSP交换信息,无需依赖外部的网络设备,这种设计提高了系统的并行处理能力和效率。

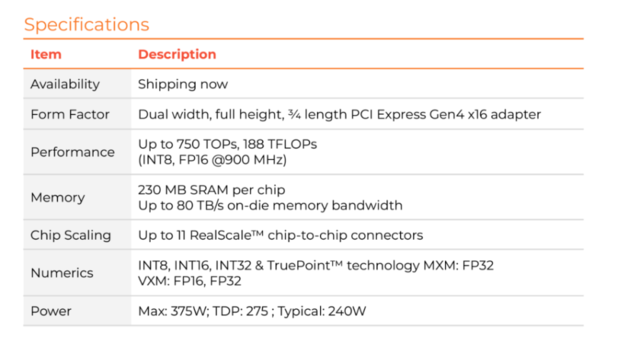

结合新设计的Dragonfly网络拓扑,hop数减少、通信延迟降低,使得传输效率进一步提高;同时软件调度网络带来了精确的流量控制和路径规划,从而提高了系统的整体性能。性能指针达到750 TOPS(INT8)和188 TeraFLOPS(FP16),并具有320×320融合点乘矩阵乘法和5,120个向量ALU。

Groq LPU拥有80 TB/s的带宽和230 MB的本地静态随机访问存储器 (SRAM)容量,提供了超快的推理速度,每秒可服务高达480个tokens。具体到不同的模型,能够以每秒300个tokens的速度服务Llama 2 70B模型,以及每秒750个tokens服务较小的Llama 2 7B模型,推理性能翻了一番多。

其特殊内存SRAM的容量是230MB,带宽80TB/s,在INT8、FP16下算力为188TFLOPs

华尔街见闻此前文章提及,Groq LPU搭配Meta Llama 2 70B能在7分钟内就能生成与莎士比亚《哈姆雷特》相同数量的单词,比普通人的打字速度快75倍。

如下图所示,有推特网友问了一个和营销有关的专业问题,Groq在四秒钟之内就输出了上千词的长篇大论。

还有网友测试同时用Gemini、GPT-4和Groq完成一个代码调试问题。

结果,Groq的输出速度比Gemini快10倍,比GPT-4快18倍。

此外,Groq的LPU推理引擎在ArtificialAnalysis.ai进行的首个独立LLM基准检验中领先,超越了八大云服务提供商的关键性能指针。基准检验结果如此出色,检测工具甚至必须调整图表轴以适应Groq的性能水平。

Groq的LPU推理引擎通过Groq API提供,为客户提供Tokens-as-a-Service,用于实验和生产的应用。Groq可支持多种用于模型推理的机器学习开发框架,包括PyTorch、TensorFlow和ONNX。但不支持使用LPU推理引擎进行ML训练。

据介绍,公司已在各种活动中展示了其LLM的低延迟性能,并已将其硬件部署到阿贡国家实验室的ALCF AI测试床,为全球研究人员提供AI加速器访问。

电子邮件初创企业Otherside AI的首席执行官兼联合创始人马特·舒默(Matt Shumer)在演示中亲自体验了Groq的强大功能。他称赞Groq快如闪电,能够在不到一秒钟的时间内生成数百个单词的事实性、引用性答案。更令人惊讶的是,它超过3/4的时间用于搜索信息,而生成答案的时间却短到只有几分之一秒。

LPU将在目标市场与GPU竞争

目前,AI芯片市场主要是由英伟达主导,H100也公认是训练大语言模型最需要的GPU。据Groq介绍,其LPU旨在解决 CPU 和 GPU 等旧技术的限制。 当面对大量运算需求时,传统的处理架构往往无法满足要求。

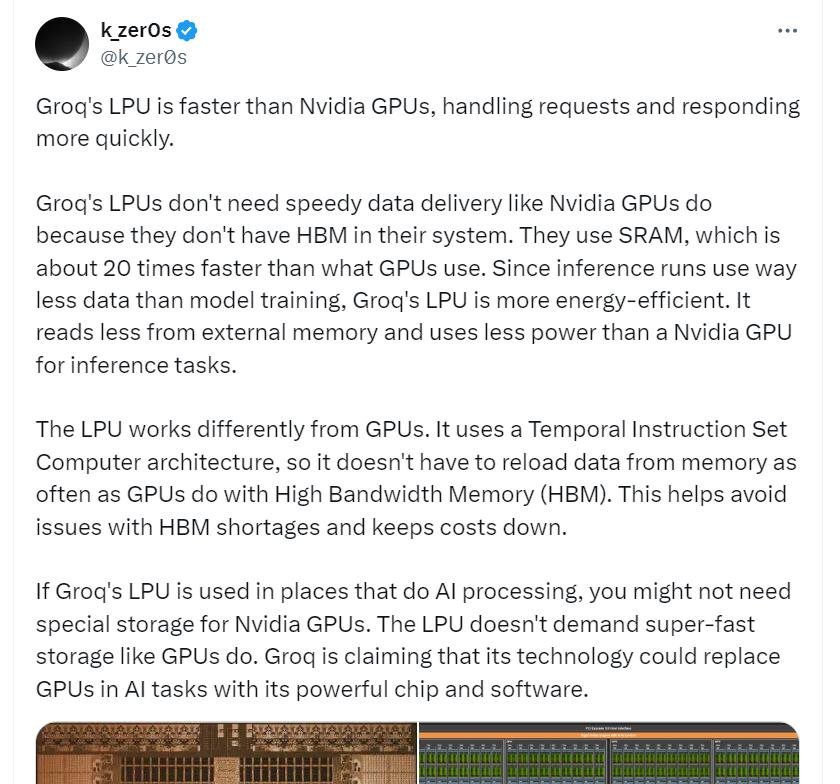

据与Groq关系密切的投资人k_zeroS在其 X 平台账号发文表示,Groq 的 LPU 不需要像 Nvidia GPU 那样快速的数据传输,因为它们的系统中没有高带宽存储器(HBM)。它们使用SRAM,其速度比 GPU 使用的速度大约快 20 倍。由于推理运行使用的数据比模型训练少得多,因此 Groq 的 LPU 更节能。与用于推理任务的 Nvidia GPU 相比,它从外部内存读取的数据更少,功耗也更少。

LPU 的运作方式与 GPU 不同。 它使用时序指令集计算机(Temporal Instruction Set Computer)架构,与GPU使用的SIMD(单指令,多数据)不同。这种设计可以让芯片更有效地利用每个时钟周期,确保一致的延迟和吞吐量,也降低了复杂调度硬件的需求,不必像 GPU 使用HBM那样频繁地从内存重载数据。

这也有助于避免 HBM 短缺问题并降低成本,目前HBM的供应除了依赖于三星和海力士,在封装上也依赖台积电的CoWoS技术。

Groq 声称其技术可以凭借其强大的芯片和软件在人工智能任务中取代 GPU,对用户而言,最直观的体验就是“快”。

有从事人工智能开发的用户称赞,Groq是追求低延迟产品的“游戏规则改变者”,低延迟指的是从处理请求到获得响应所需的时间。

另一位用户则表示,Groq的LPU在未来有望对GPU在人工智能应用需求方面实现“革命性提升”,并认为它可能成为英伟达A100和H100芯片的“高性能硬件”的有力替代品。

举个形象的例子就是:

把LPU和GPU比作两个厨师,LPU有一个高效的工具箱(SRAM),里面装着他需要的所有材料,他可以随手拿到任何东西,不需要走远路。而GPU的材料都在一个大仓库(HBM)里,每次需要材料时,都要跑到仓库去拿,这就花费了更多时间。即使仓库很大,能存很多材料(高带宽),但往返跑动的时间就使得整个烹饪过程变慢了。

LPU结构

撼动了英伟达的地位?没那么简单

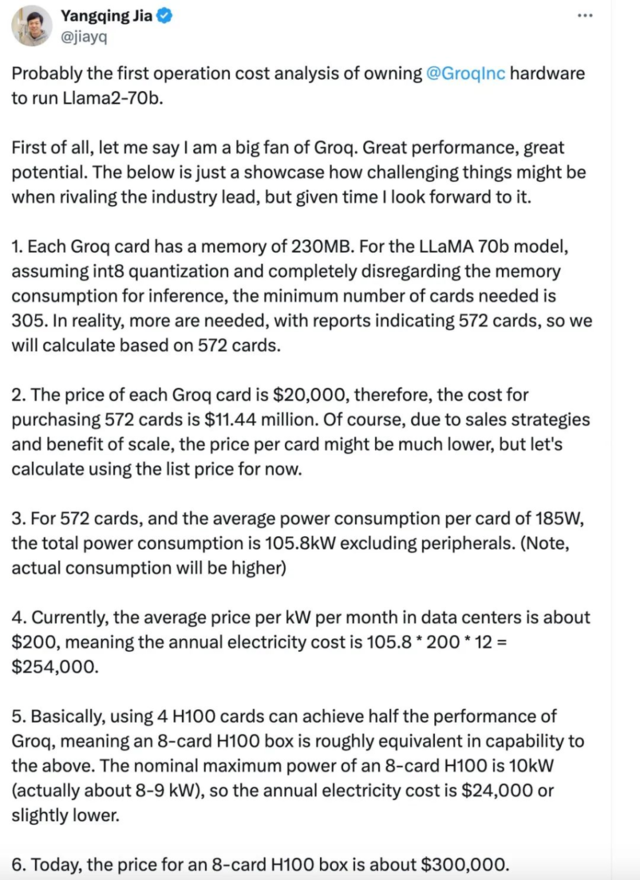

不过真相可能并没有那么简单。震撼过后,很多行业大佬一算账,发现这个快的代价可能有点高。

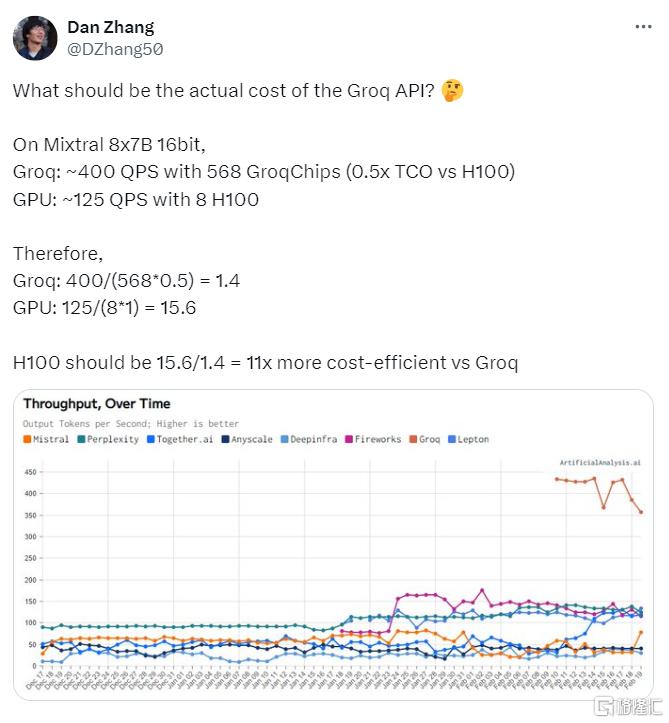

有网友分析,英伟达 H100 的成本效益应为 Groq 的 11 倍。

业内大佬贾扬清也算了一笔账,因为Groq小得可怜的内存容量(230MB),在运行Llama-2 70b模型时,需要305张Groq卡才足够,而用H100则只需要8张卡。

在第三方网站上,搭载Groq芯片的加速卡售价为2万多美元,差不多15万人民币,低于NVIDIA H100的2.5-3万美元。从目前的价格来看,这意味着在同等吞吐量下,Groq的硬件成本是H100的40倍,能耗成本是10倍。

芯片专家姚金鑫(J叔)在接受《腾讯科技》采访时,进行了更详细的解释:

按照Groq的信息,这颗AI芯片的规格如下:

从芯片的规格中,可以看到几个关键信息点:SRAM的容量是230MB,带宽80TB/s,FP16的算力是188TFLOPs。

按照当前对大模型的推理部署,7B的模型大约需要14G以上的内存容量,那么为了部署一个7B的模型,大约需要70片左右的芯片,根据透露的信息,一颗芯片对应一张计算卡,按照4U服务器配置8张计算卡来计算,就需要9台4U服务器(几乎占了一个标准机柜了),总共72颗计算芯片,在这种情况下,算力(在FP16下)也达到了惊人的188T * 72 = 13.5P,如果按照INT8来算就是54P。54P的算力来推理7B的大模型,用大炮打蚊子来形容一点也不为过。

目前社交媒体广泛传播的文章对标的是英伟达H100,其采用的是80G的HBM,这个容量可以部署5个7B的大模型实例;我们再来看算力,稀疏化后,H100在FP16下的算力将近2P,在INT8上也将近4P。

那么就可以做个对比,如果从同等算力来看,如果都是用INT8来推理,采用Groq的方案需要9台包含72片的服务器集群,而如果是H100,达到同等算力大约需要2台8卡服务器,此时的INT8算力已经到64P,可以同时部署的7B大模型数量达到80多个。

原文中提到,Groq对Llama2-7B的Token生成速度是750 Tokens/s,如果对标的是H100服务器,那这2台总共16颗的H100芯片,并发吞吐就高到不知道哪里去了。如果从成本的角度,9台的Groq服务器,也是远远贵过2台H100的服务器(即使此刻价格已经高到离谱)。

● Groq:2万美金*72=144万美金,服务器2万美金*9=18万美金,纯的BOM成本160万美金以上(全部都是按照最低方式来计算)。

● H100:30万美金*2 = 60万美金(国外),300万人民币*2=600万人民币(国内实际市场价)

如果是70B的模型,同样是INT8,要用到至少600张卡,将近80台服务器,成本会更高。

这还没有算机架相关费用,和消耗的电费(9台4U服务器几乎占用整个标准机柜)。实际上,部署推理性价比最高的,恰恰是4090这种神卡。

因此姚金鑫(J叔)认为,抛开场景来谈对比,其实是不合适的。对于Groq这种架构来讲,也有其尽显长处的应用场景,毕竟这么高的带宽,对许多需要频繁数据搬运的场景来说,那就是再好不过了。

总结来说,Groq的架构建立在小内存,大算力上,因此有限的被处理的内容对应着极高的算力,导致其速度非常快。但反之,Groq极高的速度是建立在很有限的单卡吞吐能力上的。要保证和 H100同样吞吐量,你就需要更多的卡。

毕竟还是小公司,生存是第一要务

虽然埋头研发7年后一炮而红,但Groq目前的团队还相对较小,其总部位于加州山景城,该公司仅有180余名员工,甚至还不到英特尔等大型芯片制造商所需工程师数量的四分之一。不过目前,Groq的官网正在招人,技术岗位年薪为10万~50万美元,非技术岗位则为9万~47万美元。

Ross等人的目标是在Groq复制他在谷歌的成功经验,打造一个内部芯片项目,引领整个行业向新技术迈进。他希望吸引少数关键客户,通过广泛部署Groq芯片为公司提供稳定的收入来源,推动公司的独立发展。目前,这家初创公司已开始向潜在客户发送样品。

Groq还有个日常操作是叫板喊话各位大佬。

去年11月,当马斯克发布人工智能模型Grok时,Groq公司的开发者们就发了一篇文章说马斯克撞名自己的公司。信写的挺逗的,但这波流量他们是一点没吃到。

当时GPTs商店推出之后,Groq还喊话OpenAI创始人/CEO奥特曼:“用GPTs就跟深夜读《战争与和平》一样慢……”。

一名自称Groq工作人员的用户与网友互动时,也高调地表示,Groq的目标是打造最快的大模型硬件,并扬言:“三年时间内赶超英伟达”。

在去年底的采访中,Ross表示,考虑到GPU的短缺和高昂的成本,他相信Groq未来的发展潜力:“在12个月内,我们可以部署10万个LPU,在24个月内,我们可以部署100万个LPU。”

Groq LPU由知名电子元件生产商莫仕(molex)旗下的BittWare代工,同时该厂也为英特尔和AMD代工加速卡。

Ross 在形容公司现状的时候,则没有像之前在网上贴大字报那样高调,他表示:“这就像猎杀大象,你只需要少数猎物就能维持自己的生命,尤其在我们还如此弱小的时候。”