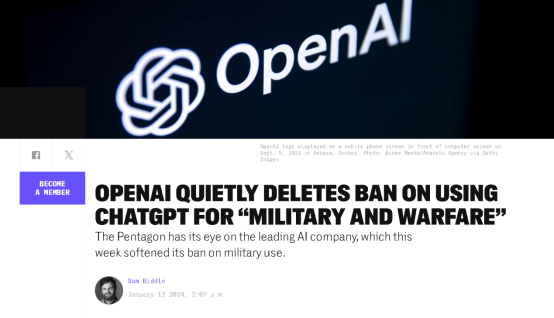

1月12日,据美国调查新闻网站“拦截者”(The Intercept)报道,开发了被全世界广泛使用的人工智能产品ChatGPT的美国知名AI公司OpenAI,于近日删除了一项涉及他们AI模型用于军事目的的使用禁令。此举虽然是悄悄进行,但被媒体曝出后立即引发大量关注。

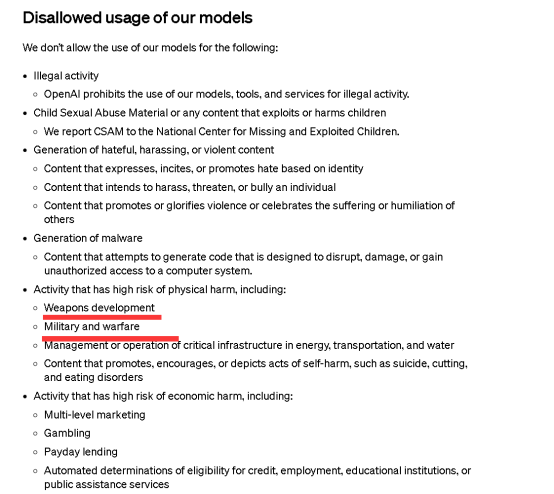

“拦截者”网站称,在今年1月10日之前,OpenAI公司在其AI模型的使用条款中曾明确表示,禁止将其模型用于很可能会造成“具有高身体伤害风险的活动”的用途上,比如“研发武器”和“军事与战争”。

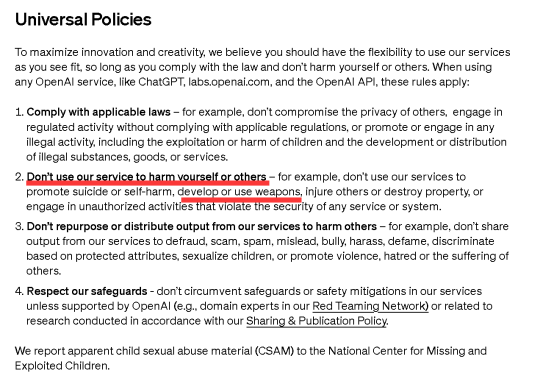

然而,在1月10日对其使用条款进行一番大更新后,OpenAI公司虽然在禁止项中仍然提到禁止将其产品、模型和服务用于会导致人员伤亡的用途上,并提到了“武器开发和使用”,但先前同样被禁止的军事用途,如今却在文本中消失了。

这一变化引发了对于OpenAI技术可能被用于不道德或非法目的的担忧。

OpenAI回应:只是简化文本

对此,OpenAI公司的发言人尼克·费利克斯(Niko Felix)在一封回复给“拦截者”网站的邮件中表示,1月10日这次对使用条款的大调整,是因为公司的产品和服务已经被全世界广泛使用,所以需要设立一套更加简洁和普适的规则,包括让规则中的文本变得更加清晰,更好被理解、记忆以及应用。

该发言人还强调,新的使用条款中提到的“不要去伤害他人”本身就是一个很宽泛同时也很好理解的概念,可以适用于很多语境之下,而且条款中还列举了武器作为一个明显的例子。

但该发言人并没有正面回应“禁止伤害”这个宽泛的表述,是否包括一切军事用途,仅称条款禁止其技术被包括军方的人用于研发和使用武器,伤害他人或摧毁他人财物,或是在未授权的情况下用于破坏任何服务或系统的安全。

专家:这次改动更强调合法,而不是安全

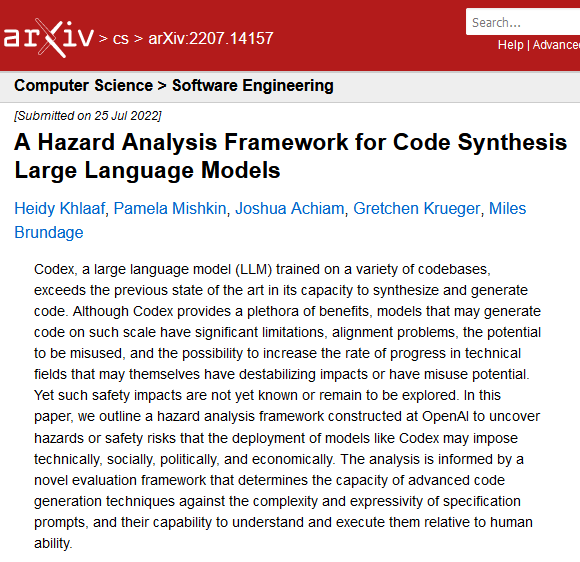

有网络安全公司Trail of Bits工程总监、机器学习和自主系统安全专家海迪·克拉夫(Heidy Khlaaf)对“拦截者”网站表示,OpenAI非常清楚在军事应用中使用其技术和服务可能带来的风险和危害。

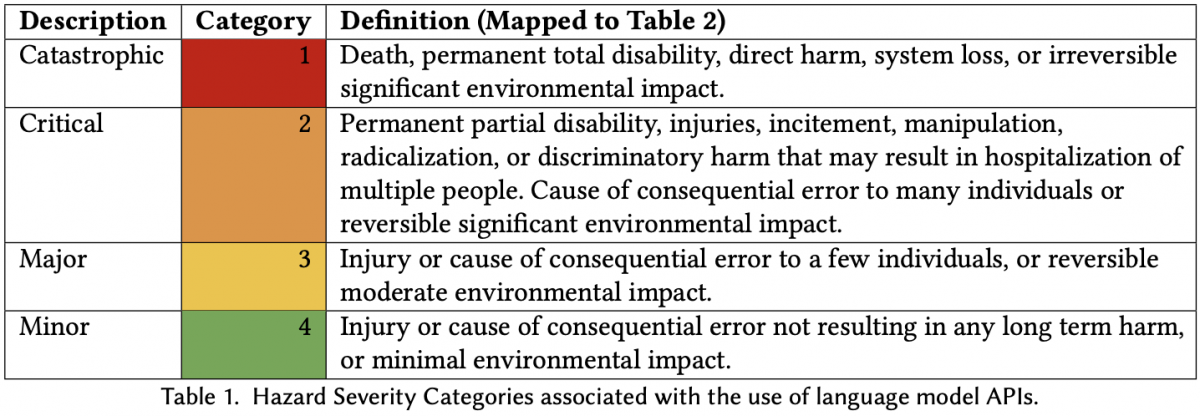

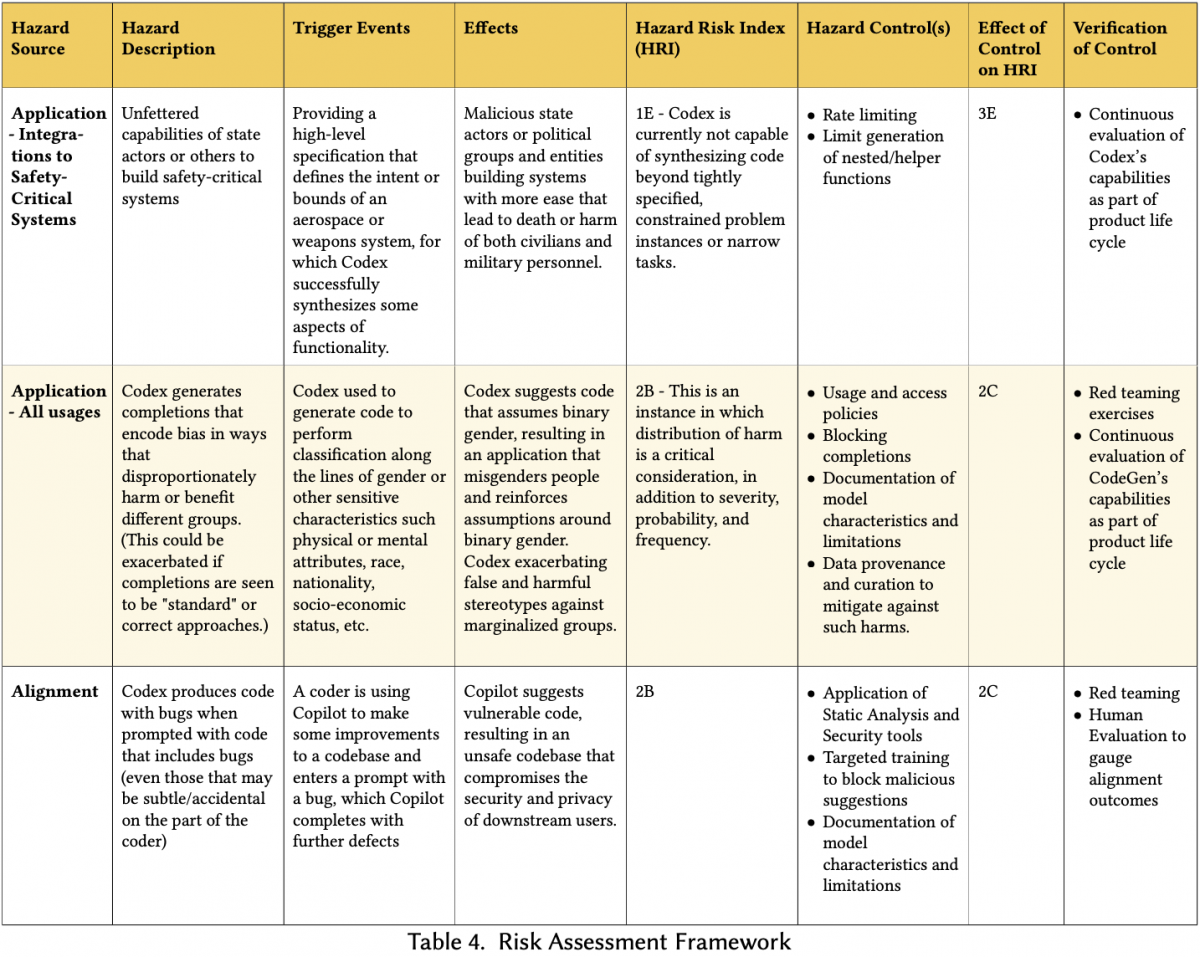

她引用 2022 年她与 OpenAI 研究人员合著的论文《A Hazard Analysis Framework for Code Synthesis Large Language Models》,标出军事用途可能造成风险并认为,“前后政策之间存在明显区别,前者明确规定禁止武器开发、军事和战争,后者则强调弹性和遵守法律”,她认为新政策似乎更强调合法性而非安全性。

“OpenAI删掉使用条款中禁止军事和战争用途的内容,是一个很大的变化,说明该公司新版使用条款关注的重点,是在确保法律合规之上提供更多的灵活性,但在很多国家,军事和战争都会被披上合法的外衣。” 海迪说道,“这对AI安全的影响可能非常大。考虑到大语言模型中已知的偏差和虚假生成现象,以及它们整体上的准确性不足,将它们应用于军事战争可能导致不准确和带有偏见的操作,从而增加伤害和平民伤亡的风险。”

其他专家亦对“拦截者”网站也表示,OpenAI的新使用条款反映出公司正在悄悄弱化其先前反对军事应用的立场。有专家还指出,OpenAI的重要合作伙伴微软公司就是美国军方主要的供应商之一。而且美军对于AI技术的需求也越来越强烈。

OpenAI的产品已经用于军方

“拦截者”网站还特别提到,虽然OpenAI公司的产品、模型和服务如今还没有被用于操控武器去杀人,但实际上其技术已经开始被军方用于编写代码、处理武器采购以及情报分析等方面。换言之,尽管没有被直接用于杀人,该公司的技术都已经在被用于协助这样的工作了。

“在人工智能系统正被用于针对加沙地区的平民时,OpenAI决定将禁止军事和战争用途文字从其使用条款中移除,是值得关注的”,一位专家对“拦截者”网站这样说道。