根据OpenAI的数据,自 2012年以来,最大规模的AI训练所使用的计算量以每年10倍的速度增长。以OpenAI的ChatGPT为例,2022年11月发布的GPT-3使用1750亿个参数构建,而2023年3月发布的GPT-4就使用了超过1.5万亿个参数。

Rambus接口IP产品管理和营销副总裁Joe Salvador认为AI训练数据集增长的原因来自以下三方面:AI模型日益复杂;大量在线数据被生成并用于训练;随着AI被应用于新的领域,人们对 AI准确性和稳健性的期望持续升高,当以上趋势转化为对内存的需求时,实际上就意味着更高的带宽和更高的容量,高带宽内存(HBM)在这样的背景下一跃成为当前半导体行业的“顶流”,AI训练硬件的首选,其实并不令人感到意外。

Rambus接口IP产品管理和营销副总裁Joe Salvator

HBM新的性能里程碑

众所周知,AI行业目前最常见的两大主流应用分别是AI训练和AI推理。对于AI训练来说,它需要建立一个模型,并提供大量数据,从而让它能够进行分析和掌握其中包含的信息;而AI推理则是通过已经训练好的AI模型去实时运行新的数据,做出相应的预测,并产生相应的结果。

显而易见,AI训练和AI推理分属不同的应用领域,它们对于处理器、内存等硬件的需求也不一样——AI训练需要大量优质数据和较长的计算周期,是HBM最常被使用的领域;而AI推理是速度更快、能效更高的应用,绝大部分情况下GDDR/LPDDR等内存类型就可满足。当然,在一些混合交叉使用的情况下,也有部分用户会在AI推理中使用HBM技术。

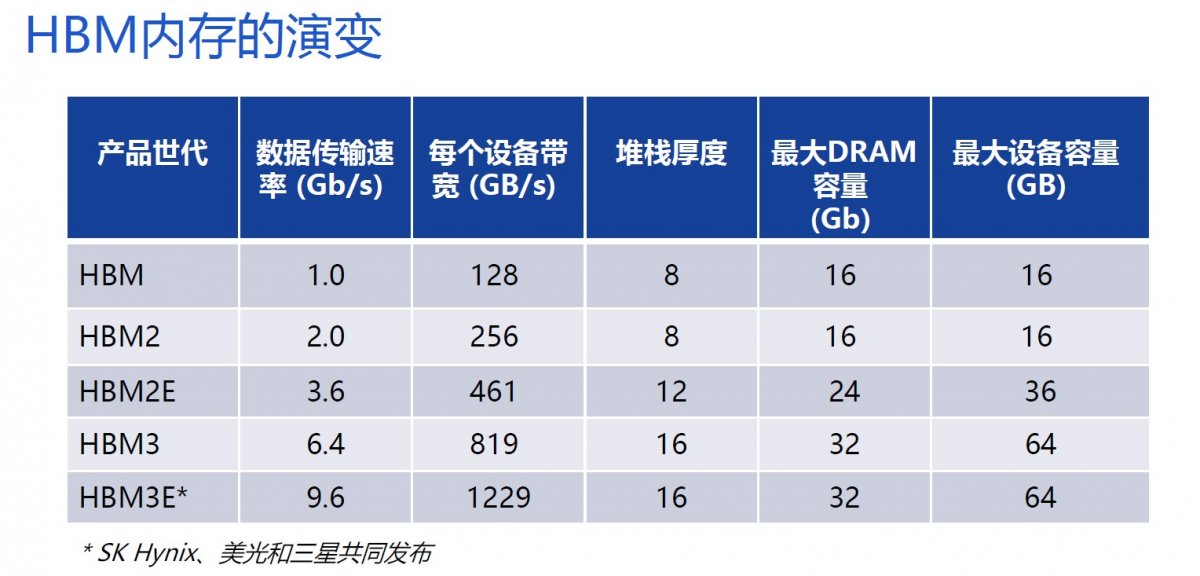

HBM技术于2013年推出,是一种高性能2.5D/3D堆栈DRAM构架,包含了中介层、处理器和内存堆栈,数据传输速率大概可以达到1Gbps左右。此后,该技术标准差不多每隔2-3年就会更新一代,使得此后每一代产品的带宽和最高数据传输速率记录被不断刷新。鉴于同期内其他产品的带宽仅增加两到三倍,我们有理由将HBM产品的快速发展归功于存储器制造商之间激烈的竞争。

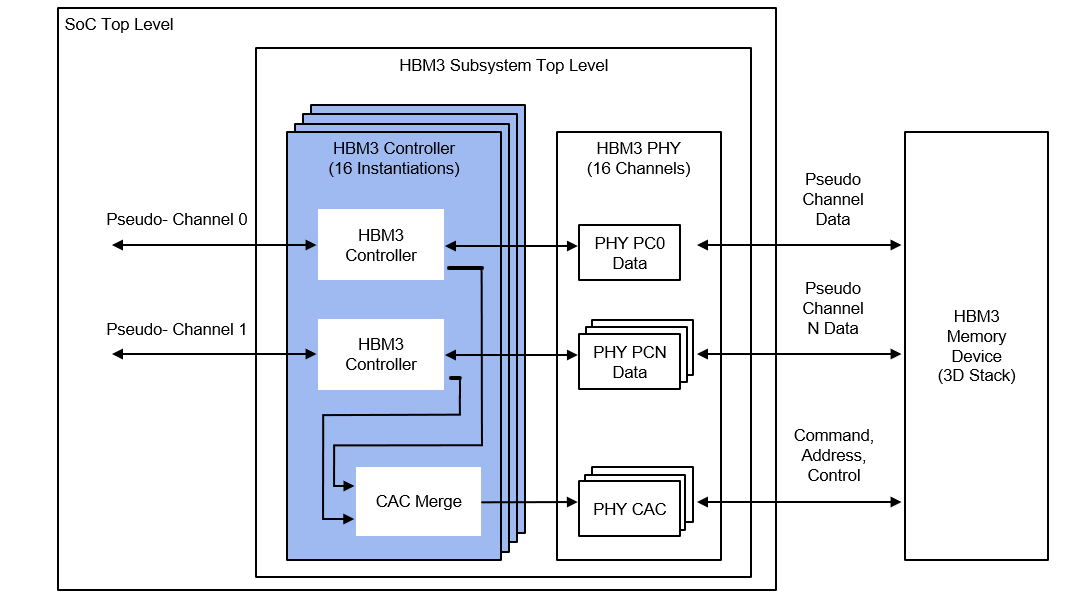

日前,为了增强AI/ML训练、生成式AI、以及其他要求苛刻的数据中心工作负载,Rambus最新推出了可提供高达9.6Gbps性能的HBM3内存控制器IP。相比HBM3 Gen1 6.4Gbps的数据速率,Rambus HBM3内存控制器的数据速率提高了50%,总内存吞吐量超过1.2TB/s。即便是面对当前主流的8.4Gbps传输速率,也是具备明显优势的。

Rambus HBM3控制器模块图

Rambus HBM3控制器不仅仅作为独立的产品推出,而是一整套完整的、经过验证的解决方案,能够跟SK海力士、美光、三星等比较常见的HBM3以及相关的内存模组进行匹配。此外,Rambus也与西门子旗下公司Avery 在验证IP方面展开合作,支持HBM3内存模块BFM(活动和监控模式)、主机内存控制器BFM和HBM3 PHY BFM等功能。

不过,需要指出的是,即便英伟达H200宣称已采用了HBM3E,几家主流内存厂商也都发布了HBM3E内存,但从标准规格的角度来说,目前所说的HBM3E还不是正式的行业标准,而是9.6Gbps的HBM3。至于后续HBM4的规格和标准,目前业界有许多预测,但都还处于研究阶段。

设计挑战犹存

HBM内存控制器的设计面临诸多挑战。首先是对于总体架构设计的复杂度和了解程度,毕竟要在高性能、低功耗和低成本之间找到平衡点,不是一件容易的事情。其次,要考虑与主流内存厂商产品组件、物理层的兼容性和性能验证,就必须共同构建相应的测试环境和验证环节,客户的子系统设计才更容易成功。同时,在架构设计时还要预留一定的自定义配置空间,允许客户根据不同需求来选择相应的控制器。

Salvador在接受本刊采访时指出,尽管不断演进的HBM技术对于数据通路的宽度基本上是相同的要求,但是其他方面还是有很多不同的需求,例如PHY对于制程工艺有明确的需求,而控制器则是可以支持多个不同的制程工艺。

而在谈及当前限制HBM发展的两大主要原因:一是中介层,二是2.5D/3D堆叠带来的复杂性和制造成本的增加话题时,他强调称,目前整个行业都在努力推动相关成本的下降,但比起成本下降的缓慢,我们更应该看到市场对于更加快速、更加高能效内存的需求永远得不到满足的现实状态,“很多应用场景所需要的内存带宽和吞吐量都是越快越好、越高越好”。

今年9月,Rambus将PHY IP业务出售给了Cadence公司,以便能够更加专注于芯片和数字IP业务。Salvador对此回应称,出售前Rambus的PHY业务发展的非常好,但控制器IP是提供给包括Cadence以及其他PHY IP合作伙伴的。当把PHY业务出售之后,就可以更好地与其他PHY合作伙伴合作,因为彼此间已经不构成直接的竞争关系。

“控制器IP可以跟客户所选择的PHY进行很好的结合,并且能够通过大量的测试和验证确保一次流片成功,这对于客户来说是很大的价值。”Salvador说HBM未来的应用领域将不限于在数据中心、高性能计算方面,比如现在已经有一些显卡在使用HBM内存,也有可能会进入汽车行业,尽管目前还没有看到哪家公司推出经过验证的车规级芯片使用HBM内存,但前景可期。