几十年来,真正身临其境的虚拟现实(VR)和增强现实(AR)的前景似乎都已非常接近,然而,随着每一项新技术的引入,似乎又都变得遥不可及了。如今的好消息是,它们距离人们的确越来越近了。然而,要想让AR和VR真正身临其境,人们所有的感官都必须确信这种体验是真实的。

创造可信的VR和AR体验,取决于工程师如何准确、一致地再现所有构成人们感知现实的元素,需要从理解人类生理学和神经科学开始。对于感知现实世界中的3D结构来说,至关重要的是人们必须首先了解多感官信号,然后再是利用耳机技术来进行模拟。

实现基于技术的现实

VR设备遮挡了用户的视觉,呈现了一个模拟环境——在该环境中,感官刺激提供了存在感和与虚拟对象的交互。AR设备将虚拟对象覆盖在物理环境上,感官提示提供了物理元素和增强元素之间的一致性。3D AR系统也被称为混合现实设备,它在虚拟环境中融合了真实世界的元素。

每种配置都有独特的要求,但推动这些系统向前进步的常见技术,包括实时3D传感和跟踪、强大算力且节能的计算处理、高保真图形渲染和显示、沉浸式音频、机器学习和人工智能算法、直观的人机界面和新颖的应用。

身临其境的视觉体验

通过创新的图形和显示技术,人们可以渲染逼真度更高的数字对象,并在更小的区域封装更多像素,且比以往任何时候都更清晰、更明亮。然而实际上,对于上述这些,还有更多的事情要做。其中不光是渲染逼真的图像,以及利用所需视觉提示的近眼显示。

如今的高分辨率智能手机显示器,每英寸显示500多个像素(PPI)。但对于身临其境的耳机视觉效果来说,利用PPI来度量已显不足,一个相关度更好的度量是,显示器显示视场的每度的像素(PPD)。

在中心视觉点上,典型的人眼具有大约1/60度的角分辨率。每只眼睛的水平视野约为160°,垂直视野约为175°。两只眼睛协同工作,在约120°宽和约135°高的FOV范围内实现立体深度感知。所有这些都意味着人们需要为每只眼睛提供大约100兆像素(MP),为立体视觉提供大约60MP,以提供60PPD的视觉。然而,当今最先进的主流VR头戴式耳机显示器大约才达到3.5MP。

由于目前的制造技术,还不支持这种像素密度,设计师必须在理解人类视觉系统如何工作的基础上,在高分辨率渲染视觉场景的凸显部分做出权衡。

眼睛跟踪和注视点渲染

人类高视力敏度仅限于非常小的视场,该视觉场为以中央凹为中心、围绕眼睛光轴约±1°的范围。这意味着视觉中心最清晰,边缘趋模糊。使用实时传感器来跟踪用户的注视区域,人们可以在中心注视区域渲染更多数量的多边形,将计算能力集中在那里,并在其他地方以指数级降低图形保真度(多边形密度)。这种强化中央渲染的处理方式,可以显著减少图形工作负荷和相关的功耗。

图1:人眼的中央凹上有高密度的视锥感光体,从而导致中央视觉的视力敏度高,而周边的光受体密度显著下降,导致视力下降。(资料来源:E.Bruce Goldstein《感觉与感知》)

世界各地的研究人员正在对此进行研究,设计师正在探索多显示器配置,其中高分辨率显示器覆盖中央凹视觉,像素数相对较低的显示器覆盖周边视觉。未来的显示架构,将能够在注视方向上及其周围,动态地实时投影更高分辨率的视觉内容。

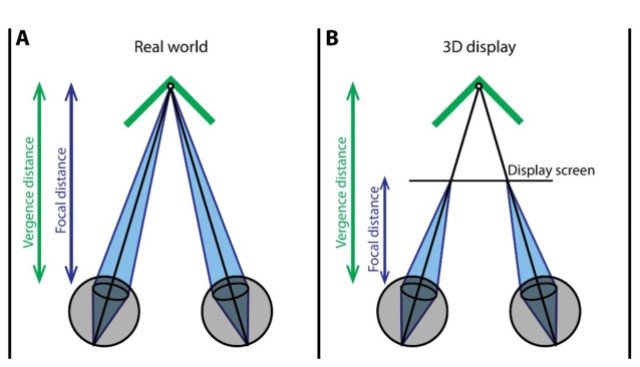

调节和会聚失配

另一个关键问题是确保动眼神经线索的一致性,以纠正眼睛调节和会聚错配。人类用两只眼睛聚焦在一个物体上,立体地看待世界。通过调节,每只眼睛的晶状体都会改变形状,以聚焦来自不同深度的光线。两只眼睛会聚的距离与每只眼睛所适应的距离相同。

如今的商用VR和AR耳机中,汇聚距离和调和距离之间存在不匹配。现实世界中的光,是通过来自各种不同距离光源的反射和折射来调适的。而在头戴式耳机中,所有的光都是通过同一距离的光源产生的。此时,当眼睛会聚以观看虚拟物体时,其透镜形状必须不断调整,以聚焦从显示器发出的固定距离光,从而导致不同程度的距离失配,这通常会导致眼睛疲劳或定向问题。

图2:3D显示器的会聚调节失配。(来源:Martin Banks)

为解决这一问题,人们正在探索各种方法,例如动态可移动光学器件和焦点可调液晶透镜,其焦距可以随着电压的调整而改变。

3D空间音频

对于真正的沉浸感,AR/VR音频体验必须与视觉体验相对应并协调,以便所感觉的声音位置与用户所看到的目标完全一致。在现实世界中,大多数人即使闭上眼睛,都能感知到声音的大致位置。这是因为大脑能够对声音的“到达时间”和强度进行感知和分析。这在现实世界中是自动即时发生的,然而在VR耳机中,必须对3D空间音频进行编程和处理。

挑战在于,每个人对声音信号的体验是不同的,信号频谱会根据头部和耳朵的大小、形状以及受众等因素而变化。这个被称为与头部相关的传递函数,如今的许多技术,都在致力于对其实现尽可能逼近的近似。另外,正在进行的个性化功能研究,也将使耳机用户能够以正确的空间线索来感知虚拟物体发出的声音。

低延迟由内而外跟踪

在VR/AR中,实时跟踪用户的头部运动显然是必要的。无论何时,在3D空间内,系统都必须能够确定头戴式耳机相对于其他物体的位置,并同时确保高精度和低延迟,以便根据用户的头部位置及方向来渲染和呈现相应的视觉和听觉信息,另外,在用户移动时还要快速更新。

直到不久前,VR耳机还通过“内外”跟踪方法,利用用户放置在环境周围的外部传感器来跟踪人类头部运动。而如今,基于计算机视觉和微调运动传感器的有机结合,“由内而外”的跟踪提供了模拟定位、映射技术、以及视觉惯性测距,从而实现了头戴式耳机内的运动跟踪。

图3:通过“由内而外”的跟踪,现代耳机可以利用内置传感器实现用户动作的实时精确跟踪。(来源:Meta)

然而,一个持续的挑战是,如何实现更低的动作到光子延迟,即从目标动作开始到从显示器中相应图像帧的最后一个像素发射光子之间的延迟。换句话说,它是传感器数据采集、处理、接口传输、图形计算、图像渲染和显示更新所花费的总时间。

通常在现实世界中,根据视觉确定的视野变化以及前庭感觉系统检测到的运动信息,来跟踪人们的头部运动。如果VR耳机的延迟时间过长,会导致视觉前庭不匹配,从而导致定向问题和头晕。目前系统实现的动作到光子延迟通常为20~40ms,但感知无缝体验要求该延迟小于10ms。

人类导入和交互

身临其境的体验还要求用户能够与虚拟对象进行逼真的交互。人们必须能够伸手抓住物体,并且物体必须按照物理定律实时做出反应。

如今最先进的耳机,让用户可以用基本的手势选择物体,随着计算机视觉技术的不断进步,还有人工智能的快速进步,未来的耳机将包括更丰富的手势控制功能。

下一代设备还将提供多模式交互及眼动追踪技术,将允许用户通过将视线集中在虚拟物体上来进行选择,然后用手势进行激活或操控。很快,随着人工智能技术的不断发展,本地低延迟处理将成为现实,耳机也将具有实时语音识别功能。

图4:计算机视觉和人工智能技术的进步,使用户能够通过手势、眼神和语音命令进行自然的交互。(资料来源:David Cardinal)

展望未来

如今,人们可以体验一些主流的VR和有前景的工业AR,但它们并非完全沉浸式的。虽然这条路并不直接,但随着数十亿美元的相关技术投资,其潜力几乎是无限的。例如,麦肯锡估计,到2030年,元宇宙可能产生4万亿至5万亿美元的收入。

通过不断突破技术障碍,人们将能够再现逼真的体验,最终能够从根本上缩小人们在真实世界和虚拟世界体验之间的差异。

(参考原文:how-can-we-get-to-truly-immersive-vr-and-ar)

本文为《电子工程专辑》2023年9月刊杂志文章,版权所有,禁止转载。点击申请免费杂志订阅