当前,AI大模型带来的庞大算力需求,正导致GPU处理器“一芯难求”。近日,据英国《金融时报》援引两位与英伟达关系密切的未具名人士报道称,百度、字节跳动、腾讯和阿里巴巴向英伟达下单订购50亿美元的芯片。

其中,今年英伟达将合计发货约10万块A800芯片,价值10亿美元,另外价值40亿美元的芯片都将2024年交付。不过,对以上消息,英伟达和上述四家国内企业都未予置评。

AI算力需求旺盛

GPU因具备图形渲染和海量数据的并行运算等优势,能够快速准确地处理大量数据,市场价值逐渐凸显,广泛应用于人工智能、图像渲染、科学计算等领域。其中,AI、自动驾驶与游戏市场是GPU需求增长的主要场景。

2022年底,ChatGPT问世后,迅速在全世界掀起了AI风潮。而一直押注AI未来的英伟达,成为AI大模型风潮中收益最大的企业,其市值已高达万亿美元市值。

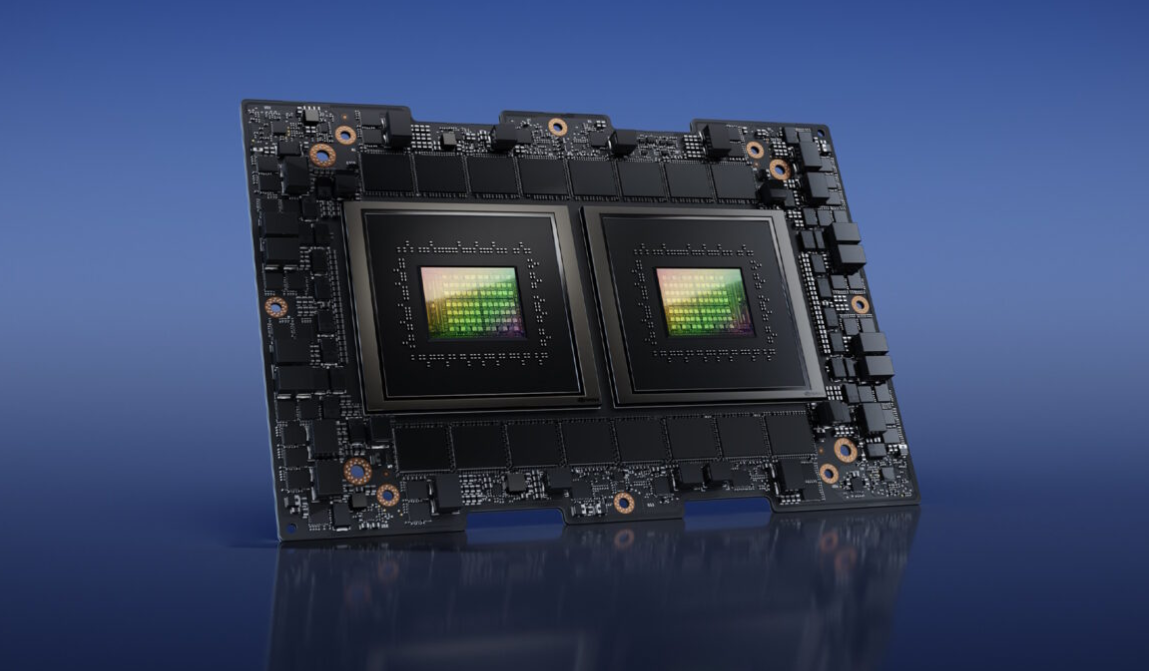

图源:英伟达官网

今年3月,英伟达在GTC 大会上重磅发布了H100 NVLINK芯片,其是专门为大语言模型(LLM)设计的GPU,采用了Transformer加速解决方案,可用于处理ChatGPT。相较于英伟达的HGX A100 GPU芯片,一台搭载四对H100 和双GPU NVLINK 的服务器速度还要快上10倍,可以将LLM 的处理成本降低一个数量级。

目前,英伟达在高性能GPU方面的技术领先地位,旗下A100和H100两款AI芯片是ChatGPT这样的大语言模型的核心动力。有云计算专业人士介绍,1万颗英伟达A100芯片是一个好的AI模型的算力门槛。而微软为OpenAI构建的用于训练其模型的AI超级计算机就配备了1万颗英伟达的GPU芯片。

近日,英伟达又推出下一代版本的GH200 Grace Hopper超级芯片。该芯片将成为世界上第一个配备HBM3e(High Bandwidth Memory 3e)内存的GPU芯片。与当前一代产品相比,最新版本的GH200超级芯片内存容量增加了3.5倍,带宽增加了3倍;相比最热门的H100芯片,其内存增加1.7倍,传输频宽增加1.5倍。

据GlobalMarketInsights数据,全球GPU市场预计将以CAGR25.9%持续增长,至2030年达到4000亿美元规模。其中AI领域大语言模型的持续推出以及参数量的不断增长有望驱动模型训练端、推理端GPU需求快速增长。

英伟达在一份声明中表示:“消费互联网公司和云供应商每年在数据中心组件上投资数十亿美元,通常会提前几个月下订单。” 英伟达CFO克雷斯也表示,目前AI 算力市场的需求已经超出了公司对未来数个季度的预期,订单已经多到做不过来。

GPU价格一涨再涨

2022年,美国加大了AI芯片对华出口限制。为了规避该政策的限制,英伟达向中国市场专供A800处理器,以取代A100 GPU。不过,在AI大模型算力需求的驱动下,即使性能被限制的“专供版”GPU也是供不应求。

过去几个月,在AI大模型算力需求的带动下,英伟达旗下A100、H100、A800和H800等高性能GPU芯片价格不断上涨。特别是旗舰级芯片H100,4月中旬在海外电商平台就已炒到超4万美元,甚至有卖家标价6.5万美元。同时,英伟达的中国特供版A800和H800芯片也遭到了哄抢。

值得一提的是,此前多家媒体报道,美国政府正酝酿实行新的芯片出口限制,主要涉及英伟达对中国出口的AI芯片。尽管新的限制政策一直未落地,但市场早已“风声鹤唳”,GPU的价格一涨再涨。

7月上旬,据澎湃新闻报道,英伟达在中国一家代理商表示,现在英伟达A800芯片一天一个价,如果购买量多的话可以10多万元/片,少的话没有11万元/片拿不到,“考虑到禁售传闻,大家都比较惜售,一个多礼拜以来涨幅达20%到30%。

7月末,腾讯科技的报道也提到英伟达芯片被哄抢,称在芯片分销圈,英伟达的中国特供版A800和 H800售价从原来的12万元人民币左右,变成了现在的25万甚至30万元,甚至有高达50万元一块。

今年6月,就有媒体称,字节跳动今年向英伟达订购了超过10亿美元的GPU,字节到货和没到货的A100与H800总计10万块,仅字节一家公司今年的订单可能已接近英伟达去年在中国销售的商用GPU总和。有知情人士透露,字节跳动已储备了至少10000张英伟达GPU。字节跳动还订购了近70000张A800芯片,将于明年交付,价值约7亿美元。

英伟达的财务总监在6月份表示,对AI芯片出口到中国的限制“将导致美国产业永久性地失去机会”,并且该公司预计短期内不会受到实质性影响。

目前来看,英伟达订单能见度已至2024年,高端芯片非常紧缺。以现在的排产进度,就连A800/H800都要到今年底或明年才能交货。