最近Meta面临新一波裁员,有人评价在这波行情下Meta押错了宝,几乎All In到了元宇宙方向上,错过了ChatGPT造成的AI风潮。这话当然有问题,比如说元宇宙和AI并不是互斥的关系,而是相互渗透、相互交叉的;不过现下的这两大热点,元宇宙真有被AI全面盖过风头的意思。

上周的英伟达GTC开发者大会,黄仁勋的主题演讲切分成两个大的主题:AI和Omniverse。后者可说是前两年GTC主题演讲的大热门了,但今年的GTC主题演讲总时长1小时20分钟,前58分钟都在讲AI:这偏心程度还是有那么点的。不止如此,这届GTC规划中有关生成式AI话题的talk,超过了70场;黄仁勋自己还特别和OpenAI联合创始人兼首席科学家Ilya Sutskever进行了一场有关AI现状与未来的对话。

我们特别统计了黄仁勋主题演讲和媒体采访活动中,他提到“Generative AI(生成式AI)”和“Omniverse(英伟达版本的元宇宙)”这两个词的次数。主题演讲里,黄仁勋提“生成式AI”共48次,“Omniverse”共59次——看来后者份量还是挺大的;不过在面向APAC区的媒体采访活动上,黄仁勋提到“生成式AI”23次,“Omniverse”则为10次——可见媒体现阶段普遍还是更关注AI的。

其实ChatGPT现在这么热,今年GTC围绕这东西展开是必然的。当然也不光是ChatGPT,以ChatGPT为代表的,包括Stable Diffusion、DALL-E、Midjourney等都在这其中,都属于生成式AI(Generative AI)。

所谓的生成式AI,可以简单理解为某一种AI系统,它能够根据用户的输入、提示,来自行生成文字、图像、3D图形等内容。ChatGPT是生成文字,Midjourney则是生成图像...

前不久还在跟周围的朋友闲聊,说Midjourney这类生成式AI的存在,让不少插画师和美术相关工作者面临失业危机;或者说生成式AI让大量内容创作者,无论是文字还是多媒体工作者都感到了前所未有的压力。其实不用感觉有压力,因为远不止是内容创作,今年GTC上,黄仁勋还特别谈到生物学也进入到了生成式AI时代,强力介入到药物发现流程的每个步骤中......

这还只是个开始,生成式AI进入各行各业都是迟早的事。媒体对于这次GTC渲染比较多的是黄仁勋所说AI进入了所谓的“iPhone时刻”。所以不必恐慌,反正失业也不只你我。

那么本文就来谈谈以ChatGPT为代表的生成式AI,以及在以英伟达为代表的AI芯片公司眼里,乃至整个电子产业,生成式AI究竟意味着什么。

AI第3篇章,和AI的iPhone时刻

答记者问阶段,我们感觉黄仁勋说的两段话是高度概括了AI在现如今人类社会所处地位的。其一是当前AI翻开的Chapter 3(第3篇章);其二就是AI的“iPhone时刻”。

“AI爆发的确有多个阶段。大约10-12年之前,深度学习改变了计算方式。深度学习和机器学习革新了软件的开发和部署方式。”黄仁勋说,“这个阶段的计算机和过去发生了完全的变化。”“第一阶段是构建AI基础设施。”

“第二阶段,AI的第2篇章则是AI学习感知。在我们做出某个预测或者执行某事之前,我们需要理解周围的环境。就像人类的感官包括了眼睛、耳朵、触觉等等,过去10年,我们开发了具备感知能力的计算机。”“包括用于自动驾驶汽车的计算机视觉、自动化机器人的计算机视觉、自动结算系统的计算机视觉等等。”

“但AI的巨大突破,并不只在于感知能力。我们人类对社会产生价值的根本,在于我们会生产信息。我们创作故事、创作音乐、创作电影、做设计、做策略,做各种各样的事。”黄仁勋表示,“现如今是生成式AI的时代。在AI的第3篇章中,AI能够成为我们的联合创作者、副驾驶(co-pilot)、合作生产者。”

“不管是帮我们完成创作草稿,还是激发灵感的初步设计。”事实上,现阶段我们身边就已经有不少人开始用ChatGPT、novelAI来做创作的助力了,更不用谈微软Office co-pilot的问世原本就是办公生产力的AI助手。抛开失业危机不谈,对于某些内容创作者来说,尚未全面商用的生成式AI的确暂时减轻了工作负载。

“在过去6个月里,我们已经体验到了co-pilot提升了生产力——提升幅度达到了2倍。”“如果软件工程师的生产力也能提升2倍,自然也就创造了难以估量的价值。”用黄仁勋的话来说,过去的30-40年,知道如何编程的人毕竟还是少数,“了解如何用计算机来惠及自身、业务或者整个国家的人真的不多”,而这个时代AI“新型计算机”的诞生,“你不需要去学C、C++、Pascal、Fortran,甚至连Python都不用学,只需要用你自己的语言和计算机沟通,告诉它你需要什么,你要解决什么问题,计算机就会自己去写软件。”

换句话说,在生成式AI时代,“每个人都是程序员”。“我相信这会推动社会各个行业的发展(lift so many segments of society)。”

而所谓“AI的iPhone时刻”讲述的又是另一个故事。所谓的“iPhone时刻”,说的是AI作为一个“平台”的价值——或者从英伟达的角度,其实是要宣导他们的AI计算机DGX上云,让AI进一步成为普适的平台。后文会提到英伟达对应的新品发布,就“iPhone时刻”的理念层面,“就像PC以前也曾是新的计算平台,后来互联网、云成为新的计算平台。”

“将某个东西称作新的计算平台是因为出现了新的应用,可用于解决新的问题;而且出现了新的初创公司去开发应用。”黄仁勋说,“就像iPhone为代表的移动设备,出现了数百万应用——这在过去的PC平台是做不到的,移动云的属性决定了会有海量的人加入到计算生态系统中,将计算融入工作、创造新事物。”

“LLM和生成式AI也是如此。这是个新的计算模型。将来(这个平台上)会出现新的应用,(这个领域)会出现新的公司。”这是黄仁勋将AI现如今所处阶段称作“iPhone时刻”的原因,“将来会有很多很多的应用,而且新的应用会是现在我们都想象不到的。所以这绝对会是个新的计算平台,”...“定义新时代的计算,超越PC、互联网和移动云。”

再把注意力放到inference,和AI上云

用流行的话来说,这些要表达的都是AI到达了“拐点”。回到英伟达的产品上,黄仁勋在主题演讲中说当年自己将全球首台DGX交给了OpenAI——对AI芯片和系统关注的同学应该知道,DGX作为英伟达的AI计算机,是其他不同AI芯片厂商发布产品时,进行系统对比的常客——就像手机厂商发布新品都要对比iPhone一样。很容易想见,生成式AI的这波热潮下,英伟达是绝对的背后赢家。

老黄在主题演讲中说,现在DGX AI超级计算机的市场出现了大幅增长。“原本DGX AI超级计算机是仅用于AI研究的设备,而现在扩展到了数据提炼和AI处理7x24小时的工作。”不管增长的是不是DGX,起码以GPU为代表的AI芯片及其系统,其发展速度就近两年是有目共睹的。

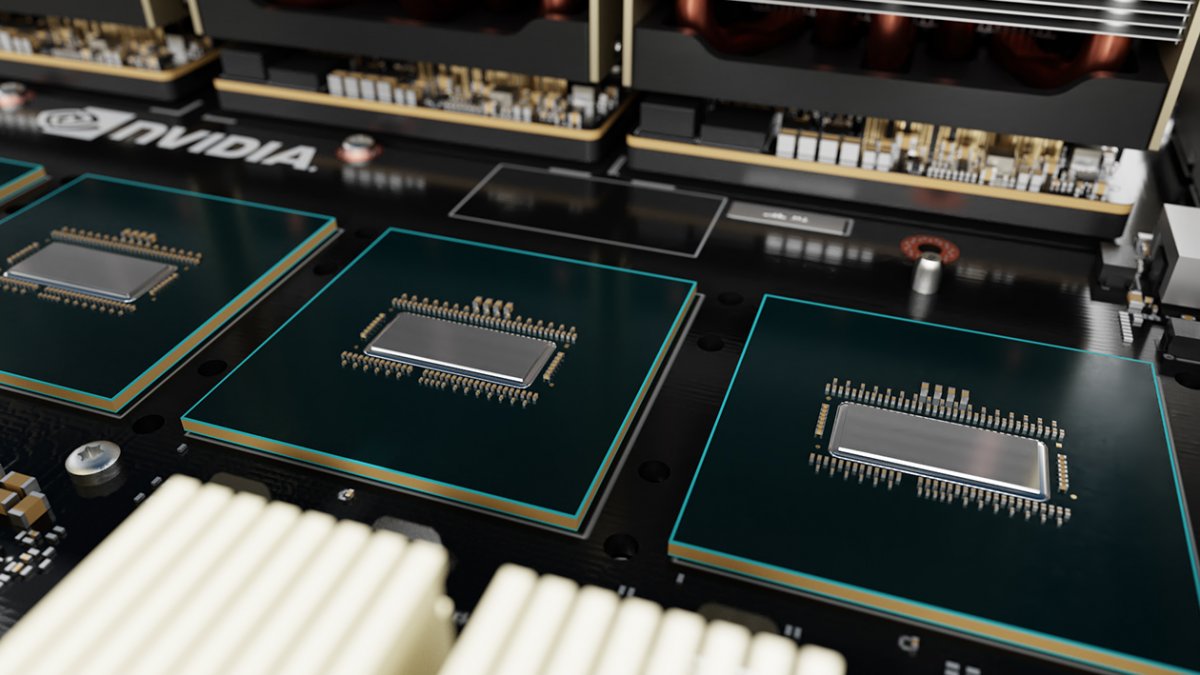

此前英伟达Hopper架构介绍的文章里,我们就提到过,英伟达最新一代的Hopper架构GPU特别加入了Transformer Engine——专为Transformer深度学习模型准备的。Transformer是2017年Google Brain公开的。其训练的并行化特性,令其适用于更大型数据集的训练;随后就诞生了预训练系统,包括BERT、GPT。

此前英伟达Hopper架构介绍的文章里,我们就提到过,英伟达最新一代的Hopper架构GPU特别加入了Transformer Engine——专为Transformer深度学习模型准备的。Transformer是2017年Google Brain公开的。其训练的并行化特性,令其适用于更大型数据集的训练;随后就诞生了预训练系统,包括BERT、GPT。

显然Hopper在这一局的下注还真是万般准确,ChatGPT后面的GPT,就是指Generative Pre-trained Transformers。“我想,未来我们会看到一个行业接着一个行业,都会开始采用LLM(大型语言模型)。”黄仁勋在答记者问时说,“Transformer Engine就是用来理解LLM的。”这也是在AI基础设施层面经营多年后达成的某种成就。

答记者问阶段,黄仁勋被问到最多的一个问题就是ChatGPT这个风口下,英伟达是如何应对这波市场机遇,如何处理未来可能存在的算力不足的。黄仁勋对此有一段总结,也是这次GTC相关于Nvidia AI部分的产品发布:

“英伟达对此有几个方向的准备:首先是打造AI计算机、构建算法、软件;其次是把这一切都放到云上——和包括阿里巴巴、腾讯、百度、微软Azure、GCP、亚马逊等云服务提供商合作伙伴合作,把英伟达的AI超级计算机放到云上。”

“第三,生成式AI的市场需求在增长,training(训练)和inference(推理)皆如此。”“我们会尽力去满足客户的需求,我们也有能力在芯片、存储与封装、系统等各个层面提供足够的供货。”看样子生意的确是相当红火。

按照这三则指引来看GTC有关AI的新品发布,的确也有利于我们观察AI未来的部署方式。

首先是AI基础设施。包括AI计算机、算法、软件。先来谈谈AI计算机新品:一般我们说英伟达在AI的training领域是制霸市场的。最新基于Hopper架构的DGX H100,就是这一市场的新布局,而且DGX H100也已经在全面量产。有关主要用于训练的DGX H100计算机,这次英伟达主要是宣布了,微软Azure基于此开启private preview;另外包括Atos、AWS、Google Cloud、HPE、技嘉、联想、甲骨文等在内的系统和云服务都将相继有对应的产品推出。

有关AI硬件的发布,真正的重头戏在inference部分。英伟达认为,生成式AI狂潮,驱动了inference市场的新机遇。这一点也很容易理解,以ChatGPT为代表的生成式AI应用,在几个月的时间内就狂揽上亿用户,这是过去的短视频、即时通讯、社交网络应用都没能达成的。而用户量的飙升,就意味着算力需求和硬件资源的苛求——这里的硬件资源,就用户使用层面就是inference:每次你向ChatGPT发出一词对话请求,都是一次inference操作。

Adobe在产品中加入的生成式AI特性、微软Office的co-pilot、Teams很快也会接入生成式AI,海量请求都是AI inference。

这其实也是英伟达渴望迅速占领这部分市场的关键,因为inference市场不像training市场那样集中,其他AI芯片企业都还有更大的竞争余地。

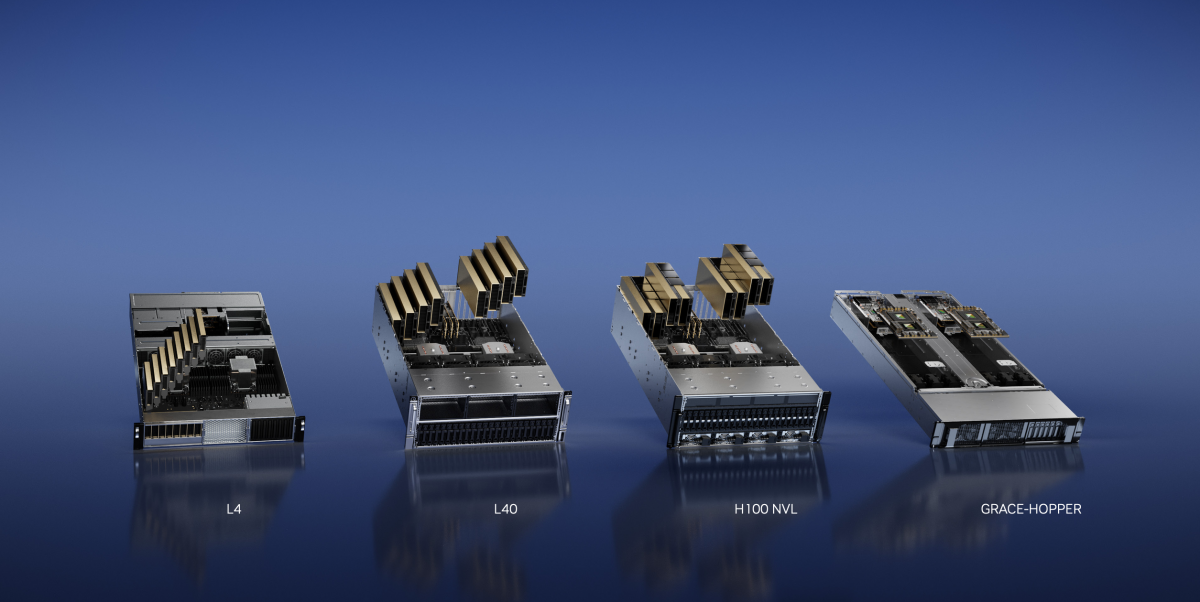

上面这张图展示的4款产品,就是新架构的AI inference系统产品布局。最左边的L4 GPU新品,应用主要涵盖视频、图形、AI,尤其面向“AI视频负载”的,针对视频编解码、视频通话的背景替换、光照、眼神接触、自动字幕生成、实时翻译等准备。

英伟达宣传中说,L4的AI视频性能相比于传统CPU服务器有120倍的领先,能耗还低了99%;相比于更老的T4,图形性能领先4倍;当然要特别提到生成式AI支持,2.7倍性能提升。图片中展示的L4服务器总共是8张显卡。先期采用L4的客户包括有Snap、Google Cloud。前者会将L4用于AV1视频处理、生成式AI和AR应用;而谷歌则是将L4用于GCP。

上图中的第二款产品是L40,去年9月份英伟达发布的产品。当时主要是面向Omniverse发布的新GPU。这次黄仁勋强调,L40在包括text-to-image(文字转图像)、text-to-video(文字转视频)这类生成式AI上的优势;主打图像生成。

第三款H100 NVL也是这次发布的新品。从英伟达的定位来看,H100 NVL就是专门针对实时的LLM inference所做的。具体是把两张H100卡合到一起,用NVLink桥接——因为GPT模型对存储和计算都很看重,所以H100 NVL达成了188GB HBM3内存,在千亿级别参数的GPT3模型上,吞吐较上代HGX A100提升12倍。

最右边的Grace-Hopper就不用多谈了,此前发布的明星产品,是将Grace CPU和Hopper GPU进行高速连接,主要是用于处理超大型数据集的诸如推荐系统和LLM。

黄仁勋说:“AI inference负载类型是多种多样的“,而这个“平台是1个架构、软件全兼容,对于视频、图形与图像、LLM、推荐系统等等实现了全面的布局。”

从英伟达这次这么积极的inference系列产品发布来看,这片市场应当也会是AI芯片企业未来竞争的焦点。

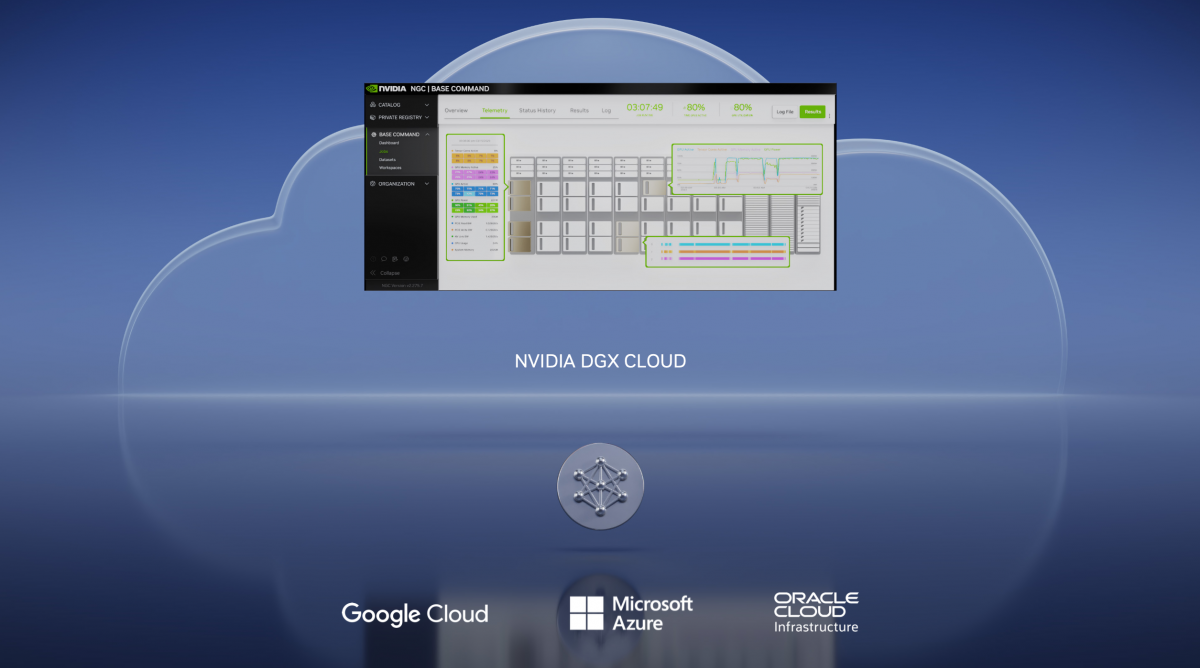

回到黄仁勋总结这次的AI新品发布,另一个重点就是“把英伟达的AI超级计算机放到云上”。其实过去这两年,英伟达上云的“大件”不少,比如Omniverse上云。对于英伟达这种搭建平台和基础设施的企业而言,上云的最大价值,莫过于让产品覆盖到更多的人,毕竟像Omniverse这样的元宇宙,要由企业自己来搭建,IT的问题就一大堆。

这次发布的DGX Cloud也是类似的道理,让Nvidia AI的覆盖面进一步拓宽。DGX Cloud的搭建,主要还是和微软Azure、谷歌GCP、甲骨文OCI之类的云服务供应商合作。据说此后要用DGX AI计算机,用浏览器访问就行了。用他们的行话来讲叫Training-as-a-Service,或者Model Making-as-a-Service。

当然,也不光是计算机硬件上云。Nvidia AI全栈,包括各种加速库之类的东西应该都会配套地上云,主要面向的估计还是企业用户,也就是跑Nvidia AI Enterprise。

从认出猫,到自己画猫

再回顾一下黄仁勋提到的本次GTC的AI新品发布总结,“英伟达对此有几个方向的准备:首先是打造AI计算机、构建算法、软件”——不光是AI计算机,还在于AI相关的软件、模型。这也属于AI基础设施。

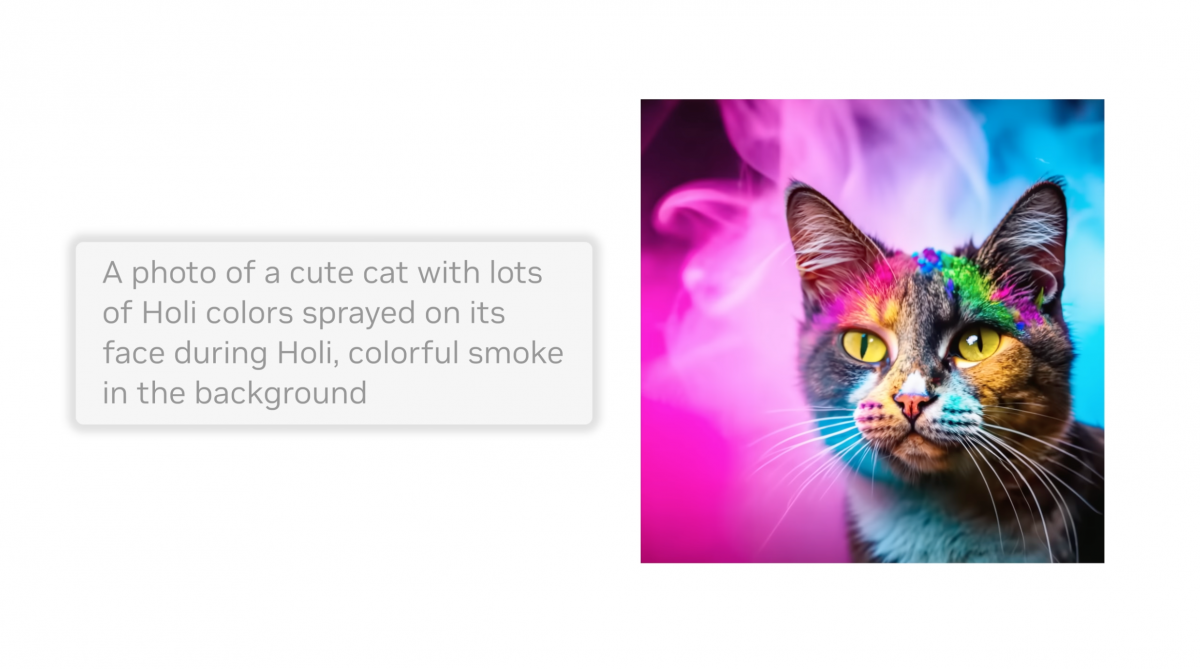

“Diffusion模型,在无监督的情况下就能生成图像。”黄仁勋谈到,“才10+年的时间,(AI)就已经从尝试能识别出一只猫,到生成穿着宇航服、漫步在月球上的猫的照片了。”下面这张图则在输入的文字中指明了背景要有彩色烟雾,猫猫则在印度人的Holi节上,脸染上了各种色彩...

这说的就是生成式AI。在Midjourney、文言一心这类服务中,的确也就一句话输入的事,就能搞定特定场景下的画面生成。最近我们还尝试让Midjourney去生成几张星巴克咖啡的渲染图,周围的摄影师、设计师看到输出都大为震惊,甚至认为这些生成的图已经可以作为广告宣传图发布了。

其实协助设计和创作的生成式AI种类并不止于此,比如说Debuild可以设计部署web应用;Grammarly这个比较知名的英语写作工具好似也增加了AI属性;Tabnine则是切实地用来写代码的;还有前文就提到的医疗方面的药物发现与设计等等。

不过对于不同的企业而言,真正要让生成式AI发光发热,是需要所谓的guardrail的。这一点在此前的GTC上,英伟达就有特别提到过。即AI要在不同的细分领域起作用,那么就需要限定或强化它在某个特定领域的认知。因为像ChatGPT这样的应用,面向大众时整体还是太泛了。比如零售AI机器人,就不能像ChatGPT那样去回答顾客的问题。

很多企业还是需要去打造自己的定制化AI模型的,包括用自己独有的数据去做训练,最终起到AI在限定细分领域更具深度,或做更有针对性的的模型,有时也可能关乎到企业的安全、隐私等需求。

所以“行业需要一个foundry,需要一个定制化LLM模型的台积电”——这好像是英伟达对于自己在AI行业的另一重定位,即LLM的foundry代工厂,感觉还是挺形象的。针对这一部分,英伟达在GTC上发布了AI Foundations——这本身是个云服务,可用来构建、提炼、运作定制化的LLM和生成式AI,最终完成特定领域的工作。

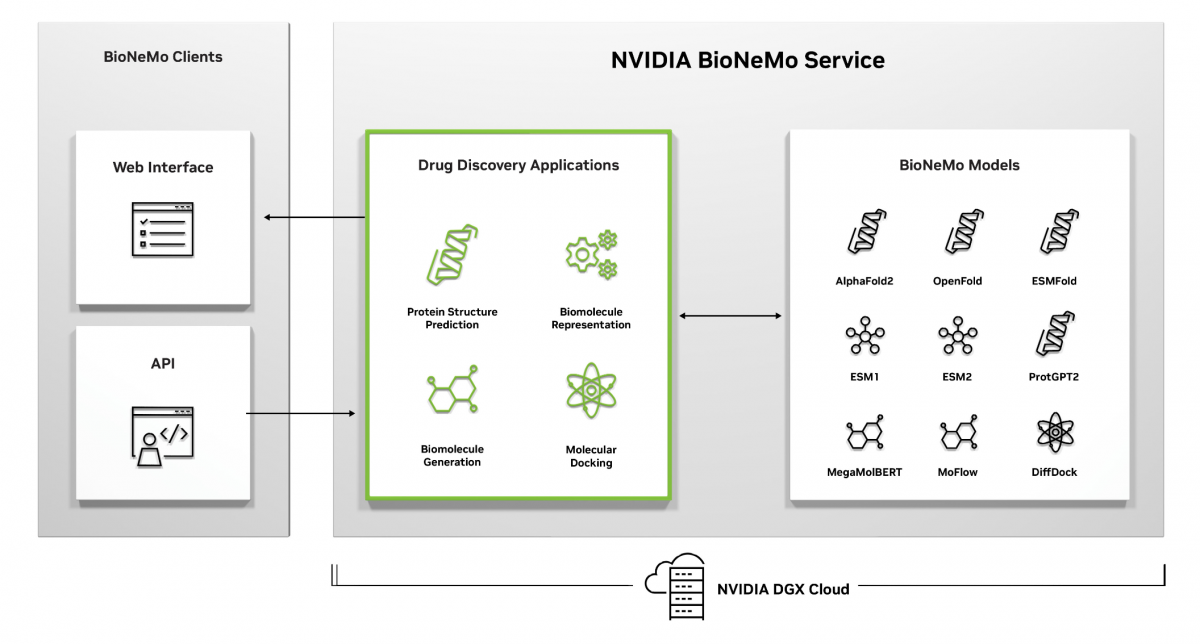

AI Foundation目前涵盖语言、视觉、生物模型构建服务,包含上图给出的三个板块Nemo、Picasso、BioNemo。

Nemo是用来构建text-to-text生成式模型的:可以用自己的模型,或者用英伟达的预训练语言模型。这东西最终形成的应该就是针对某个特定领域的定制版ChatGPT。具体的特性和实现这里就不列举了。

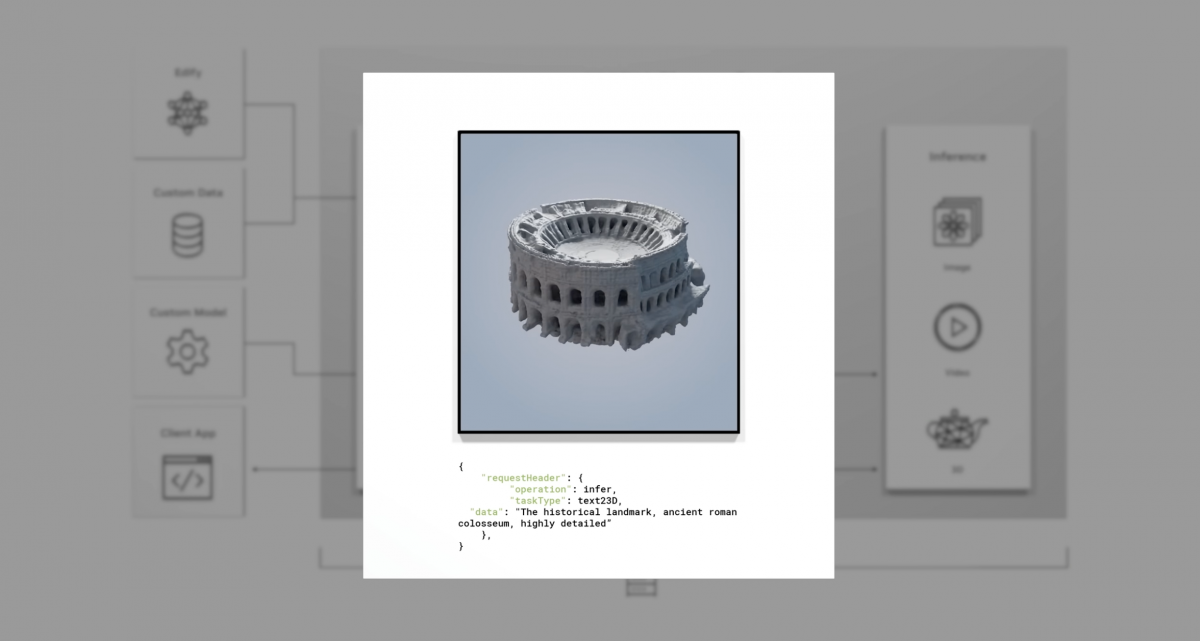

其次是Picasso,这是个text-to-image、text-to-video和text-to-3D服务,就是文字转各种多媒体。在搞定定制模型之后,应用基于文字输入、metadata,向Picasso发出API调用;Picasso就用对应的模型,跑在DGX Cloud上面,发回给应用。这个inference过程和用法,和Midjourney Bot之类的都是类似的。

值得一提的是,Picasso也支持文字转3D模型。从英伟达的演示来看,得到的3D几何体可以很细节化。而这个3D模型是基于USD格式表达的——对Omniverse了解的同学应该知道,Omniverse的3D图形表达都是基于USD格式——这一点,我们在过去介绍Omniverse的文章里都有反复提及。

所以得到的3D资源也就和Omniverse达成了互通,换句话说基于Picasso,随便输入两行文字,得到3D模型,立刻就能用在Omniverse里面,不管是用于数字孪生,还是3D协同设计。这也算是Omniverse生态的强有力补充吧。正应了黄仁勋所说的,生成AI时代,人人都是艺术家。

gettyimages、shutterstock、Adobe都已经宣布了采用Picasso服务。比如gettyimages这种图片视频素材大户,他们的客户就能用生成式AI自己去构建自己想要的图片和视频。据说这也是保障图片和摄影原作者利益、保持其创作热情的方法。而和shutterstock的合作就是3D生成模型相关的了。

最重要的应该是Adobe和英伟达之间的合作——因为这其实是把Picasso引入到Adobe的创作工具中,听起来和微软Office引入co-pilot是类似的事情,只不过后者主要是文字内容创作,前者是图像、图形和视频创作。不知道最后出来的成品会是什么样,是不是以后用Photoshop,也是输入几行文字就让它抠个图、给个背景之类的;另外面向用户的收费模式也暂不得而知。

除了Nemo和Picasso之外,AI Foundation还有项服务就是BioNemo。这是个AI药物发现服务,主要应该是为近些年涌现的此类初创企业准备的,帮助研究人员用自己的专有数据做模型精细调整和定制化。从介绍来看,药物发现是分成了好几个关键阶段的,英伟达说生成式AI现如今深入到了每一个阶段中。

比如说生成式模型能够在几秒的时间内,就看完蛋白质氨基酸序列(proteins amino acid sequence),准确预测靶蛋白——虽然这段话我们也并不明确知道是什么意思...

值得一提的是,无论Nemo、Picasso,还是BioNemo,都是基于DGX Cloud的。看样子英伟达对AI上云,无论是training-as-a-service,还是别的什么as-a-service,都还是相当看重的。或许在AI大算力时代下,AI基础设施这样的重资产,最终还是应该让云服务供应商去处理——其运作量级,往往都不是中小型企业可以承受的。

AI为行业创造的价值

其实这篇文章的标题“对行业”“的影响”,这里的“行业”非常模糊,我们也没说是半导体行业、电子产业,还是整个信息技术行业。这可能基于英伟达的确不是什么纯粹的芯片企业这一点;或者说英伟达的发展,本身是否给予了其他芯片企业以启示:即“芯片公司”究竟该怎么去定义。

在答记者问媒体会上,有个提问挺有趣,就是英伟达本身在人们的印象里就是个卖硬件产品来赚钱的公司,什么CUDA生态、各行各业加速库补充、AI模型等等,理论上都应该是为了卖硬件服务的;但现如今的英伟达是否并不单纯依托于硬件来赚钱,而是期望藉由服务、软件来赚钱?

比如前文提到的DGX Cloud。虽然我们仍然没有那么明了DGX Cloud的盈利模式,但这显然是基于和云服务供应商的合作来卖服务。黄仁勋的回答是这样的:“软件服务、AI服务的市场比硬件大多了。这一点非常明确。原因也很简单。全球范围内这一领域硬件总销售额大约是10亿美元,就是云基础设施方面的。”

“而AI服务,关乎到了各行各业的自动化、加速、增值、强化。比如对万亿美元级别制造业的机器人的强化。”“比如医疗健康领域,AI成为药物科学家们的合作者,加速药物的发现。”“效率的加强本身是以万亿美元来衡量的。”“这些行业的每一个,市场规模都远大过硬件。”这一点或许是相当值得思考的。当然前提也在于生成式AI是否真的有那么大的能量。

绝大部分关注行业的同学应该知道,这波AI热潮的起源是2012年的AlexNet计算机视觉模型。那也是头一回有人用GPU来加速AI计算。当时研究人员用GeForce GTX 580对1400万张照片进行训练,262 PetaFLOPS。现在看来,那已经是小儿科了。训练GPT-3,算力需求323 ZettaFLOPS。这是AI发展的缩影,也是AI超越摩尔定律的写照。

最后补充一下,这篇文章受限于篇幅只部分谈到了Nvidia AI相关的发布。实际上Omniverse仍然是英伟达宣传的重点,并且也有不少对应的内容发布,包括给人印象比较深刻的宝马用Omniverse来构建EV车厂的数字孪生,据说是早于现实世界工厂2年之前就搞了数字版的工厂,做调试运营之类的。

而且Omniverse和AI也一直是相辅相成的,比如我们常在说机器人的AI训练过程需要放到数字世界——也就是Omniverse里面;以及工业元宇宙涵盖了未来汽车从原型设计到最终销售的整个链条,其中也有大量的AI参与。未来有机会,我们也会就元宇宙和AI的关联再行撰文。

- FT中文网报道:

不能让科技自行其是

福鲁哈尔:纵观历史,科技领域的大企业家一直在设定关于技术带来福祉的叙事——硅谷也不例外。

更新于2023年4月12日 17:43 拉娜•福鲁哈尔