在很多人眼中,“元宇宙”只是被炒出来的一个概念,八字都还没一撇,或者说只是一些初创企业为了融资给投资人和大众讲的一个故事。今年WAIC上,AI行业的诸多从业者都提到“元宇宙”这个词并不是某个人在某个时间突然提出来,然后大家都一拥而上;而是在诸多技术——包括通信、视觉、图形、AI、IoT等发展到高级阶段,必然促成的一个新应用。

我们认为这个说法或许还真有一些道理。连续几届GTC开发者大会,我们都报道了英伟达Omniverse:可以将其理解为英伟达版本的元宇宙,或者用英伟达的话来说Omniverse是元宇宙得以实现的平台/软件。

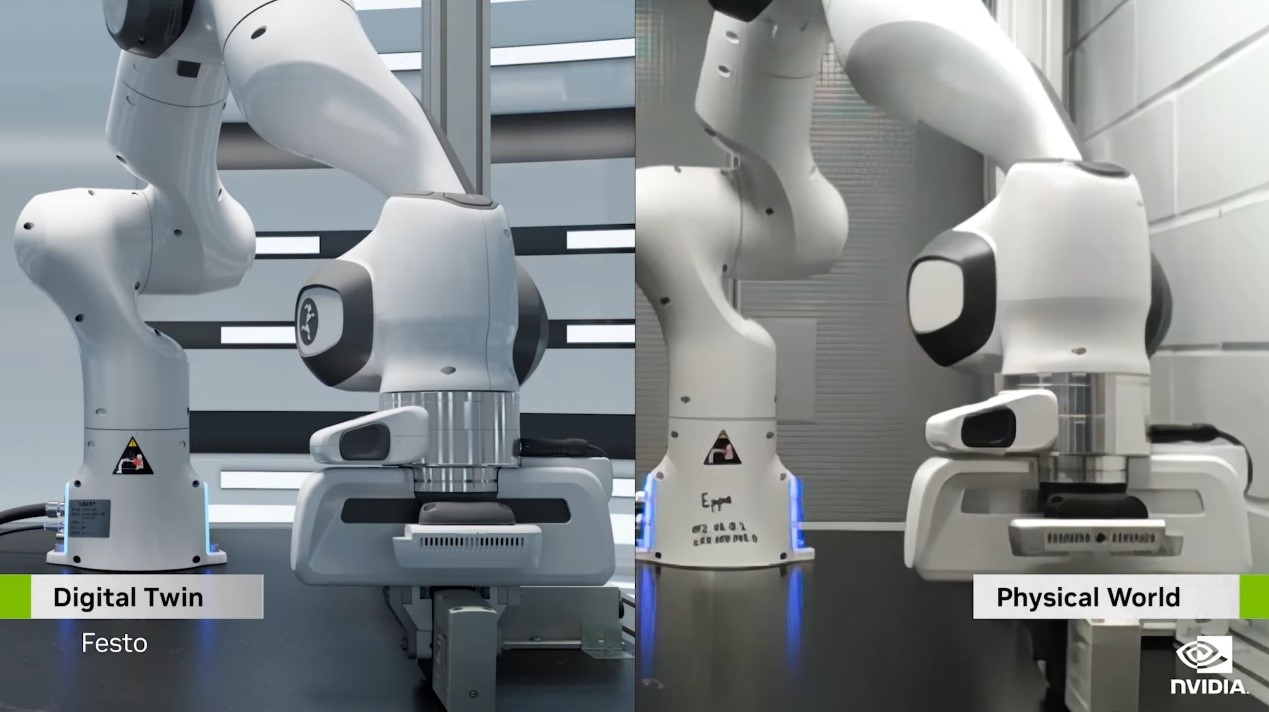

或许仍有不少人不清楚Omniverse是什么。举个例子:也是这次英伟达提到的一个例子。德国铁路(Deutsche Bahn)就在Omniverse里面构建、运营铁路轨道的digital twin(数字孪生),据说这个虚拟世界里的铁路包含了5700个站、轨道全长33000km。

做这么个东西,能在里头训练、验证AI模型,持续监控铁路、火车的运行情况,制造各种意外状况来发现问题对运营造成的影响。最终的目的是在不需要造新轨道的同时,增加铁路运载容量和运行效率,降低碳排量。那么在这个数字世界模拟的结果就能指导现实世界的铁路运转了。

当然这只是Omniverse的某一个方向的应用。似乎在Omniverse最初提出的那一年,同期Meta把“元宇宙”这个词也炒热了。或许英伟达最初在做Omniverse这东西时,压根儿也没想到“元宇宙”这么个新词。但当这个概念突然变火,发现Omniverse与“元宇宙”又无比契合,于是有了当前的市场宣传。这件事表现出来的,就是诸多技术走向成熟,大家的技术和市场方向多少是殊途同归的。

此前我们就在Omniverse的解读文章里提到过,或许在这么多个“元宇宙”里,Omniverse的落地情况是相对靠谱,且真正成型的。最近的GTC Fall,有关Omniverse推进情况的汇报也不例外。不过当前所在的发展阶段,从Omniverse上云,到英伟达拉来德勤(Deloitte)带货,都表明这个元宇宙的推广和“大举入侵”正式开始。

总览这届GTC

本文报道虽然主要将着眼在Omniverse,但和往常一样,最近举办的GTC Fall发布、更新的产品和技术仍然相当巨量——信息量多到一两篇文章根本难以承载。所以此处做个GTC概览,只关注Omniverse的同学可略过这部分内容。

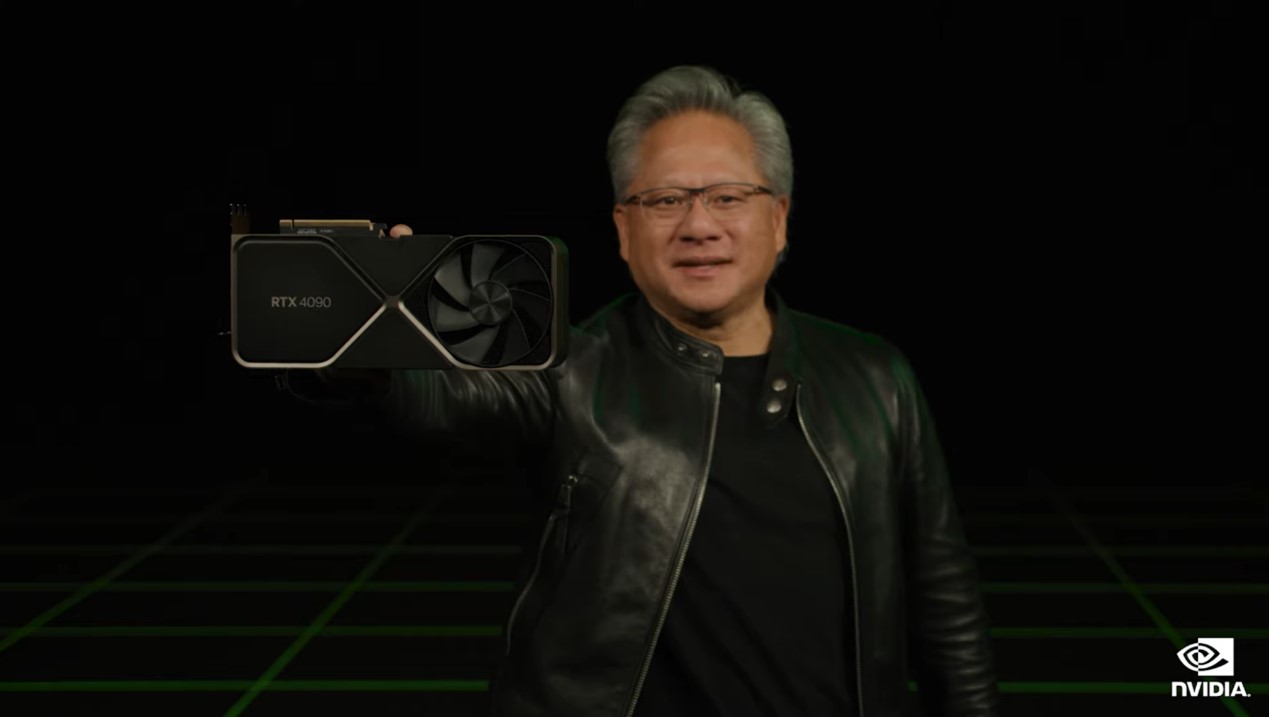

从大方向来看,黄仁勋在GTC主题演讲中做产品与技术发布、更新的板块大致上分成了GeForce RTX 40系列GPU(Ada Lovelace架构)、Omniverse、机器人(包括机器人、汽车、医疗,后两者本身就是特定领域的机器人)、AI(包括着重谈到的Large Language Model)、Hopper芯片及系统几大部分。其中的某些部分,我们已经做了报道。

除了Omniverse后文将做详细报道之外,我们认为比较重要的发布包括(尾巴上标了星号的,表示我们推荐关注的项目):

• Ada Lovelace架构的GeForce RTX 40系列GPU发布;同期面向设计师和创作者的RTX 6000系列也更新了*;

• 发布DLSS 3,其中特别新增了中间帧生成以及Reflex低延迟技术*;

• 特别发布了一个面向游戏MOD制作者的工具RTX Remix,可以给DX8/DX9的老游戏做光追级别的MOD*;

• 面向汽车,Thor芯片替代了Altan——后者在吞吐和性能方面都达到了前者的两倍;系统层面新增DRIVE Thor,在未来汽车的E/E架构中扮演中央计算机的角色*;(不少参会者对于英伟达用Thor来替换Atlan感到困惑,黄仁勋在答记者问中说Atlan项目是多年前就开始做的,而现在Ada Lovelace、Hopper、Grace这些新架构出现了,“这些技术那么优秀,我不想再等两年把这些技术做集成。”黄仁勋说。)

• 面向汽车的DRIVE Sim平台,新增了一个Neural Reconstruction Engine特性,传感器(如摄像头)录制的行车数据,就能在DRIVE Sim中构建完整的digital twin用于模拟*;

• 面向汽车的DRIVE Sim平台,新增针对座舱内部的digital twin构建,甚至包括座舱内跑的所有软件;

• 面向机器人,更新Jetson Orin Nano,比上一代Nano快80倍的速度;共用AGX Orin Developer Kit;

• 面向机器人,Isaac Sim上云(以SaaS方式提供服务)*;

• 面向机器人,发布工业级IGX Orin(也面向医疗成像与机器人);

• AI相关的更新:RAPIDS及其生态更新;新支持两个GNN网络加速(PyTorch Geometric和Deep Graph Library);宣布针对成像和计算机视觉的GPU开源加速库CV-CUDA;cuQuantum(量子电路模拟SDK)生态持续扩张;宣布JAX on Nvidia AI,英伟达和Google Research、DeepMind合作优化了JAX,预计Q4会有个比较重要的发布;

• LLM(Large Language Model)这次在主题演讲中占了大量篇幅,黄仁勋主要谈到了LLM的重要性;

• 发布Nvidia Nemo LLM Serivce,这是个针对大型LLM模型定制和推理的云服务,其中也提供一些预训练的基础模型。Nvidia NeMo LLM本身是一个prompt learning框架,针对LLM只需要给预训练模型提供一些例子(examples)就能对模型做出微调,而不需要重新训练整个模型——如此一来,就能定制化模型应用的上下文,比如AI针对相同的问题,在不同的应用场景给出不同的回答,LLM就能比较轻便地应用于不同地市场和场景*;

• 发布NeMo Megatron 530B Cloud API,是英伟达用NeMo做的,针对一些特定任务做了微调(prompt-tuned);

• 发布BioNemo和BioNemo Cloud API。BioNemo自然也是个LLM服务,给研究者和开发者准备的的数字生物学框架,可构建应用于化学、蛋白质、DNA和RNA序列的LLM;

• H100正式上架LaunchPad;DGX H100系统接受预订;OEM厂商的H100系统10月份出货;H100 2023年开始用于云服务;

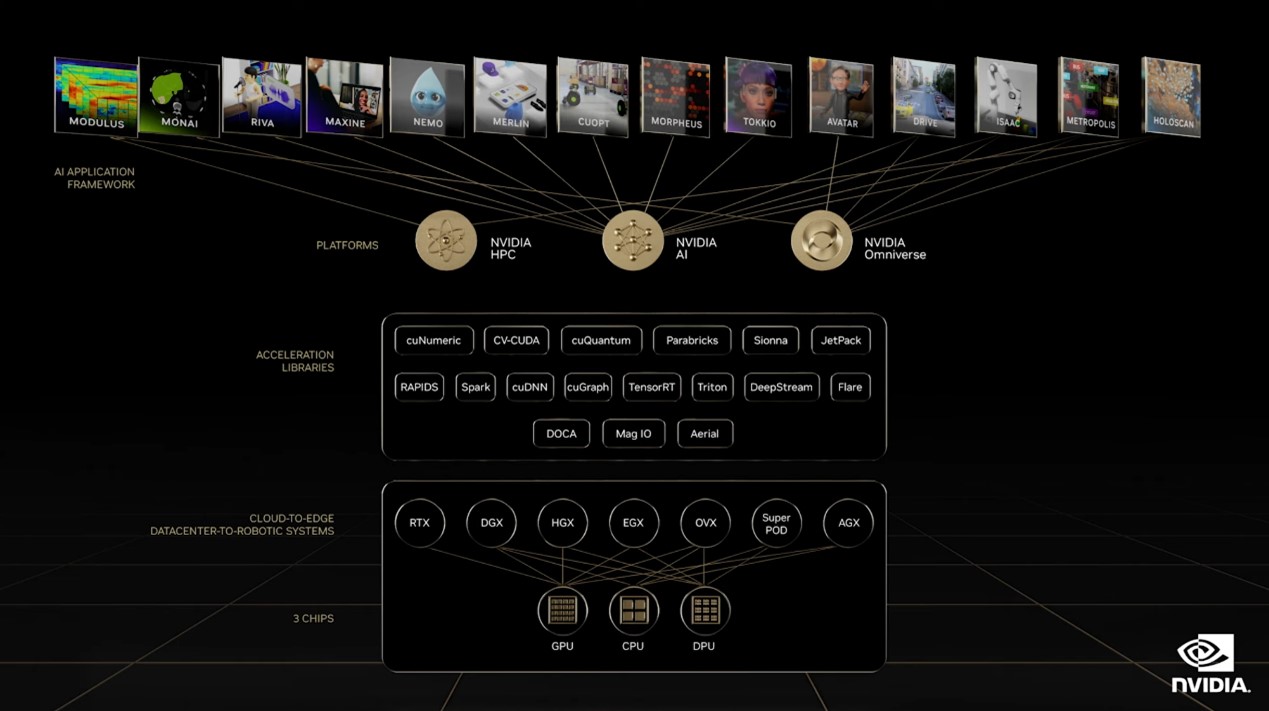

• 英伟达的三大平台HPC、AI、Omniverse,全栈将于明年全面在底层应用Grace与Grace Hopper(具体到设备形态上包括HGX Grace、HGX Grace Hopper、OVX),英伟达称其为“为现代数据中心开启Arm生态系统”*;

其他还有不少软件、库、SDK等方面的更新,以及加入新的合作伙伴的示例,此处不再一一列举。后续我们会对Ada Lovelace架构、DLSS 3技术,以及RTX Remix更有针对性的解析。这三个部分还是相当有趣的。

元宇宙是互联网的又一次迭代

上面这些软硬件更新,虽然大部分被划归在英伟达AI、HPC范畴内,实则很多也和Omniverse有着千丝万缕的联系。比如像Ada Lovelace这种很快就能看得见、摸得着的东西,也在扮演着Omniverse底座的作用——如OVX本身就是承载Omniverse的digital twin应用的计算机,更新其中的Ada Lovelace GPU在性能推升上也就显得很重要。

再比如Isaac Sim、Drive Sim对于机器人、汽车的训练都是在Omniverse中进行的;连GTC Fall引发热议的RTX Remix、Racer RTX都在Omniverse内运作;LLM模型就更是Omniverse某些应用能跑起来的基础了。从这个角度来说,英伟达元宇宙的添砖加瓦是每时每刻都在进行中的;基于每届GTC新发布的要素建设速度,还说“元宇宙”是个骗局就说不过去了吧。

似乎我们每次写有关Omniverse的文章都还是要花笔墨来科普一下Omniverse究竟是个什么。好在每次黄仁勋总能以一番挺生动的说辞来形容Omniverse。今年黄仁勋在接受采访时谈到Omniverse的方式也很有趣:“元宇宙这个概念今天还不那么容易理解,但这在未来会很重要。”

“大约25年前,互联网也没那么容易理解。15年前,移动互联网也不大容易理解。现在,下一代互联网——也就是元宇宙不容易理解也很正常。未来人们终将可以理解元宇宙。”

“互联网刚刚诞生的时候,我们惊奇地发现可以从一个文档直接转到另一个文档——这叫超文本。”“互联网将全世界连接到一个标准下,这个标准就是HTML。”黄仁勋说,而迭代后的“移动互联网的特点是不间断的(perpetually or continuously connected)。”“计算不仅是在你发出请求的时候才发生,而是随时随地的。一切都跨互联网更新,你也不需要发出更新请求,一切都是不断持续的。移动互联网因此让计算成为我们生活的一部分,所有的服务都不间断地提供给我们。”

“下一代互联网则在于连接数字和现实世界。现在的互联网连接了人,下一代互联网连接万物。汽车自动驾驶系统会连接到互联网,物流和制造机器人、建筑、每个房间、零售店都会连接到互联网,而且会实现高度自动化、机器人化。”

这个说法虽然听起来颇有点“万物互联”的感觉,但实际上在形式上是互联网与万物互联的“升维”版本。比如说此前我们花了很多笔墨解释的,数字世界中有现实世界对象的digital twin(数字孪生),并基于AI、图形渲染与物理仿真等技术,实现各类应用。比如机器人的digital twin可以进行AI训练,等到digital twin被训练成熟了,就可以对现实世界机器人的智能化引导;这也就避免了各种安全、时间、成本的种种限制。

“在这样一个新的世界里,数字(世界)与现实(世界)接合到一起,那么我们就需要新型的软件。这个新的软件就是我们打造的Omniverse。”黄仁勋说,“技术瓶颈在于,在部署软件之前,我们需要在软件里面模拟现实世界。那么我们就需要被称作digital twin的东西,这样我们才能持续对应用到digital twin之上的软件做测试,对AI做测试,然后再将其部署到现实世界中。Omniverse因此而诞生。”

“虽说元宇宙的未来现在还没那么好理解。但其实我们周围已经有不少元宇宙的构成元素了。比如说数字虚拟形象(digital avatar)。”此前两届GTC展示的Toy Jensen之类的虚拟形象都包含在其中。“还有手机上的现实增强,对视频的后期增强。”比如视频的实时换脸、Maxine改变视频中人的眼神方向、实时语言翻译、本地画质增强等都属于这个行列。

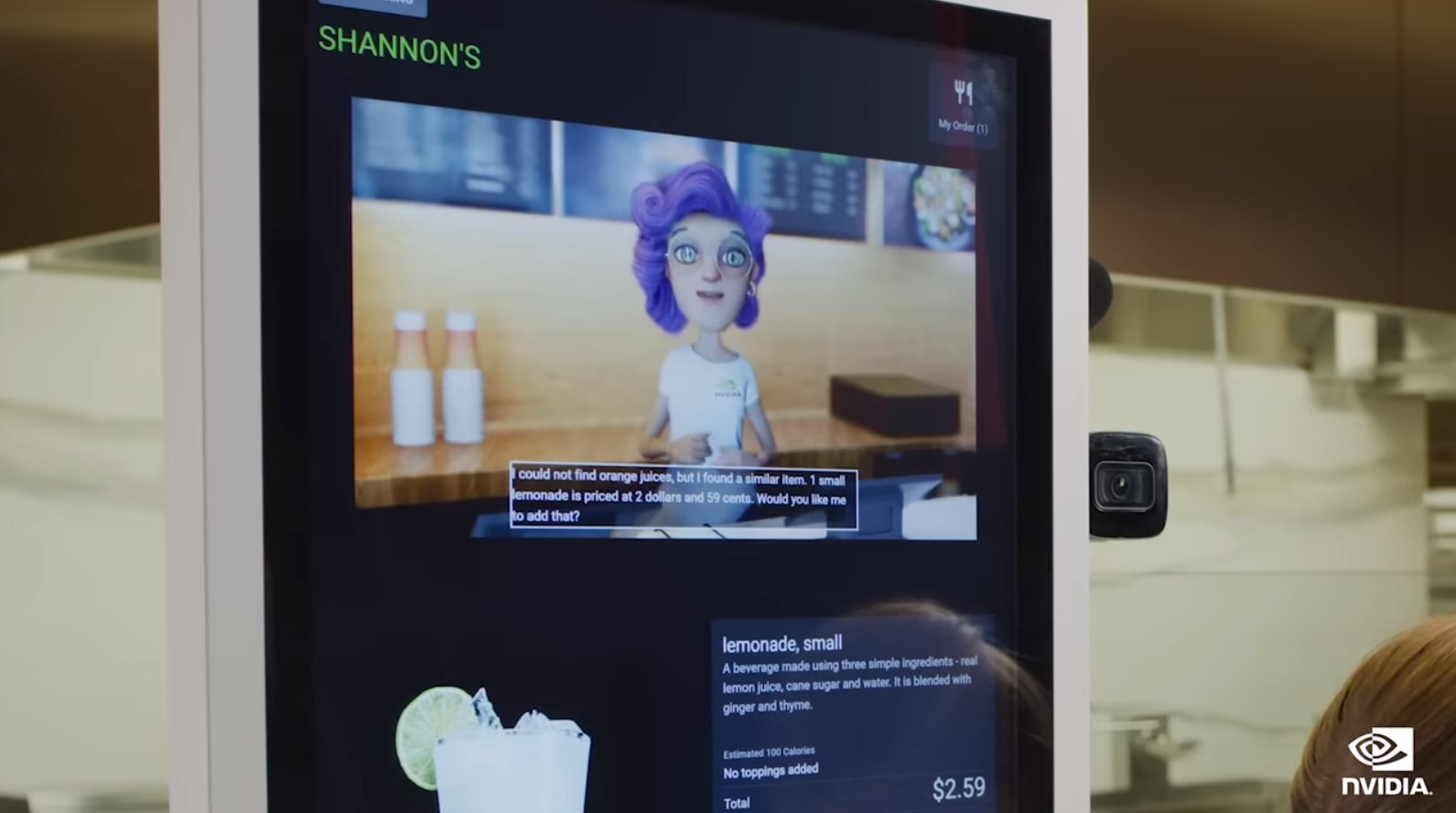

虚拟形象的确是Omniverse中的一个应用;也是我们认知里,未来元宇宙内部个体组成部分。今年黄仁勋主题演讲中又展示了一个叫做Violet的虚拟形象(应当就是基于Tokkio)——这是基于Omniverse ACE(Avatar Cloud Engine)打造的——ACE似乎是英伟达在SIGGRAPH会上发布的。这次是做出了一个云上、可做自动交互服务的虚拟形象,而且是面向快餐厅零售及其他客户服务场景。

快餐零售店里的Violet

我们在之前的解读文章里就谈到过,看起来还挺简单的这么一个虚拟形象,涉及到的技术项目涵盖了计算机视觉、语音AI、语言理解、实时的计算机图形(仅这部分就相当复杂,包含人物动作、衣服材料质感等);脸部表情、根据语音内容的唇部动作都需要契合,这都要用到对应的AI模型;而且还要让虚拟形象应用到零售、教育、家庭之类不同的行业或上下文场景;另外既然是云上的服务,则还涉及视频传输的编解码。

换UE引擎后的终极版Violet

似乎是为了实现这套流程,英伟达还做了个名为UCF(Universal Computing framework)的“零代码应用框架和云runtime引擎”。主题演讲中甚至还演示了,在UCF Studio界面中直接将Audio2Face的微服务输出,从Omniverse改成UE引擎,Violet形象就变身为豪华3D动画渲染版。

在我们看来,虚拟形象大概是元宇宙内部的构成要素;而虚拟形象更能体现的,是现代互联网的升维:交互方式从2D升维到3D,从文字或平面化的图像视频升维到真正的可交互的3D多媒体,并智能化的一种具象体现。

要覆盖整个地球

GTC Fall大会之上有关Omniverse的一个重要发布就是Omniverse上云。不过今年3月份的GTC Spring上,我们就已经谈到过上云的Omniverse Cloud,详情可点击这里了解Omniverse Cloud是怎么回事。据说这是英伟达的首个SaaS产品;在接受采访时,英伟达发言人还开玩笑说“we're becoming a SaaS company”。

这次有关Omniverse Cloud的更新应该算是基础设施的进一步补全。黄仁勋说Omniverse Cloud计算机应该有三个组成部分:(1)端侧给设计师、工程师准备的RTX计算机;(2)OVX服务器,跑虚拟世界模拟、连接Nucleus数据库的;还有第(3)个Nvidia GDN(Graphics Dilevery Network)。

GDN扮演的角色在传统互联网的分布式架构上,和CDN是类似的。所以GDN就是在云和端侧之间的分布式cache。黄仁勋说,藉由GDN,Omniverse计算机要覆盖整个星球。那GDN要怎么建呢?毕竟这是个极为巨大的工程——而且基于我们对云游戏的了解,“升维以后的互联网”要做分布式部署的难度实际是远大于现在的互联网的,吞吐、交互延迟方面的工程难度都很大。英伟达说GDN能够实现3D图形到边缘设备交互的低延迟串流。

很自然地,英伟达想到了基于GeForce Now来构建全球的GDN网络。似乎现在已经有企业开始基于GDN做部署了,比如Rimac用Omniverse来连接设计、工程和营销流水线。这家公司是做电动车平台的,他们在RTX工作站上做设计,然后汽车配置器应用发布基于Omniverse,通过GDN流转到终端设备上。

首先,设计是在各自的RTX电脑上做的,或者是使用云上OVX服务器上的Omniverse应用。设计完成以后,再将工作结果(USD模型)融入到实时的3D configurator中;然后通过GDN网络发布,发往边缘设备。据说以前configurator受限于预渲染选择,Rimac只能在端侧配置简化模型;而有了这套流程之后,Rimac用户就能以物理级精确材料、实时光追的高保真,对实际的工程数据集做配置了。

感觉这个应用就元宇宙的构建目标来看,还是相对初级的。不过随GDN的进一步铺陈和工程技术上的改进,这些应该算是实实在在的元宇宙构成基础设施了。

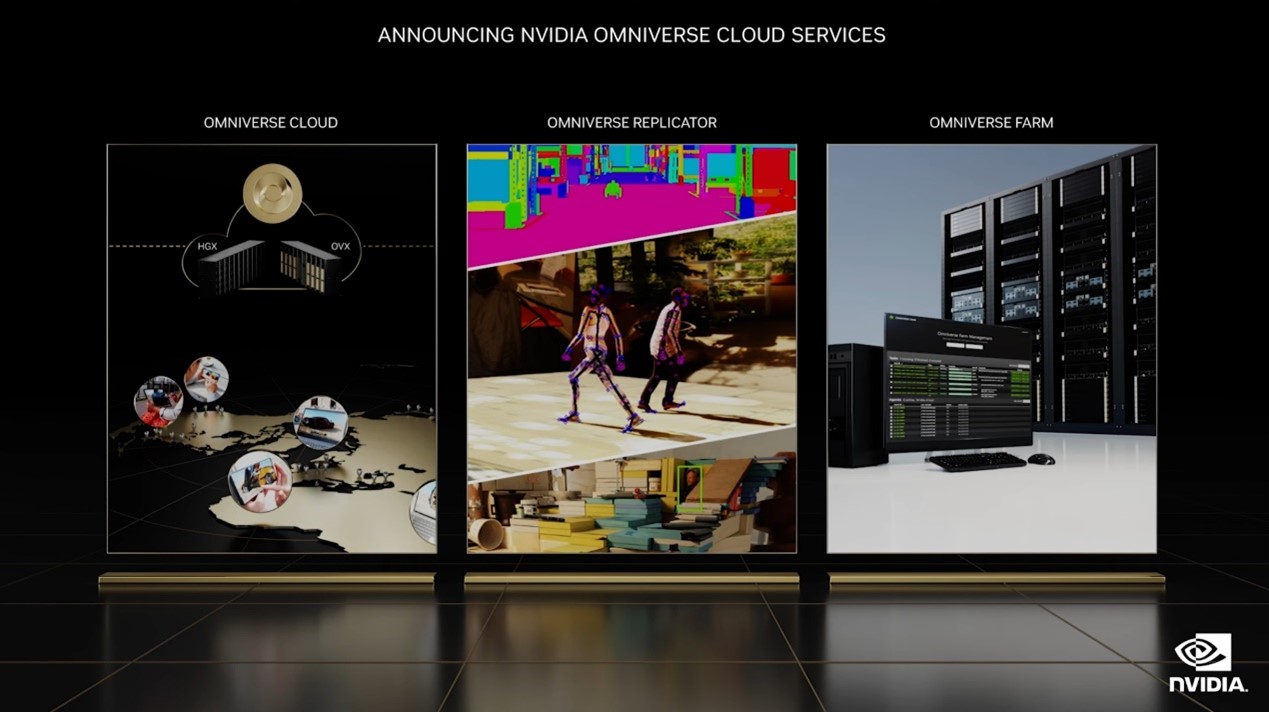

新发布的Omniverse Cloud Services服务包含了Omniverse Cloud、Replicator、Omniverse Farm等——最后这个应该是个可弹性扩展的渲染抽象层。而Omniverse Replicator,此前我们也详细介绍过,这是个合成数据(synthetic data)生成引擎,解决某些AI训练模型的数据来源问题——主要面向计算机视觉和机器人AI。机器人和汽车平台的模拟训练Isaac Sim和DRIVE Sim应当也包含在内。

其实Isaac Sim上云,可作为SaaS服务在Omniverse Cloud中提供也是一个重要发布(且Isaac Sim融入到了AWS Robomaker中);英伟达还说Tokkio、Maxine的上云也快了——Maxine作为一个实时通信AI应用框架,已经作为云原生微服务做了特别的优化。上云的一个重要价值就是扩展生态,让更多因为某些原因无法使用英伟达技术的人也能用得上。英伟达好几个发言人都在接受采访时说,如何让更多人能使用英伟达的产品是个挑战,那么云就能某种程度上解决了问题。

另外上次GTC上就提到Omniverse Nucleus云进入早期使用阶段。现在AWS上,Omniverse Enterprise企业客户已经可以部署Enterprise Nucleus服务器。

Omniverse生态建设情况

像Omniverse这样一个野心庞大的应用,目前最需要的就是更多的上下游合作伙伴接入,这样才有真正的“元宇宙”可言。Omniverse Cloud或者说Omniverse的上云,很大程度上就是为了提升Omniverse的触达率,能够更快速地扩张生态。

有关Omniverse生态扩展的另一个重要发布是,英伟达宣布和德勤(Deloitte)合作,将英伟达的服务和产品带到企业客户那里——当然除了Nvidia Omniverse之外,还有Nvidia AI相关的产品。黄仁勋在主题演讲中说:“德勤的35万专家将帮助全球企业去使用Nvidia应用框架,为客户服务、网络安全、工业自动化、仓储、零售自动化等构建当代多云应用。”

英伟达公布的数据是,目前已经有“超过150家软件合作伙伴成为生态系统的组成部分”,且有来自英伟达成百上千(hundreds of)的扩展(extentions),开发者社区也在快速成长。“我们有合作伙伴与经销商的全球网络,以及超过17万用户。”“Omniverse正在千万亿价值的跨通信、运输、零售、能源、娱乐、物流、奢侈品等行业和领域发挥作用。”显然,这就是下一个业绩突飞猛进的增长点了。

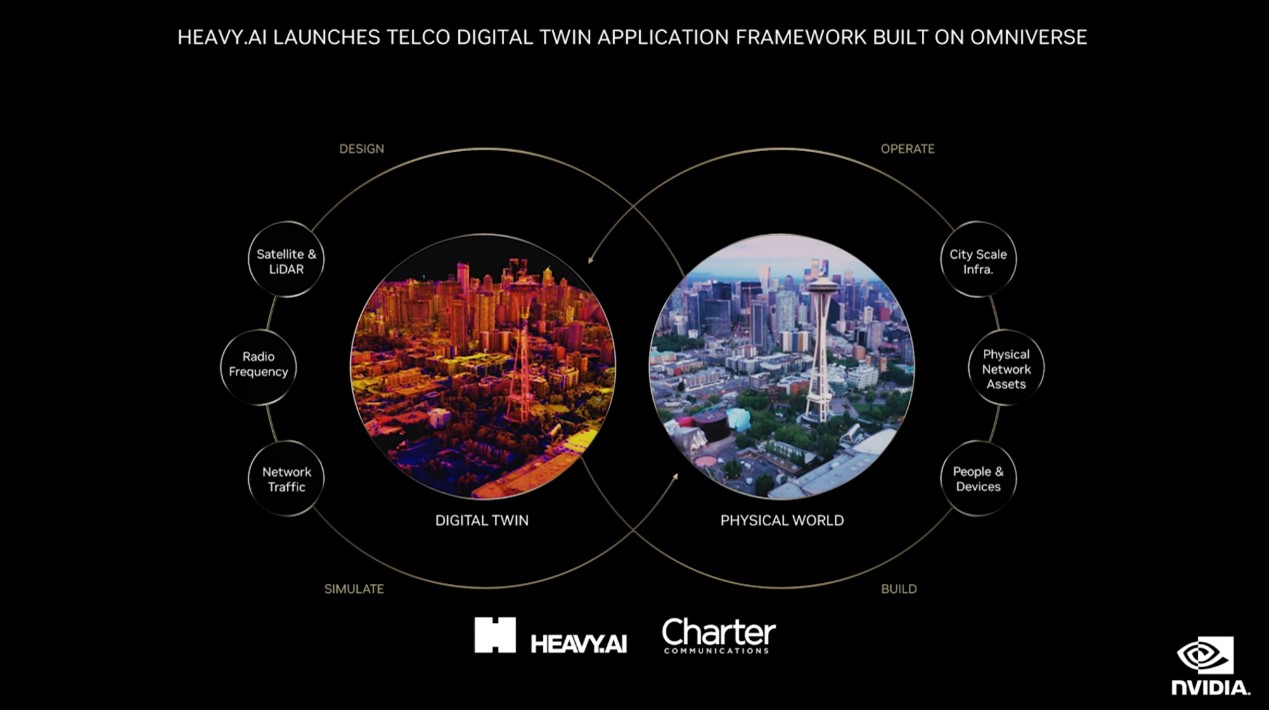

这次英伟达在宣传中提及的几个Omniverse主要新客户包括WPP、Lowe's、Heavy.AI、德国铁路(Deutsche Bahn),分属几个不同的领域。让我们感觉印象深刻的除了文首提到德国铁路的例子,Heavy.AI的应用也是其一。

Heavy.AI这家公司本身是做AI数据分析的,他们在Omniverse里面构建了一个AI加速应用框架——这个框架能够帮助电信公司开发物理级精确的digital twin,规划、建设和运营4G、5G网络。和此前爱立信的例子有点儿像,简而言之就是用Omniverse优化基站的部署和运营。首个项目是和Charter Communications(许特通讯,美国的一家通信公司)合作,而且会有数据科学家、业务分析师参与对数据集做剖析。英伟达说这么干能够节约数十亿美元的成本。

还有Lowe's的例子——这是个家居产品零售商,用Omniverse来设计、构建、运营店铺的digital twin,最终起到优化运营、加强购物体验的作用。这一例中还用到了与Omniverse连接的Magic Leap 2现实增强头戴设备,这样一来就能结合现实和Omniverse虚拟世界来浏览店铺设计。这算是很多人想象中的“元宇宙”吧。

另外值得一提的是,Omniverse实际并不限于digital twin的应用。创作协同也是Omniverse的一大应用方向,不管是异地的3D内容协作,还是不同设计工具流程上的统一管理与配合。黄仁勋也在主题演讲中举了些例子。

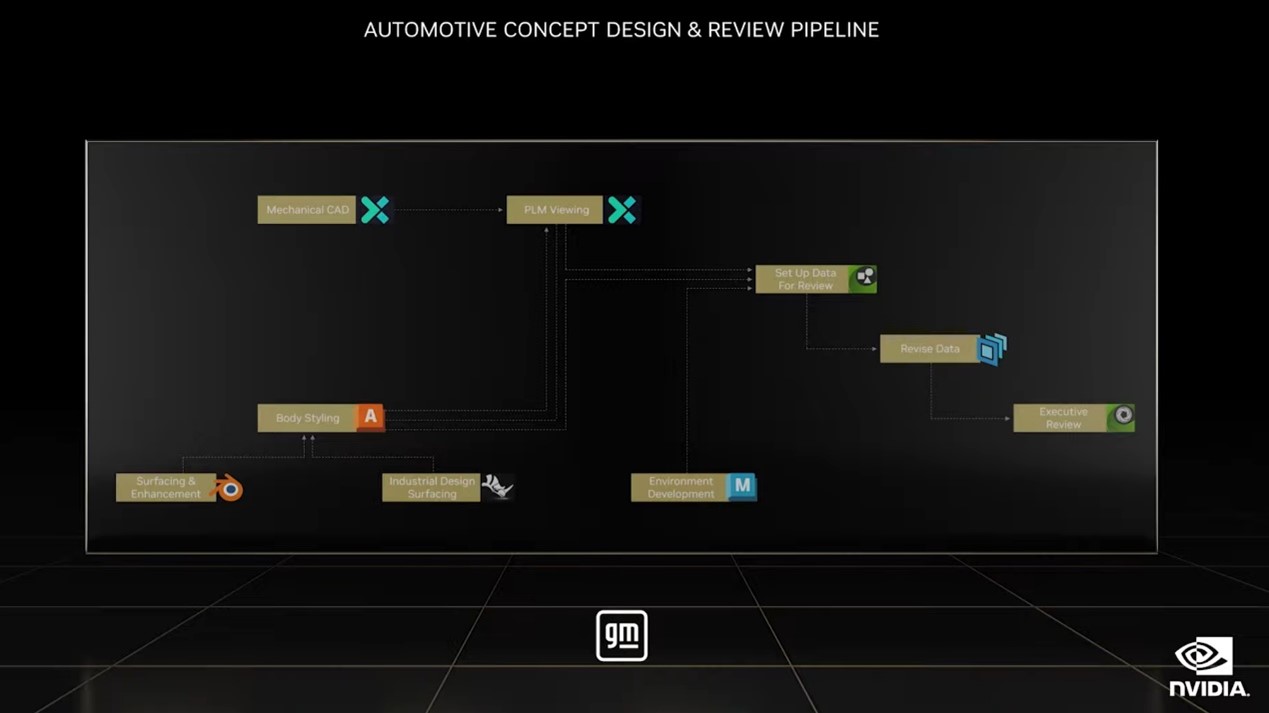

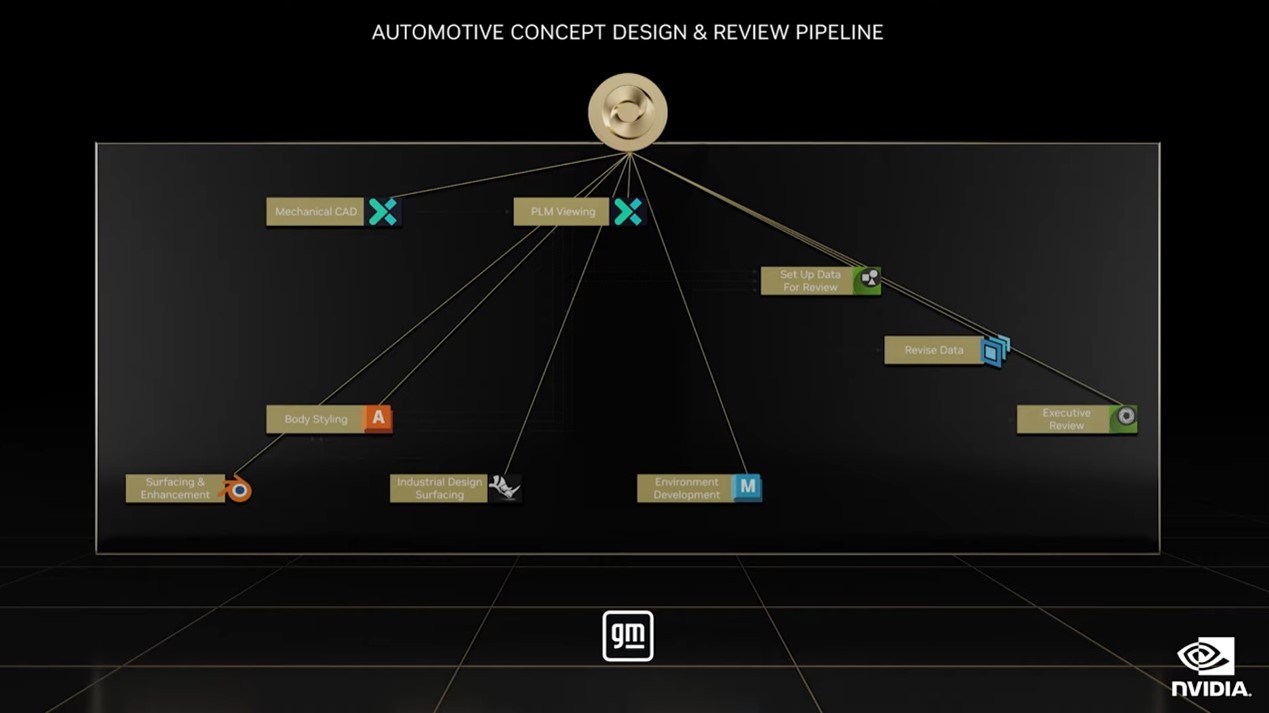

比如说通用汽车概念设计与review管线,涉及到使用Siemens、Autodesk、Ansys、PTC等的工具。通用汽车基于Omniverse搞了个Michigan Design Studio,设计师、工程师和营销人员可以在里面协同。虽然我们不清楚具体是怎么协同的,总之流程就如上图般发生了变化。

更多有关Omniverse的更新

除了上云与云基础设施构建、生态扩张这两件大事,Omniverse自身作为一个软件或平台,也有不少更新。比如说新的USD方案示例与教学;新的USD C++扩展示例;更新基于web的USD体验样例;还有新发布的Ada Lovelace新GPU在Omniverse使用的性能上更进一步,尤其全光追支持的实时VR性能提升;各类kit,比如Create、View版本更新;各种新的AI工具、新的开发者工具、内容管理系统;Siemens JT→USD格式支持......

L40 GPU与第二代OVX

Omniverse底层硬件的一个重要更新应该是第二代OVX的发布——感觉第一代OVX都还发布没多久,第二代就来了。OVX基本就可以理解为跑Omniverse的计算机,里面从硬件到软件为digital twin做优化的。相比第一代的主要更新,应该就在于采用Ada Lovelace架构的GPU(具体是这次新发布的L40数据中心GPU)。

宝马、捷豹已经成为OVX系统的第一批客户;而这个新系统的首批OEM合作伙伴也囊括了浪潮、联想和Supermicro,未来还会扩张。

最后值得一提的是,英伟达当前版图中的平台层三个板块相互之间错综复杂,很难将某一个产品或技术的更新简单归在一个板块中。比如前文提到这次非常热门做MOD的RTX Remix工具,其实也放在Omniverse里面协作。主题演讲中有炫酷视频放出的Racer RTX亦如是。所以我们对于Omniverse的解读并不全面。像RTX Remix这类更有趣的话题就放到下回单独分解吧。

这次GTC Fall上有关Omniverse的新发布大致上让我们有这么个感觉:Omniverse从底层CPU、GPU、DPU硬件、系统和设备,到中间层各种框架、库和软件,再到上层各类应用逐渐完善的当下,就要开始真正登上舞台了。所以上云、找德勤带货,让更多的人、企业能用上都是这么个过程——当然开发生态的完善一直都在持续中。

此前英伟达一直在强调自己构建这些系统时,是业内唯一具备了“全栈”能力的,无论HPC、AI还是Omniverse。感觉Omniverse方向的说服力暂时还不及HPC和AI方向,不过英伟达现在一年两刷GTC,还在各类包括SIGGRAPH、Computex之类的会上做有关元宇宙各层级的新发布——尤其是应用层——产品和技术名称多到大部分人根本分辨不过来。

这建设速度应该称得上是现有元宇宙里最脚踏实地的吧。不管“元宇宙”这个词的概念和热度最终会走向哪里,英伟达Omniverse还是有一条自己非常明晰的发展思路在的。

- 突然想起西部世界三那个雷荷波系统

- 看来元宇宙覆盖地球应该是真的,技术真的准备好了吗?只是个时间问题。

试想,元宇宙莫不就是诺亚方舟?