最近Discovery与联发科合作,共同发布了《Chasing Incredibles极感影像合作计划-探索跃至不凡》节目。这属于比较典型的品牌联名活动了。似乎在手机影像方面,不同市场参与者之间的合作还挺频繁。

此前联发科的媒体活动上,联发科就已经宣布了与Discovery之间的合作,准备共同拍摄制作《Chasing Incredibles极感影像合作计划-探索跃至不凡》节目。这个节目还是以Discovery擅长的纪录片形式,来探讨不同地域的文化、生活;节目在中国、墨西哥、新加坡等不同国家地区做了拍摄呈现。

从介绍来看,采用联发科天玑9000的手机主要参与到了本次纪录片拍摄的堪景工作中——堪景相关工作内容展示已经在Discovery探索频道官方微博发布,有兴趣的同学可前往观摩。

值得一提的是,这次的合作邀请了3位专业影像工作者,包括北京的Discovery资深制片人毛晓可、英国纪录片摄影师Richardo Afonso、苏格兰摄影导演Brian McDairmant——最后这位据说多次获得过英国电影学院奖和艾美奖提名。这3个人都参与了《Chasing Incredibles极感影像合作计划-探索跃至不凡》节目的拍摄制作;而且也在发布会上谈到了他们对于采用天玑9000芯片的拍照手机,用于纪录片堪景的体验。

从发布会的发言来看,不难总结这三位影视工作者对于当代搭载了天玑9000芯片的手机拍照,主要的评价在成像质量上(1)HDR特性能够同时呈现画面的明暗细节;(2)暗光环境下的抑噪表现出色/捕捉移动中的对象表现佳。以及在拍摄体验上(3)长时间视频拍摄,发热控制不错;(4)用于堪景时,手机非常灵活、方便。

后两者实则是更系统层面的问题——抛开这些体验层面的加成不谈,借此机会,我们来简单堪堪手机摄影摄像的HDR、暗光抑噪、稳定成像。

有关硬件和算力

手机成像前后通路的主体是摄像头和AP SoC,当然还有软件和算法。摄像头部分还可以切分成CIS(CMOS图像传感器)、镜头、驱动马达、框架等;而当代AP SoC参与成像的主要是ISP(图像处理器)与AI单元。后者以天玑9000芯片为例,就是天玑9000 SoC之上的Imagiq 710 ISP,以及APU 590。

有关天玑9000的ISP、APU部分,此前我们特别撰文谈到过。似乎在异构计算时代,手机AP SoC供应商的竞争焦点正默默从此前CPU、GPU为主,把更多注意力放在ISP、AI单元上。

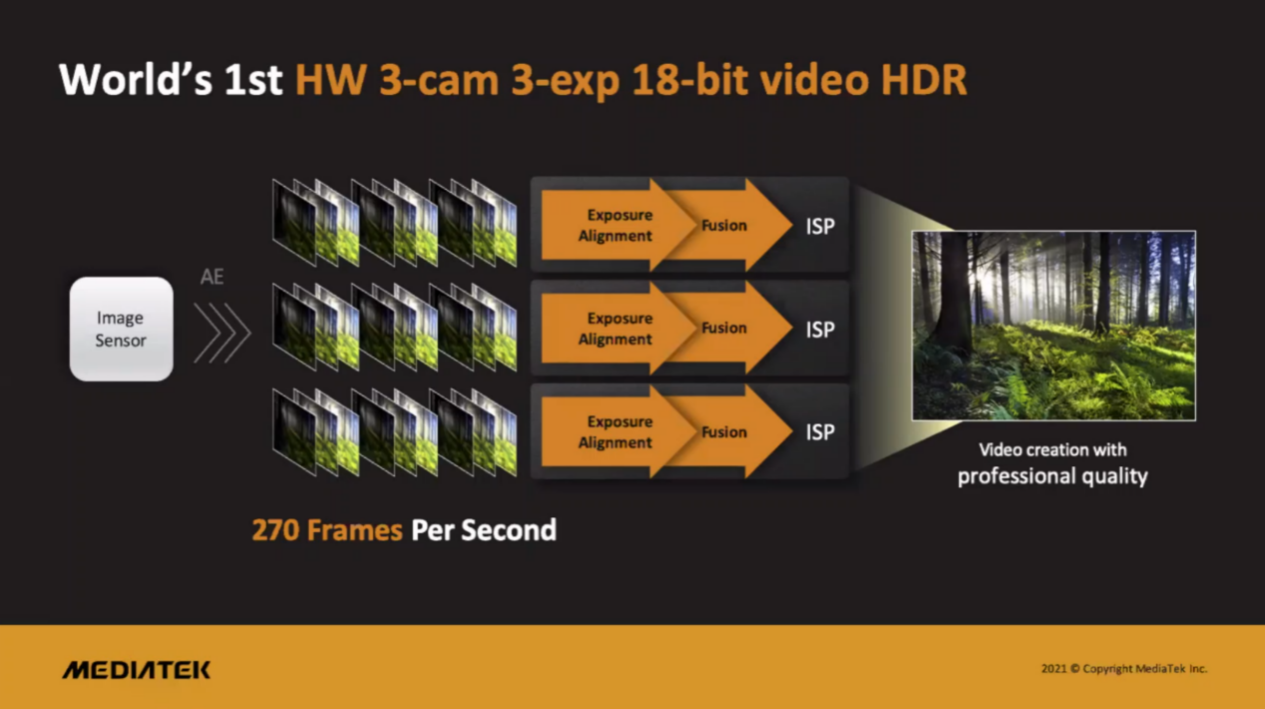

今年天玑9000发布之际,联发科也大力宣传了芯片上这两个组成部分:(1)Imagiq 790 ISP的特点包括最高90亿像素/秒的吞吐;3核设计,每核都支持3摄3曝光18bit视频HDR;AI video架构;(2)APU 590则是4个性能核+2个通用核的设计。

现在旗舰手机的成像过程,包括拍照和拍视频,影像数据从摄像头进入到AP SoC之后,主要就在ISP与AI单元之间流转,在两者配合的过程中输出为画面或视频。随着图像传感器更高像素的普及,以及市场对画质要求的提升,拍照、拍视频的算力需求是相当大的——而且现在这个过程还涉及到了AI计算,且AI在成像pipeline上的参与度正变得越来越高。

参与Discovery纪录片拍摄的这几名从业者提到的几个点,的确也是当代手机成像的痛点和技术发力点。联发科无线通信事业部技术规划总监李俊男在发布会上说:“在影片录制上,搭载天玑9000的手机,拥有高效能的HDR ISP;每一秒可以处理90亿像素,并拥有高达18比特的动态范围处理能力,可让多种不同的曝光融合为一。在HDR模式录制影片时,能帮助摄影师捕捉接近人眼看到的清晰高对比度视觉效果。”

另外“天玑9000的高效能APU能帮助侦测在拍摄过程中快速移动的人或物体,智能追踪物体的移动速度,精准捕捉清晰的画面,并让最后拍出的照片避免动态模糊。天玑9000的高能效APU还能支持出色的AI降噪技术,能在光线不足或是夜间拍摄录像的情况下,让画面非常的干净、漂亮。”

当代HDR

3位专业影像工作者在发言中其实都提到了HDR,比如说Richardo前往墨西哥尤卡坦州的奇兰,记录天然井(Cenote)。他说在15米深的地下,用天玑9000手机去拍照,仍然能够捕捉到丰富的细节、鲜艳的色彩。这其中的重点在于天然井场景下的光比很大,因为“井”口位置看出去很亮,而深入到“井”下位置是很暗的。这对HDR就有要求了。

时域的多帧合成HDR(High Dynamic Range,高动态范围)已经是现在手机“直出片”的标配了。遥想10年前,是否开启HDR还得由用户自行选择。这也是当代手机技术与算力提升的一个佐证。而且现在的HDR,并不限于静态照片,也在于动态的视频——后者对算力要求就更高了。Imagiq 790的每一个ISP达成3曝光18bit视频HDR,属于当代比较典型的达成拍摄更高动态范围与色深HDR视频的配置。

对于手机这种无法塞入很大图像传感器的设备而言,像素尺寸不够大。这其实是限制画面动态范围的根本原因。早年的手机拍摄高光比画面时,高光溢出和暗光死黑的情况是很常见的。以不同的曝光时间拍摄多张同场景的照片,然后合成为一张,就成为一个解决方案。

不过这种“包围曝光”方法也有问题:长曝光照片的一部分是过曝的,而短曝光照片的噪点问题会很严重。这就给最终的合成、对齐算法造成很大的障碍。所以前些年HDR刚刚在手机拍照上全面普及的时候,拍的照片经常会有鬼影、重像之类的问题。

这是应用和算法层面的问题。早年谷歌公布过有关其HDR+技术的部分细节信息,可作为参考。HDR+的本质也是在用户一次按下快门的时候就捕捉一系列的照片,并将之合成为一张。不过谷歌的思路是每张照片的曝光时长一致,都是短曝光,也就避免了高光溢出的问题。

只要堆栈足够多的短曝光照片,也就可以做降噪——噪点少了,就能提高画面暗处的亮度了。加上短曝光的照片相似程度都比较高,则合成、对齐就不容易有伪像产生。当然这其中还有不少技术细节,比如说如何对短曝光的线性RGB照片应用tone mapping曲线;还有要先选一张做最终对齐的初始帧——那么通常基于lucky imaging选择拍摄多张照片中锐度最高的,有利于让最终合成的照片画质更好。

不过HDR+最初问世的时间是2014年,用当年的谷歌手机拍一张HDR+照片需要用户在按下快门以后等上好一会儿。这在ISP性能提升显著提升的当下,已经越来越不成问题了。

HDR本身也随时代与技术进步在不断发展。比如说谷歌后来发现了HDR+的问题所在:通过大量短曝光来合成,即便可以做降噪,读取噪声(read noise)的存在实际上也限制了这种多帧降噪的上限。因为读取噪声和散粒噪声(shot noise)不同,是系统层面的,每拍一张照片就增加固定量的读取噪声。所以去年,谷歌还是在HDR算法中加入了包围曝光方案的——当然这对合成算法就提出了更高的要求。

再比如说现在的手机不光要实现最终拍摄效果的HDR,在用户拍照取景的时候就要看到HDR的预览。就这个看起来很简单的技术,其中也浓缩了不少技术和工程研究。

静态照片的HDR,不同的方案会在用户一次按下快门后,拍摄大约3-15张照片。然后对这些照片做对齐、合成、降噪,以及各种算法、tone mapping曲线应用。要在取景的时候,就把这一套流程做完,将HDR画面实时显示在取景框里是不现实的。尤其是对线性RGB照片,应用tone mapping算法,照片的不同区域需要采用不同的曲线。

此前有一种方案是基于机器学习,让拍照时的预览画面达成近似的HDR效果。大方向思路,是把画面切成块——对每个块应用一条tone mapping曲线;这些曲线形态都是渐进的,做blending合成可以近似出一个最优曲线。针对每一个像素,应用其周围最近的4个块的曲线,做结果合成。当然这个过程的计算也不轻松,因为同样涉及到大量像素的并行计算——这就不是ISP可以解决的问题了,需要其他处理单元的协同。

谷歌此前应用了一种叫做HDRnet的深度学习网络,这个模型可以预测从线性RGB画面,到近似最终HDR效果的画面每个块所需应用的tone mapping曲线。基于上述思路,对HDRnet训练上万张照片,就能适配各种不同的场景了。当然不同的手机OEM厂商用到的算法有差异,但此类思路的存在,就让天玑芯片APU这样的单元有了极大的用武之地。

还有暗光拍摄

除了HDR之外,《Chasing Incredibles极感影像合作计划-探索跃至不凡》节目的几位参与者都提到了采用天玑9000芯片的手机在暗光环境下的表现。

不过暗光环境下拍摄对于计算摄影的考点还是比较多样的。比如说毛晓可说堪景时,南池子美术馆内的灯光比较暗,这一方面也是为了保护作品。“日常拍出来的效果会比较模糊,画面有颗粒感。这次我们拍摄的效果出乎意料的好。背景其实没有太多噪点,拍摄主体很清晰,颜色也更真实。”

Richardo则说墨西哥的梅里达市有项古老的球类运动:波塔波球,拍摄团队特别探访了当地的一个波塔波球队。据说拍摄地所在位置的光线情况本来就相当不好,球赛又有大量的运动画面。不过Richardo谈到:“搭载天玑9000芯片的手机对于捕捉运动中的移动对象很擅长。”另外他也提到了画面抑噪,“搭载天玑9000的手机配备了AI降噪技术,配合上手机厂商的自研技术,在照片和视频拍摄方面都表现很出色。”

这其中,暗光环境下要求长曝光,原本就很难拍出清晰、锐利的画面;至于成像噪声,这也是散粒噪声作为主要来源,以及手机图像传感器很小,所以手机在暗光环境下拍照的一大痛点。

这方面的技术点还是比较多样的。受限于篇幅,此处只选择一些稍谈一谈。比如说前文提到HDR+技术在近两年加入了包围曝光以后,对于动态对象拍摄的多张合成算法实际上是成为了挑战的。不过其实这两年我们用手机拍摄移动对象,会发现多张堆栈的鬼影几乎已经不再成为大问题:画面的可用性极大提升。

这里面的常规思路是首先对于一次拍下的多张照片,选择一个参考帧——通常是为避免大幅度的运动模糊,会选择短曝光的帧。则在进行合成时,所有其他帧都对齐到该参考帧。对于复杂场景来说,合成的挑战依然相当大;因为场景复杂度高、运动对象动作幅度很大时,很难找到不同帧可相互匹配的区域。早年简单的算法也就很容易造成鬼影。

有些方案为解决问题会采用空间合成算法——根据像素来决策画面内容是否做合成;另外还需要去鬼影,只不过算法难度还是不小的。毕竟长曝光帧和参考帧比起来,在噪声特点、高光溢出、动态模糊的量等方面都存在极大差异。具体怎么做,那就是相当工程的问题了。此前有一些手机会用到动作检测(motion metering),比如光流法来判断最近的场景动作,然后选择一个曝光时间,让模糊的影响最小化。

值得一提的是,在拍摄高速运动对象之外的动态画面稳定性方面,也有越来越多的机器学习解决方案。比如有一种方案首先是进行动态分析,借助手机上的陀螺仪信号、光学防抖机构以及其他相关资源,预测摄像头的运动;然后是动态过滤阶段,这个阶段会融合机器学习和信号处理,来预测摄像头可能的抖动方向;最后则是帧合成阶段,移除快门的果冻效应、对焦呼吸效应等的伪像。

这虽然和拍摄运动对象的去鬼影的过程还是不同,但是对于视频拍摄稳定性和让画面看起来更锐利都有相当大的价值。而这个过程是需要算力参与的。或许一般人都很难想象,拍照、拍视频几个简单的动作就要动用到这么多复杂的技术,从硬件到软件。

还有个暗光环境下拍摄的降噪问题,超采样、多张堆栈都是降噪可选的方案。此前天文摄影领域很早就有曝光堆栈的降噪方案。随着手机芯片算力的提升,可堆的帧数量其实是在增多的;而且高像素多帧堆栈也已经很平常。

画面信噪比提升当前的瓶颈虽然在于散粒噪声,以及手机原本就很小的图像传感器上;但单纯对图像信号处理而言,这其中的难点还是在合成、对齐之类的问题上;以及前文就提到读取噪声的存在,对于多帧堆栈降噪的天然不利。

不过现在比较流行的显然是“AI降噪”。天玑9000的参数表中提到了4K HDR视频的AI降噪,以及照片拍摄时的快速AI降噪。这也是当代AP SoC的一个标配了。其实抛开实时降噪技术不谈,随着算力的持续提升,画面AI降噪的确是个很值得研究的方向。比较具有代表性的是Google Research前不久发布的一个名为MultiNerf的开源项目——当时谷歌放出视频演示的时候还是惊艳了不少人的。这类技术的潜力,未来大概还会很大。

当然,手机拍照的技术发展并不只是上述这些,不过这次发布会上的几位创作者对以上几点格外赞赏有加。未来有机会我们还可以就更多手机成像技术的话题做进一步的探讨。

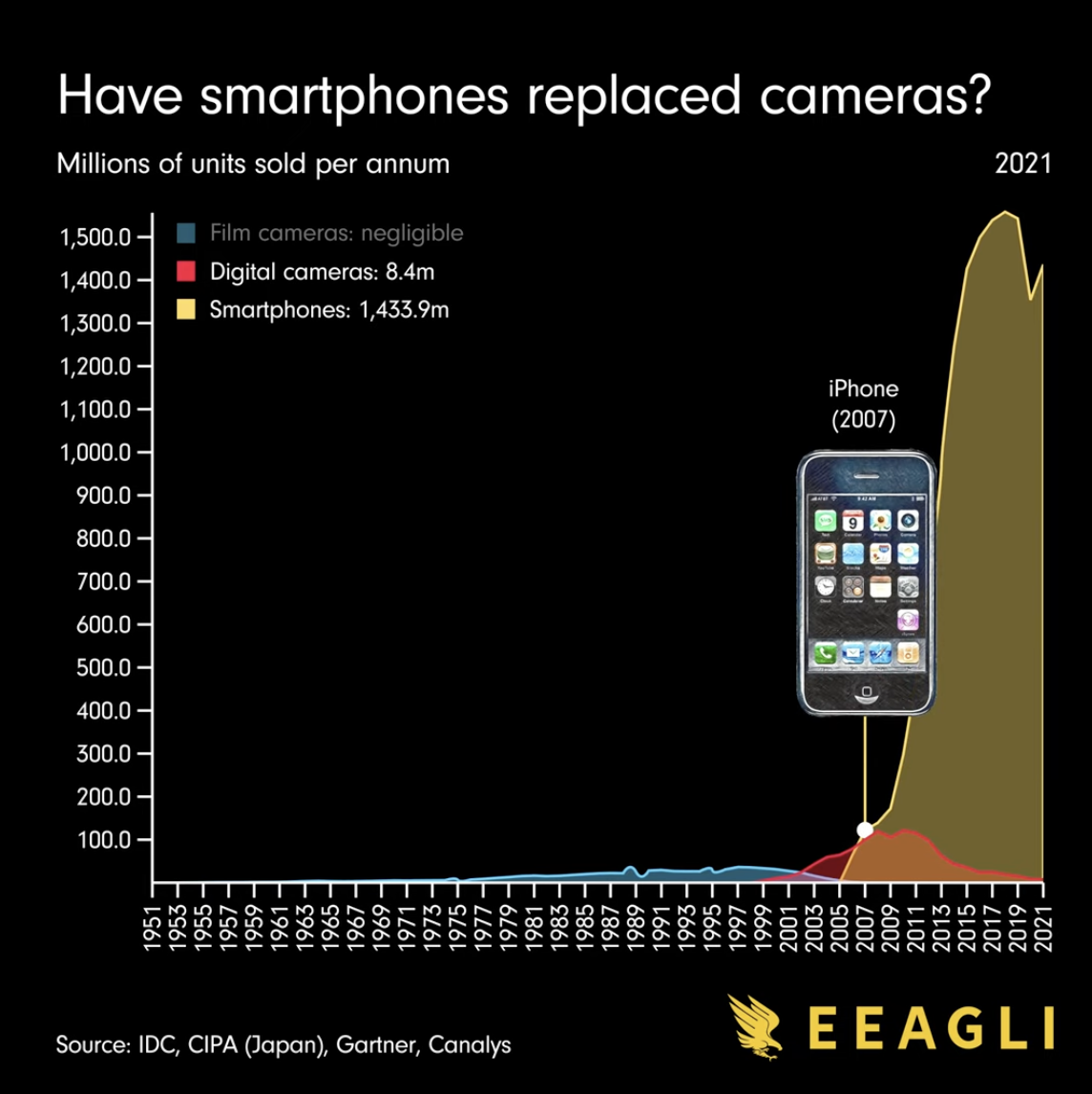

前不久EEAGLI发了个视频,提问“手机取代相机了吗“,还给出了上面这张图。在专业创作领域,受制于体积和光学属性,以及用户群体与用途的差异,智能手机是无法取代相机的。但在Discovery纪录片制作流程中,手机参与堪景流程;以及当前最流行、基数最大的拍摄设备都是手机。加上手机相对灵活的独特性,以及计算摄影技术持续发展,和诸如天玑9000芯片为加持的算力提升,都为手机成像的前进注入了源源不断的动力。