每年SIGGRAPH(Special Interest Group for Computer GRAPHICS,计算机图形图像特别兴趣小组)都是图形、图像计算的盛会。今年英伟达照例发了一些图形计算研究相关的paper,发布了面向图形专业领域的GPU,并且更新了Omniverse——传说中元宇宙的最新动态。

这两年GTC、Computex之类的会上,我们关注比较多的是英伟达的AI业务。其实从英伟达FY2021 Q1的季报来看,其Gaming(游戏)业务的营收同比增长也达到了106%(27.6亿美元),实在是让人感觉相当意外;而其Professional Visualization(专业视觉)虽然在业务规模上远小于游戏和数据中心(20.5亿美元),但该业务季度营收达到3.72亿美元(只相当于游戏业务的13%左右),同比增长21%。

游戏+专业视觉,英伟达的图形计算业务仍然是其营收核心。关注SIGGRAPH,大体上也能看到图形计算近未来的发展方向。

新发布一款RTX A2000

面向专业视觉市场,英伟达在SIGGRAPH上新发布一款RTX A2000——从型号就不难看出,这是用来补全市场定位的光线追踪图形卡。

专业市场主要有三块,分别是数据中心、桌面工作站、专业笔记本。面向桌面图形工作站(desktop workstations)市场比较知名的安培架构显卡应该是RTX A6000——这是英伟达去年发的一款专业显卡,包括完整的GA102 GPU核、二代RT Core、三代Tensor Core、AV1硬件解码支持,以及48GB GDDR6显存,是专业显卡中的顶配。今年基于安培架构、针对桌面工作站的其他型号显卡产品还包括RTX A5000、A4000。

其实面向专业笔记本(Professional Laptops)或者说移动工作站,RTX平台已经覆盖了Nvidia RTX A5000、A4000、A3000、A2000。

所以这次针对桌面工作站的RTX A2000发布是比较典型的产品定位补全,英伟达称其为“中端”定位产品,“这很重要,因为这是我们第一次把RTX技术带到产品组合中的中端定位产品中。”英伟达高级总监(Senior Director)Sandeep Gupte表示。Gupte强调说这张卡尺寸很小,大约就手机的大小。

具体配置如上图所示,主要包括“VR Ready”;带ECC的6GB GDDR6显存(据说ECC纠错对于医疗成像之类的应用很重要,典型如放射器械的成像、重构和可视化);8 TFLOPS单精度最高算力;“单精度模拟性能翻倍”,5倍渲染(rending)性能提升,3D CAD类应用提速50%。I/O方面的支持包括4x mDP1.4显示输出、PCIe Gen 4支持。预计销售价格450美元,今年10月通过系统合作伙伴(如惠普、Dell、联想等OEM厂商)推向市场。

其余配置信息,包括RT光追核心数量、Tensor核心数量、内存位宽等,在正式发布的规格表中应该会公布。这张卡的发布其实并没有太多意外,英伟达对此的宣传点主要包括:对实时光线追踪的支持——也是这个定位的显卡首次对RTX做出支持;Tensor核心用于加速AI应用。这些对于一些从事建筑、设计等的中小型企业应该会非常有价值。

以及紧凑的尺寸设计,因为很多应用领域对工作站的空间占用可能是比较敏感的,小尺寸对于紧凑的工作站设计就有价值。“这部分市场正在快速发展,这张卡不仅适用于标准工作站,而且适用于小尺寸(small form factor)工作站——面向一些特定的设备和解决方案。”Gupte说,“致力于医疗设备的一些客户,现在就能利用RTX的技术和性能了。”“像是数位看板(digital signage),以及其他对空间比较敏感的应用。”

Omniverse元宇宙构建的新进展

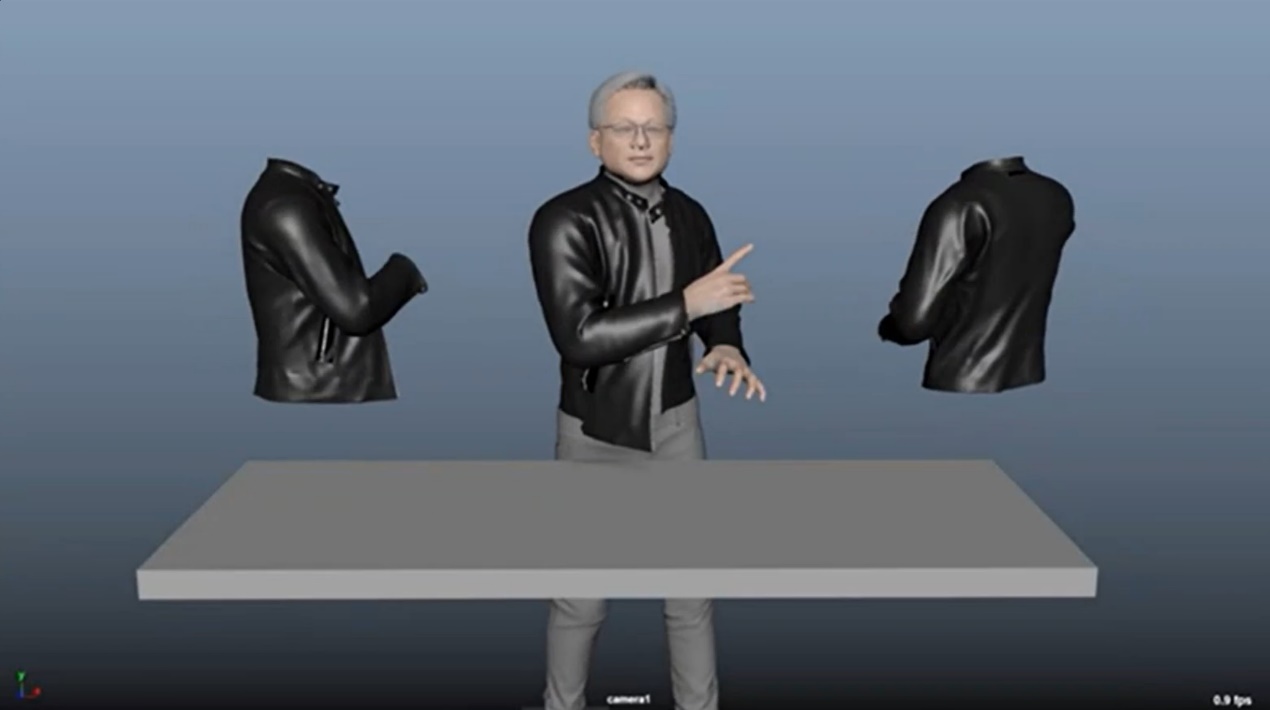

有关Omniverse元宇宙:这是英伟达构想中建立的庞大虚拟世界。建议阅读我们此前撰写的有关Omniverse的报道文章。简单来说,Omniverse更像是基于现实世界的物理法则,构建的一个庞大虚拟世界。这个虚拟世界将发挥相当大的作用,比如说构造digital twin用于智能制造;从不同的位置进行数字内容协作;更多创造者在虚拟世界中设计数字内容——原本是现实世界才能设计的,如汽车、鞋子、药物等等。

黄仁勋此前接受采访时说,这个虚拟世界会比现实世界大上百倍,包括其中的经济都会比现实世界规模更大。“艺术家们会花时间去打造漂亮的建筑、漂亮的汽车、漂亮的产品,只不过是以数字的方式。”

“我们相信更多的东西会在元宇宙(metaverse)中造出来,比现实世界多。在这个世界里,更多的东西可以分享、购买、出售…其实这些在现在的电子游戏、数字化产品中已经能够体现出来了。”英伟达Omniverse工程与模拟副总裁(VP, Omniverse Engineering & Simulation)Rev Lebaredian在今年SIGGRAPH上对Omniverse做了个比较有趣的总结。

“过去几十年,3D计算机图形计算高速发展,英伟达抓住了这波机遇。但3D仍然很大程度上局限于一些行业。构建3D世界很难,尤其是从头构建这样一个大型虚拟世界。像Pixar、梦工厂这样的企业在电影中构建虚拟世界,需要成百上千的艺术家耗费多年一起去做——这些人可能是动画师(animator)、建模师(modeler)、贴图画师(texture painter)等等。”

“这些人要从不同位置,使用不同的工具来完成工作。这些工具可能来自不同的行业,可能是建筑、制造或者媒体娱乐等。” Lebaredian说,“我们构建这样一个虚拟世界,需要集齐所有的工具。”“我们构建这样一个元宇宙(metaverse)的速度是指数级的,但构建难度增长也是指数级的。我们需要构建起基础设施,让这个世界的构造更高效。”

构建Omniverse这样一个元宇宙的基础设施,实际上存在着大量的挑战,比如说设计者在全球不同区域、位置,协同设计是比较复杂的工作;海量的数据从一个位置搬迁到另一个位置,一个工作站到另一个工作站,或者在不同位置间同步也很难;另外3D设计的不同工具并没有统一的标准,其表达方式都千差万别,要在不同工具间传递数据和设计就有更大的挑战。

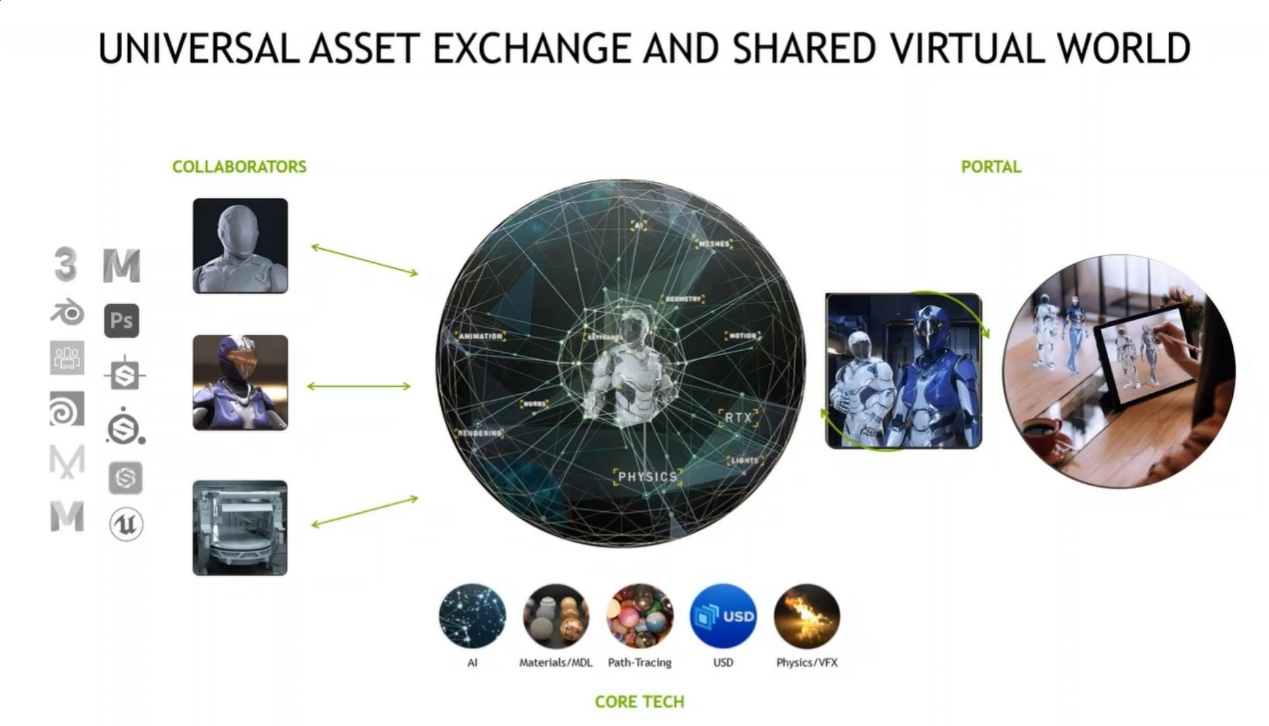

其实有关Omniverse如何构建基础设施,我们此前已经花比较大的篇幅介绍过,这里就不再赘述了:包括用Nucleus来连接不同位置的用户,以USD(Universal Scene Description)格式来统一数据的表征(common representation);还包括合成、渲染和动画引擎,也就是遵循现实世界物理法则的各种模拟技术,比如光线追踪——这些技术可以加强现有工具;还有一些应用,也作为进入虚拟世界的入口。

(感觉每次介绍Omniverse的背景都要花好大篇幅)这次SIGGRAPH之上,英伟达针对Omniverse的更新主要包括:

●宣布与Blender Foundation合作。“我们投入了不少工程方面的能力,针对Blender,增加对于USD格式和各种其他标准的支持。我们以开源的方式进行,很快就会作为代码分支向大众开放,我们称之为Omniverse Blender。” Lebaredian说,“计划未来将其汇入到Blender的主干。如此一来,我们就能把USD这类共同标准带给大量Blender用户,让Blender以一流的方式与我们的Omniverse生态系统协同。”

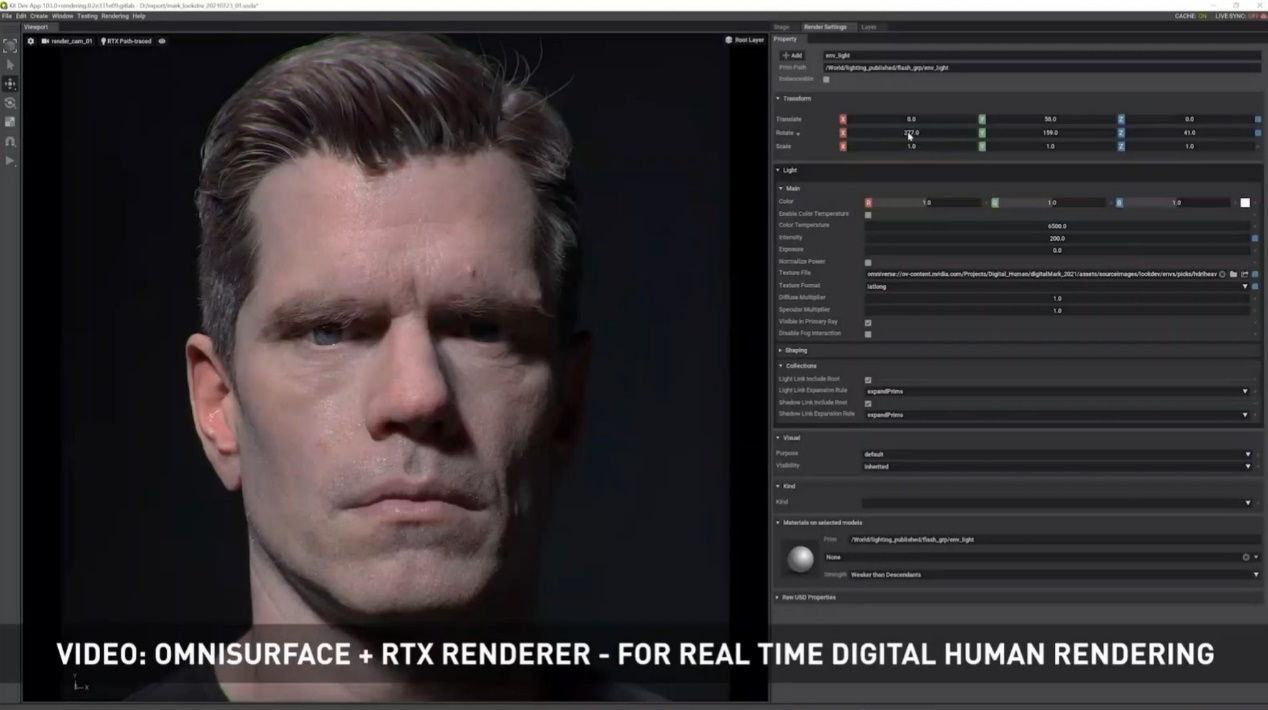

●宣布推出Omnisurface。Lebaredian表示Omnisurface是MDL(material definition language)的一部分,MDL其实是多年前开源的一种语言,用以作为材质表达的标准。而“Omnisurface是我们开发的一种材质,一种uber shader,设计上相当高效、具备弹性。藉由这种uber shader的简单参数,就能描述广范的、多种类型的材质。”Omnisurface在Omniverse Create应用中提供,原则上所有支持MDL的render都能用Omnisurface。

Lebaredian在媒体分享会上也做了Omnisurface的简单演示:以足够的精度构建某个演员的3D形象后,就能做脸部材质(material)的模拟,在改变光照环境的情况下,演员脸部依然会看起来很自然,而不需要做其他调整——主要就是基于Omnisurface MDL材质的精确属性特点。

●宣布推出GANVERSE3D。不过好像GANVERSE3D的成果是在数月前就公布的,这个工具的特点是只需要一张平面照片,就能将其中的对象转为3D模型。举例说用网上的汽车照片,藉由GANVERSE3D就能生成汽车的3D模型,而且该3D对象的操作、运行完全符合物理法则,也就能在虚拟世界里驾驶这辆车。Omniverse Create应用中已经发布了该扩展特性。

“这只是我们期望带到虚拟世界中的AI的一个开始,更多现实世界的东西都能带进来,通过图片这类方式快速、简单地转为虚拟对象。”

●宣布与Adobe合作。Adobe方面据说已经开发了connector连接器,将其(Substance?)应用接入到Omniverse,与此同时也带来了一些扩展。

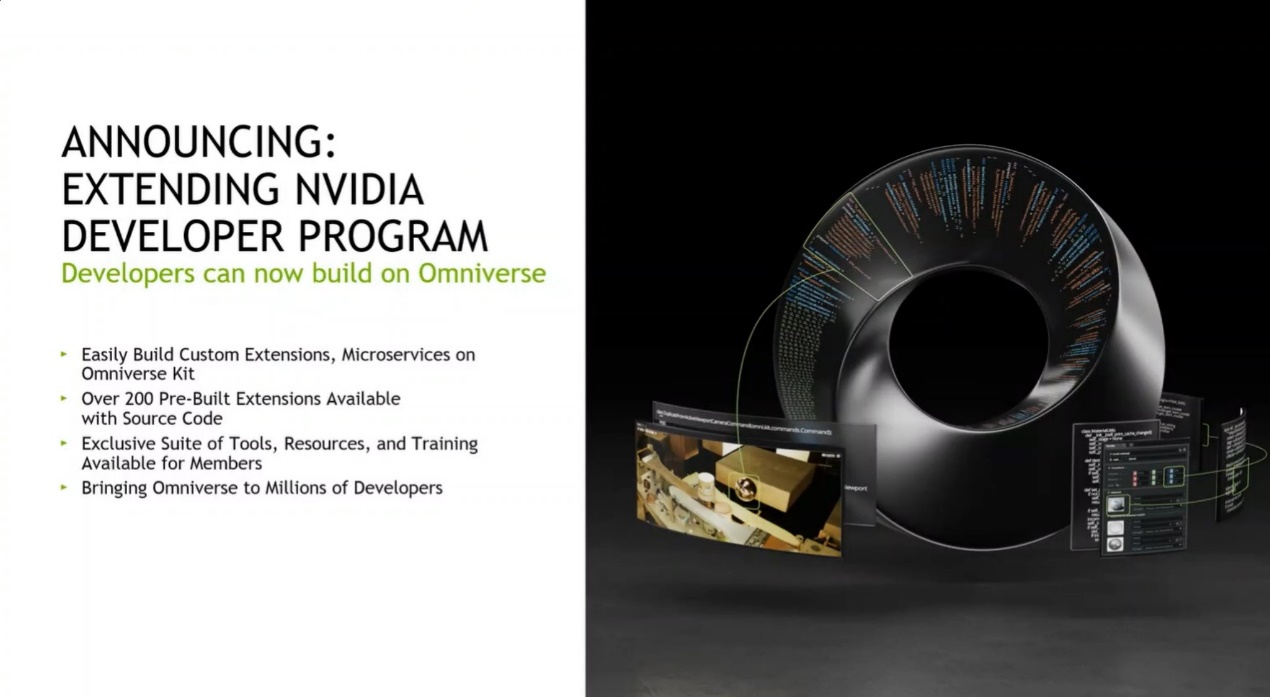

●宣布扩展Nvidia Developer Program。“我们将发布一系列材料、工具集,让Omniverse之上的extensions、microservices、connectors和应用的开发变得更容易。”

●宣布与Pixar、苹果合作,共同改善USD格式语言。英伟达表示,首先面向社区发布合作白皮书,然后与社区协作对标准做修改,在达成一致之后再将修改内容整合进USD开源的主干代码。“我们计划在USD中增加描绘万物的其他诸多标准。我们期望未来不只是与Pixar和苹果合作。”

●宣布Omniverse Enterprise秋季对大众开放,目前是early access阶段。这一点应该不算什么新闻了。不过据说目前加入到Omniverse生态的企业还不少,生态系统正快速扩大。毕竟像Omniverse这么一个庞大的系统还是需要诸多参与者的共同参与。

Oops…

图形计算方面的一些研究成果

以上应该是比较多爱好者感兴趣的,相关英伟达在专业视觉,以及Omniverse构建方面的一些新闻。最后来简单谈谈英伟达这次分享的有关图形计算方面的一些研究成果,在SIGGRAPH上以paper的形式开放:也就是那个据说全球有超过200名研究人员的Nvidia Research在做的事情。

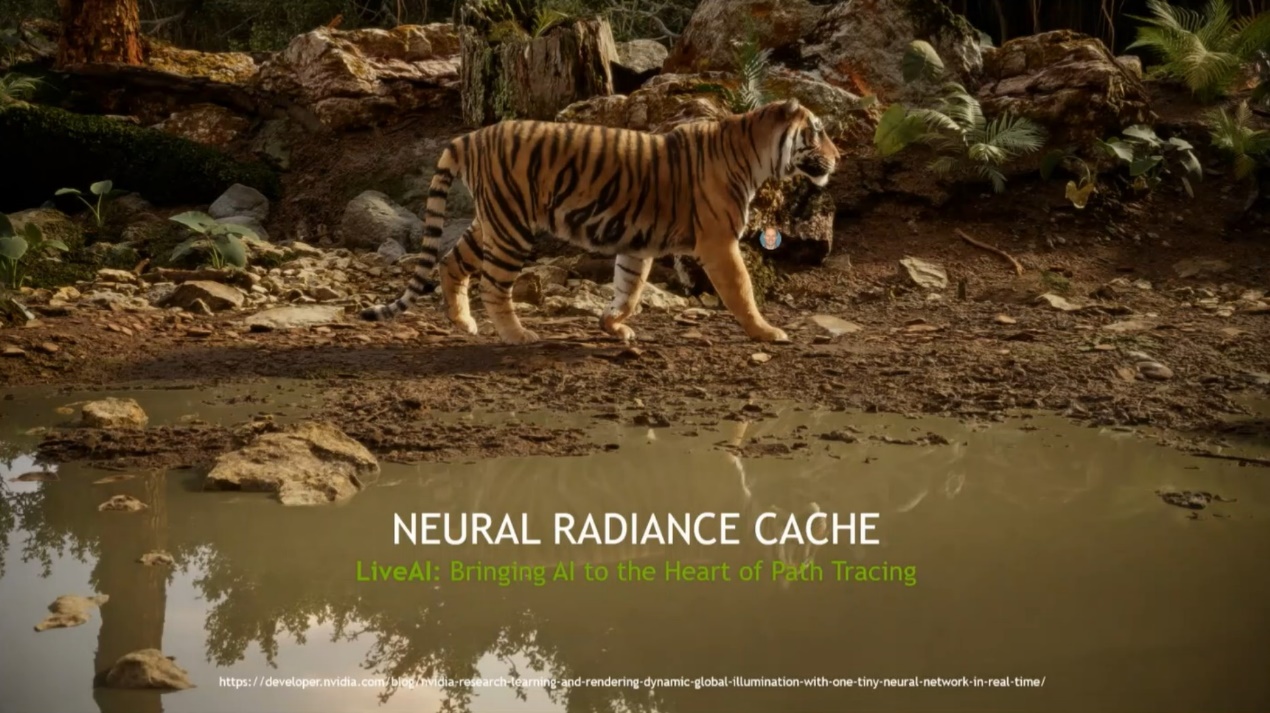

英伟达图形研究副总裁(Vice President of Graphics Research)Aaron Lefohn主要提到一种名为Neural Radiance Cache的渲染技术。Lefohn说此前英伟达在光线追踪技术上已经做了不少努力,包括ray trace shadows, ray trace ambient occlusion, ray trace reflection等。“光线追踪效果下一步是要走向,电影行业大约10年前就达成的,也就是path tracing(路径追踪)。”“Path tracing是完全统一的、光传输的物理模拟,而不再将其切分为单独的效果。任意光线反射,都和现实世界中一致的方式进行的。”

上面这张图的演示是开启和关闭Neural Radiance Cache的不同效果。在没有该特性的情况下,来自摄像头的光线进入场景中只反射(bounce)一次;而在启用该流程之后,老虎本体变亮了,这个场景进行了30次反射的光线模拟,老虎皮毛颜色亮度看起来也更自然。

感兴趣的同学可以去搜一搜这篇探讨Neural Radiance Cache的paper,这种技术的是估算整个场景的光分布,在场景中的对象和光移动的时候做动态更新。光照路径估算的数据结构用了AI,名为“LiveAI”,所以每一帧都实时执行AI inference。不知道对图形计算算力要求如何,估计这会成为一个近未来的技术,而且相当契合英伟达如今的GPU加入RT与Tensor核心的设定。

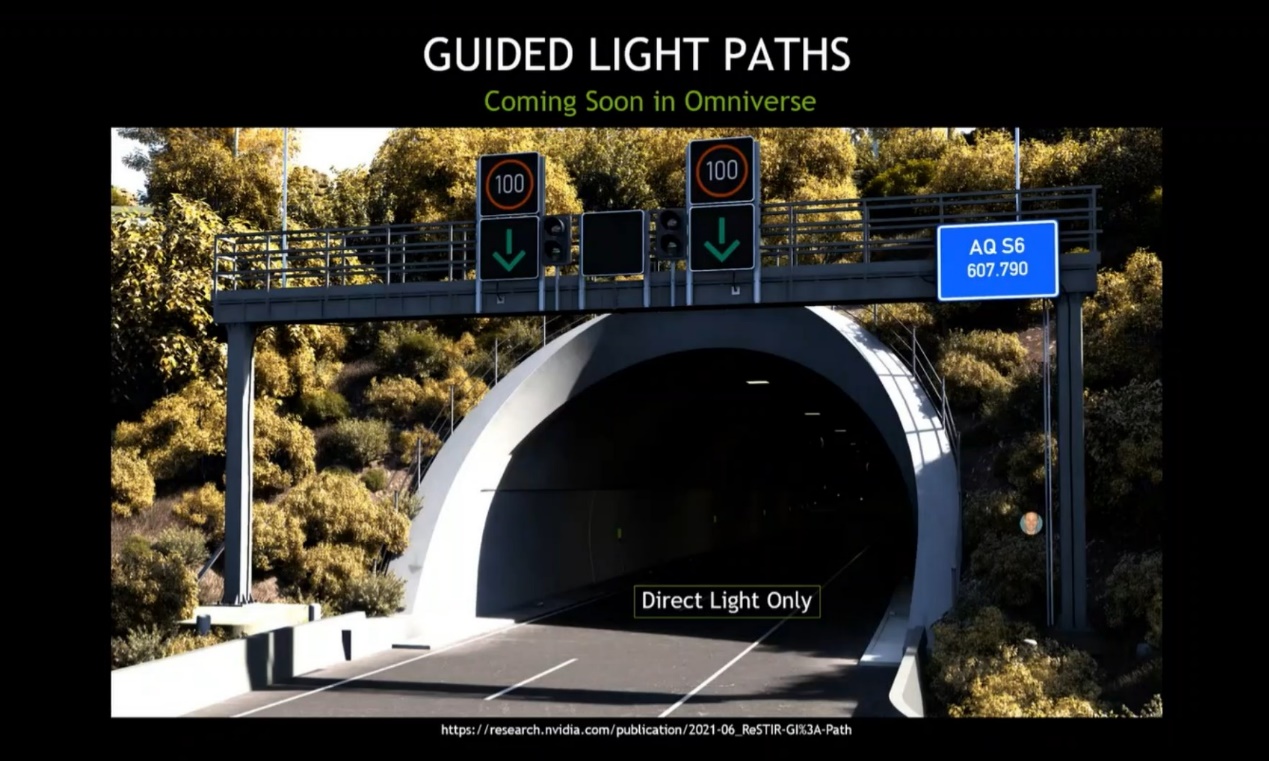

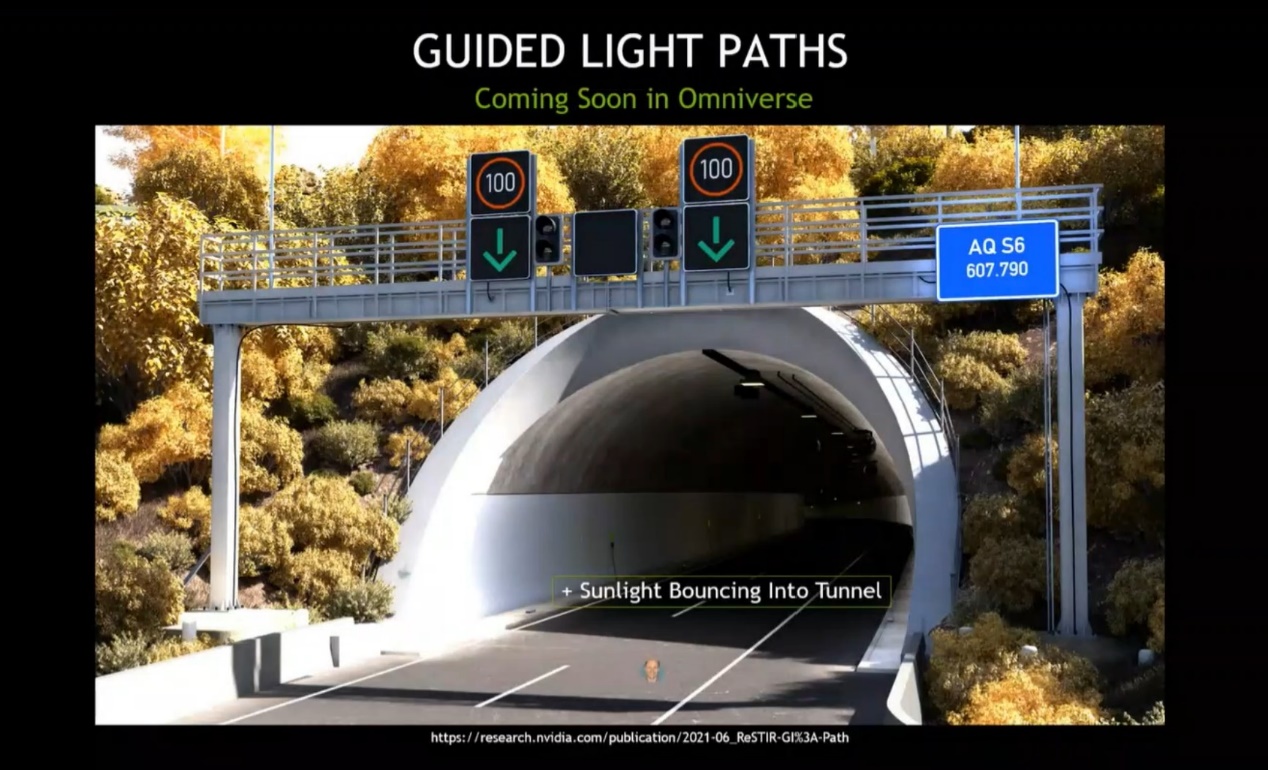

另一个例子的素材是来自英伟达的Drive Sim应用(面向自动驾驶汽车的一个模拟路测应用,现在也是Omniverse的一员)。上面这两张图的对比,可以看到外界阳光是否通过多次反射,进入到了隧道中。看起来也是个更精准模拟光反射的研究。不过Lefohn说反映这个例子的研究paper侧重点,在于“making the choice”。

这张图隧道外侧的道路是能够产生漫反射的坚硬平面,光线会有很多方向的反射。而这项技术着力的就是帮助做出反射方向的决策(guide light paths)。这个技术预计很快也会应用到Omniverse中。

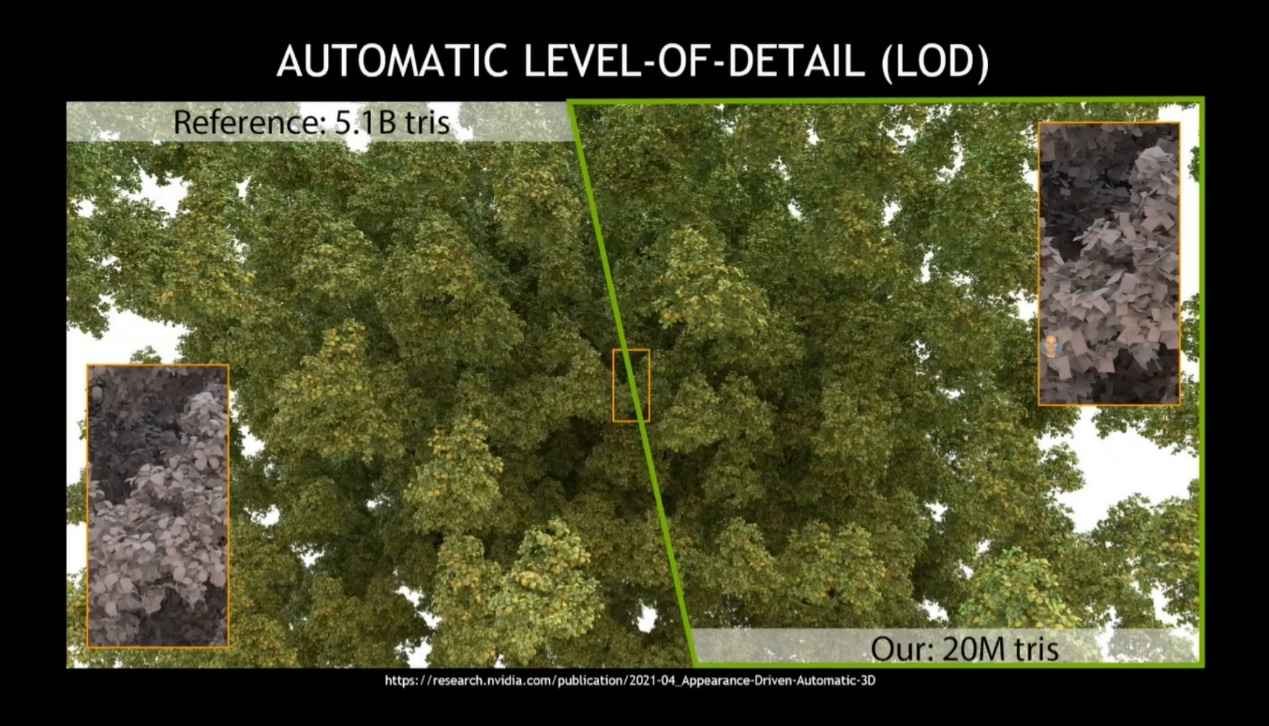

更多的例子还包括content creation方面,上图中左侧的灌木丛大约用到了50亿个三角形来实现;而英伟达这次发布的一篇新paper则采用对应技术将三角形减少到2000万,同时令其在相同距离看起来差别也并不大。这里面应该也用到了AI,结合了两套渲染机制。

还有比如材质(material)方面的研究成果,以往图形计算常规是平滑的材质,但实际上现实世界还有很多是所谓的有绒毛的材质(fuzzy materials),比如毛衣、地毯、草地。英伟达考虑用AI来学习fuzzy material材质的表征。Lefohn说这项研究的阶段还比较早期,期望未来能够用基于GAN的图像综合技术来生成这类材质,最终能够将其应用于实时渲染。

更多的研究成果这里就不再一一列举,其实还有Optimal Volumetric Visibility等方面的演示,以及提及去年在SIGGRAPH发的paper,今年就已经成为产品的RTX Direct Illumination。回看10年前的游戏与视觉创作,这些年的图形计算实现的效果丰富程度实在是太过琳琅满目,图形技术现在看起来仍在飞奔。

以上所有内容应当都可以在英伟达的开发者blog中找到,有兴趣的读者可前往查看,这里只做个简单的索引。

责编:Luffy Liu