大数据(big data)应用持续推动内存更密切结合运算资源的架构需求,但人工智能(AI)和机器学习更进一步展现了硬件和硬件架构如何在成功部署中发挥关键作用。然而,关键的问题在于内存应该要设计在哪里?

根据美光科技(Micron Technology)最近委托Forrester Research进行的研究发现,有89%的受访者认为运算和内存在架构上密切整合至关重要。Forrester Research的这项调查还发现,针对硬件限制使得AI与机器学习能力受限的讨论中,最常被提及的就是内存和存储技术。超过75%的受访者认为目前的内存与存储技术有必要进行升级或重新架构,才能突破应用上的限制。

特别是AI让大数据和分析原已面对的挑战更形复杂,因为机器学习经由神经网络在庞大的数据矩阵上执行乘积累加运算。这些运算不断地重复执行,伴随更多的结果出现,同时从数据处理中学习,最终产生一种每次都能达到最佳路径和最佳选择的算法。

美光科技企业策略副总裁Colm Lysaght说,由于数据越来越庞大,取得足够可用内存的常见解决方案就是增加更多的DRAM。这使得性能的瓶颈开始从原始运算转移到数据的所在位置。他说:“内存和存储正是数据所在之处。由于这些庞大的数据组合必须处理,我们只得一再地将其传送至CPU进行处理后返回。”

只要找到让运算和内存更紧密结合的方法,就意味着能够更加省电,因为数据不必再密集地来回传送了。Lysaght说,“它还提高了性能,因为更多的处理任务都可以在需要之处才发生。”

美光科技认为,诸如DRAM和3D NAND SSD等现有的内存和存储技术,为AI架构提供了可用硬件。该公司同时还研究其他更新的技术,例如许多新创公司也支持的内存处理器(PIM)架构(来源:Micron Technology)

Lysaght指出,“有许多不同的方法可以创建更好的架构。例如神经形态处理器,可在内部使用神经网络,并将内部核心数分解为更多的较小核心。他说:由于必须处理大量的资料矩阵,因此,更理想的解决方案是让更多核心周而复始地执行相对简单的运算。”

。

例如一家对开发新架构感兴趣的内存公司Crossbar最近与Gyrfalcon Technology、mtes Neural Networks (mtesNN)和RoboSensing等公司合作,共同成立了一个名为‘SCAiLE’(SCalable AI for Learning at the Edge)的AI联盟,致力于开发一款加速、节能的AI平台。

Crossbar策略营销和业务开发副总裁Sylvain Dubois表示,该联盟将结合先进的加速硬件、可变电阻式内存(ReRAM)以及优化的神经网络,共同打造具有免监督学习和事件辨识功能的节能解决方案。

Dubois表示,无论是智能音箱、智能相机还是智能电视,许多公司面临的挑战在于希望直接将AI导入装置上,但又不知道如何着手。该联盟的目标就在于提供一个将所有必要部份整合在一起的平台。

Crossbar的贡献在于内存——特别是ReRAM,它将透过文本、关键词、GPS坐标以及来自传感器的可视数据(非结构化)等各种输入,以处理在机器学习系统中产生的数据。

Dubois还设计了一种内存数组架构,让特定处理程序代码可在边缘装置中,以高度平行的方式针对每一个案例进行读取。他说:“如果彼此匹配,就会知道在边缘装置进行哪些处理。但如果无法顺利匹配,那么就成了我们所说的学习曲线。”

在云端执行更多分析

以相机传感器为例,他指出这种系统将会在ReRAM数组的备用位置存储新事件或一组功能。Dubois说:“等到下一次在这台相机面前出现类似的事件时,相机本身就能检测到,而无需在云端进行任何训练。”。

因此,Dubois表示,如果出现了需要快速决策的意外事件,例如具有安全顾虑的交通现场时,这提供了一种全然不同的AI处理途径,因为它并不必依赖于云端中的大量训练能力。

Forrester Research的研究预期,更多的公司将在公共云和边缘进行分析,从而在边缘实现更多的机器学习。51%的受访者表示目前在公共云执行分析,这一数字预计将在未来3年增加到61%。此外,尽管目前约44%的人开始在边缘进行分析,但Forrester预测,这一比重将在2021年增加到53%。

在为美光科技进行这项调查期间,Forrester基础设施和营运产业资深分析师Chris Gardner一开始对于硬件产品大量“涌现”的程度备感惊讶,特别是存储和内存。

Gardner说:“我本来预期会看到更多与硬件有关的软件可编程问题,以及管理等问题。当然,这些问题确实也出现了,但并不至于像其他事情的程度。”

Gardner表示,在该研究中衍生而出的是内存本身如何完成大量的工作,同时又尽可能避免进行存储。但值得注意的是,对于内存和存储的需求取决于实际的应用类型。据Gardner解释,训练模型需要相当庞大的内存和存储能力,除此之外,你几乎不需要其他任何东西。

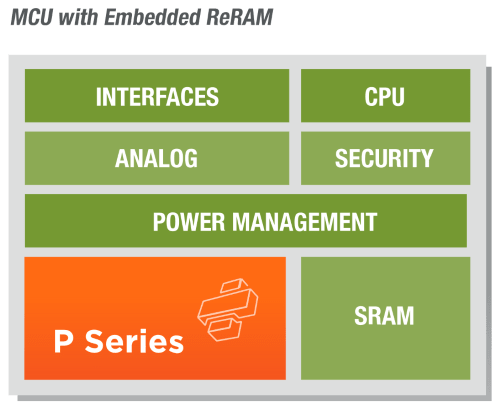

Crossbar最近成立了一个打造AI平台的联盟,提供针对AI应用的内存产品,例如其内建嵌入式ReRAM的P-Series MCU(来源:Crossbar Inc.)

Gardner说,理想上,企业希望拥有一个容量高达数百GB或TB级RAM的存储环境。但现实上,他们必须自行打造或付费给供货商协助打造,他并补充说,目前业界亟需的是整个硬件典范的转型。

Gardner说:“我们需要更多以内存为中心(memory-centric)的架构。”他进一步解释,运算需要以内存为中心,并尽量减少存储的必要性,而不再是以运算为中心。

Gardner说:“但这并不表示当今的运算架构及其存取方式很糟糕,而只是强调在执行AI和机器学习方面,它可能不是最有效率的方式。”

Forrester的研究内容还涵盖了边缘运算。应用场景之一是内部架设摄影机的主要运动场馆,这些摄影机将产生大量需要快速处理的资料,以确定场是否存在危险情况。Gardner说:“目前虽然可以来回云端传送资料,但并没时间进行分析。他们需要的是尽可能迅速地进行处理。”

当然还有一些机器学习任务得在云端中完成,再将其发送回物联网(IoT)装置,但其中的一些装置将会变得越来越智能并自行执行机器学习,接着传回云端共享后再传送到其他装置。Gardner表示,对于内存制造商来说,这意味着商品组件制造商正持续转型以及重新编译应用程序,以善加利用AI和机器学习工作负载所需的新式内存架构。

但我们如今仍处于实验阶段,因为还没有任何真正的张量(tensor flow)——使用以内存为中心的架构可以整合在一起;这种以内存为中心的架构要走出实验室之前还得克服很大的延迟挑战。

Gardner说:“几十年来,我们一直抱持着以CPU执行的心态。如今这种极具革命性的想法,将有助于我们摆脱这种心态。”

去年秋天,美光科技宣布投资1亿美元于AI新创领域。该公司如今已在实验室中开发了一款类似DRAM的产品,目标是在2021年出样,同时,该公司的研究人员也正致力于研究业界新创公司积极探索中的内存处理器(PIM)架构。

编译:Susan Hong

- Good