在2016年5月的I/O开发者大会上,谷歌首次向外透露了其机器学习专用芯片Tensor处理单元(TPU)。之后,谷歌除了公布它们是围绕公司自身进行优化的TensorFlow机器学习框架之外,就再未透露更多的细节。今天,这款机器学习定制芯片的神秘面纱终于被揭开了。

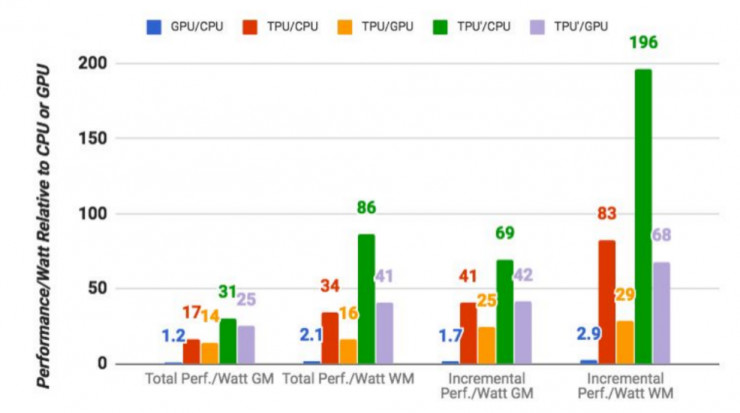

4月5日,谷歌资深硬件工程师Norman Jouppi刊文表示,谷歌的专用机器学习芯片TPU处理速度要比GPU和CPU快15-30倍(和TPU对比的是英特尔Haswell CPU以及Nvidia Tesla K80 GPU),而在能效上,TPU更是提升了30到80倍。

值得注意的是,这些数字是关于在生产中使用机器学习模型的,而不是首次创建模型。

从这次发布的测试结果来看,TPU似乎已经超出了业界的预期,但是藏在这一芯片背后的内部架构究竟有什么秘密呢,我们从Jouppi此前发布的论文当中,可以找到答案。

据了解,早在四年前,谷歌内部就开始使用消耗大量计算资源的深度学习模型,这对CPU、GPU组合而言是一个巨大的挑战,谷歌深知如果基于现有硬件,他们将不得不将数据中心数量翻一番来支持这些复杂的计算任务。

所以谷歌开始研发一种新的架构,Jouppi称之为“下一个平台”。Jouppi曾是MIPS处理器的首席架构师之一,他开创了内存系统中的新技术。三年前他加入谷歌的时候,公司上下正在用CPU、GPU混合架构上来进行深度学习的训练。

Jouppi表示,谷歌的硬件工程团队在转向定制ASIC之前,早期还曾用FPGA来解决廉价、高效和高性能推理的问题。但他指出,FPGA的性能和每瓦性能相比ASIC都有很大的差距。他解释说,“TPU可以像CPU或GPU一样可编程,它可以在不同的网络(卷积神经网络,LSTM模型和大规模完全连接的模型)上执行CISC指令,而不是为某个专用的神经网络模型设计的。一言以蔽之,TPU兼具了CPU和ASIC的有点,它不仅是可编程的,而且比CPU、GPU和FPGA拥有更高的效率和更低的能耗。

TPU的内部架构

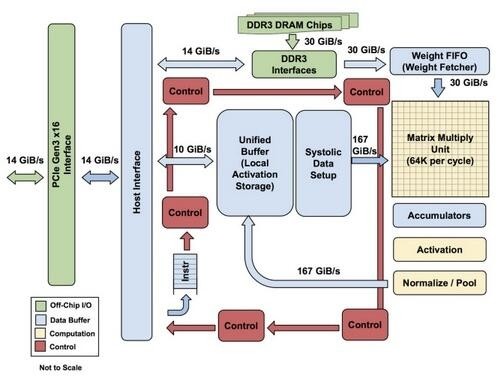

该图显示了TPU上的内部结构,除了外挂的DDR3内存,左侧是主机界面。指令从主机发送到队列中(没有循环)。这些激活控制逻辑可以根据指令多次运行相同的指令。

TPU并非一款复杂的硬件,它看起来像是雷达应用的信号处理引擎,而不是标准的X86衍生架构。Jouppi说,尽管它有众多的矩阵乘法单元,但是它GPU更精于浮点单元的协处理。另外,需要注意的是,TPU没有任何存储的程序,它可以直接从主机发送指令。

TPU上的DRAM作为一个单元并行运行,因为需要获取更多的权重以馈送到矩阵乘法单元(算下来,吞吐量达到了64,000)。Jouppi并没有提到是他们是如何缩放(systolic)数据流的,但他表示,使用主机软件加速器都将成为瓶颈。

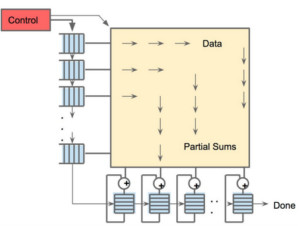

256×256阵列缩放数据流引擎,经过矩阵乘法积累后实现非线性输出

从第二张图片可以看出,TPU有两个内存单元,以及一个用于模型中参数的外部DDR3 DRAM。参数进来后,可从顶部加载到矩阵乘法单元中。同时,可以从左边加载激活(或从“神经元”输出)。那些以收缩的方式进入矩阵单元以产生矩阵乘法,它可以在每个周期中进行64,000次累加。

毋庸置疑,谷歌可能使用了一些新的技巧和技术来加快TPU的性能和效率。例如,使用高带宽内存或混合3D内存。然而,谷歌的问题在于保持分布式硬件的一致性。

TPU对比intel Haswell CPU

在和英特尔“Haswell”Xeon E5 v3处理器来的对比中,我们可以看到,TPU各方面的表现都要强于前者。

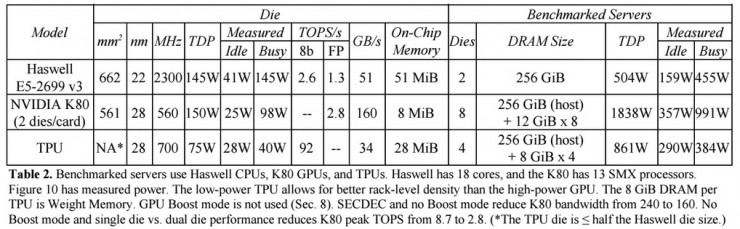

在Google的测试中,使用64位浮点数学运算器的18核心运行在2.3 GHz的Haswell Xeon E5-2699 v3处理器能够处理每秒1.3 TOPS的运算,并提供51GB/秒的内存带宽;Haswell芯片功耗为145瓦,其系统(拥有256 GB内存)满载时消耗455瓦特。

相比之下,TPU使用8位整数数学运算器,拥有256GB的主机内存以及32GB的内存,能够实现34GB/秒的内存带宽,处理速度高达92 TOPS ,这比Haswell提升了71倍,此外,TPU服务器的热功率只有384瓦。

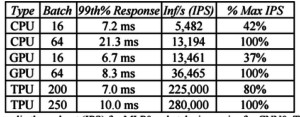

除此之外,谷歌还测试了CPU、GPU和TPU处理不同批量大小的每秒推断的吞吐量。

如上图所示,在小批量任务中(16),Haswell CPU的响应时间接近7毫秒,其每秒提供5482次推断(IPS),其可以实现的最大批量任务(64)每秒则可以完成13194次推断,但其响应时间为21.3毫秒。相比之下,TPU可以做到批量大小为200,而响应时间低于7毫秒,并提供225000个IPS运行推理基准,是其峰值性能的80%,当批量大小为250,响应时间为10毫秒。

不过需要注意的是,谷歌所测试的Haswell Xeon处理器似乎也不能完全说明问题,英特尔Broadwell Xeon E5 v4处理器和最新的“Skylake”Xeon E5,每核心时钟(IPC)的指令比这款处理器提升了约5%。在Skylake是28核,而Haswell为18核,所以Xeon的总体吞吐量可能会上升80%。当然,这样的提升与TPU相比仍有差距。

最后需要强调的是,TPU是一个推理芯片,它并非是要取代GPU,可以确定的是,TPU与CPU一起使用对训练分析更加有益。但对于CPU制造商而言,如何研发出像ASIC一样兼顾性能和能效的芯片是现在以及未来要做的。

Jouppi表示谷歌TPU已经开始出货,而英特尔这些芯片商也将面临更大的挑战。

关注最前沿的电子设计资讯,请关注“电子工程专辑微信公众号”。

- 在中国20多年的天津三星电子正式注销,裁员跟着就来 9月9日,爱企查App显示,天津三星电子有限公司的经营状态由存续变更为注销。

- 华夏芯域名、专利等资产公开拍卖 拍卖标的包括三项域名以及15项软件著作权和14项专利。其中,三项域名的起拍价为13879元,15项软件著作权和14项专利的起拍价为15550元……

- 传音控股CFO肖永辉被立案调查 根据通知书内容,因某种未具体披露的原因,丹东市振安区监察委员会决定对肖永辉采取留置措施,并对其立案调查。此消息一出,立刻引起了市场的广泛关注。

- 传台积电9月底前低价引进High-NA EUV设备,价格远低于3.5亿欧元 值得一提的是,台积电此次购入价格可能远低于原定的3.5亿欧元的单台报价。ASML同意以折扣价向台积电出售High-NA EUV设备的原因主要是因为台积电是其超级VIP客户,ASML给予了很大的让步。

- 苹果发布iPhone 16系列、AirPods 4及Apple Watch Series 10等新品 9月10日,苹果发布了一系列新品,包括iPhone 16系列手机、Apple Watch Series 10智能手表和AirPods 4耳机。发布会后网上响起了一片吐嘈声,带着这些吐槽,我们来看看这次苹果到底有没有新玩意……

- 传台积电美国晶圆厂试产良率媲美台湾南科厂 自台积电宣布在美国亚利桑那州建设首座晶圆厂以来,该项目就备受瞩目。在台积电美国厂建厂期间也传出不少质疑的声音。近日,有关台积电在美国亚利桑那州的晶圆厂传出试产新进展,新厂4月工程晶圆试产良率媲美台湾南科厂,该消息再次引发了业界的高度关注......

- 全球折叠屏手机快速增长,中国品牌压 • 得益于西欧、关键亚洲市场和拉丁美洲市场的增长,以及中国品牌的持续领先,全球折叠屏手机出货量在2024年第二季度同比增长了48%。 • 荣耀凭借其在西欧特别强劲的表现,成为最大的贡献者,成为该地区排名第一的品牌。 • 摩托罗拉的Razr 40系列在北美和拉丁美洲表现良好,为其手机厂商的出货量贡献了三位数的同比增长。 • 我们预计,头部中国手机品牌厂商的不断增加将至少在短期内抑制三星Z6系列在第三季度的发布。

- AI网络物理层底座: 大算力芯片先进 AI技术的发展极大地推动了对先进封装技术的需求,在高密度,高速度,高带宽这“三高”方面提出了严苛的要求。

- 奕斯伟计算DPC 2024:发布RISAA(瑞 奕斯伟计算2024首届开发者伙伴大会以“绿色、开放、融合”为主题,从技术创新、产品应用、生态建设等方面,向开发者、行业伙伴等相关方发出开放合作倡议,加速RISC-V在各行各业的深度融合和应用落地,共同推动RISC-V新一代数字基础设施生态创新和产业发展。

- 重磅发布:Canalys 2024年中国云渠道 2024年 Canalys 中国云计算渠道领导力矩阵冠军厂商分别是:阿里云、华为云和亚马逊云科技(AWS)

- 全球第三!全球高端手机市场,华为猛涨80%,苹果坠落正拉开帷幕! 在全球智能手机竞争日益激烈的情况下,谁能在高端市场站稳脚跟,谁就占据了主动权。一直以来全球智能手机市场格局都是,苹果专吃高端,其他各大厂商分食全球中低端市场。但现在市场正在其变化。根据Canalys最

- 路特斯的努力有多“韧性” 文|沪上阿YI路特斯如今处在一个什么样的地位?吉利控股集团高级副总裁、路特斯集团首席执行官冯擎峰一直有着清晰的认知:“这个品牌的挑战依然非常大。首先,整个中国市场豪华汽车整体数据下滑了30%~40%,

- 在成都寻“金”,那可是来对地方了 文|德福很多去成都旅游的朋友都有个疑惑——为什么在成都官方的城市标志上看不到熊猫,而是一个圆环?其实这个“圆环”大有来头,它被唤作太阳神鸟,2001年出土于大名鼎鼎的金沙遗址,距今已有三千余年历史。0

- 2.4亿美元!“果链”捷普科技在印度设厂! 周二,捷普科技(Jabil)官员与印度泰米尔纳德邦代表团在泰米尔纳德邦首席部长MK Stalin的见证下,签署了一份备忘录。MK Stalin正在美国进行为期17天的访问,旨在吸引新的投资。MK St

- 大力拓展半导体行业-节卡复合机器人有何优势? 会议预告向世界展示中国最具创新力、领导力和品牌化的产品与技术!9月27号,“第6届国际移动机器人集成应用大会暨复合机器人峰会”将在上海举行,敬请关注!逐个击破现有痛难点。文|新战略半导体行业高标准、灵

- 上半年SiC汽车中国销售近110万辆,供应商有哪些? 近日A股上市公司陆续完成2024年上半年业绩披露,其中24家SiC概念股上半年合计营收同比增长14.58%至1148.65亿元,研发费用同步增长7.22%至69.16亿元。尤为值得注意的是,天岳先进、

- 60%汽车供应商裁员! 疫情后的劳动力囤积和强有力的员工保护规则掩盖了德国高薪制造业工作市场令人担忧的变化。根据联邦劳工办公室的数据,欧元区最大经济体德国的失业率在2019年春季曾达到历史最低点4.9%,现已上升至6%。虽然

- 突发!三星印度厂工人大规模罢工! 9月11日消息,根据外国媒体报道,位于印度清奈的Sriperumbudur工厂三星电子工厂的员工发起了无限期罢工,要求提高工资并改善工作时间。此次罢工涉及大约2000名工人,导致工厂的日产量大约减少了

- 活动邀请|华强电子产业研究所诚邀您莅临2024深圳跨境电商展览会 展位信息深圳跨境电商展览会(CCBEC)时间:2024年9月11-13日 9:30-17:30地点:深圳国际会展中心(宝安)展馆:16号馆 16D73/16D75 展位报名注册准备好“观众注册”入场二

- 下线、投产...这3个电驱动项目传最新进展 近日,3个电驱动项目迎来最新进展,包括项目量产下线、投产、完成试验等,详情请看:[关注“行家说动力总成”,快速掌握产业最新动态]青山工业:大功率电驱项目下线9月5日,据“把动力传递到每一处”消息,重庆