人工智能的原则是一种自上而下的人工智能(AI)伦理学方法。最近,人工智能伦理学的原则清单到处出现。它们非常有用,不仅对人工智能及其影响,而且在更大的社会层面上也是如此。因为人工智能,人们正在以一种全新的方式思考伦理问题。上次,我们讨论了《支持和反对人工智能伦理的理由》,本文将讨论人工智能原则,作为一种自上而下的方法来努力实现符合伦理的人工智能。

伦理的人工智能原则

原则可以分为两类:为人工智能系统编程的人遵守的原则,以及人工智能本身的原则。

一些针对人的原则,主要是程序员和数据科学家,读起来就像戒律。例如,道德人工智能和ML研究所有一个面向技术专家的八条原则清单。这些原则包括:人力增强,让人参与其中;偏见评估,持续监测偏见;可解释性和理由,提高透明度;可重复性,确保基础设施可合理重复;转移战略,减轻自动化对工人的影响;实用准确性,与特定领域的应用保持一致;隐私信任,保护和处理数据;以及数据风险意识,考虑数据和模型安全。(道德人工智能和机器学习研究所)

负责任的机器学习原则:

- 人工增援

- 偏见评估

- 可解释性和合理性

- 可重复性

- 置换策略

- 实用的准确性

- 隐私的信任

- 数据风险意识

其他的原则清单是针对人工智能系统本身的道德规范以及它们应该遵守的内容。其中一个清单包括四项原则,由美国国家标准与技术研究所(NIST)发布,旨在促进可解释性。其中第一条是关于解释的:一个系统可以为其过程和输出提供证据和理由,可以被人类阅读,并解释其算法。其余三条在此基础上展开。第二条建议人工智能系统必须是有意义的和可理解的,并有方法来评估无意义。第三条原则是解释的准确性:一个系统必须正确反映其生成的输出的原因。最后第四条是知识限制:确保系统只在其设计的条件下运行,并且在其有限的知识领域不给出过于自信的答案;例如,一个被编程为鸟类分类的系统被用来对苹果进行分类。(Marengo, 2021)

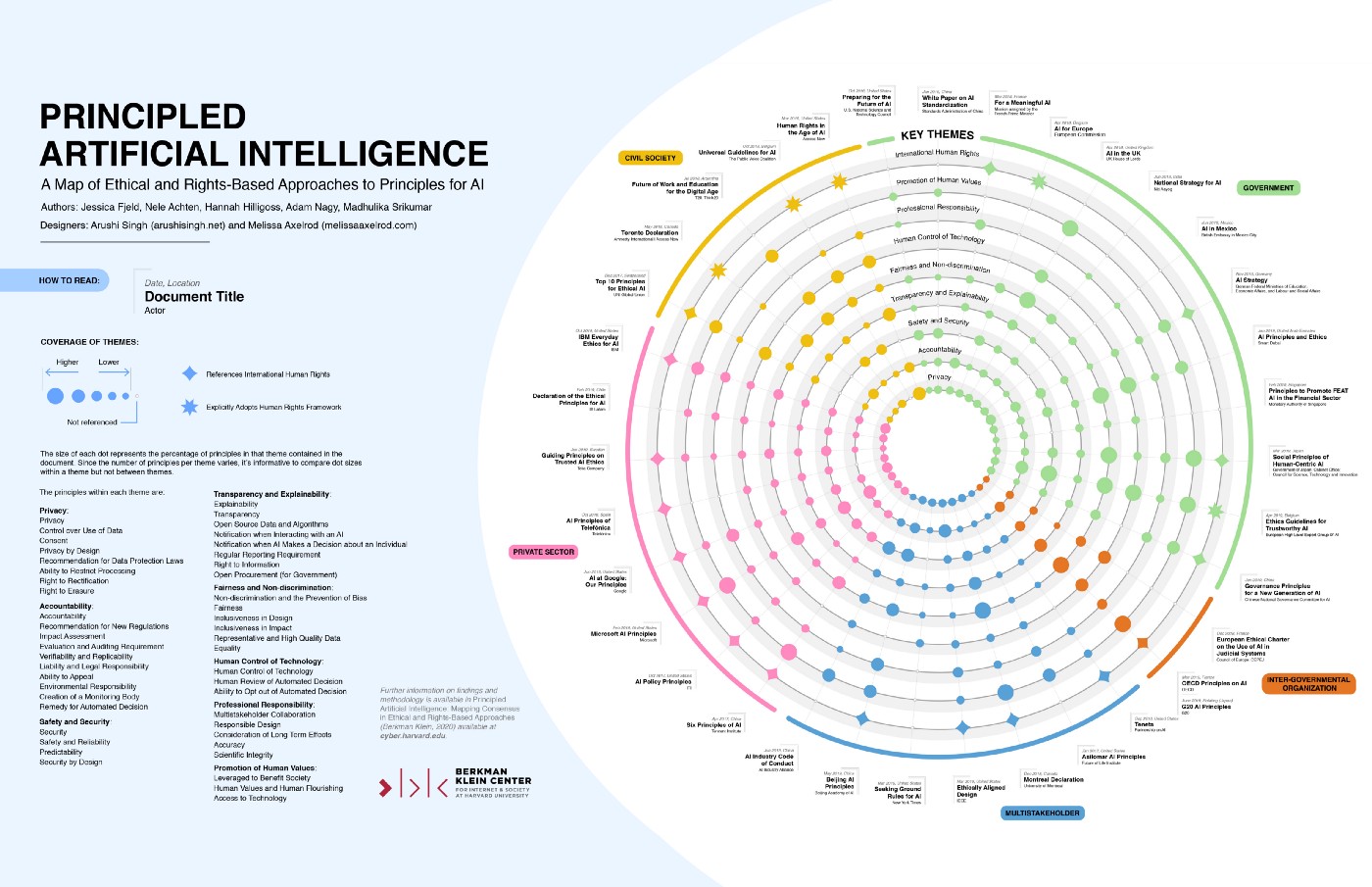

许多原则在不同的公司和机构之间是重叠的。我们可以看到哈佛大学伯克曼-克莱因互联网和社会中心发布的详细图表和信息,在这里可以找到。这对各种组织、公司和其他实体正在采用的四十七项原则、它们重叠的地方以及它们的定义做了一个很好的概述。

来源:https://cyber.harvard.edu/publication/2020/principled-ai

作者提供了许多关于人工智能伦理原则的清单和描述,并将其归类为八个主题趋势。隐私、责任、安全和保障、透明度和可解释性、公平和非歧视、人类对技术的控制、职业责任和促进人类价值。(Fjeld and Nagy, 2020)

伦理人工智能的幻觉

我认为这些清单中缺少一项特别的原则,即照顾非人类世界。正如博丁顿在她的《迈向人工智能的道德准则》(2018)一书中所说:"......我们正在改变世界,人工智能将加速这些变化,因此,我们最好对哪些变化算好的,哪些算坏的有一个概念。" (Boddington, 2018)我们都会对此有不同的看法,但这需要成为讨论的一部分。我们不能在试图创造超级人工智能的同时继续破坏地球,还幻想着我们的道德原则正在拯救世界。

这也将是一个警示故事,因为很多这些原则在理论上是合理的,但却像一层面纱,呈现出道德的幻觉。这可能是危险的,因为它让我们觉得我们正在实践道德,而业务却照常进行。造成这种情况的部分原因是,道德人工智能发展领域是如此之新,还没有进行大量的研究,以确保整体影响是对社会有益的。"尽管这些'人工智能原则'层出不穷,但学术界很少关注对这些努力的理解,无论是单独的还是在不断扩大的原则宇宙中的背景,都有明显的趋势。" (Fjeld and Nagy, 2020)

原则是一枚双面的硬币。一方面,做出明确的努力来遵循一系列的道德原则是好的。人们思考如何做正确和符合道德的事情,而不是盲目地输入可能以不可预见的方式造成损害的代码,这是有好处的。

有些原则表面上很简单,但在实践中却具有难以置信的挑战性。例如,如果我们看一下普遍采用的透明度原则,说算法和机器学习应该是可解释的,和实际开发的方法可以看到黑盒子的内部,这之间有很大的区别。随着数据集越来越大,这带来了越来越多的技术挑战。(Boddington, 2018)

此外,一些原则可能会相互冲突,这可能会使我们陷入一个比我们开始时更不道德的地方。例如,透明度可能与另一个流行的原则--隐私相冲突。围绕这一点,我们可能会遇到很多复杂的问题,我希望在我们前进的过程中看到这个问题得到迅速和彻底的解决。

总的来说,我们希望这些概念在人们的头脑中:如公平。问责制,和透明度。这些是FAACT会议的核心宗旨和名称,该会议深入探讨了这些原则。对于企业和程序员来说,关注普遍涉及的偏见、歧视、压迫和系统性暴力等主题是极其重要的。然而......可能发生的情况是,这些原则让我们觉得我们在做正确的事情,然而,写出这些理想,实际上能改变多少事情?

我们需要的人工智能伦理革命

为了使人工智能符合道德规范,很多东西都必须改变,而且不仅仅是在技术领域。人们似乎忽略了一些不为人知的原则:对于企业和当权者来说,金钱的价值,以及对于那些有能力的人来说,便利性。如果我们试图在人工智能中创造公平、问责和透明,我们需要对社会做一些严肃的工作,将我们的核心原则从金钱和便利调整到照顾每个人的基本需求和地球。

人工智能能否成为一种工具,它的副作用是启动一场伦理学革命?

我们如何实现这一目标?我们使用的语言很重要,尤其是在涉及到原则的时候。莫斯和梅特卡夫指出了使用市场友好型术语的重要性。如果我们想让道德胜出,我们需要证明必要的组织资源,而更多时候,公司会选择利润而不是社会公益。(Moss and Metcalf, 2019)

Whittlestone等人描述了需要关注人工智能中伦理的紧张领域,并指出了 "公平"、"正义 "和 "自治 "等术语的模糊性。作者促使我们质疑这些术语在不同群体和背景下可能有不同的解释。(Whittlestone et al. 2019)

他们继续说,为了在实践中发挥作用,需要将原则正式化为标准、守则,并最终成为法规。他们提请注意承认道德的高层次目标之间的紧张关系的重要性,这些目标可能不同,甚至相互矛盾。为了有效,必须包括对如何解决不同情况的某种程度的指导。为了体现真正的协议,必须尽可能地承认和包容不同的观点和价值观。(Whittlestone et al. 2019)

然后,作者介绍了讨论紧张关系对人工智能伦理学有益且重要的四个原因:

- 缩小原则与实践之间的差距

- 承认价值观的差异

- 突出需要新解决方案的领域

- 识别模糊不清的地方和知识差距

每一项都需要持续考虑,因为这些紧张关系不是一夜之间就能解决的。特别是,在实践中建立原则之间的桥梁是很重要的,正如我在上面所论证的。

作为总结,我将分享这段直接引用的话,因为它令人难以置信地深刻。

"我们需要在使我们的道德推理尽可能强大的要求与防止使其过于僵化和通过拒绝任何我们不能立即解释的东西而将道德婴儿与洗澡水一起扔掉之间进行平衡。这一点与起草道德准则和在机器中实现道德推理的尝试都有很大关系。" (Boddington, 2018 p.18-19)

总之,伦理守则,或人工智能的伦理原则是很重要的,我喜欢因为它们的存在而开始的对话。然而,它不能止于此。我很高兴看到越来越多的方式将这些原则付诸行动,并看到技术专家和理论家一起研究如何使它们发挥作用。我也希望我们能够打开思路,超越为企业赚钱和创造便利的想法,而是朝着解决紧张关系和真正创造一个为每个人服务的世界的方向发展。

参考

ACM公平、问责和透明会议(ACM FACCT)。ACM FAccT. (2021). 2022年1月7日,检索到https://facctconference.org/

艾氏原则. Future of Life Institute. (2021年,12月15日)。2021年12月30日检索,来自https://futureoflife.org/2017/08/11/ai-principles/

Berkman Klein Center Media Library. (n.d.). 2022年1月8日检索,来自https://wilkins.law.harvard.edu/misc/

Boddington, Paula. (2018). Towards a code of Ethics for Artificial Intelligence. Springer international pu.

Fjeld , J., & Nagy, A. (2020). 有原则的人工智能. Berkman Klein Center. 2021年12月30日,从https://cyber.harvard.edu/publication/2020/principled-ai。

Marengo, F. (2021). Federico Marengo on linkedin: 可解释的人工智能的四个原则:35条评论。LinkedIn。2022年1月7日检索,来自https://www.linkedin.com/posts/fmarengo_four-principles-of-explainable-ai-activity-6878970042382356480-updf/

Moss , E., & Metcalf, J. (2019, November 14). 大科技公司核心的道德困境。哈佛商业评论》。2021年12月13日检索,来自https://hbr.org/2019/11/the-ethical-dilemma-at-the-heart-of-big-tech-companies。

Ethical Ai & Machine Learning研究所。(n.d.). 机器学习原则。负责任地开发人工智能和机器学习系统的8项原则。2021年12月30日检索,来自https://ethical.institute/principles.html

Whittlestone, J., Cave, S., Alexandrova, A., & Nyrup, R. (2019). 人工智能伦理学中原则的作用和限制。Towards a ... 2021年12月13日检索,来自http://lcfi.ac.uk/media/uploads/files/AIES-19_paper_188_Whittlestone_Nyrup_Alexandrova_Cave.pdf。