王瑞哲 资深研发工程师,中国芯片设计中心

刘磊 电院微纳电子系,上海交通大学

孟超 高级设计经理,中国芯片设计中心

李晴 总监,中国芯片设计中心

随着现代社会信息量的爆炸式增长,越来越多的存储器和AI计算被用来进行信息的存储和运算。然而,即便是算力强大的云端计算,也很难完全满足数据带宽和传输速度的需求,加上人们对于数据隐私保护的重视程度不断提高,在这种现状下,边缘AI计算就成为了突破口,它能够在大数据时代助力人们的生产生活。而边缘计算中非常重要的一个部分就是嵌入式存储器。本文就来介绍一下边缘AI与嵌入式存储器是如何帮助实现大数据网络中的计算。

什么是边缘AI计算

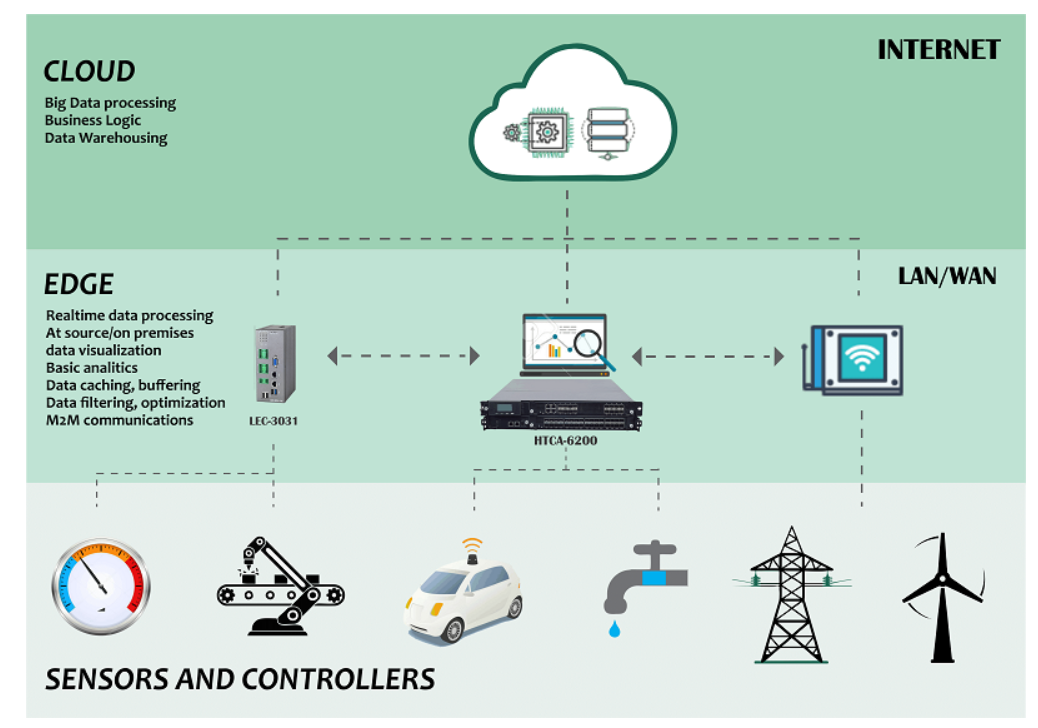

边缘计算 (edge computing) 是一种将数据计算靠近数据源头的新型计算模型。相较于云计算(cloud computing) 的云端服务器大数据计算不同,边缘计算不需要将数据上传到云端设备,而是直接在靠近数据源的设备端或者边缘端进行计算。边缘计算考虑的更多是如何能够将一些基本运算移至边缘终端设备,来节省设备的功耗,提高数据的时效性和用户隐私保护等。

图1. 边缘AI与云端AI之间的计算架构模型和关系ref[1]

边缘AI(edge AI)则是边缘计算的进一步发展。依托于云端服务器数据计算能力的飞速提升,人工智能和机器学习取得了巨大进步,发展出更具综合性的人工神经网络。在大数据时代,每天都会产生海量的信息需要分析处理,随着机器学习、神经网络训练等网络架构和工具不断的适配和兼容到嵌入式系统上,越来越多的AI应用也可以直接在边缘设备运行,于是“边缘AI”成为了当下讨论和研究的热点。

边缘AI是指在本地硬件设备上处理的AI算法,可以在没有网络连接的情况下进行数据处理。为了实现这一目标,边缘计算在云端通过深度学习进行训练生成神经网络的权重,而在产生数据的设备本身(边缘)执行模型的推断和预测。目前,各大厂商已经开始在相关领域进行探索。谷歌、亚马逊和微软等传统云服务提供商推出了边缘人工智能服务平台,通过在终端设备本地运行预先训练好的模型进行机器学习推断,将智能服务推向边缘。很多公司都在着手进行研究,市场上也已经出现多种边缘人工智能芯片。

边缘AI计算的优势

随着物联网和智能设备井喷式的应用,智能手机,智能家电,智能汽车以及可穿戴设备已经逐渐融入到物联网中,在终端运行的过程中,这些智能设备会产生海量的数据。但是现有云端计算的带宽以及计算资源还不能实时有效的处理这些数据,而且上传到云端也会出现数据丢失以及泄露的隐患。同时终端设备在发送和接受无线信息时,会消耗大量的能量。这限制了电池供电的终端设备的大规模部署,也增加了维护的成本,不利于物联网的应用和普及。因此,很多行业的大数据以及AI设备,开始逐步从以云计算为中心的集中式处理,转入以万物互联为核心的边缘计算处理。通过减少在云端之间的数据互传,增强了数据实时更新、及时处理和分析的能力,补充和优化了云端设备在计算链条中所占比重,实现了计算效能利用的最大化。

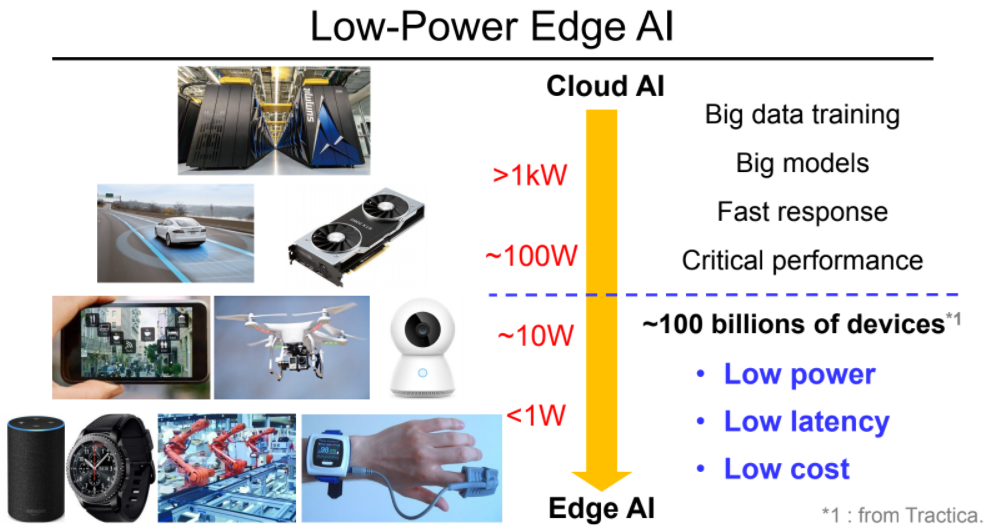

图2. 边缘AI可以提供比云端AI技术更低的功耗、延时和成本ref[2]

边缘AI计算相对于云计算有以下几方面优势:

第一,边缘AI计算能够更好的解决带宽问题。无需将大量数据上传到云端,只是处理部分产生的临时数据,将会大幅降低网络带宽的负荷并降低网络传输的功耗。

第二,边缘AI计算可以降低系统和数据的延迟。通过在设备端进行数据处理,可以极大程度的减少系统的延时,提升指令的响应时间。例如,智能汽车在紧急情况下,通过车载传感器来接收信号进行处理分析并作出响应,这样信号的处理更接近信号来源,而非在云端或者外部处理器进行,从而减少数据延迟并做出快速响应。

第三,边缘AI计算还可以实现用户隐私的保护。隐私数据不需要上传到云端,可以免于黑客攻击以及网络病毒等影响,提升了数据的安全性。如智能门锁的密码信息、智能摄像头的监控信息、智能穿戴设备中的个人健康数据以及语音助手的对话信息等。

边缘AI计算与嵌入式存储器

存储器是计算机架构里非常重要的一环,Edge devices和边缘AI计算也需要先进存储技术的加持和推动。下面就来介绍一下边缘AI计算和嵌入式存储器的关系。

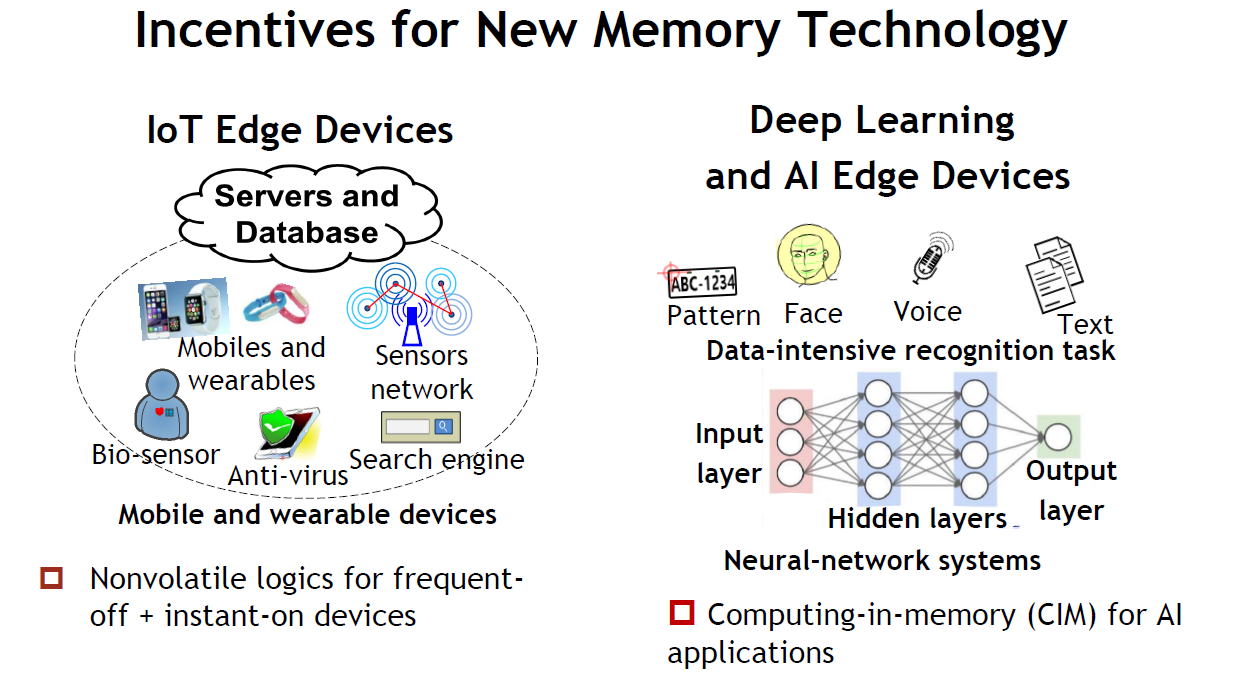

图3. 随着IoT设备和边缘AI计算的发展,新型存储技术多场景应用ref[3]

边缘AI计算在低带宽、低延时、保护隐私等方面具有较大优势,但同时也面临着一些挑战,如功耗问题以及权重的存储。在工业物联网、机器人、可穿戴设备、智能汽车等应用中,边缘计算的使用日益增加。终端设备需要不断收集数据,在云端训练和更新权重后再将权重返回到终端。随着这种需求的增加,程序存储和数据备份等应用也越来越需要高速、低延迟、非易失性、低功耗、低成本的存储器来实现数据记录。

终端设备的数据记录一般需要数兆比特大小的存储器,以容纳长期积累的数据。并且记录器通常由电池供电,因此需要低功耗存储器。另外系统待机和断电时,记录的数据可无限期保留,因此需要非易失性存储器(NVM)。

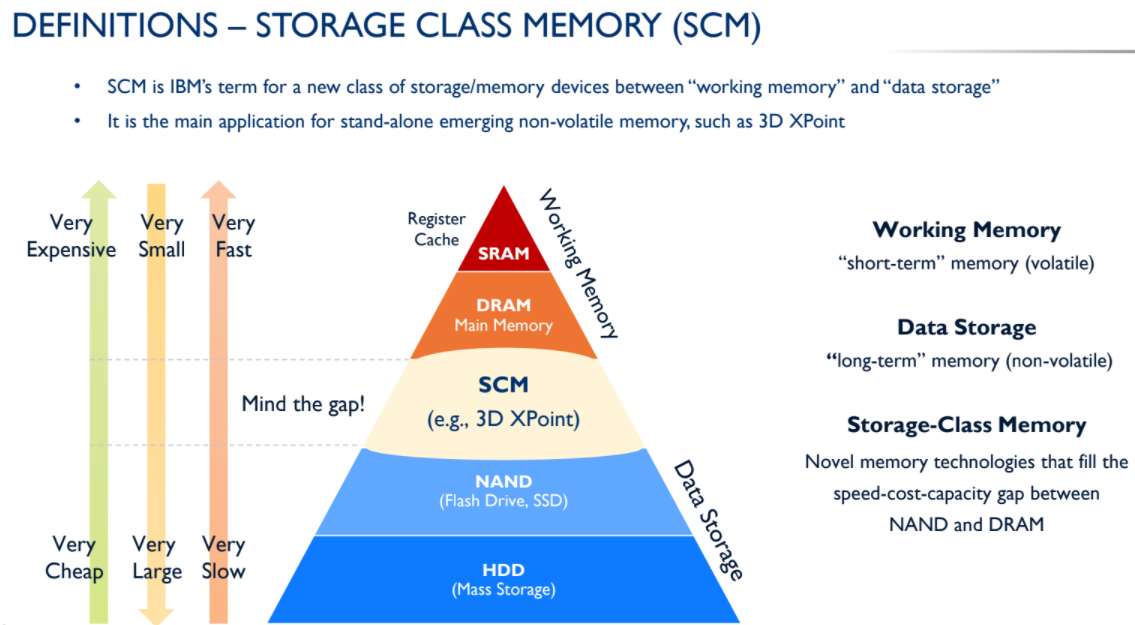

图4. NVM在成本、面积和速度达到平衡,填补Memory和Storage空白ref[4]

对于这些要求,非易失性存储器中的磁阻式随机访问存储器MRAM就可以比较好地满足。对于边缘AI,在不要求高性能的应用中,MRAM能以较低的电压运行,提高能效。由于IoT设备和可穿戴设备很多都是电池供电 ,所以需要存储器功耗更低,漏电更小,格芯的MRAM采用了22FDX的工艺,功耗低,具备深度睡眠模式(Deep Sleep Mode),可以减小漏电,极大程度地提升终端设备的待机时间;Data Retention高,能够更长时间的正确保存数据,能够在比较极端的温度条件(-40℃~125℃)下正常工作;存取时间短,能实现快速读取数据。此外与External Memory相比,嵌入式MRAM可以减少PCB面积,减少成本。

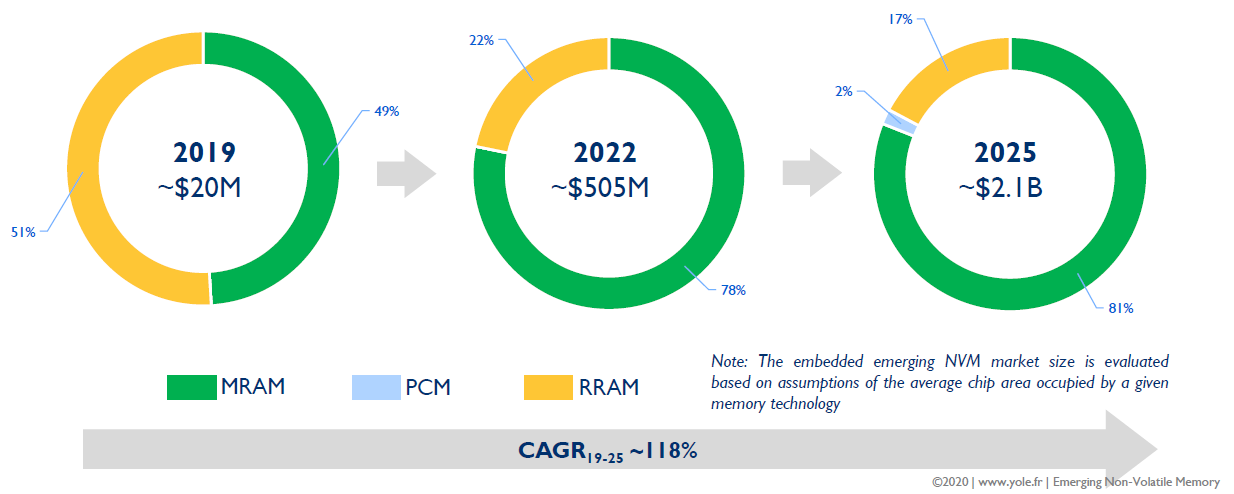

图5. MRAM从2019年到2025年,在嵌入式市场份额中增进和演变ref[4]

边缘AI中的近存计算

为了进一步更好地实现边缘AI,减少数据传输带来的功耗和延时,就需要将内存和计算单元的物理距离减小。由于数据搬运产生的能耗和延时变小,所以也相应的提高效率,减小了能耗和延时的不利因素,因此,近存计算也就应运而生。

近存计算,顾名思义,是让数据在存储侧就近完成计算。这就需要计算单元和存储单元距离更近,这不仅降低了计算节点的CPU和内存的负荷,也大大缓解了网络传输的负载,大幅降低应用的响应延迟,为基于数据中心的大数据和人工智能等涉及大数据量处理的应用优化提供了新的解决方案。

近存计算其中可以应用的一种方法就是高带宽存储器HBM 2.5D封装技术。这种2.5D封装技术,可以把多个小芯片封装到一个基板上,这项技术有许多优点,主要优势是带来更高的运算速率,更高的带宽,以及相对较低的成本和功耗,实现了从成本、性能到可靠性的完美平衡。

图6. 格芯2.5D封装技术帮助减少内存和计算单元的物理距离ref[5]

格芯2.5D封装技术2017年产品化,至今已成功应用于国内外多个系统厂家的高端芯片,可以覆盖不同产品尺寸,并且是基于3层Metal工艺实现的Interposer, 更具成本优势。在2.5D先进封装设计服务方面,格芯已完成从物理实现,到仿真分析,到物理验证的全流程开发,并持续开发支持多个主流EDA厂家的设计流程,方便不同客户使用。另外格芯与第三方IP厂家以及各OSAT (Amkor, ASE等) 都有完善的长期合作关系,因此格芯也提供一站式服务(从设计到生产加工),使客户的产品拥有快速、高质量和高性价比的设计和生产方案,让产品能更快地进入市场,同时保证了独特的技术和方案。

边缘AI中的存内计算

在未来,大数据处理和机器学习等对算力的要求还会进一步增加,对于边缘AI计算也同样会出现需要提高算力容量以及效率的需求。这种对算力的极高要求会和冯·诺伊曼计算架构导致的存储墙 (Memory Wall) 成为限制电子信息领域发展的一对矛盾。近年来出现的存内计算(存算一体)芯片就有很大希望能够解决这一问题。存算一体芯片技术,旨在把传统以计算为中心的架构转变为以数据为中心的架构,直接利用存储器进行数据处理,从而把数据存储与计算融合在同一个芯片当中,可以彻底消除冯诺依曼计算架构的瓶颈。由于边缘AI运算,例如卷积神经网络 (CNN) 的运算,涉及的指令相对单一,基本上是乘累加 (Multiply-Accumulate) 运算,以存储器来做MAC单元有很高的可行性。

进行CNN计算时,在传统的计算架构下,Memory的bit-cell只存储权重,在进行计算时,要把权重从Memory中取出,和输入数据一起放入数据处理器(Digital Processor)中进行计算,再输出结果。而存内计算是直接在Memory中进行权重和输入的乘累加运算,一次可以打开多条字线(word-lines) , 而不是像传统架构通过地址译码器 (Decode)只能打开一条字线 (word-line), 大大的提高了运算效率和吞吐量。因此,存内计算特别适用于深度学习神经网络这种大数据量大规模并行的应用场景。

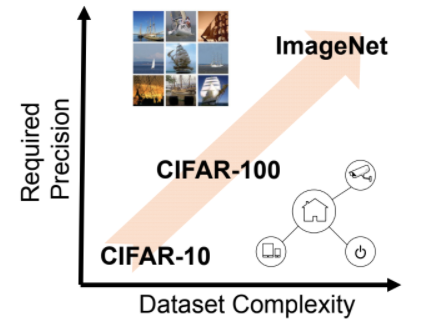

图7. 利用SRAM存储和计算的特点,解决计算架构的瓶颈以及识别高精度的数据集ref[6]

边缘设备的解决方案对成本非常敏感。许多边缘AI芯片供应商都需要在40nm左右的成熟节点上交付产品。目前这一工艺很理想,成本并不昂贵。但展望未来,供应商希望以低功耗获得更高的性能。

格芯的新型12LP+技术提供了一条替代途径,通过减小电压而不是晶体管尺寸来降低功耗。格芯还开发了专门针对AI加速而优化的新型SRAM和乘法累加 (MAC)电路。12LP+工艺下的SRAM单元中增加了双功函数晶体管,使电压得以降低,从而减小所需的电压裕量。

总结

虽然云计算一直是数据管理、处理和存储的首选,但其存在局限性。而边缘计算可以充当替代解决方案,但由于该技术仍处于起步阶段,因此还面临很多挑战,比如需要开发能够处理云端分流的计算任务的软件和硬件,以及需要教会机器能够在边缘执行的计算任务和需要云端执行的计算任务之间切换。

即便如此,随着边缘AI计算更多地被采用,企业将有更多的机会在各个领域测试和部署这种技术。届时,嵌入式存储器也会焕发出新的生命力。

Reference:

[1] “How Edge AI is widely changing smart devices“. https://www.mediatek.com/blog/how-edge-ai-is-widely-changing-smart-devices. March.2019.

[2] J. Yue et al., “A 65nm Computing-in-Memory-Based CNN Processor with 2.9-to-35.8TOPS/W System Energy Efficiency Using Dynamic-Sparsity Performance-Scaling Architecture and Energy-Efficient Inter/Intra-Macro Data Reuse”, ISSCC, pp. 234-235,2020.

[3] M.-F. Chang et al. “Nonvolatile Circuit for AI Edge Applications”, VLSI, 2019.

[4] Yole Development, "Emerging Non-Volatile Memory, Market and Technology Report 2020"

[5] Cheng, Zhang et al. "Advanced 2.5D packaging technology", GLOBALFOUNDRIES,

https://www.eet-china.com/news/11093.html

[6] Xin Si et al., “A 28nm 64Kb 6T SRAM Computing-in-Memory Macro with 8b MAC Operation for AI Edge Chips” ISSCC.Feb.2020.

- 嵌入式存储器迎合大数据时代契机,抓住机遇,迎接挑战!