导读:这期的干货有点大,诸位看官且忍受一下~

AI 简报 Github 地址:

https://github.com/Lebhoryi/AI-News-weekly

本文一共 3600 字,通篇阅读结束需要 7~12 分钟

本周要闻

原文:

https://news.cnstock.com/news,bwkx-202108-4742691.htm

在8月18日召开的“百度世界大会2021”上,百度创始人、董事长兼首席执行官李彦宏首次提出了“汽车机器人”的前瞻概念,并发布百度Apollo“汽车机器人”。

据介绍,百度汽车机器人具备L5级自动驾驶能力,并且具备语音、人脸识别等多模交互能力,可以分析用户潜在需求,主动提供服务。

此外,汽车机器人还具备自我学习和不断升级能力,是服务各种场景的智慧体。

外观上,自动鸥翼门、全玻璃车顶与外部传感器融为一体;汽车机器人车内不设方向盘、踏板,且拥有超大曲面屏、智能控制台、变光玻璃、零重力座椅等智能化配置。

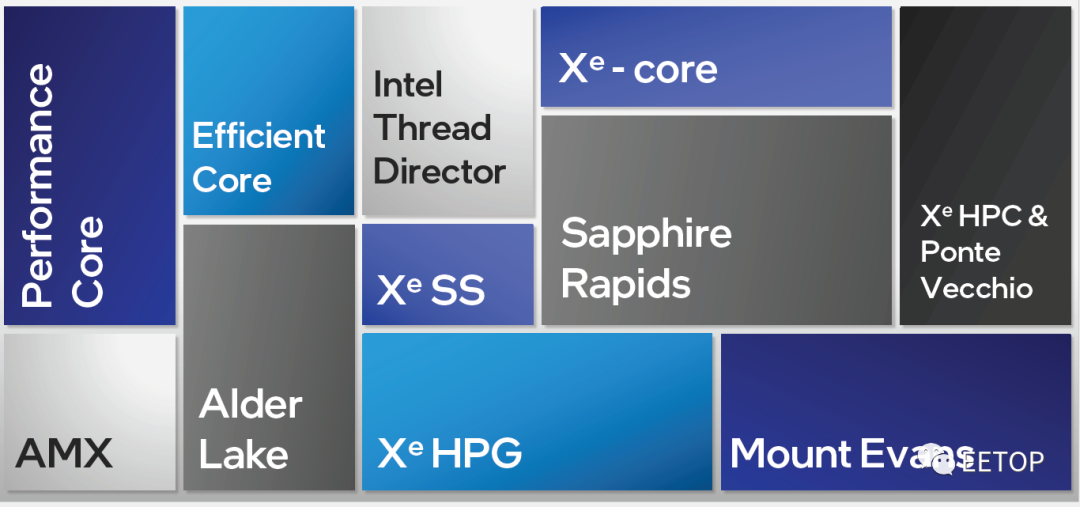

8月20日,英特尔为选定的媒体和合作伙伴举办了一年一度的架构日活动。每年的架构日,英特尔架构师都会披露面向新产品的架构创新。今年也不负众望,在2021年的英特尔架构日上,英特尔公司高级副总裁兼加速计算系统和图形事业部总经理Raja Koduri携手多位英特尔架构师,全面介绍了:

两种全新x86内核架构的详情,AI加速提升约8倍!

英特尔首个性能混合架构,代号“Alder Lake”,

智能的英特尔®硬件线程调度器;

专为数据中心设计的下一代英特尔®至强®可扩展处理器Sapphire Rapids;

基础设施处理器(IPU);

即将推出的显卡架构,包括Xe HPG微架构和Xe HPC微架构,以及Alchemist SoC, Ponte Vecchio SoC。

最近,预测DRAM凛冬将至的声音不断,并且这种情况极有可能持续长达一年半之久。不过供不应求的市场现状并不影响华邦电子上半年的营收。

据华邦电子近日公布的数据,2021年上半年内存事业营收为新台币257亿1百万元,较去年同期增加36%,其中DRAM产品线占2021年上半年营收为46%, DRAM营收年增率近4成。闪存Flash产品线占2021年上半年营收为54%,Flash营收年增率超过3成。

在近日的采访中,华邦电子DRAM产品营销部经理曾一峻介绍说:“在未来一两年,边缘计算将更流行。通常大家都认为AI的模型很大。但其实,行业内正在致力于通过不断的架构优化,来将AI模式缩小,可以说是在准确度可以接受的范围情况下进行极致地压缩化处理。

有趣的开源项目

原文:

https://zhuanlan.zhihu.com/p/400474142

YOLO-FastestV2项目链接:

https://github.com/dog-qiuqiu/Yolo-FastestV2

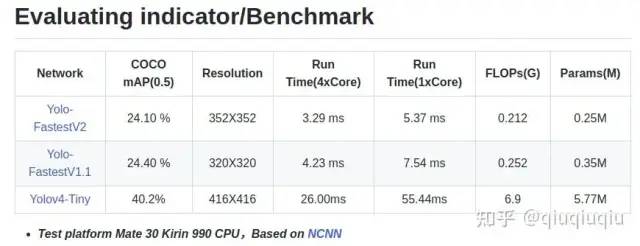

先说说Yolo-Fastest的初衷吧,其实早期轻量的目标检测大家多是用的Mobilenet-SSD,其实在实际测试中,在常用的ARM设备上是很难达到实时的,只有在一些高端手机大核全开勉强达到实时,更别说工业界常用的"性能强悍的"RK3399等ARM CPU呢,达到实时基本是不可能的。

Yolo-Fastest注重的就是单核的实时推理性能,在满足实时的条件下的低CPU占用,不单单只是能在手机移动端达到实时,还要在RK3399,树莓派4以及多种Cortex-A53低成本低功耗设备上满足一定实时性,毕竟这些嵌入式的设备相比与移动端手机要弱很多,但是使用更加广泛,成本更加低廉。

V2版本作者没有优化精度,优化了速度。用0.3%的精度损失换取30%推理速度的提升以及25%的参数量的减少,觉得还是挺值,与其说追求的速度,其实更加注重的是算法效果与推理效率的性价比。

GitHub地址:

https://github.com/xinixgit/rpi/tree/main/pi-cat-litter参考链接:

https://xinxindai.medium.com/build-a-ventilated-cat-litter-box-with-pi-zero-ce943d55b446

每个铲屎官最痛苦的事情之一,莫过于处理猫咪的“生化武器”——猫屎。

只要猫拉了粑粑,气味就会飘出来,在铲屎时还能闻到一股巨酸爽的味道。

好消息,来自硅谷的一个华人工程师,想出了一个绝妙的方法:给猫做个智能厕所!

结合小零件,一块树莓派就能将猫砂盆升级成自动通风猫厕,每当猫咪“解决完生理问题”,它就能自行启动风扇,进行散味.

树莓派控制,红外自动检测

硬件上,完整的零件清单如下:

树莓派Zero W、80mm×80mm的风扇(CPU散热器)、12V电源、1截空调通风管、适量PIR运动传感器、适量1kΩ电阻、三极管、1个降压-升压变换器

论文地址:

https://arxiv.org/abs/2108.03798

GitHub网址:

https://github.com/wzmsltw/PaintTransformer

AI已经能教你画油画了。

随便给一张图,笔画序列秒秒钟呈现。

比如世界名画蒙娜丽莎。亦或是写实类的小鸟。还有极具氛围感的河灯。

这项技术在Reddit上21小时内就已经有600+的点赞量。

赛事地址:

https://graphchallenge.mit.edu/challenges

项目地址:

https://github.com/CGCL-codes/Graphchallenge21

喜讯喜讯!

8月13日,2021年图计算挑战赛GraphChallenge比赛结果揭晓:

华中科技大学图计算团队获得全球冠军!

这是国内团队在该赛事中首次夺冠!

作为图计算领域最具影响力的国际赛事之一,华中科技大团队此次夺冠,标志着我国在图计算领域的研发水平位于国际前列。

此次比赛吸引了赛灵思、英伟达、劳伦斯利弗莫尔国家实验室、弗吉尼亚理工大学、伊利诺伊大学厄巴纳-香槟分校等国际知名科技研院所参赛。

最终,华中科技大学团队、美国乔治华盛顿大学与马里兰大学的联合队伍两支参赛团队获得冠军。

在GraphChallenge 2021中,参赛选手需要在给定的图应用上比拼处理速度。

比赛分为三个赛道:静态图匹配、动态图划分和稀疏神经网络推理,也分别代表了图计算的不同典型应用场景。

目前代码已经开源

AI 前沿

pape:

https://arxiv.org/abs/2108.07755

code:

https://github.com/fcjian/TOOD

单阶段目标检测往往通过优化两个子任务进行实现:目标分类与目标定位,两者采用两个并行分支,这种处理方式可能会导致一定程度上的空间不对齐问题。

作者提出一种任务对齐单阶段目标检测(Task-aligned One-stge Object Detection ,TOOD),它通过学习的方式对两个任务进行显式对齐。首先,作者设计了一种新颖的T-Head(Task-aligned Head),它可以为任务交互以及任务相关特征提供更好的平衡,还可以通过任务对齐预测器为学习对齐提供更好的灵活性。其次,作者提出了TAL(Task Alignment Learning)在训练过程中通过采样分配机制与任务对齐损失将两个任务最终的anchor进行显式靠拢(甚至统一)。

作者在MS-COCO数据集上进行了充分了实验,凭借单模型单尺度测试,TOOD取得了51.1AP指标,大幅超过了已有单阶段检测(比如ATSS的47.7AP、GFL的48.2AP、PAA的49.0AP),同时具有更少的参数量、FLOPs。此外,定量分析结果同样表明:TOOD可以更好的对目标分类与目标定位两个任务进行对齐。

论文:

https://arxiv.org/abs/2108.05894

代码:https://github.com/liyunsheng13/micronet

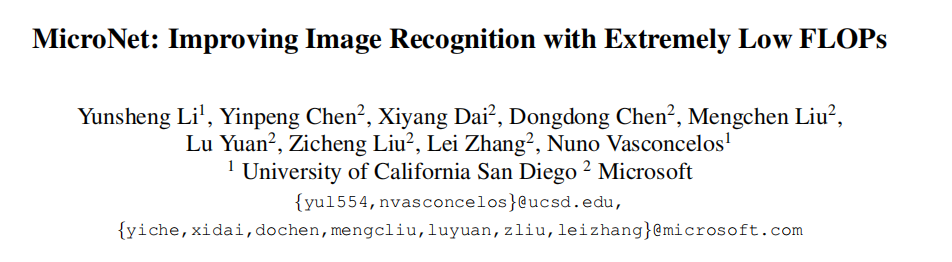

本文旨在以极低的计算成本解决性能大幅下降的问题。作者发现有两个因素是可以有效提高精度的,分别是:稀疏连通性和动态激活函数。前者避免了网络宽度的大幅度缩减的危害,而后者则减轻了网络深度缩减的危害。

技术上,作者提出了微分解卷积(micro-factorized convolution),它将卷积矩阵分解成低秩矩阵,以将稀疏连通性整合到卷积中。此外,作者还提出了一个新的动态激活函数,称为Dynamic Shift Max,通过最大化输入特征图和圆形通道位移之间的多次动态融合来提高非线性。

基于这两个操作,作者提出一个新的网络系列:MicroNet,在低FLOP状态下,它取得了显著的性能提高。例如,在12M FLOPs的约束下,MicroNet在ImageNet分类上达到了59.4%的Top-1准确率,比MobileNetV3高出9.6%。

论文地址:

https://arxiv.org/abs/2108.02092

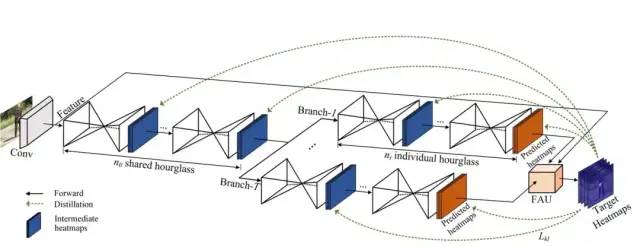

分享一篇最近被ICCV 2021接收的工作《Online Knowledge Distillation for Efficient Pose Estimation》,利用在线知识蒸馏进行高效2D人体姿态估计。

该篇工作由杭州师范大学和浙江大学合作完成。

该文章提出了一个新的在线知识蒸馏框架OKDHP去对人体姿态估计模型进行提升。特别地,OKDHP训练了一个多分支网络,其中每个分支都被当做独立的学生模型,这里的教师不是显式存在的,而是通过加权集成多个分支的结果后形成的集成heatmap来扮演教师的作用,通过优化像素级别的KL Divergence损失来优化每个学生分支模型。整个训练过程被简化到了one-stage,不需要额外预训练的教师模型。作者在MPII和COCO上都证明了该方法的有效性。

论文链接:

https://arxiv.org/pdf/2107.07467.pdf

大型神经网络学习速度很快,性能也往往优于其他较小的模型,但它们对资源的巨大需求限制了其在现实世界的部署。

剪枝是最常见的 DNN 压缩方法之一,旨在减少冗余结构,给 DNN 模型瘦身的同时提高其可解释性。然而,现有的剪枝方法通常是启发式的,而且只针对特定任务,还非常耗时,泛化能力也很差。

在一篇标题为《 Only Train Once: A One-Shot Neural Network Training And Pruning Framework》的论文中,来自微软、浙江大学等机构的研究者给出了针对上述问题的解决方案,提出了一种 one-shot DNN 剪枝框架。它可以让开发者无需微调就能从大型神经网络中得到轻量级架构。这种方法在保持模型高性能的同时显著降低了其所需的算力。

干货

ResNet到底在解决一个什么问题呢? | CVer

2020 AI 研究大盘点!这些大牛的论文你都看过吗? | 新智元

干货!深度学习加速综述:算法、编译器、体系结构与硬件设计 | 小白学视觉

官方 | Keras分布式训练教程 | 小白学视觉

史上讲解最好的Docker教程,从入门到精通(建议收藏的教程) | 极市平台

实践教程 | 万字长文,值得收藏/参考的OpenCV C++基础代码 | 极市平台

某独角兽计算机视觉算法一面面试真题 | 灿视学长

实践教程 | 深入浅出Yolox之自有数据集训练超详细教程 | 极市平台

其他

DeeCamp 2021冠军用“垃圾DNA”预测癌症,李开复:医疗是AI的下一个突破点 | 量子位

150名打工人被AI判定“效率低”遭开除,网友:属实是人工智能,能治工人

为什么说 RISC-V 是 40 年来人类计算路线的最大变量? | 雷锋网

李飞飞点赞的NeurIPS新赛道,刚刚公布了第一批数据集&benchmark入围名单

你可以添加微信17775982065为好友,注明:公司+姓名,拉进 RT-Thread 官方微信交流群!

👇 点击阅读原文进入官网