AI在工业中的广泛应用正在加速机器学习(ML)、深度学习以及LLM等方法的运用。这些进步让我们看到了将在边缘使用的大量数据。虽然目前的重点是如何加速神经网络的运行,但美光的驱动力是为Edge上的AI制造精致的内存和存储。本文探讨了创新的存储和内存技术将如何使未来的创新成为可能。

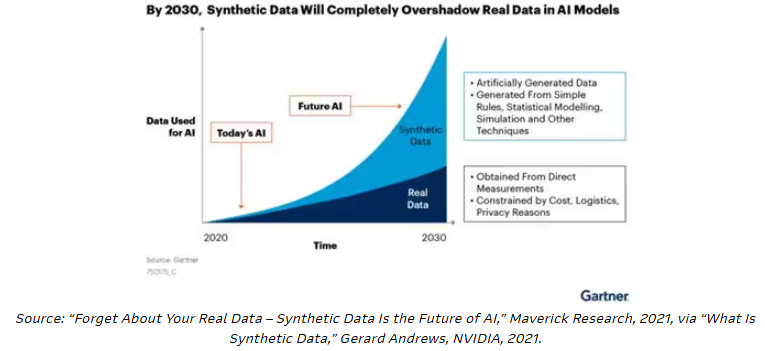

什么是合成数据?

IDC预测,到2025年,全球将产生175泽字节(1泽字节= 10亿太字节)的新数据。这些数量很难理解,但AI的进步将继续推动数据匮乏系统的发展。

事实上,不断增长的AI模型已经被从直接测量或物理图像中获得的大量真实物理数据所扼杀。如果你有10000张现成的橙子图片,就很容易识别出一个橙子。但是,如果你需要特定的场景来进行比较,除非有所有不同的样本来创建基线模型,否则很难确认准确的结果。

该行业越来越多地使用合成数据。合成数据是基于模拟模型人工生成的,例如,提供相同图像的统计现实。这种方法在工业视觉系统中尤其适用,在工业视觉系统中,物理图像的基线是唯一的,并且在网络上找不到足够的“小部件”来提供有效的模型表示。

挑战在于这些新形式的数据将留在哪里。当然,任何新创建的数据集都必须存储在云中,或者存储在更靠近数据需要分析的地方——边缘。

模型复杂性和内存墙

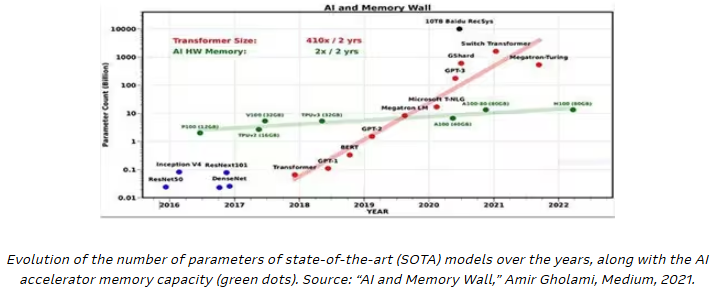

在算法效率和AI模型性能之间找到最佳平衡是一项复杂的任务,因为它取决于数据特征和数量、资源可用性、功耗、工作负载要求等因素。

AI模型是复杂的算法,可以通过其参数数量来表征:参数数量越多,结果越准确。该行业从一个通用的基线模型开始,如ResNet50,因为它易于实现,并成为网络性能的baseline。但该模型关注的是有限的数据集和有限的应用。随着这些transformer的发展,我们看到transformer的发展增加了内存带宽的参数。这个结果是一个明显的压力:无论模型可以处理多少数据,我们都受到模型和参数可用的内存和存储带宽的限制。

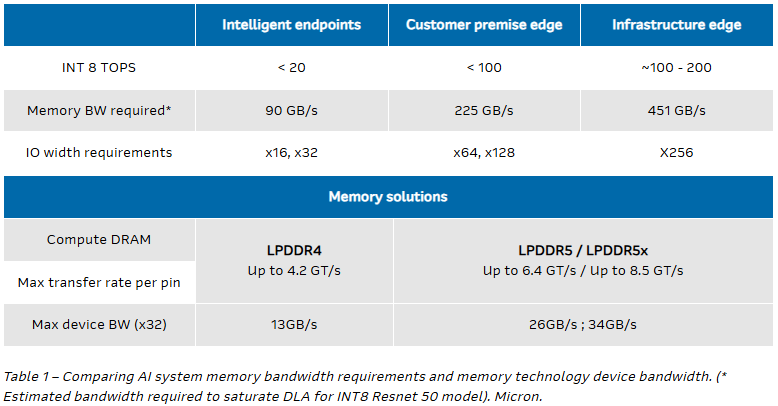

为了快速比较,可以看一下嵌入式AI系统的性能,以每秒50次操作(TOPS)为单位。这里我们看到,低于100 TOPS的AI边缘设备可能需要大约225 GB /s的内存带宽,而高于100 TOPS的AI边缘设备可能需要451 GB /s的内存带宽(表1)。

因此,优化该模型的一种方法是考虑提供最低功耗的高性能内存。

内存通过不断发展新的标准来跟上AI加速解决方案的步伐。例如,LPDDR4/4X(低功耗DDR4 DRAM)和LPDDR5/5X(低功耗DDR5 DRAM)解决方案比以前的技术有显著的性能改进。

美光正在提供行业领导和持久性

业界领先的LPDRAM供应商

LP5行业领先-率先获得FUSA认证

LP5X以最低功耗提供最高性能

LP4行业首个至1A节点——降低成本,延长使用寿命

专门的晶圆厂,提供持续的产品支持

广泛的工业和多市场投资组合

最大128Gb LPDDR4和LPDDR5

广泛参与和兼容所有主要的CSV合作伙伴

LP4 / LP5是AI芯片组生态系统的首选解决方案

与旧技术相比,LP4 / LP5提供更高的温度范围:(例如,工业用Ti = 100℃)

LPDDR4可以运行高达4.2 GT/s每引脚,并支持高达x64总线宽度。与LPDDR4相比,LPDDR5X的性能提高了50%,每引脚的性能提高了一倍,达到8.5GT/s。此外,LPDDR5的功率效率比LPDDR4X高20%(来源:Micron)。这些都是重要的发展,可以满足不断扩大的AI边缘用例的需求。

存储方面的考虑是什么?

认为计算资源受到处理单元的原始TOP或内存体系结构带宽的限制是不够的。随着机器学习模型变得越来越复杂,模型的参数数量也呈指数级增长。

机器学习模型和数据集扩展以实现更好的模型效率,因此也需要更高性能的嵌入式存储。典型的托管NAND解决方案,如3.2 Gb/s的e.MMC 5.1,不仅是代码启动的理想选择,也是远程数据存储的理想选择。此外,UFS 3.1等解决方案的运行速度可以提高7倍,达到23.2 Gb/s,从而支持更复杂的模型。

新的体系结构也将通常归为云计算或IT基础设施的功能推向边缘。例如,边缘解决方案实现了一个安全层,在受限制的操作数据和IT/云域之间提供了一个气隙。边缘的AI还支持智能自动化,如分类、标记和检索存储的数据。

支持3D TLC NAND的NVMeTM SSD等内存存储开发为各种边缘工作负载提供了高性能。例如,美光的7450 NVMe SSD利用176层NAND技术,非常适合大多数边缘和数据中心工作负载。它具有2ms的QoS延迟,非常适合SQL服务器平台的性能要求。它还提供FIPS 140-3 2级和TAA符合美国联邦政府采购要求。

不断增长的AI边缘处理器生态系统

联合市场研究公司估计,到2030年,AI边缘处理器市场将增长到96亿美元。然而,有趣的是,这批新的AI处理器初创企业正在开发专用集成电路和专有专用集成电路,以适应更多空间和功耗受限的边缘应用。当涉及到内存和存储解决方案时,这些新的芯片组还需要在性能和功耗之间进行权衡。

此外,我们看到AI芯片组供应商已经开发出企业和数据中心标准外形尺寸(EDSFF)加速卡,这些加速卡可以安装在1U解决方案中,并与存储服务器一起安装,可以使用相同的模块加速任何工作负载-从AI/ML推理到视频处理。

AI不再是炒作,而是在所有垂直领域实现的现实。在一项研究中,89%的行业已经制定了战略,或者将在未来两年内制定围绕AI的战略。

原文链接:

https://www.arrow.com/en/research-and-events/articles/ai-at-the-edge-future-memory-and-storage-in-accelerating-intelligence

高端微信群介绍 | |

创业投资群 | AI、IOT、芯片创始人、投资人、分析师、券商 |

闪存群 | 覆盖5000多位全球华人闪存、存储芯片精英 |

云计算群 | 全闪存、软件定义存储SDS、超融合等公有云和私有云讨论 |

AI芯片群 | 讨论AI芯片和GPU、FPGA、CPU异构计算 |

5G群 | 物联网、5G芯片讨论 |

第三代半导体群 | 氮化镓、碳化硅等化合物半导体讨论 |

存储芯片群 | DRAM、NAND、3D XPoint等各类存储介质和主控讨论 |

汽车电子群 | MCU、电源、传感器等汽车电子讨论 |

光电器件群 | 光通信、激光器、ToF、AR、VCSEL等光电器件讨论 |

渠道群 | 存储和芯片产品报价、行情、渠道、供应链 |

< 长按识别二维码添加好友 >

加入上述群聊

带你走进万物存储、万物智能、

万物互联信息革命新时代