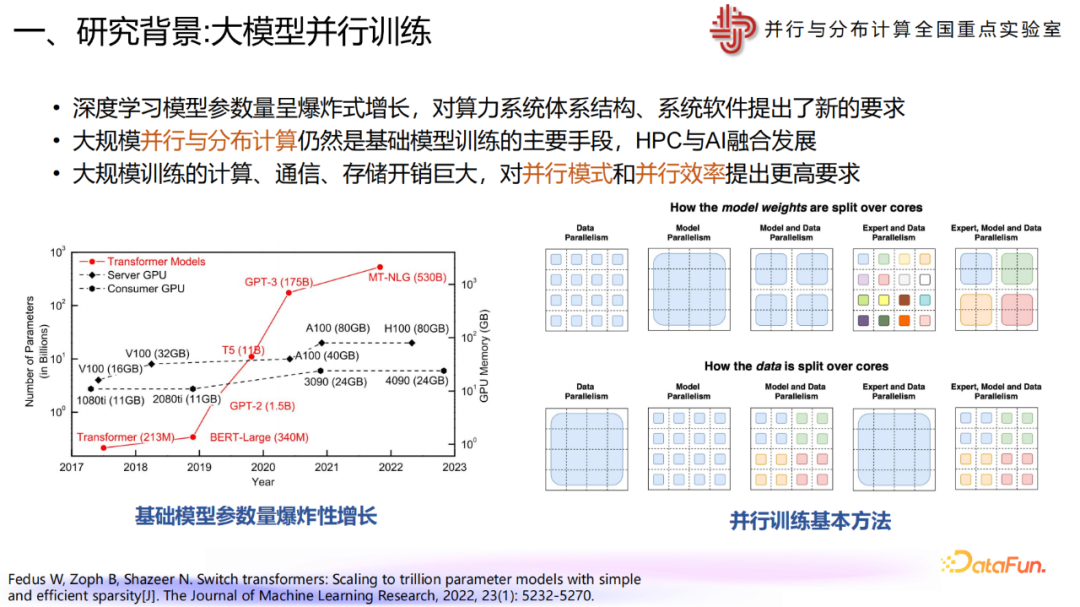

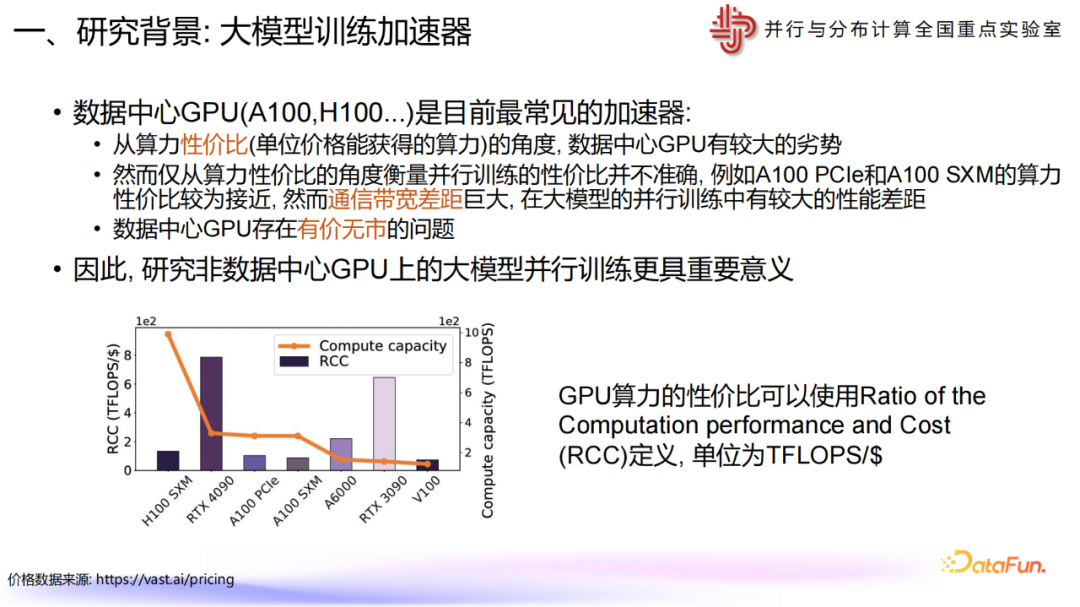

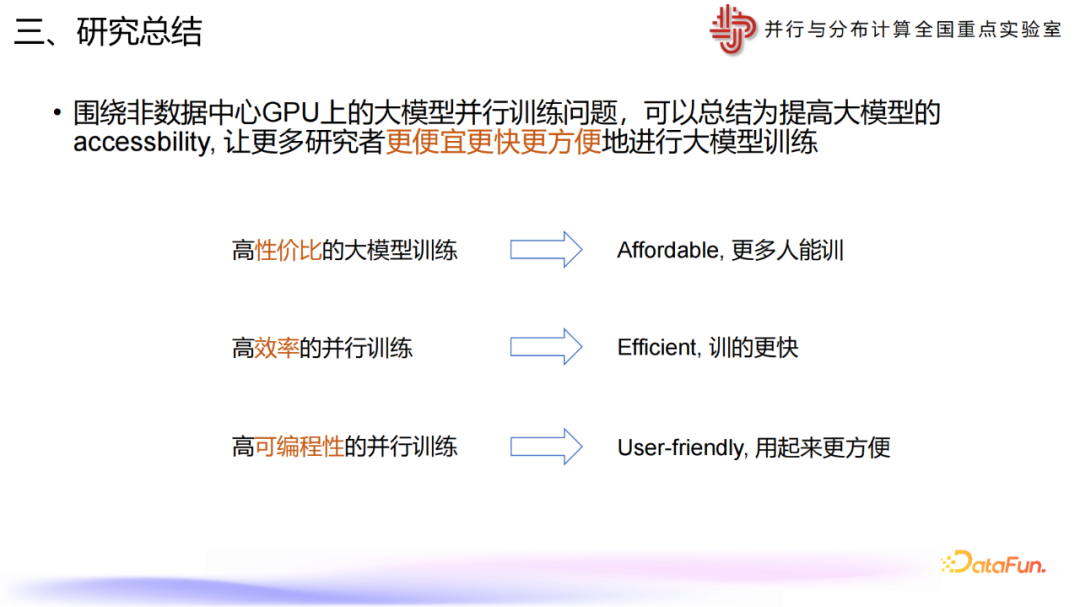

本文来自“非数据中心GPU上的大模型并行训练”,“智能计算芯知识”,深度学习模型参数量呈爆炸式增长,对算力系统体系结构、系统软件提出了新的要求。

大规模并行与分布计算仍然是基础模型训练的主要手段,HPC与AI融合发展

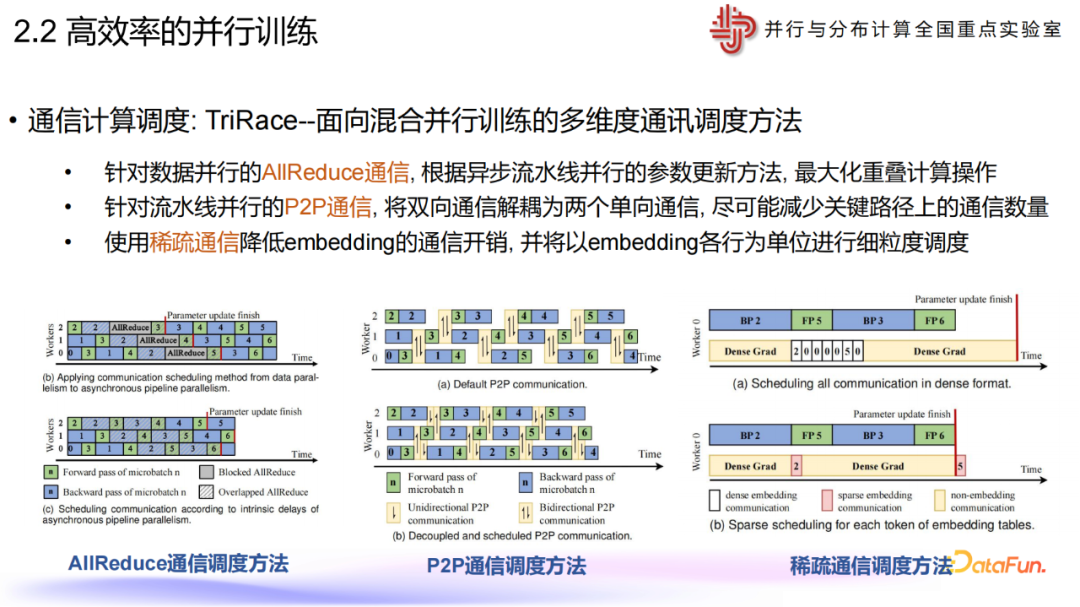

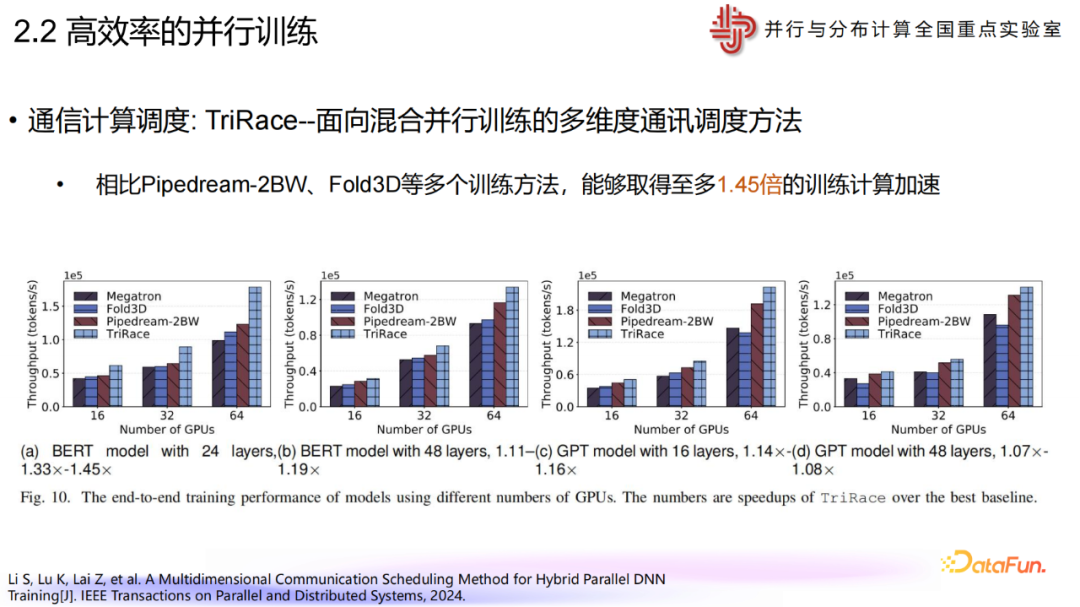

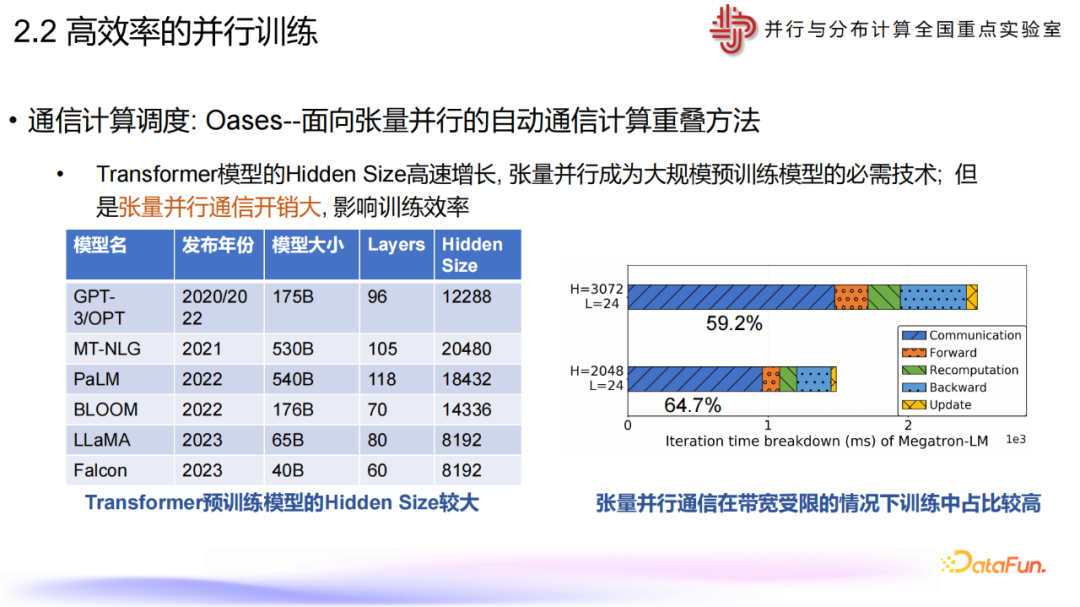

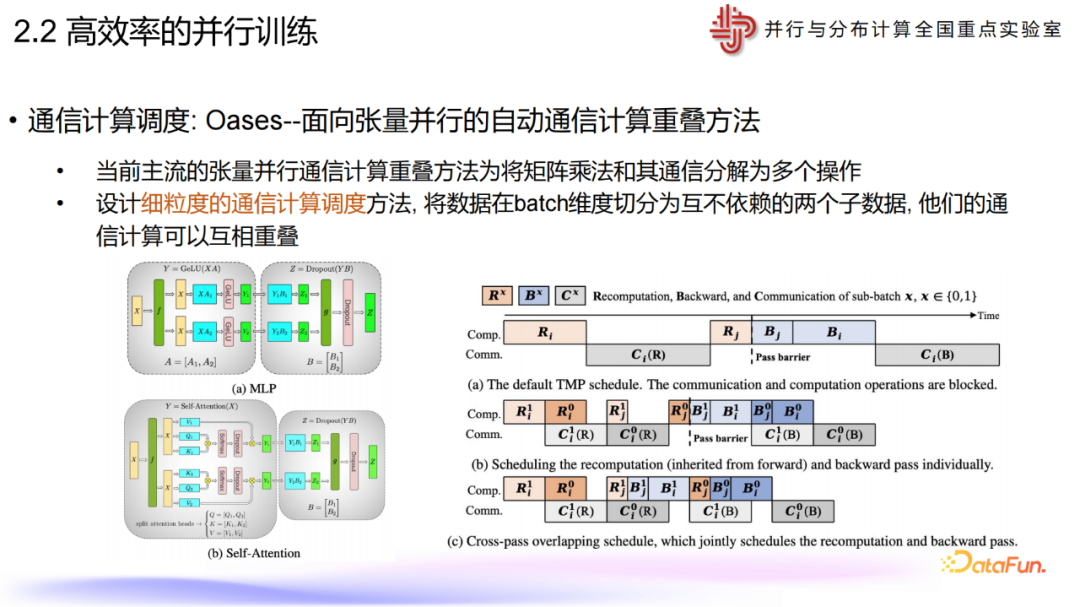

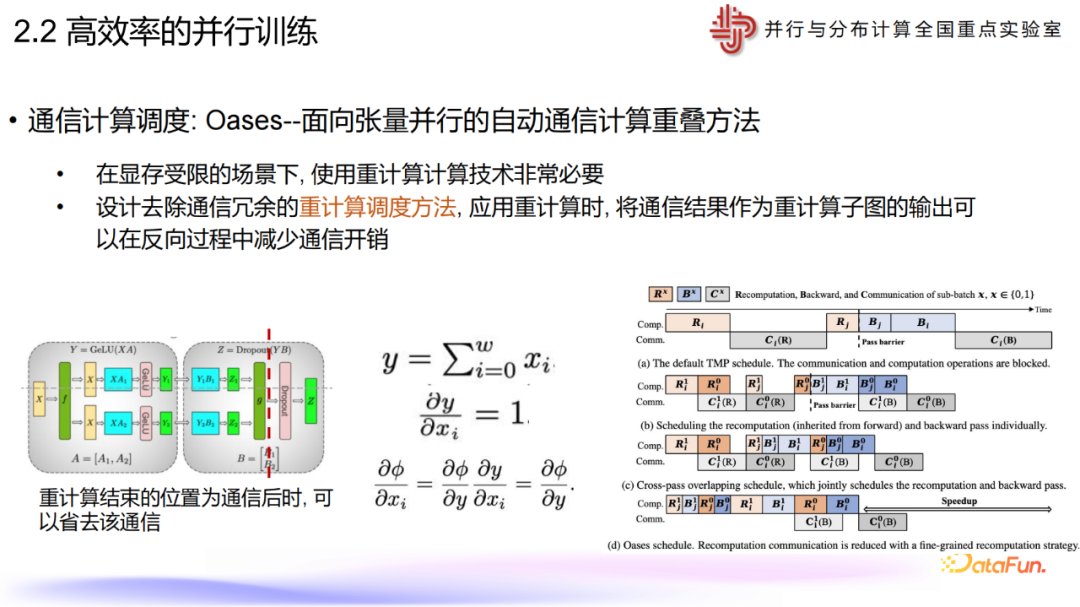

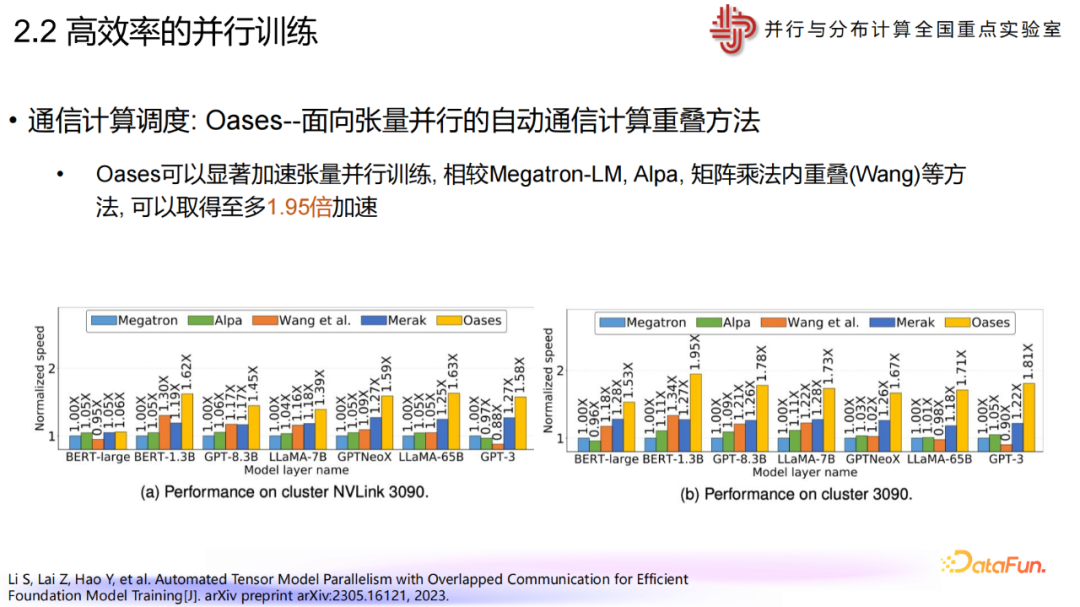

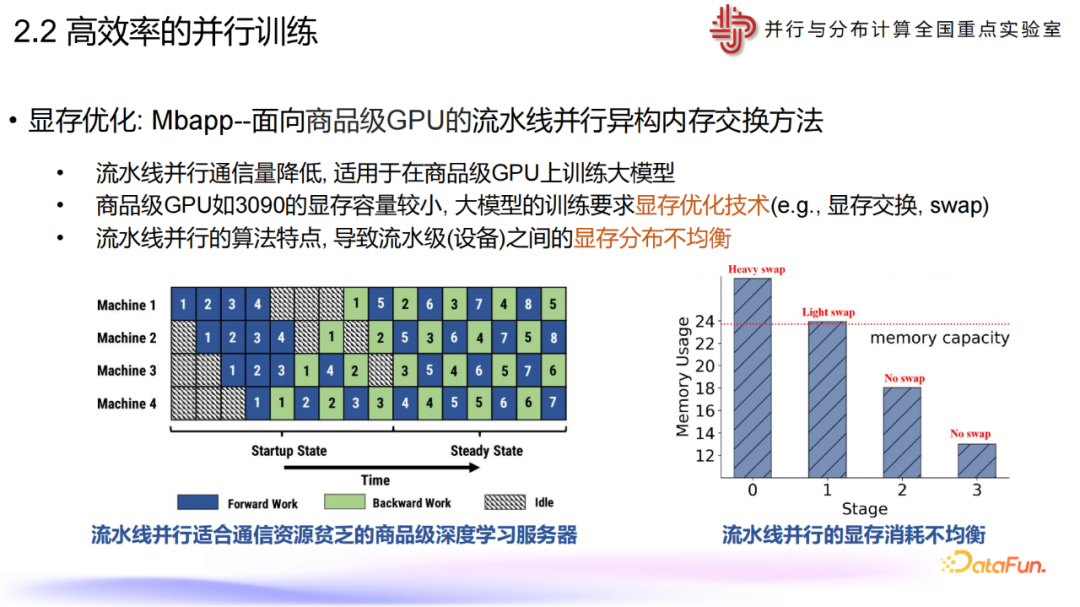

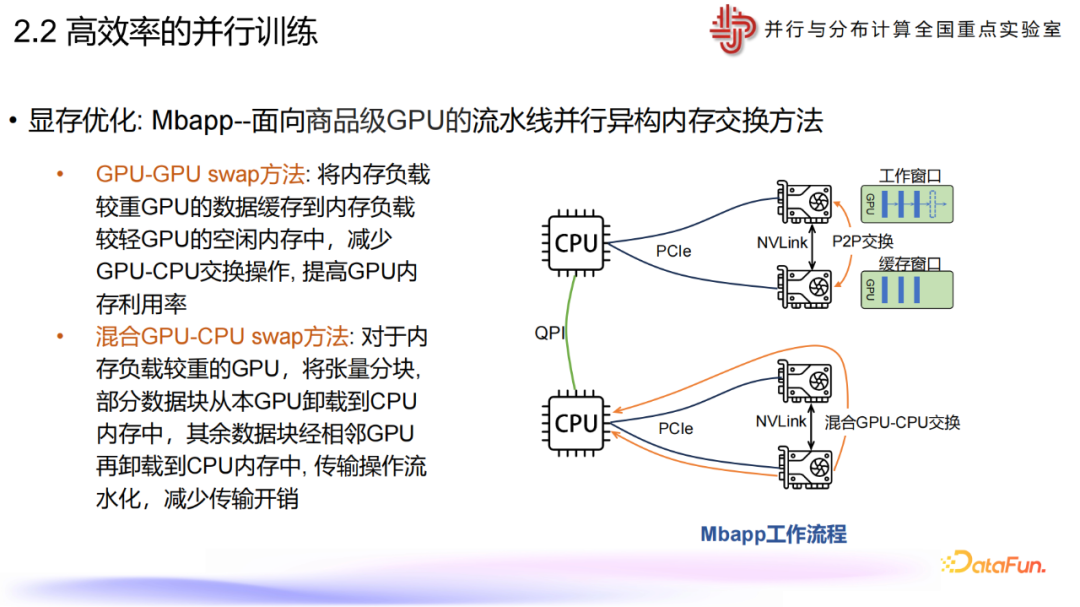

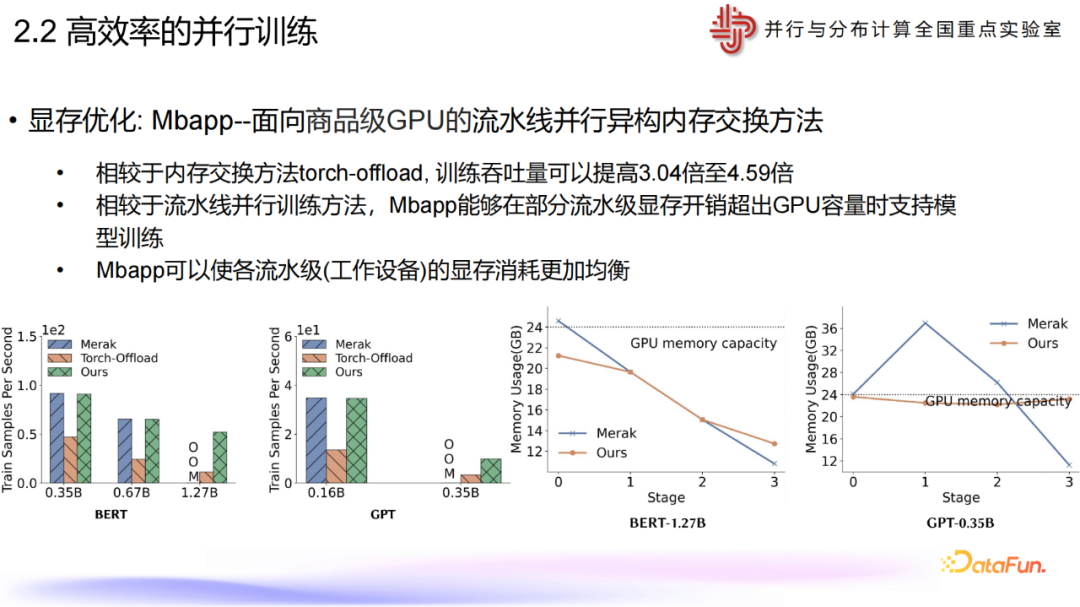

大规模训练的计算、通信、存储开销巨大,对并行模式和并行效率提出更高要求

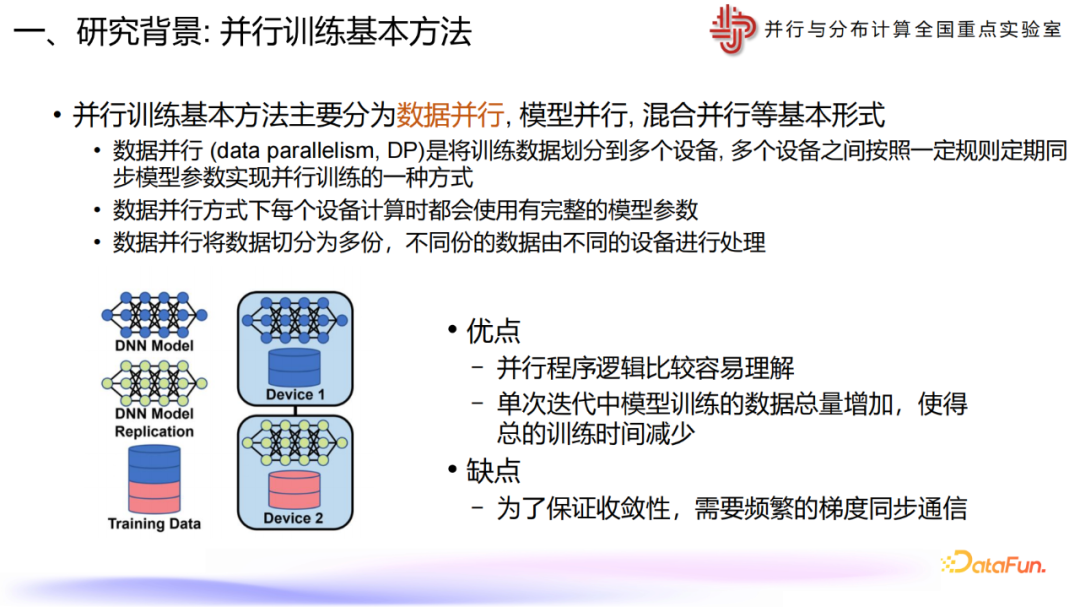

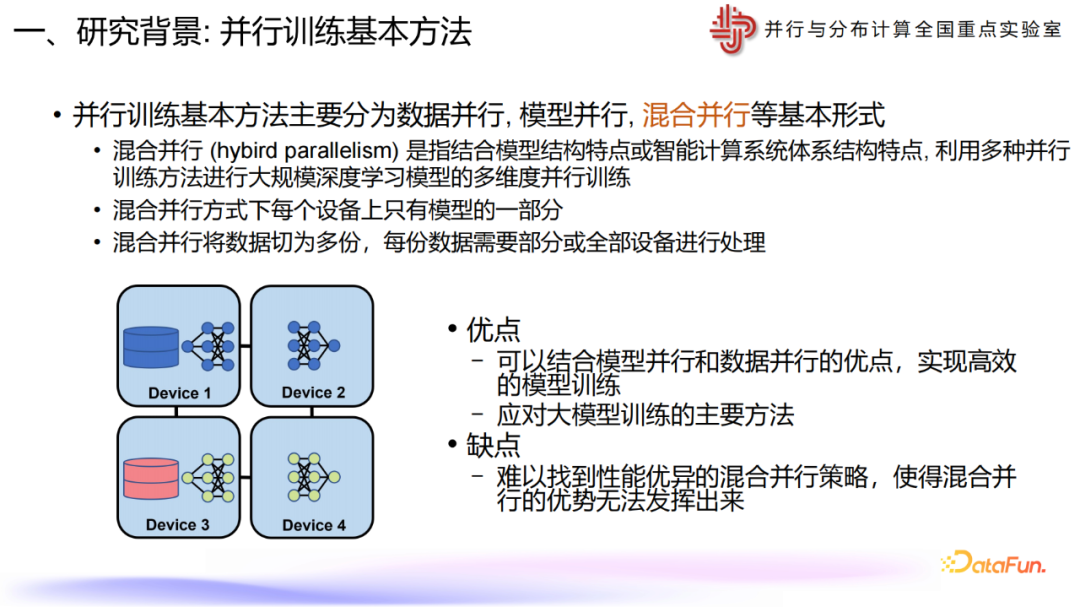

并行训练基本方法主要分为数据并行, 模型并行, 混合并行等基本形式

数据并行 (data parallelism, DP)是将训练数据划分到多个设备, 多个设备之间按照一定规则定期同步模型参数实现并行训练的一种方式

数据并行方式下每个设备计算时都会使用有完整的模型参数

数据并行将数据切分为多份,不同份的数据由不同的设备进行处理

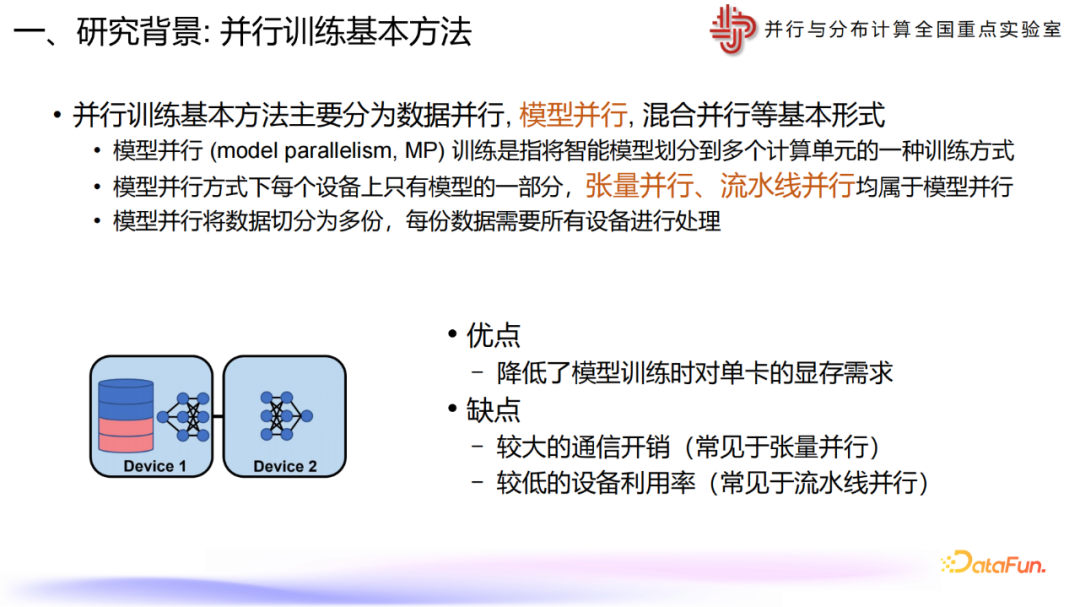

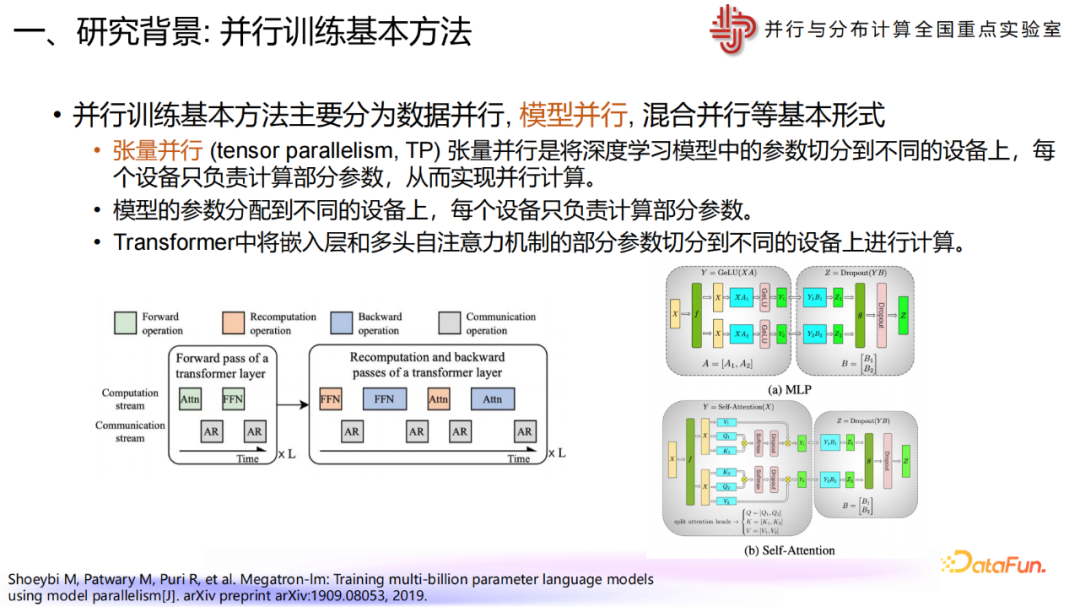

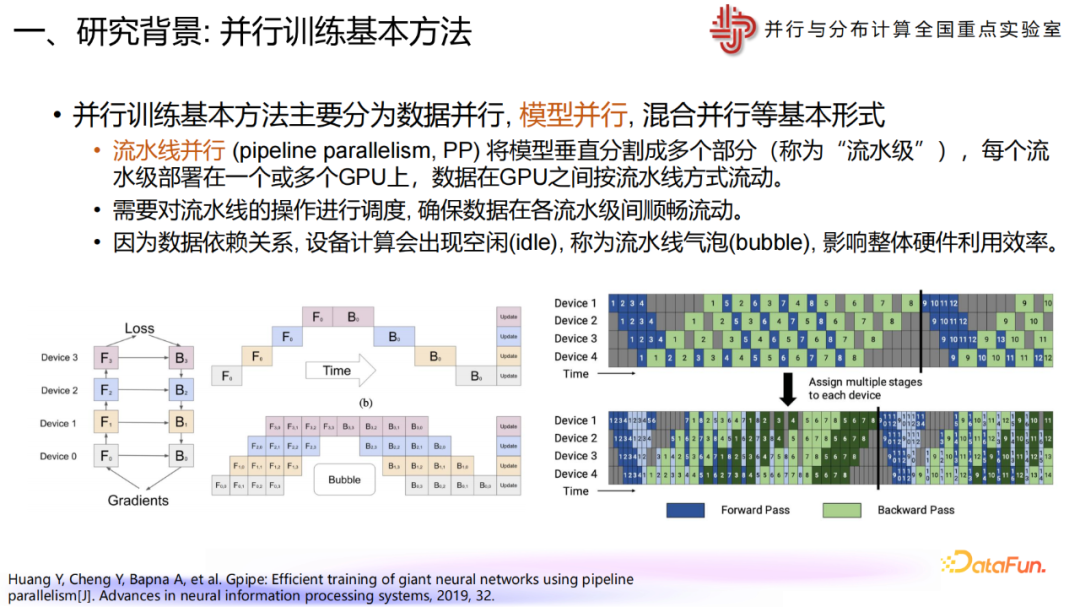

并行训练基本方法主要分为数据并行, 模型并行, 混合并行等基本形式

模型并行 (model parallelism, MP) 训练是指将智能模型划分到多个计算单元的一种训练方式

模型并行方式下每个设备上只有模型的一部分,张量并行、流水线并行均属于模型并行

模型并行将数据切分为多份,每份数据需要所有设备进行处理

本文所有资料都已上传至“智能计算芯知识”星球。如“《60+份AI Agent技术报告合集》”,“《清华大学:DeepSeek报告13部曲合集》”,“浙江大学:DeepSeek技术20篇(合集)”,“《290+份DeepSeek技术报告合集》”,“《100+份AI芯片技术修炼合集》”,“800+份重磅ChatGPT专业报告”,“《12+份Manus技术报告合集》”,加入星球获取严选精华技术报告。

下载链接:

8、《3+份技术系列基础知识详解(星球版)》

9、《12+份Manus技术报告合集》

10、《100+份AI芯片修炼合集》

11、《60+份AI Agent技术报告合集》

《290+份DeepSeek技术报告合集》

《42篇半导体行业深度报告&图谱(合集)

亚太芯谷科技研究院:2024年AI大算力芯片技术发展与产业趋势

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。