ChatGPT开发商OpenAI于4月16日(当地时间)发布了新的人工智能(AI)模型。它是一种推理模型,它超越了从用户问题进行推断,而是通过查看图像进行思考。

OpenAI宣布,将发布一款新的人工智能模型“o3”,可以分析和理解绘画、图表等图像,以及一款较小的模型“o4 mini”。

该模型是OpenAI第一个推理模型o1的后继者,该模型于去年9月发布,专注于解决复杂问题并跨多个步骤推断答案。

OpenAI将“o3”描述为迄今为止最复杂的推理模型,在衡量数学、编码、推理、科学和视觉理解能力的测试中表现优于之前的模型。此外,还增加了“o4 mini”作为寻求价格、速度和性能之间平衡的型号。

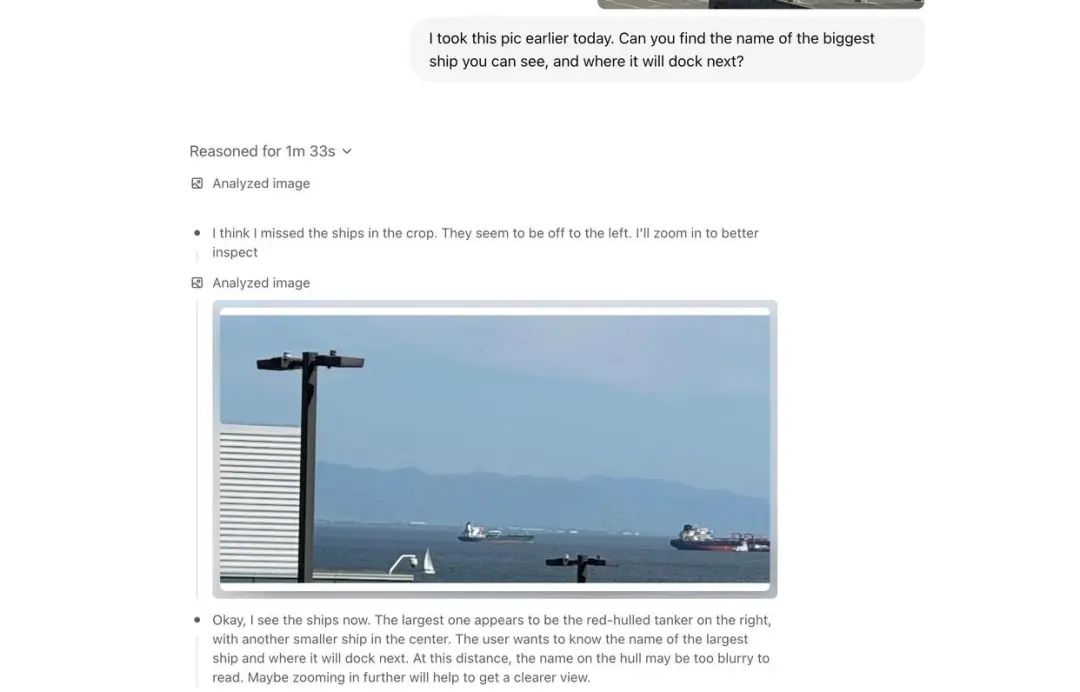

OpenAI 具体将这些模型描述为其首个能够在看图像时“思考”的模型,这意味着它们可以“将视觉信息直接纳入推理过程,而不仅仅是简单地看图像”。

当用户通过“o3”模型上传白板、绘图、图表等各种图像时,AI会对其进行分析。

这些模型可以理解模糊或低质量的图像,并可以执行放大和旋转图像等操作。

除了图像分析之外,用户还可以直接在浏览器中运行 Python 代码并执行网络搜索。

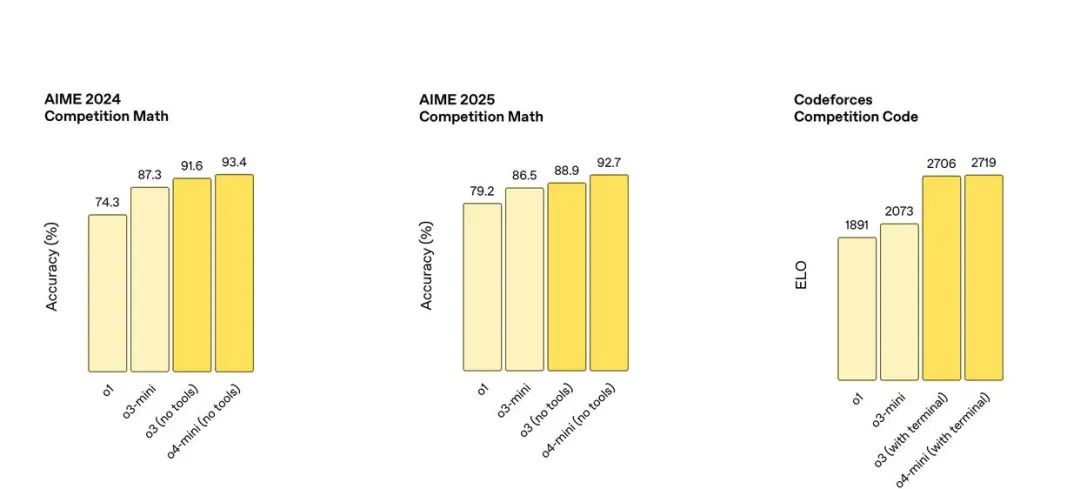

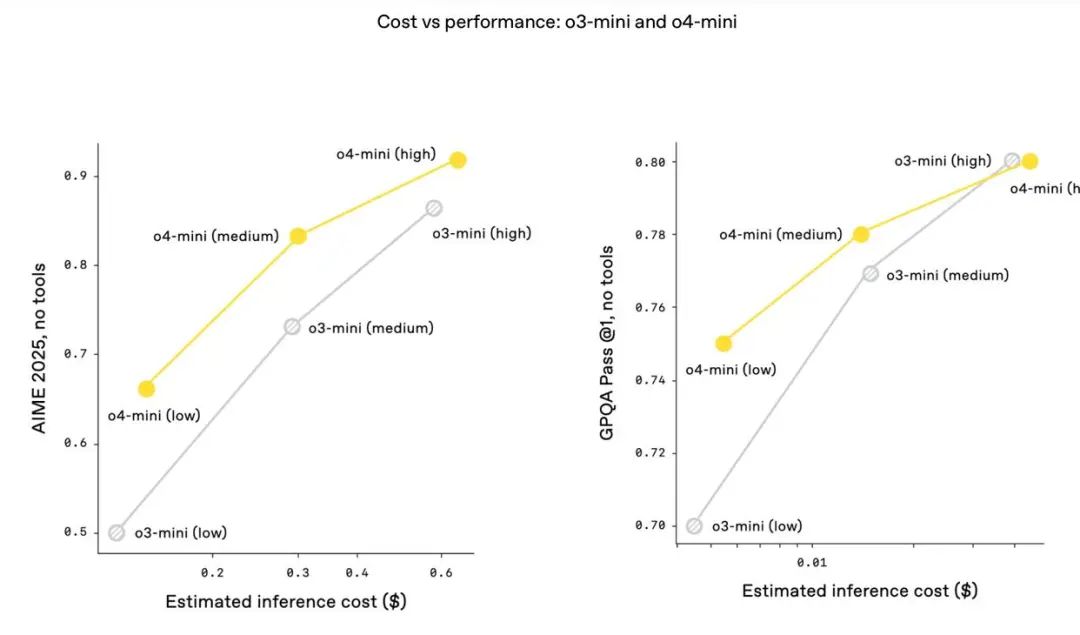

据最新测试结果,o3和o4-mini(无工具版本)在AIME 2024数学竞赛题目中的准确率分别达91.6%和93.4%,远超前代模型o1的74.3%。在AIME 2025题目中,两者准确率分别达88.9%和92.7%。在Codeforces编程竞赛评分中,支持终端工具的o3和o4-mini分别取得了2706和2719的ELO分数,显著领先于o1的1891和o3-mini的2073,显示出在复杂数学与代码任务中的强大推理与执行能力。

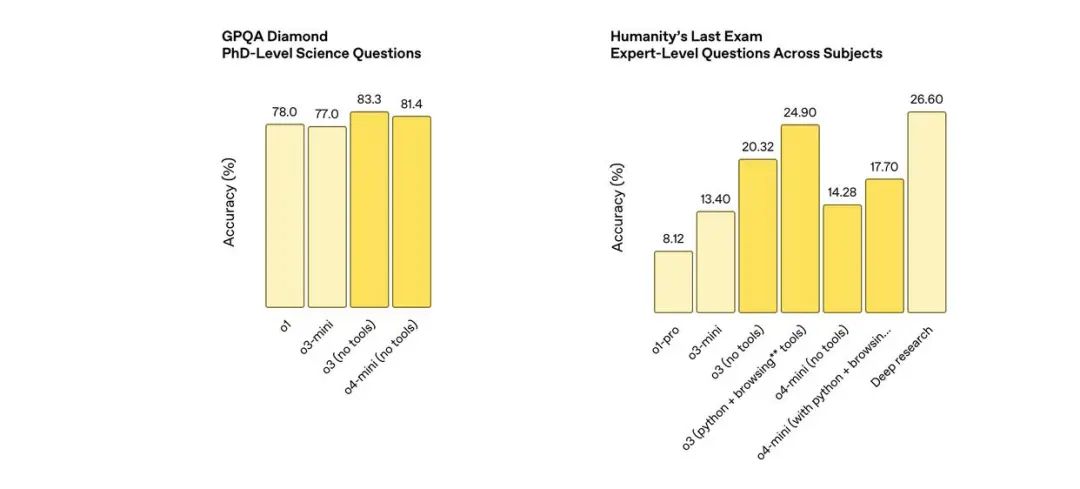

同时,o3(无工具)在博士水平科学问答中的准确率为83.3%,高于前代模型o1的78.0%,而o4-mini(无工具)也紧随其后,达81.4%。在右图所示的“人类最后的考试”高难度跨学科题目中,开启Python与浏览工具的o3模型准确率达24.9%,显著优于o1-pro的8.12%和o3-mini的13.4%,显示出多工具组合在处理复杂问题上的巨大潜力。值得注意的是,Deep Research实验系统在该测试中表现最佳,准确率达26.6%。这进一步突显OpenAI新模型在推理链、跨模态理解和工具协同方面的持续进步。

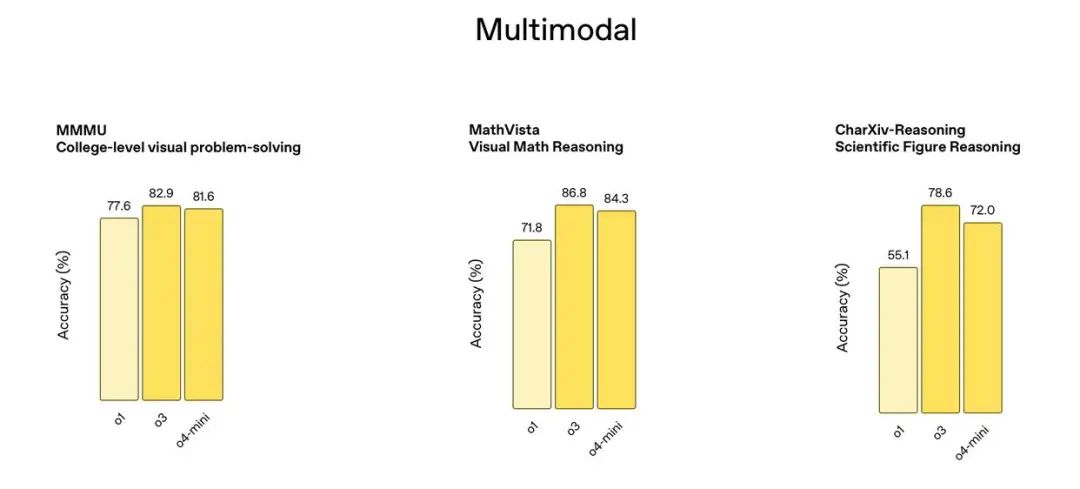

在多模态推理方面,OpenAI新发布的o3和o4-mini模型在多项视觉推理测试中全面超越前代模型o1。在MMMU大学级视觉问题解决任务中,o3的准确率达82.9%,领先于o1的77.6%;o4-mini表现相近,为81.6%。在MathVista视觉数学推理测试中,o3取得86.8%的成绩,远高于o1的71.8%;而o4-mini则达84.3%。在CharXiv科学图表推理测试中,o3的准确率为78.6%,大幅领先o1的55.1%,o4-mini则达到72%。整体来看,o3在处理图像与文本结合任务中展现出强大能力,o4-mini则在保持高性能的同时提升了响应速度与成本效率,展现出OpenAI多模态模型在复杂视觉任务中的显著进展。

与此同时,o4-mini则提供了价格、速度和性能之间的“有竞争力的平衡”,这是开发者在选择AI模型为其应用提供支持时经常考虑的三大因素。两款模型现已向OpenAI付费用户开放。

OpenAI在公告中写道,o3和o4-mini是首批能够“图像思维”的AI模型:

“这是我们首次推出能够独立使用全部ChatGPT工具的推理模型——包括网页浏览、Python编程、图像理解和图像生成能力。这使得它们在解决复杂的多步骤问题时更加高效,并朝着自主执行任务的方向迈出了真正一步。”

该公司解释称,这意味着“它们不仅能看图,还能将视觉信息直接整合进推理链条之中”。

这些模型将从今天开始向 ChatGPT Plus、Pro 和 Team 等付费客户开放,同时还将提供“o4 mini hihg”版本,该版本需要更多时间来创建答案,以提高答案的可靠性。

OpenAI 计划在未来几周内为 ChatGPT Pro 订阅者发布“o3”的增强版“o3-Pro”。该模型可以利用更多的计算资源来生成更复杂的响应。

OpenAI 首席执行官 Sam Altman 表示:“o3 和 o4 mini 可能是 GPT-5 推出之前的最后几个独立 AI 推理模型。” GPT-5 将作为集成现有 GPT-4.1 模型和推理模型的下一代模型推出。