•

通过模拟真实工作负载验证AI基础设施的性能

•

通过评估新算法、组件或协议提高AI训练的性能

•

在不投资昂贵的大规模部署的情况下,调整和优化AI工作负载和系统基础设施的参数

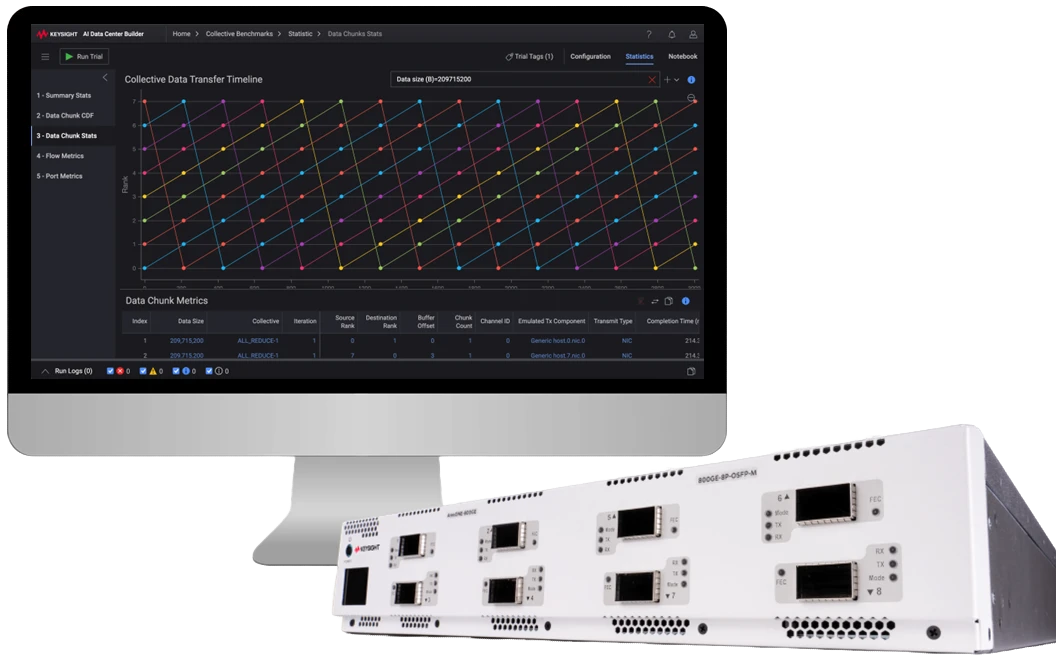

是德科技(NYSE:KEYS)推出Keysight AI (KAI)数据中心构建器,这是一款先进的软件套件,通过模拟真实工作负载来评估新算法、组件和协议对AI训练性能的影响。KAI数据中心构建器的工作负载模拟功能将大型语言模型(LLM)和其他人工智能(AI)模型训练工作负载集成到AI基础设施组件的设计和验证中——包括网络、主机和加速器。该解决方案实现了硬件设计、协议、架构和AI训练算法之间的更紧密协同,提升系统性能。

Keysight AI (KAI)数据中心构建器是一款先进的软件套件,通过模拟真实工作负载来评估新算法、组件和协议对AI训练性能的影响。

AI服务提供商使用各种并行处理策略(也称为数据或模型并行)来加速AI模型训练。将模型并行与AI集群拓扑和配置对齐可以提高训练性能。在AI集群设计阶段,关键问题最好通过实验来回答。许多问题集中在图形处理单元(GPU)之间的数据传输效率上。关键考虑因素包括:

•

AI主机或机架内GPU互连的scale up设计

•

Scale out网络设计,包括每个GPU的带宽和拓扑

•

网络负载均衡和拥塞控制的配置

•

训练框架参数的调整

KAI数据中心构建器的工作负载模拟解决方案再现了真实AI训练任务的网络通信模式,加速实验,降低达到熟练程度所需的学习曲线,并更深入洞察性能下降的原因,这些是通过真实AI训练任务实验难以获得的。是德科技客户可以访问包括GPT和Llama在内的LLM工作负载库,以及数据并行(DP)、全分片数据并行(FSDP)和三维(3D)并行等流行的模型分区方案。

使用KAI数据中心构建器中的工作负载模拟应用程序,AI服务提供商可以:

•

实验并行参数,包括并行数据大小及其在可用AI基础设施上的分布(调度)

•

了解并行内和并行间通信对整体任务完成时间(JCT)的影响

•

识别低性能的集合通信操作并深入识别瓶颈

•

分析网络利用率、尾部延迟和拥塞,了解它们对JCT的影响

KAI数据中心构建器的新工作负载模拟功能使AI服务提供商、GPU云提供商和基础设施供应商能够将真实的AI工作负载引入其实验室环境,以验证AI集群和新组件的不断演变的设计。他们还可以通过实验微调模型并行方案、参数和算法,以优化基础设施并提高AI工作负载性能。

KAI数据中心构建器是是德科技人工智能(KAI)架构的基础,这是一系列端到端解决方案,旨在通过使用真实AI工作负载模拟验证AI集群组件,帮助客户在数据中心扩展人工智能(AI)处理能力。

是德科技在2025年4月1日至3日于旧金山Moscone中心举行的OFC 2025会议上展示KAI数据中心构建器及其工作负载模拟功能,展位号1301。