最近这段时间,“DeepSeek”(深度求索)人工智能平台非常的火爆,正确的使用可以帮我们做很多很多事情,通常我们是在浏览器网页或手机APP使用,但是有时会受到本地网络或者远程服务器等限制,导致使用卡顿或无回复。

本文介绍在个人电脑本地部署DeepSeek-R1模型,部署完成之后,就可以在本地离线使用,而无需网络连接,能够为用户提供更高效的解决方案。

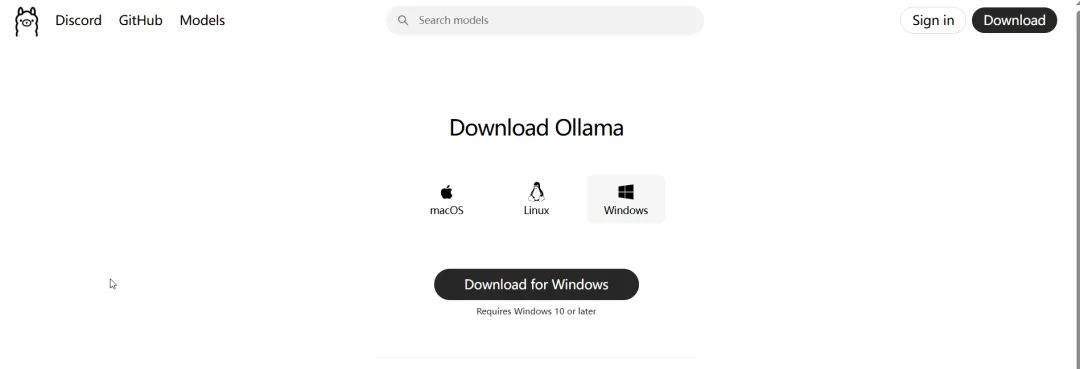

为了能在我们个人电脑本地部署DeepSeek,需要先下载两个软件,这两个软件都是免费下载使用的。

官方下载地址:

https://ollama.com/download/windows

Chatbox AI 是一款 AI 客户端应用和智能助手,支持众多先进的 AI 模型和 API,可在 Windows、MacOS、Android、iOS、Linux 和网页版上使用。

官方下载地址:

https://chatboxai.app/zh

同样支持多种平台,目前最新版本是1.10.4,安装包大小为146MB。

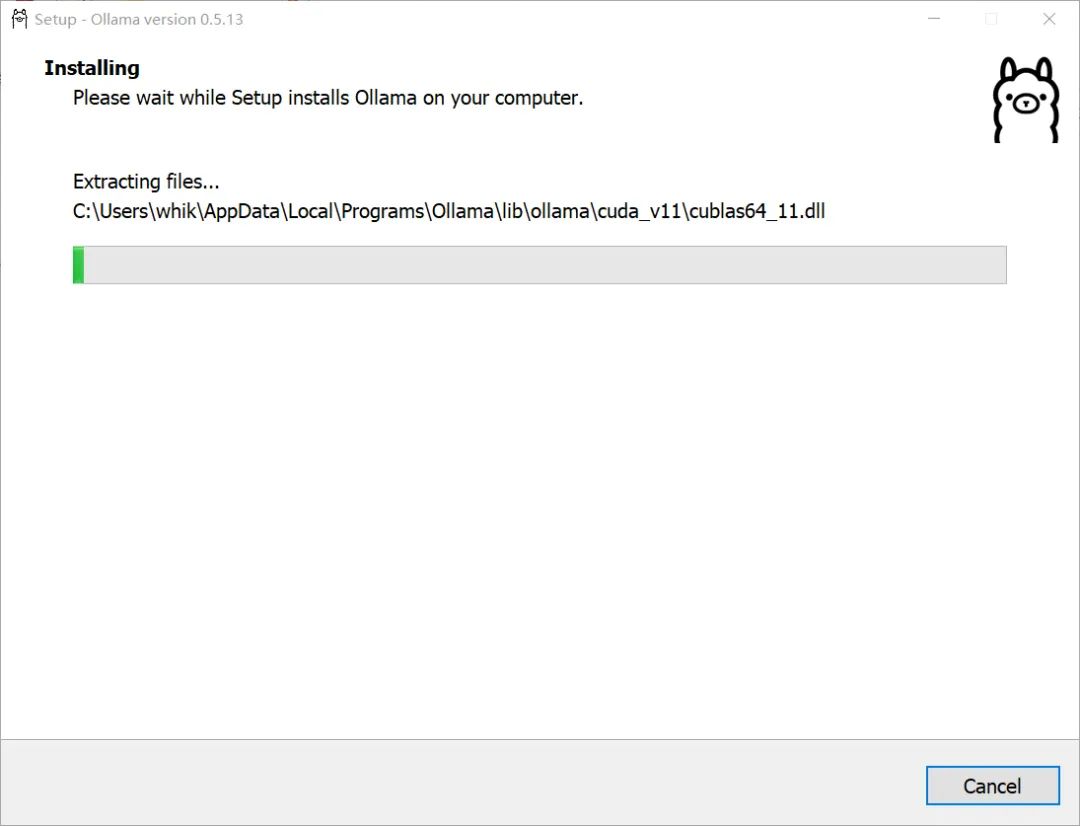

下载完成之后,直接双击安装包进行安装。

Ollama默认无法修改安装路径,默认安装在C盘,可以通过命令行的方式来自定义安装位置,由于涉及到环境变量等操作,这里我们不做介绍,采用默认的双击安装方式。

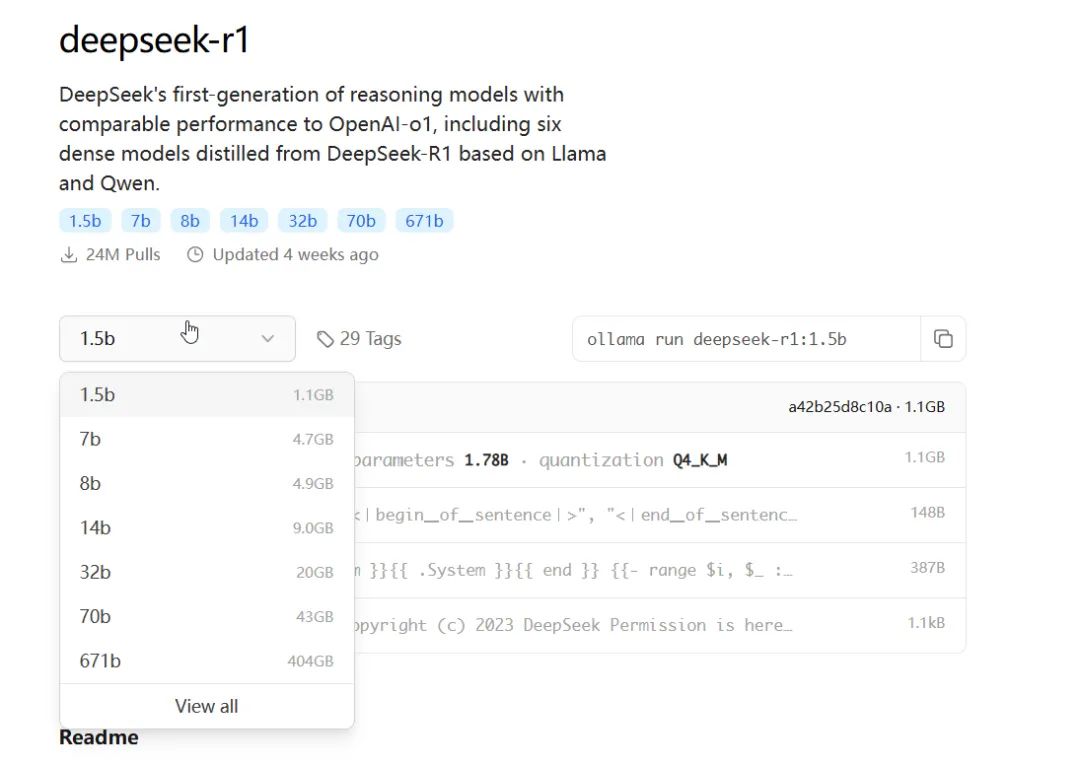

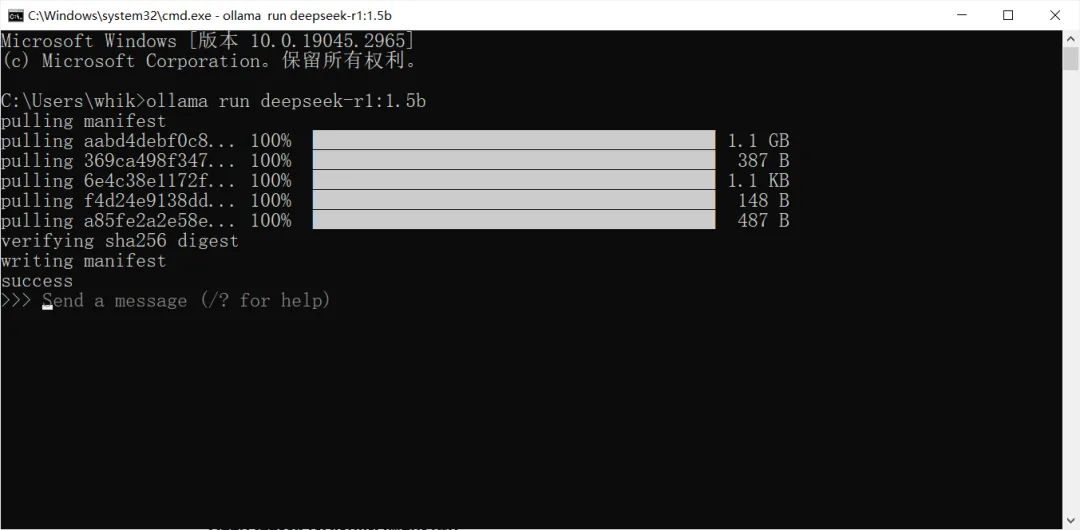

目前DeepSeek为了满足不同性能平台的需求,有多种参数量的模型库可供选择,有1.5b、7b、8b、14b、32b、70b和671b,b代表十亿参数量。1.5b版本模型库文件最小,只有1.1GB。

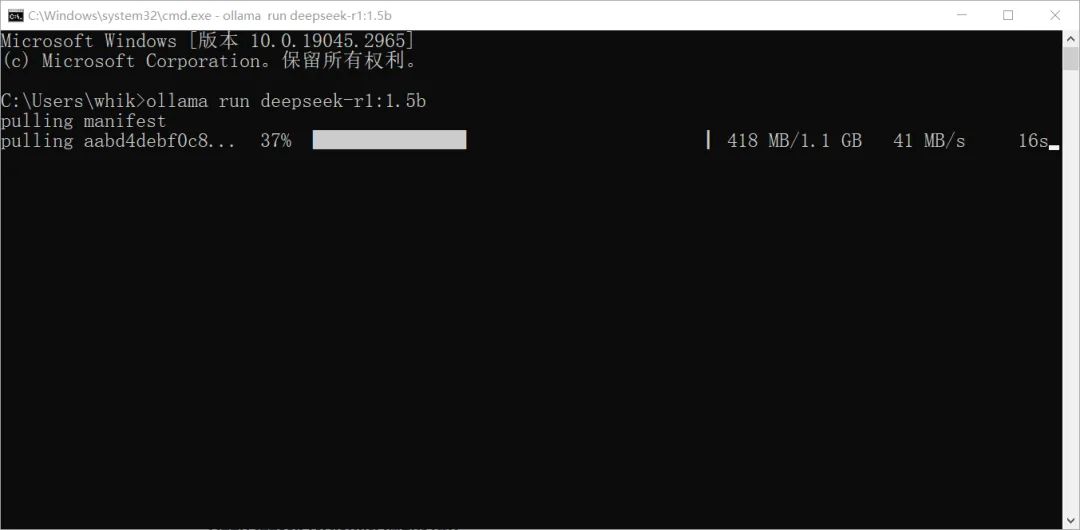

安装完成之后,打开CMD窗口,输入如下命令来安装DeepSeek-R1 1.5b:

ollama run deepseek-r1:1.5b

部署进度和网络情况有关:

等待安装完成后,关闭cmd窗口。

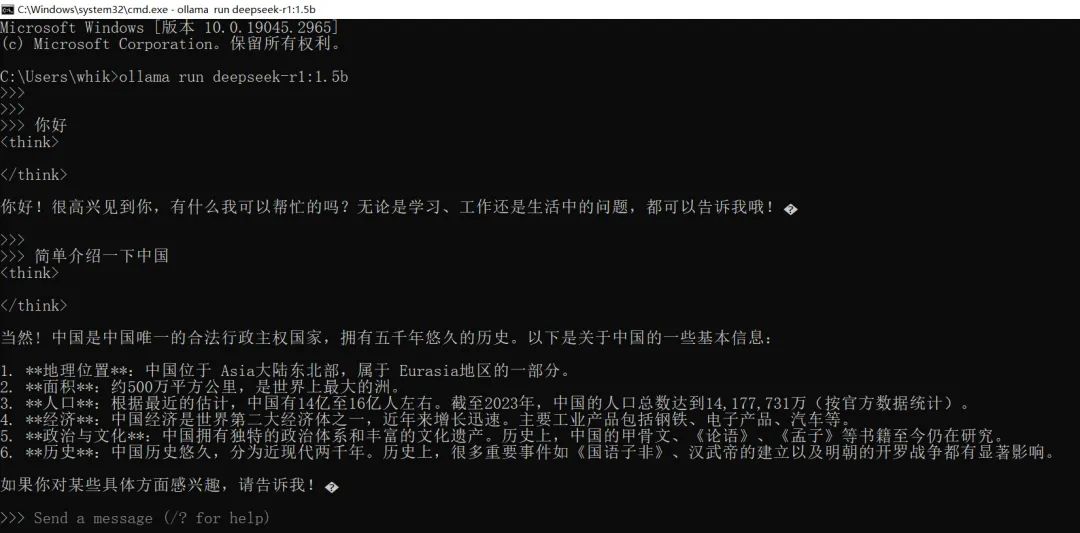

至此,DeepSeek-R1 1.5b版本就已经被部署到我们的电脑本地了,即时断开网络连接也可以正常使用,下面我们来简单体验一下,打开CMD窗口,输入如下命令运行DeepSeek模型:

ollama run deepseek-r1:1.5b

输入我们的问题后按回车键,就会得到DeepSeek给我们的回应。

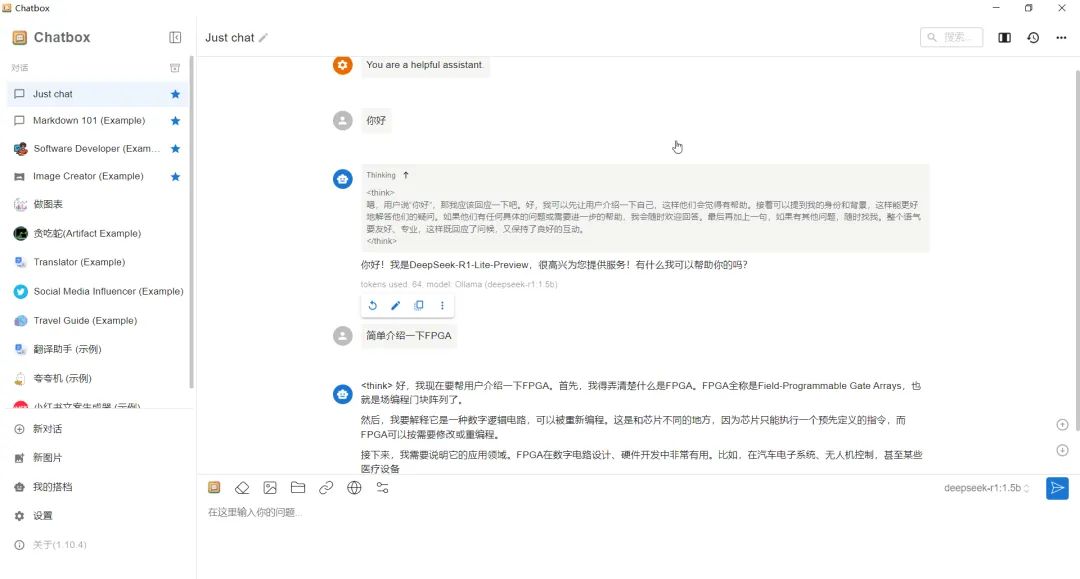

虽然我们可以通过CMD窗口进行对话,但是相对不那么直观,我们可以通过第三方客户端来实现对话聊天的效果。

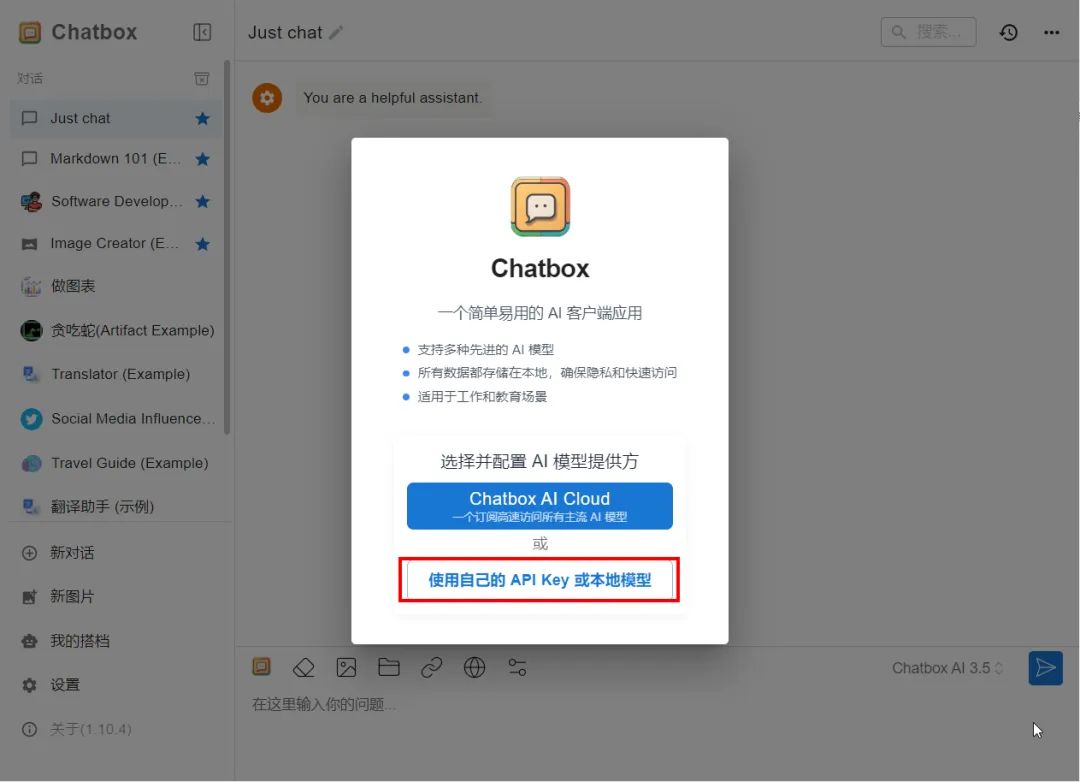

打开ChatBox软件,选择使用自己的本地模型。

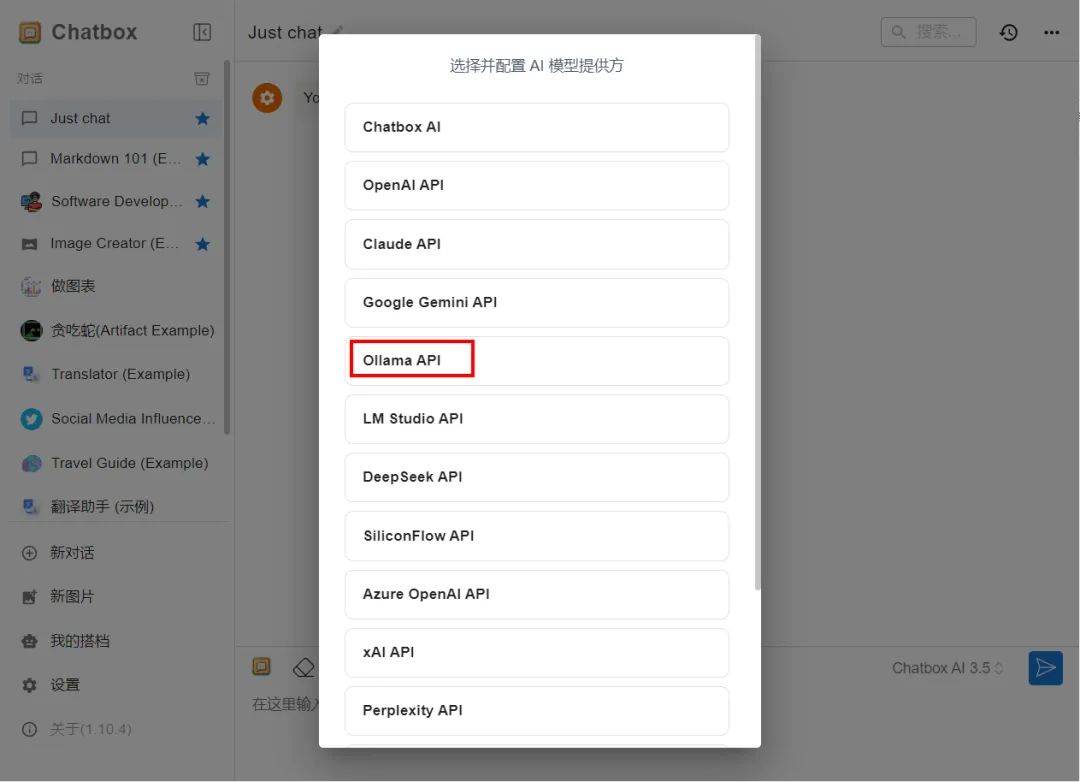

模型提供方选择Ollama

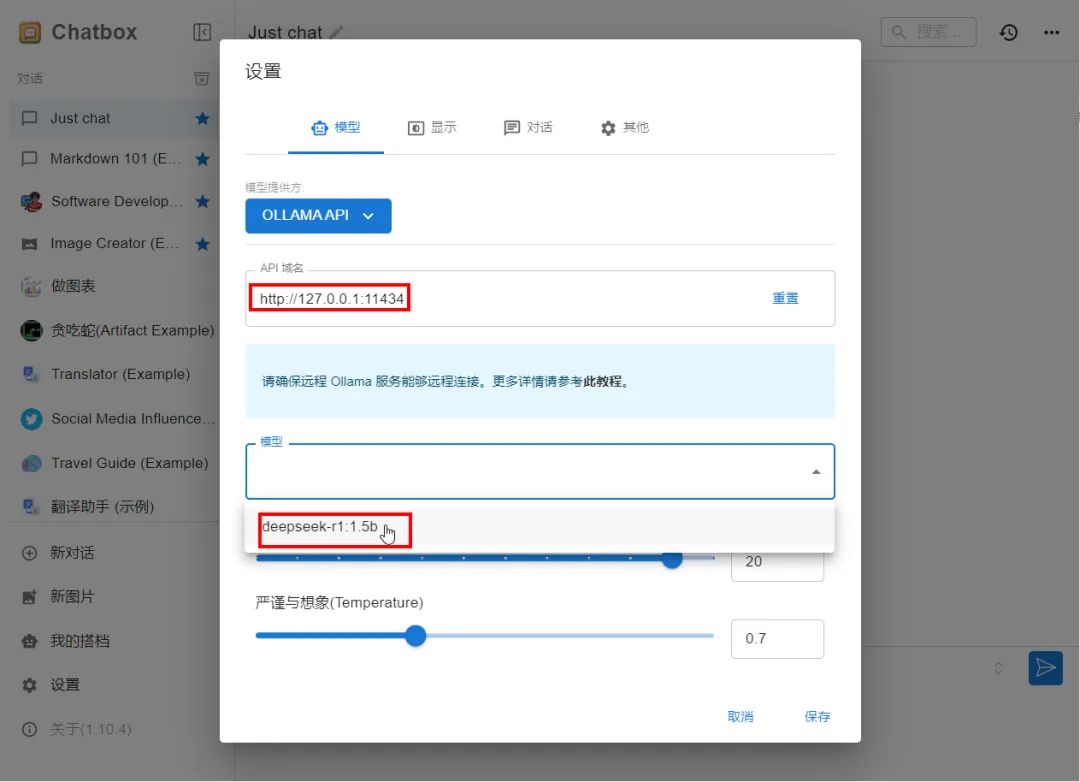

配置我们刚才下载的DeepSeek-R1:1.5b模型文件。

好了,尽情的使用DeepSeek吧!

虽然官方推荐的显卡要求是RTX3060及以上,但是在我笔记本电脑(MX450显卡)上也可以正常运行。