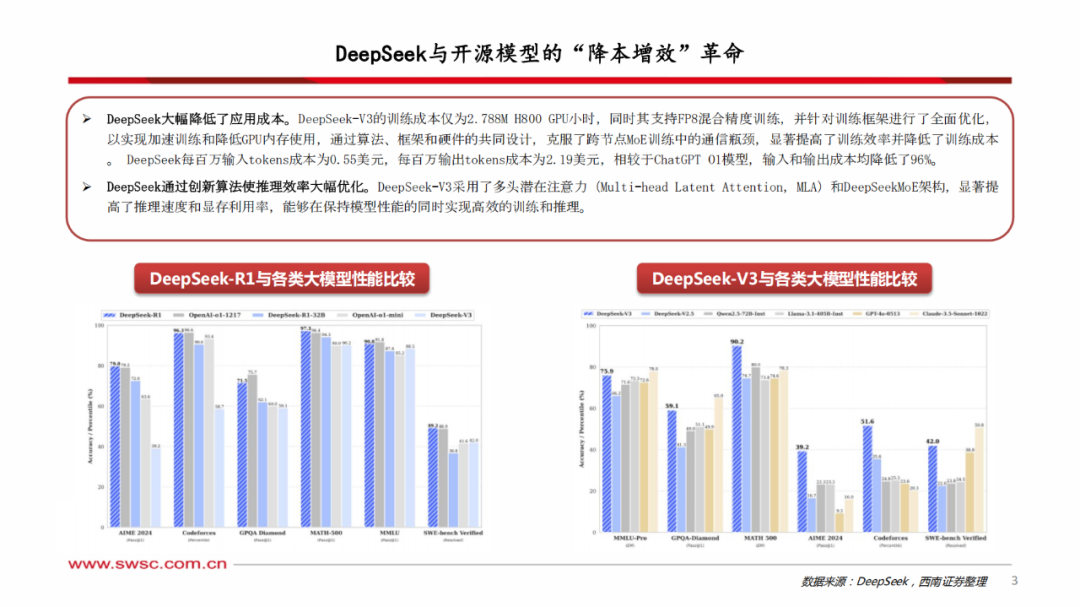

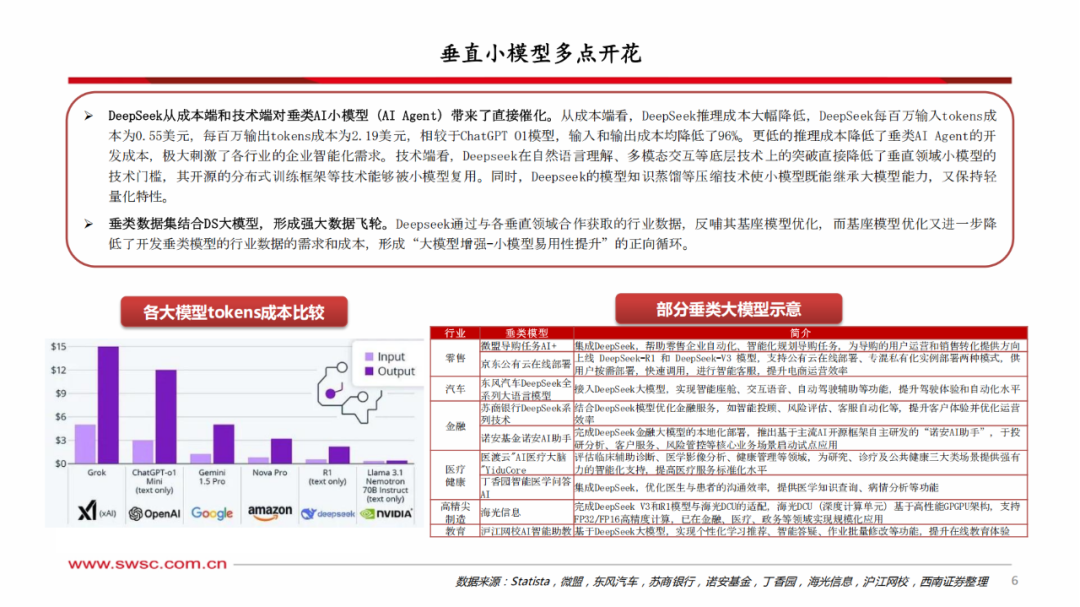

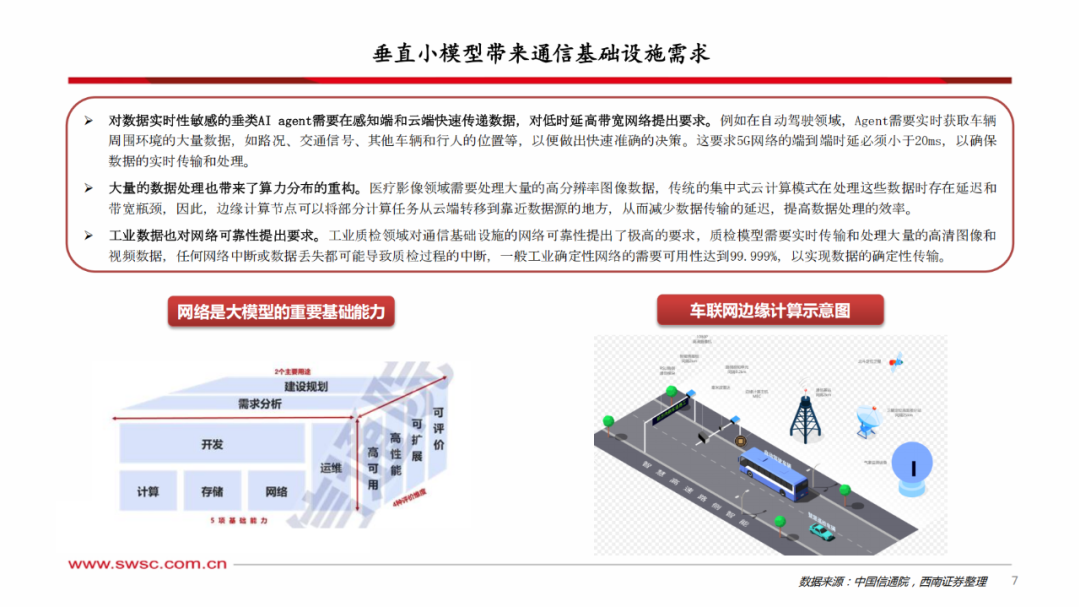

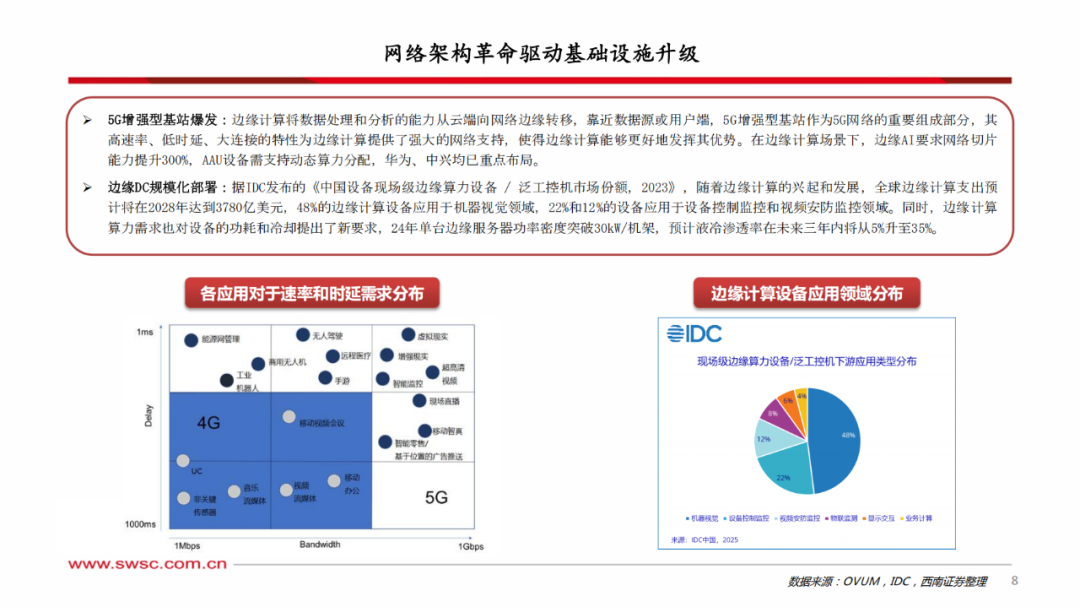

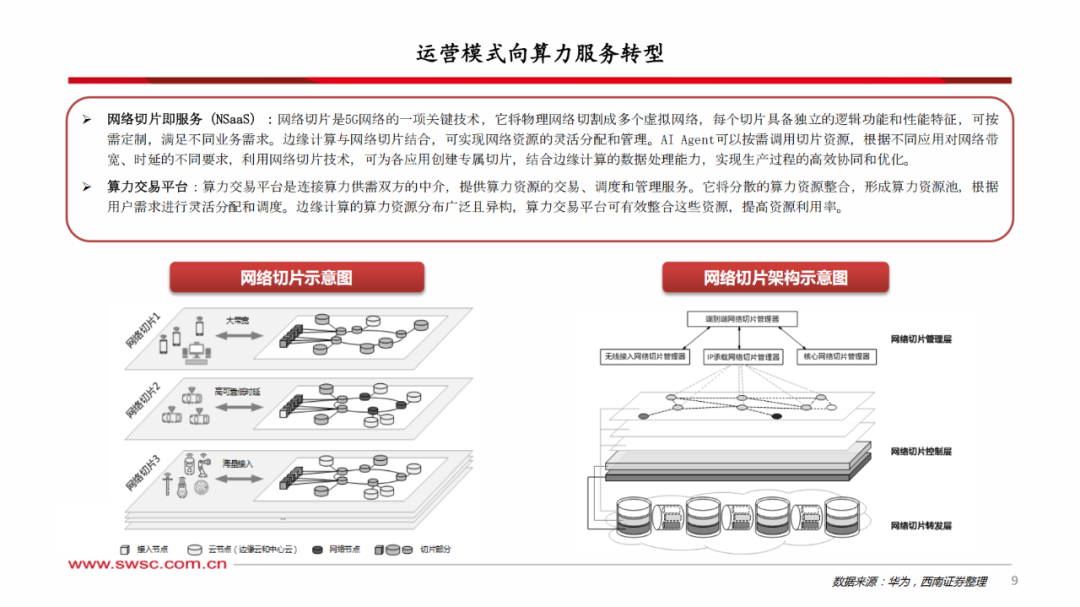

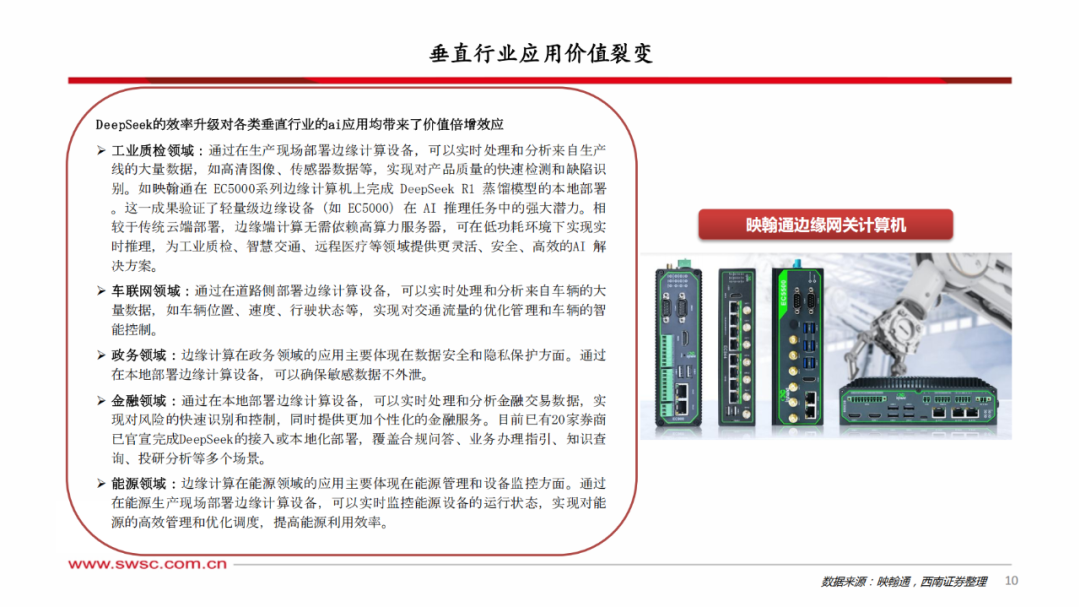

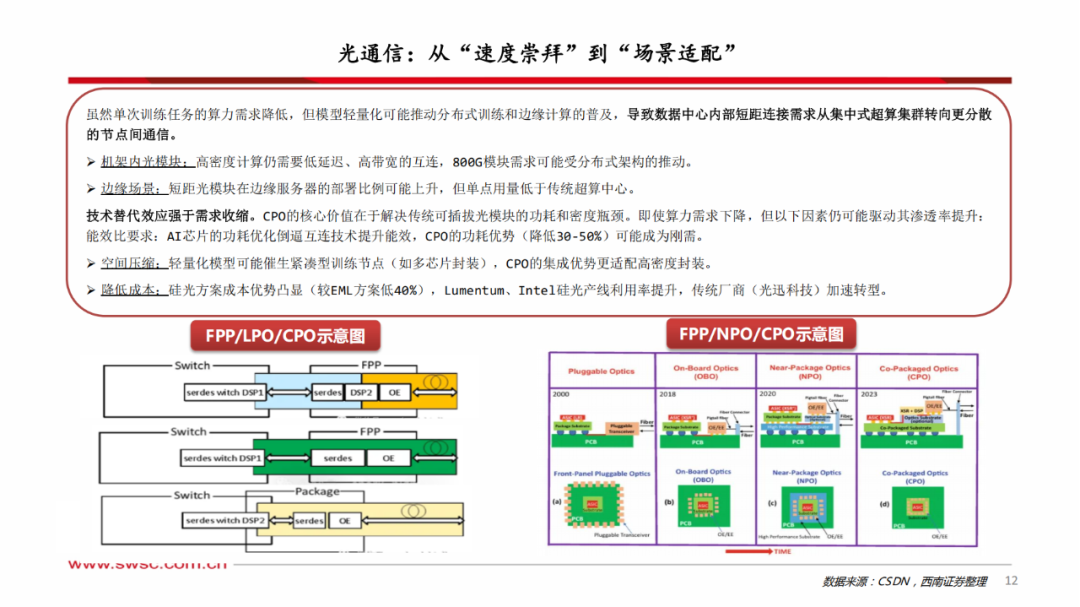

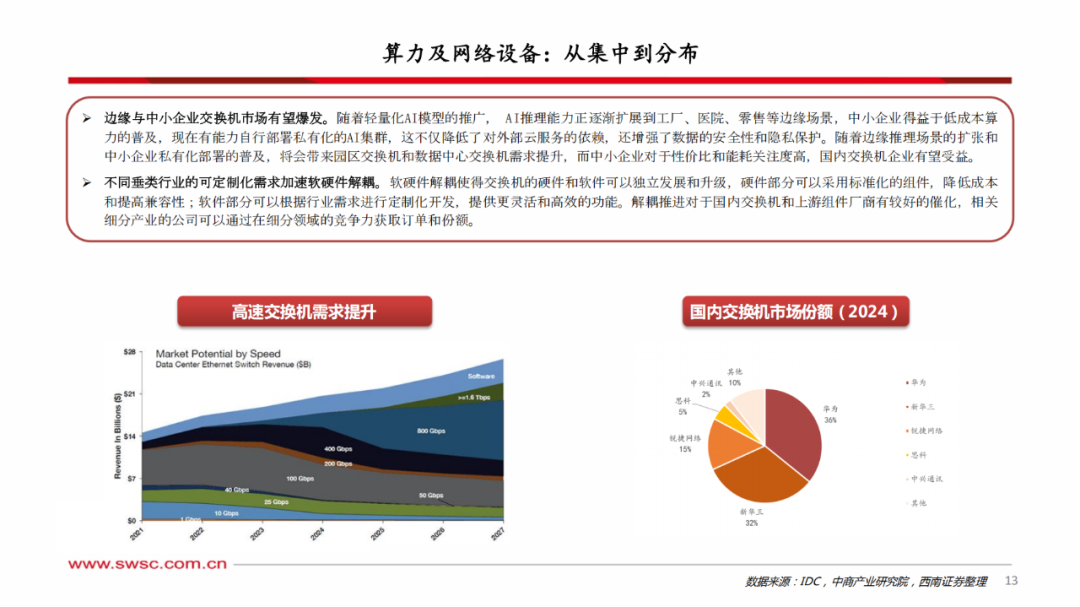

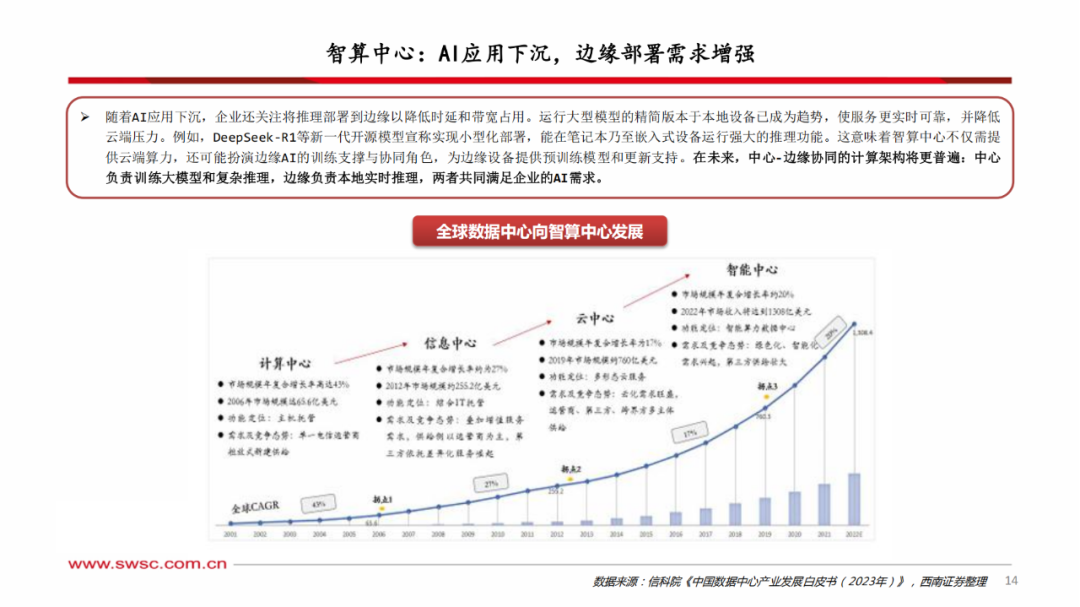

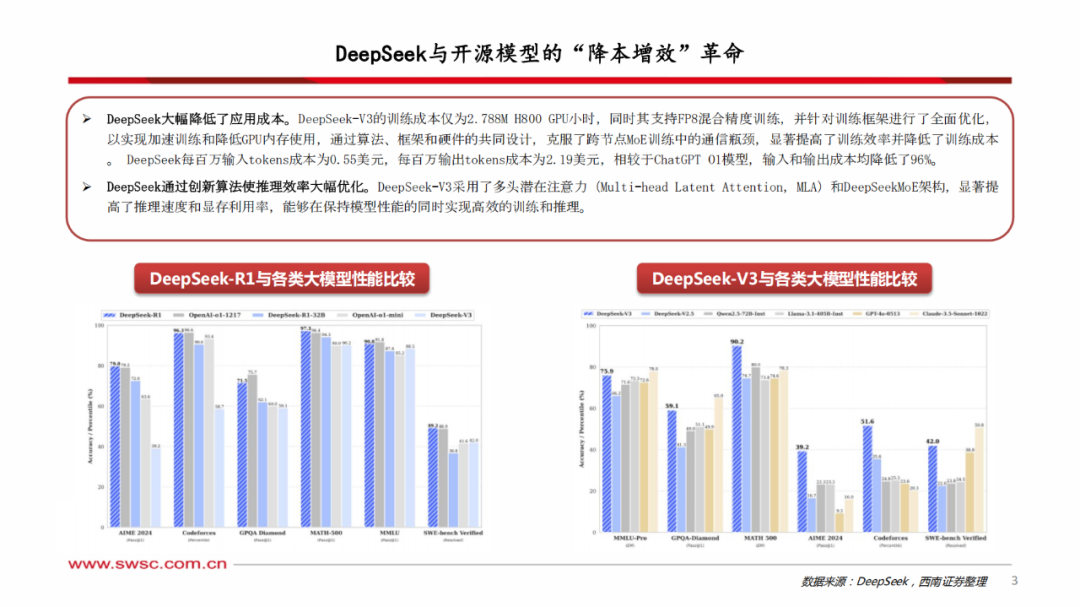

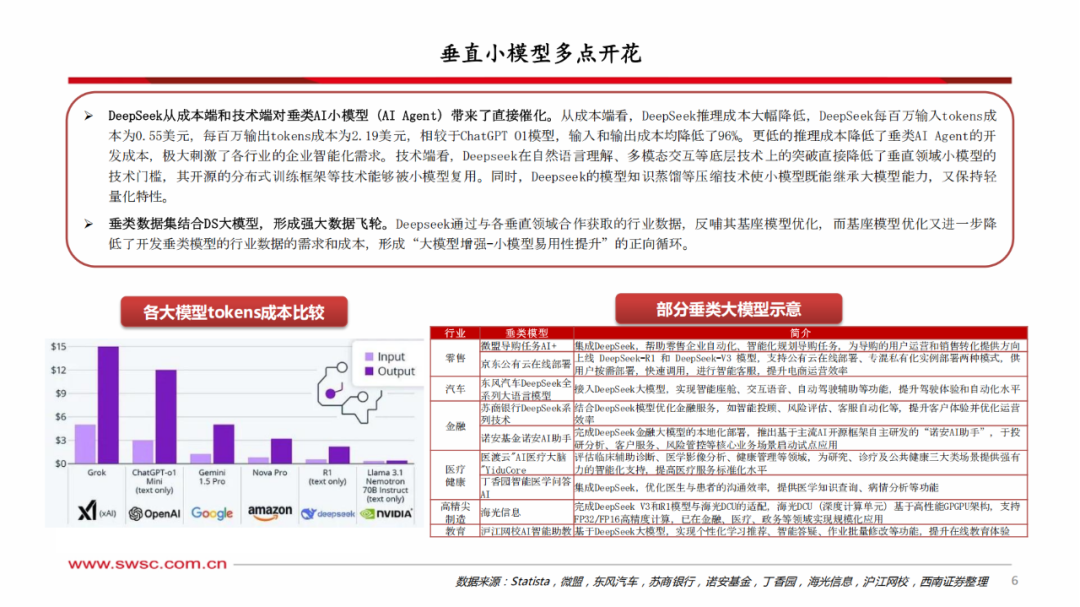

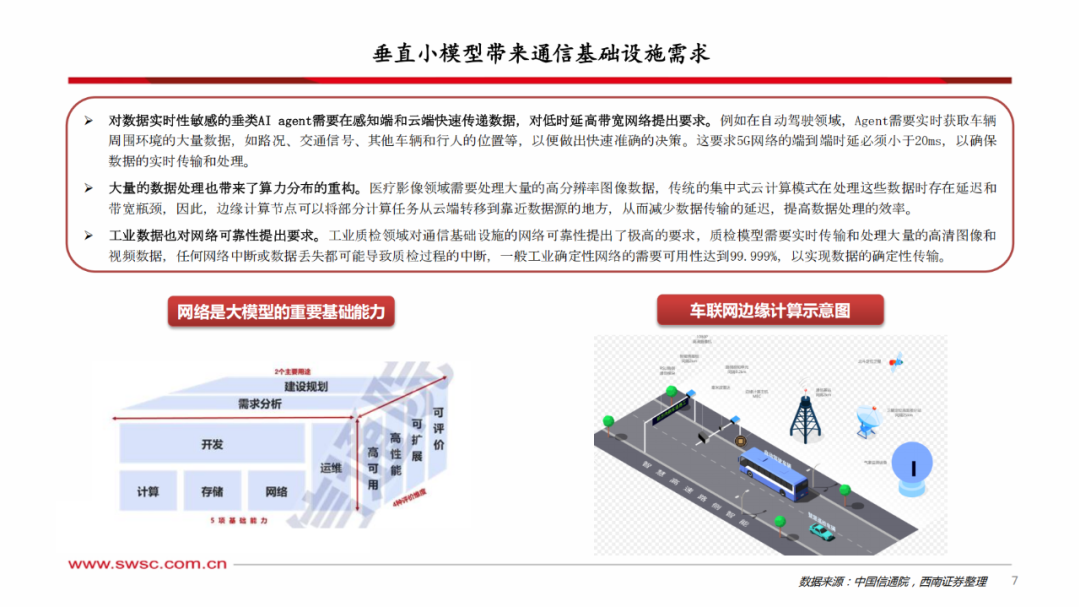

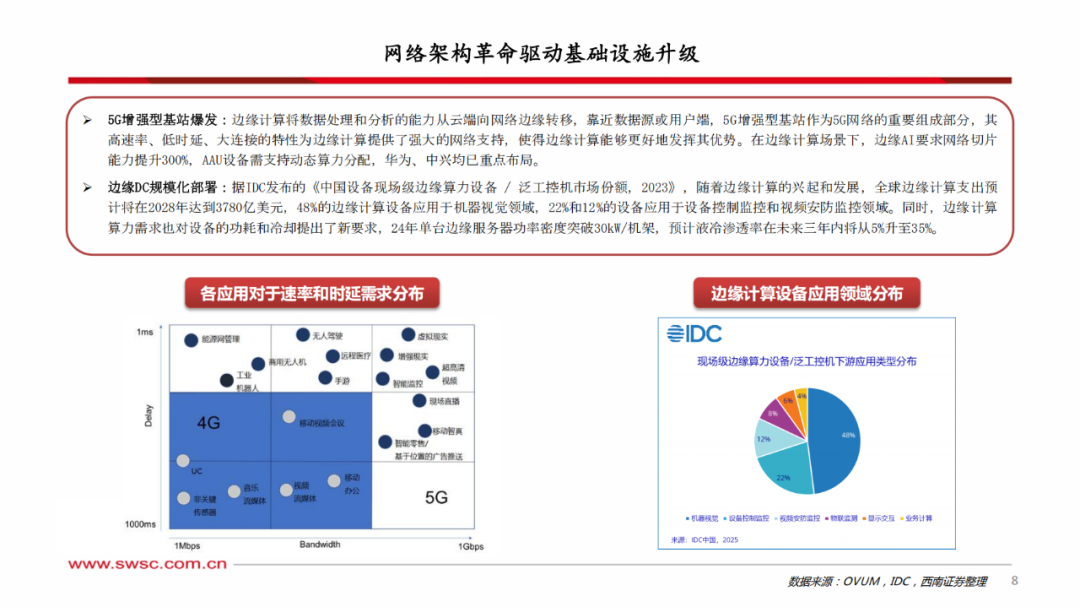

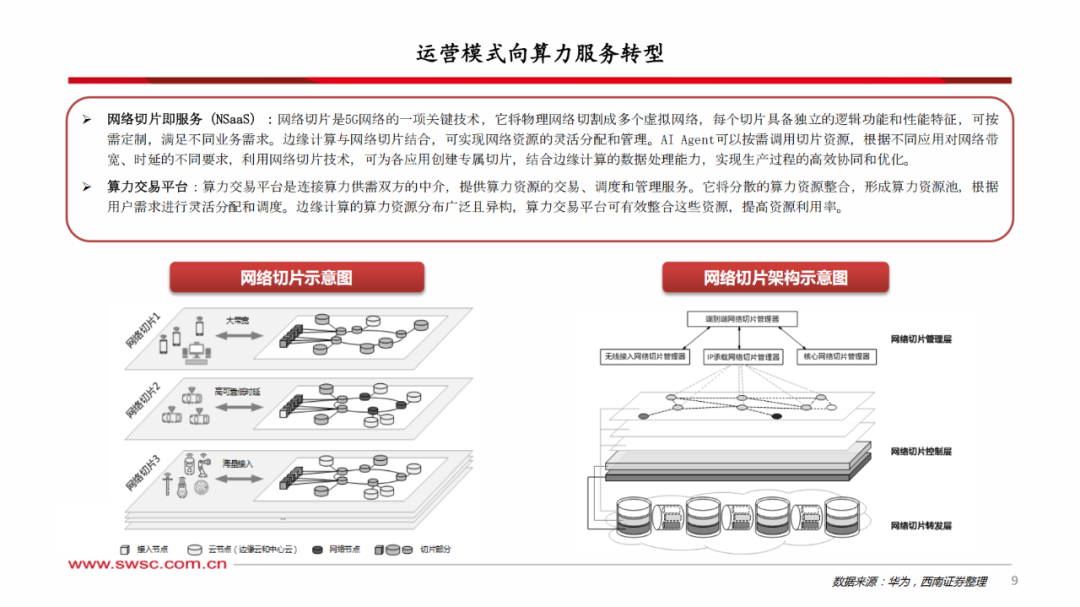

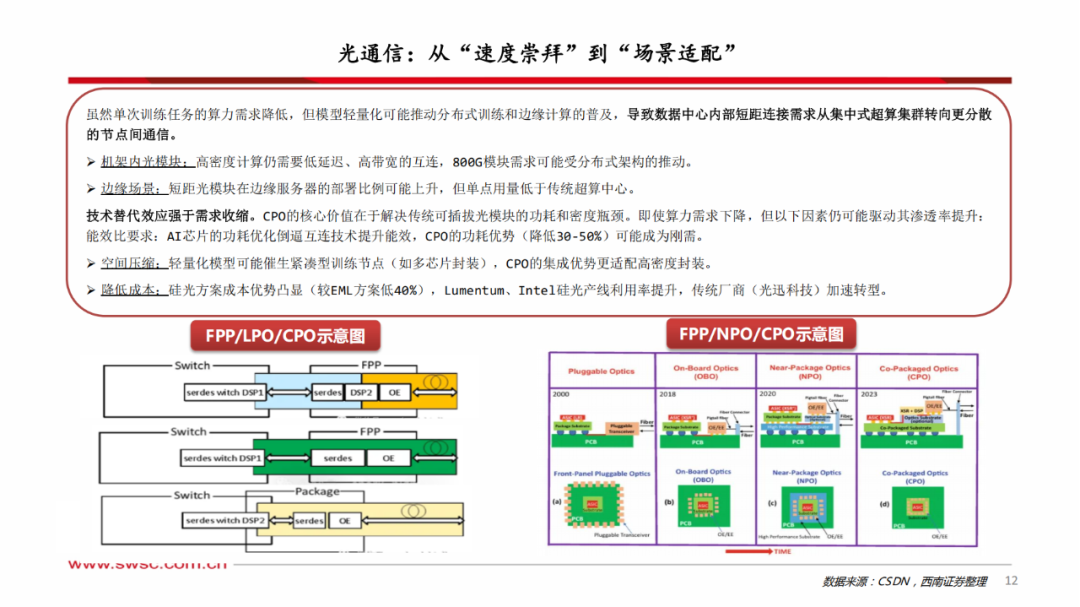

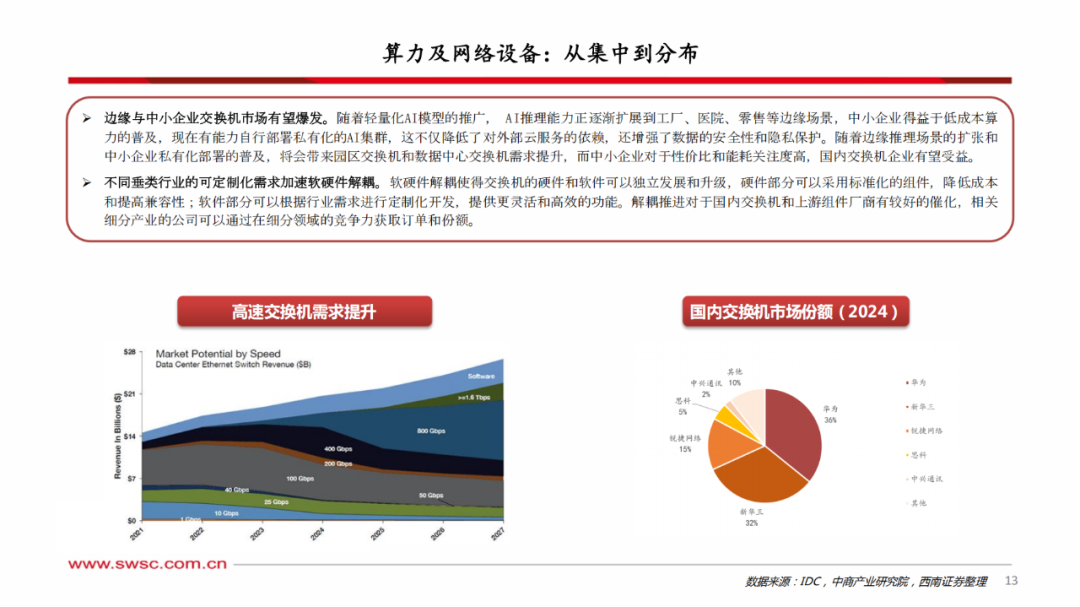

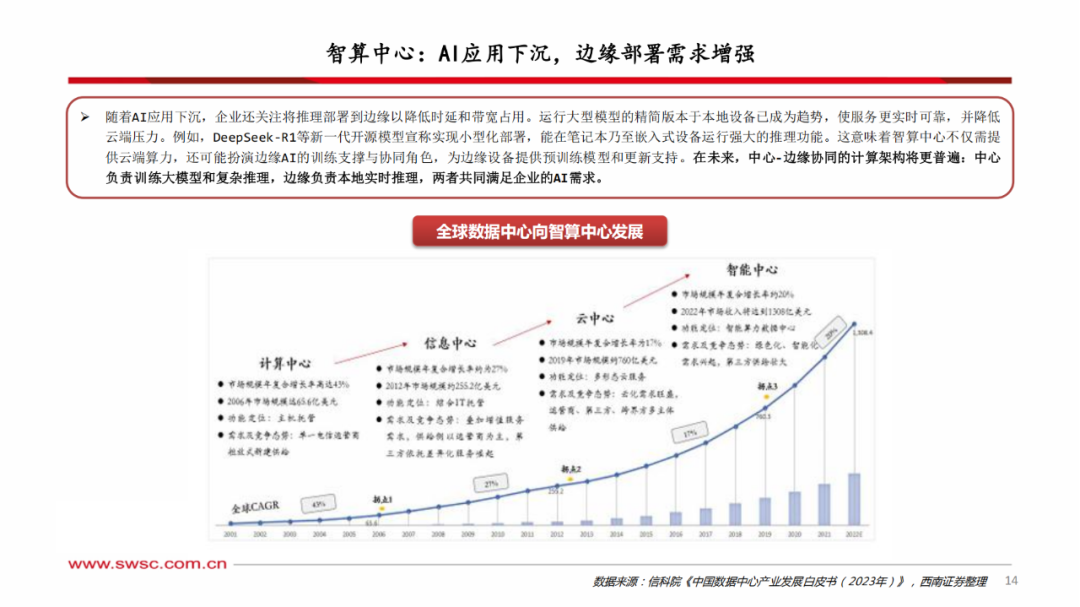

本文来自“Deepseek引爆通信产业新机遇”。DeepSeek-V3的训练成本仅为2.788M H800 GPU小时,同时其支持FP8混合精度训练,并针对训练框架进行了全面优化,以实现加速训练和降低GPU内存使用,通过算法、框架和硬件的共同设计,克服了跨节点MoE训练中的通信瓶颈,显著提高了训练效率并降低了训练成本。 DeepSeek每百万输入tokens成本为0.55美元,每百万输出tokens成本为2.19美元,相较于ChatGPT O1模型,输入和输出成本均降低了96%。DeepSeek-V3采用了多头潜在注意力(MLA)和DeepSeekMoE架构,显著提高了推理速度和显存利用率,能够在保持模型性能的同时实现高效的训练和推理。从成本端看,更低的推理成本降低了垂类AI Agent的开发成本,极大刺激了各行业的企业智能化需求。技术端看,Deepseek在自然语言理解、多模态交互等底层技术上的突破直接降低了垂直领域小模型的技术门槛,其开源的分布式训练框架等技术能够被小模型复用。同时,Deepseek的模型知识蒸馏等压缩技术使小模型既能继承大模型能力,又保持轻量化特性。对数据实时性敏感的垂类AI agent需要在感知端和云端快速传递数据,对低时延高带宽网络提出要求,同时小模型下沉到中小企业,进一步带来了网络通信基础设施需求,对交换机、边缘计算设备、5G切片等带来新需求。光模块等需求来源从训练转向推理,带来多场景适配需求。虽然单次训练任务的算力需求降低,但模型轻量化可能推动分布式训练和边缘计算的普及,导致数据中心内部短距连接需求从集中式超算集群转向更分散的节点间通信。机架内光模块对于高密度计算仍需要低延迟、高带宽的互连,800G模块需求可能受分布式架构的推动。而在边缘场景,短距光模块在边缘服务器的部署比例可能上升,但单点用量低于传统超算中心。同时,技术替代效应强于需求收缩,CPO的核心价值在于解决传统可插拔光模块的功耗和密度瓶颈,即使算力需求下降,但对于能效比要求、空间压缩要求、降低成本要求仍可能驱动其渗透率提升。清华大学:DeepSeek从入门到精通(2025)DeepSeek重塑开源大模型生态,AI应用爆发持续推升算力需求中国AI搜索行业发展报告(2024):科技普惠带来搜索变革DeepSeek R1是AGI的里程碑,中长期利好算力硬件DeepSeek大模型实现训练降本,有望加快AI应用场景落地专访幻方梁文锋:AI界的拼多多——揭秘DeepSeek1、DeepSeek v2专家混合模型白皮书

2、DeepSeek Coder 模型服务协议DeepSeek-R1:强化学习+知识蒸馏,比肩OpenAI o1DeepSeek发布高性价比开源模型,有望拉平模型差距,加速AI与应用发展1、科技行业专题报告:DeepSeek:技术颠覆or创新共赢

2、DeepSeek之AI大模型解读:模型成本大幅下降,国产化全方位加速

3、传媒:DeepSeek带来的AI变革

下载链接:

浙江图灵算力研究院:RISC-V芯片产业发展报告(2024)重磅报告:2024-2026年中国信创硬件产业发展建议报告1、2024先进液冷AI一体机报告

2、2024AI网络光交换机技术报告

3、2024边缘计算AI推理技术场景与挑战

4、2024年AI数据中心网络建网参考报告3、《14份半导体“AI的iPhone时刻”系列合集》8、《3+份技术系列基础知识详解(星球版)》

亚太芯谷科技研究院:2024年AI大算力芯片技术发展与产业趋势

【华为】AI Ready的数据基础设施参考架构白皮书

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。