2025年计算机策略报告:披荆斩棘,硕果累累

8、《3+份技术系列基础知识详解(星球版)》

亚太芯谷科技研究院:2024年AI大算力芯片技术发展与产业趋势

【华为】AI Ready的数据基础设施参考架构白皮书

智源研究院:2025年十大AI技术趋势

36氪研究院:年轻人2024“有问题就问”AI助手报告

AI图景解码50关键词:快思考与慢思考

1、AI 模型参数规模将超百万亿,超长序列成为主流标配。从 2024 年 AI 行业的发展趋势来看,大模型 Scaling Law 依然保持旺盛生命力,万亿甚至百万亿参数规模的大模型成为必然趋势。以Sora为例,视频生成场景需要使用长达百万长度的序列,例如 60 秒的视频需要1M的序列长度、10 分钟视频则需要 10M 序列长度,这标志着序列长度将成为衡量模型能力的重要指标。

2、以太推动智算网络开放互联,百万卡集群成为共识。在产业界共同努力下,智算网络呈现出两方面的演进趋势:一是以太将成为智算网络开放互联的基础,二是百万卡集群规模成为行业共识。

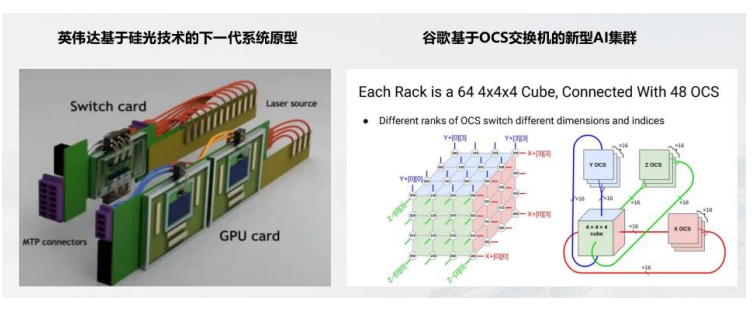

3、融合将成为智算网络演进的主路径。从宏观技术发展趋势来看,“融合”将成为智算网络演进的关键驱动。传统的总线技术(如PCIe、NVlink)和网络技术(如Ethernet、Infiniband)之间的界限将变得更为模糊,总线网络化和网络总线化的趋势将同步进行。

其次,电互联和光互联的技术融合将推动智算网络在架构和成本方面的革新。若按当前算力芯片的发展速度来看,IO 密度与功耗将成为难以突破的瓶颈。

4、新型大容量网络芯片将成为智算网络发展的基石。随着智算业务对高速互联需求的持续攀升,新型大容量网络芯片正处于高速发展阶段,呈现如下趋势:

容量持续增长,单比特功耗不断降低。在 AI 驱动下,未来网络芯片预计将迅速突破100T容量,单比特功耗将进一步降低。同时,400G/800G DPU 网卡需求也将迎来井喷。

面向 AI 场景优化将成为网络芯片发展的基本要求。业务场景融合正成为新型网络芯片的发展方向。

(一)网络带宽要求

网络带宽是 AI 大规模训练中的一个关键要素。为保证训练效率,网络高带宽对存储设备、计算节点和内存之间的快速数据传输至关重要。尤其是在分布式训练场景下,多个计算节点之间需频繁交换大量中间结果与梯度信息,若带宽不足则将产生数据传输瓶颈,进而影响训练速度。

目前,主流 AI 训练平台通常采用高带宽的网络连接,如10Gbps、40Gbps 甚至更高的带宽,以满足大规模数据传输需求。

(二)网络时延要求

低时延是支撑 AI 大模型分布式训练的关键要素。分布式训练要求在多个计算节点之间频繁交换数据,若网络时延过高,则将导致数据传输速度减慢,进而影响整体训练效率。特别是在同步训练模式下,所有计算节点必须等待最慢节点的数据传输完成,才能进行下一轮计算。因此,网络时延的增加将直接导致训练时间的延长。

低时延对于 AI 推理同样重要。推理过程通常要求快速响应用户请求,并在短时间内返回结果。

(三)网络抖动要求

通算与智算在流量特征方面存在显著区别。通算中心的特征是流数量多(通常超过 10W),但以小流为主,通信模式通常为点对点。

相比之下,智算中心的特征为流数量少(通常低于 10K),但以周期性突发的大流为主,通常采用集合通信的模式,且流间存在同步效应。

(四)网络丢包要求

网络丢包在 AI 大规模训练中是一项极其重要的问题。分布式训练要在不同计算节点间频繁交换数据,若发生丢包则将导致数据传输失败,进而影响模型训练的准确性。

尤其在同步训练模式下,任一节点的数据丢失都可能导致整个训练过程的中断,严重拖累训练进度。

2025新技术前瞻专题系列合集

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。