在 22年底,ChatGPT 点燃了一场人工智能革命,这场革命自那时以来以惊人的速度加速发展。从对通用人工智能(AGI)即将来临的猜测,到 Sam Altman 突然离开又迅速回归 OpenAI 首席执行官的职位,开源模型与闭源模型的崛起,以及 Meta 将其 AI 聊天机器人整合到其整个应用程序生态系统中(覆盖全球 40% 的人口),人工智能领域充满了戏剧性和惊人的进步。

本文将回顾 2023 年 和2024年人工智能取得的巨大进展,并预测这一生态系统在 2025 年如何演变,特别关注企业领域。该领域的发展速度如此之快,以至于创始人和企业领导者都需要预测未来的发展方向,并朝着这个方向前进。如果一个模型现在能以 40% 的时间完成一项任务,那么在一年或两年内,它完成这项任务的成功率很可能将达到 80-90%。最敏锐的构建者将为模型即将具备的能力设计解决方案,而不是局限于今天所能实现的。

本文的目标是为创始人提供这样一个指南。

2023 年:训练和性能提升的一年

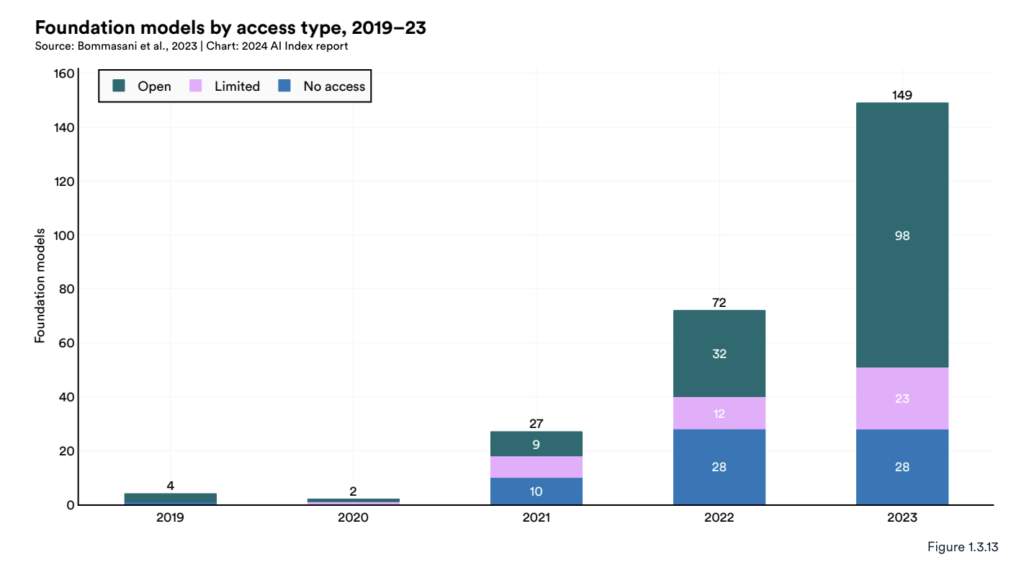

2023 年是人工智能的里程碑式一年,进步的速度和规模比以往任何时候都要快。这一年发布了 149 个新的基础模型,是 2022 年的两倍多。训练的不断进步速度反映在 GitHub 上与人工智能相关的项目数量几乎增长了 60%,与这些项目(以“星标”衡量)的互动年度增长了三倍,超过 1200 万。

来源:斯坦福大学 2024 年人工智能指数报告

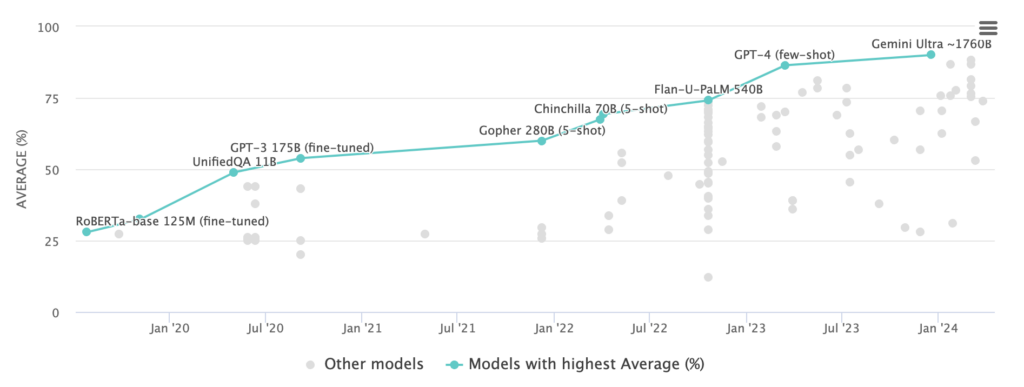

Transformer架构是这一创新爆炸的推动力。随着研究人员向这些模型输入越来越多的数据和计算资源,它们继续得到改进,证实了Transformer模型具有类似于半导体领域摩尔定律的“扩展法则”。基于Transformer的模型开始在像 MMLU 这样的黄金标准基准测试中饱和,迫使研究人员开发新的、更具挑战性的测试以跟上进度。

来源:MMLU 领先排行榜(2024.4.26访问)

与此同时,多模态模型在语言、视觉、语音和机器人技术等领域解锁了新的用例。自 2022 年 11 月以来,我们从能够处理 4096 个token文本的 ChatGPT 跃升到能够处理文本、图像、音频和视频的 100 万个token的 Gemini 1.5。Gemini 的研究团队报告说,其在下一个token预测和回忆方面的能力在至少 1000 万个标记上不断增加,暗示了这些模型中尚未开发的巨大潜力。

这些发展共同导致了人工智能竞争格局的转变。OpenAI 在年初处于主导地位,GPT-4 舒适地领先于模型排行榜,并在企业尝试生成式人工智能的市场份额中占据主导地位。但到了年中,GPT-3.5 级别的性能已成为基线。Anthropic 的 Claude 3 Opus 现在在 10 个关键基准上超过了 GPT-4,从狭窄的(在五次射击的 MMLU 试验中,Opus 为 86.8%,GPT-4 为 86.4%)到显著的(在关键编码基准上,Opus 为 84.9%,GPT-4 为 67.0%)。

很快,许多模型将很快达到或超过 GPT-4 设定的标准,包括开源新秀 Llama 3。在 LMSys 领先排行榜中筛选英语提示时,Llama 3 70B 占据了第二位,仅次于 GPT-4 的最新版本。一些在 Twitter 上的 AI 构建者暗示,这两个模型之间的差距实际上几乎不存在。甚至有传言说,仍在训练中的 Llama 3 400B 将与备受期待的 GPT-5 表现相当。

来源:LMSys 领先排行榜,筛选英语提示(2024 年 4 月 26 日访问)

开源人工智能的崛起无疑是 2023 年最令人兴奋的发展。尽管 OpenAI 一度看似不可战胜,但像 Llama 3、Databricks 的 DBRX 和 Mistral 这样的替代品在参数数量和计算成本更低的情况下取得了卓越的成果。随着开源和闭源模型性能的收敛,企业和应用程序开发者都将从中受益匪浅。

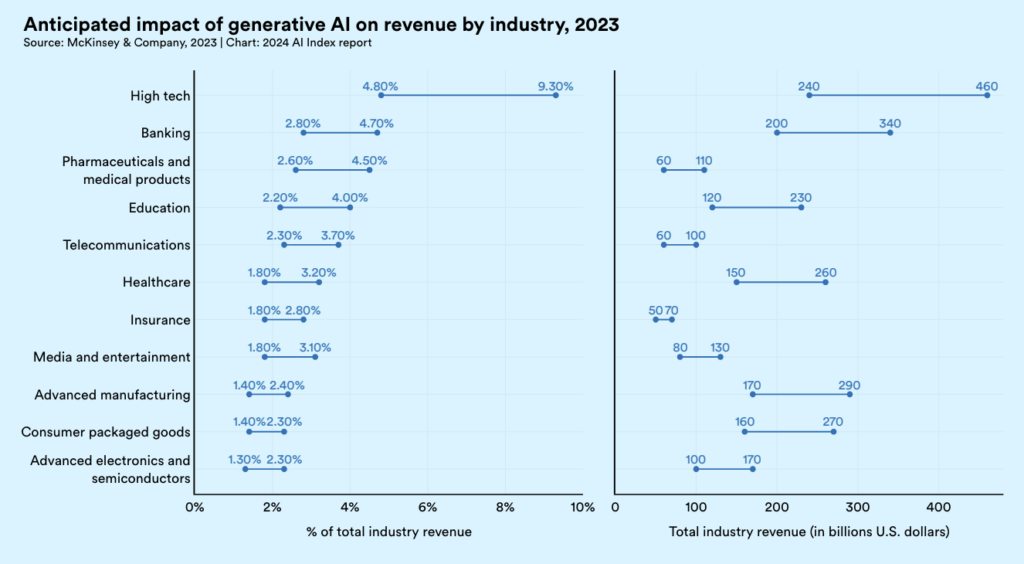

这一快速民主化的人工智能发展背景是企业采用和投资的日益增长。随着生成式 AI 试点开始证明其实用价值,企业的预算和用例都在飙升。a16z 近期的一项调查发现,2023 年企业平均在生成式 AI 上投资了 700 万美元,几乎所有受访者都报告了有希望的初步结果。大多数人计划在 2024 年将其生成式 AI 投资增加 2-5 倍。麦肯锡估计,仅生成式 AI 就可能在 2024 年将高科技行业的收入提高多达 9%,或近 5000 亿美元。重要的是,这些举措正在从实验性的“创新”预算转变为核心软件支出。

来源:斯坦福大学 2024 年人工智能指数报告

2024 年:推理的兴起

随着我们进入 2024 年,企业人工智能的焦点从训练转向推理——即将生成式模型用于现实世界应用程序的过程。这一转变体现在像英伟达和微软这样的科技巨头的季度财报中。英伟达的首席财务官透露,2023 年其数据中心收入的 40% 来自 AI 推理——这一数字预计在未来一年将显著上升。

与训练相比,推理提出了独特的挑战,需要公司在大规模部署生成式 AI 应用程序时权衡一组新的考虑因素。这些包括:

延迟:在运行推理时,低延迟和高吞吐量至关重要,因为应用程序必须快速响应用户请求。训练可以花费更长时间,因为它通常离线进行。

扩展:生产工作负载可能高度可变,需要能够动态适应波动需求的基础设施。虽然训练也受益于可扩展性,但其资源需求通常更可预测。

多种环境:推理工作负载需要能够在各种环境中运行,从云平台到边缘设备,每种环境都有其自己的约束和考虑因素。训练通常在更集中和标准化的环境中进行。

成本:尽管训练生成式模型的成本已经令人震惊,但与大规模推理的持续成本相比,这些成本相形见绌。据报道,运行 ChatGPT 进行推理的每周成本超过了训练模型的全部成本。训练成本通常更可预测和易于管理,通常涉及一次性或定期投资。

根据这些因素,企业正在细化其 AI 策略,越来越多地依赖多个模型,即使是同一功能也是如此。新兴的最佳实践是通过启用模型之间的轻松切换(通常只需简单的 API 更改)来设计 AI 应用程序,以实现最大选项性。这种“模型花园”方法允许企业根据性能-成本权衡为特定用例量身定制解决方案,避免供应商锁定(这是云计算时代痛苦的教训),并利用该领域继续前进的进展。

尽管使用多个模型有其优势,但大多数企业在模型部署和优化的复杂性导航中面临着艰巨的挑战。根据 a16z,2023 年企业 AI 支出的最大领域之一,甚至是最大的领域,是实施。这突出了简化 AI 模型在生产中部署和优化过程的解决方案的迫切需求。

为了响应这一需求,初创公司正在开发“推理即服务”平台,这些平台抽象了大部分这种复杂性。这些平台允许开发人员轻松组合和迭代不同的模型、云和芯片的组合,以找到成本、性能和效率的最佳平衡点。在这个领域,像 Modal、Baseten 和 Replicate 这样的先行者已经获得了显著的牵引力,但市场仍然主要是一个开放的竞争领域。

2025 年:三大新兴趋势

展望 2025 年,预计企业人工智能格局将出现三个进一步的转变:从训练越来越大的模型转向设计复合人工智能系统,对人工智能的可观测性和评估的重视程度不断提高,以及出现可信的变换器架构替代品。每一个趋势都建立在推理角色不断扩大的基础上。

1. 复合人工智能系统

与其依赖单一的大型模型来处理复杂的任务,人工智能开发的前沿正在拥抱模块化、系统级的工程方法。这些复合人工智能系统采用多个模型,这些模型在迭代、循环过程中协同工作,相互协调,并利用外部工具来评估、完善和改进自己的结果。通过将大型任务分解为一系列子任务,这种方法使构建者能够更好地优化和调试每个子任务,从而提高整体性能。

伯克利人工智能研究(BAIR)实验室的研究人员,包括 B2BaCEO 广播节目嘉宾 Ali Ghodsi、Naveen Rao 和 Matei Zaharia,是这一转变的前沿。他们的工作已经证明,即使在训练数据和计算资源远少的情况下,复合人工智能系统也能超越单一模型的性能。

考虑他们提供的一个例子:虽然目前最好的编码模型可能 30% 的时间能解决问题,但仅仅将其训练预算增加三倍,可能只会将成功率提高到 35%。相比之下,像谷歌的 AlphaCode 2 这样的多部分系统,通过结合多个 LLM 和先进的搜索及重新排序机制,可以使用当前模型实现 80% 以上的编码性能。

再次引用 BAIR 的话,复合人工智能系统相比单一、静态模型具有多个优势。系统设计的迭代比训练运行更快、更便宜。模块化系统还允许开发人员动态地整合最新信息,对敏感数据实施细粒度的访问控制,更可靠地确保模型按预期行为,并灵活地调整性能和成本配置文件以适应不同的用例。这些品质对于企业应用至关重要,因为可靠性、安全性和成本效益是关键任务。

除了 AlphaCode 2 之外,像 LLM Debate 和 CoT-SC 这样的其他早期示例也显示出强劲的结果。最近的一项研究使用以下方法调查了 LLM 代理的“扩展法则”:向一个或多个代理提供问题,生成多个答案,然后进行多数投票。结果显示,仅仅增加更多的代理就能在广泛的基准测试中获得更好的性能,即使没有像链式思考提示和多代理协作框架这样的高级方法。

尽管研究人员过去报告的是单一模型调用的结果,但他们现在正在利用更复杂的推理策略。微软使用一组模型的提示链方法在医学考试中比 GPT-4 高出了 9%。谷歌的 Gemini 发布帖子使用 CoT@32 推理策略测量其 MMLU 基准得分,该策略调用了 32 次模型,这导致一些人质疑将这一结果与 GPT-4 的 5 次提示进行比较的公平性。

这些发展强调了推理日益增长的重要性。正如 Andrew Ng 所解释的,今天的 LLM 产生的输出主要是为了人类用户。然而,在复合人工智能系统中,模型调用工具、创建和执行多步骤计划、与其他模型协调,并迭代地反思和改进自己的输出。所有这些幕后工作意味着,复合人工智能系统在返回任何输出给人类用户之前,可以生成数万个标记。在这种情况下,缓慢的推理很快就会成为瓶颈。

我们仍然处于探索如何构建、优化和运行复合人工智能系统的早期阶段。像斯坦福的 DSPy 这样的框架正在帮助研究人员在这些方面取得进展。

2. 可观测性和评估

如今,检查生成模型是否运行良好通常取决于“感觉”。不用说,虽然这可能适用于休闲开发者和低风险任务,但对于企业来说是远远不够的。随着我们从独立模型转向复合人工智能系统,确保模型按预期行为的挑战将变得更加棘手,因为模型之间的交互可能会产生意想不到且难以预测的结果。幸运的是,更快的推理将使运行评估变得更加容易。许多初创公司,包括我们的投资组合公司 Arize,正在解决这个问题,但这还远未解决。

3. 新的模型架构

虽然Transformer目前占据主导地位,但一些替代架构显示出早期的希望,特别是在计算效率和可扩展性方面。这使它们在高推理工作负载方面可能要好得多。我们正在关注的几个架构包括:

状态空间模型:与Transformer不同,像 Mamba、Striped Hyena 和 Cartesia 这样的 SSMs 随着序列长度的增加而次方增长。使用局部注意力机制和对数稀疏模式等技术,像 Mamba、Striped Hyena、Longformer 和 LogSparse 这样的模型可以更高效地处理长序列。这使它们非常适合涉及大量数据的任务,如视频处理和基因组序列分析。

大型图形模型: Ikigai 正在开发 LGMs,这些模型在处理结构化数据方面表现出色,能够捕捉到其他类型的神经网络难以建模的时间依赖性和复杂关系。LGMs 在分析时间序列数据方面特别有效,使其可能对金融、预测和物流等领域的用例非常有价值。

接受权重键值(RWKV)模型:这些模型采用混合方法,结合了Transformer的可并行训练和循环神经网络(RNNs)在内存和计算需求上的线性扩展。这使它们能够在语言建模任务上实现与变换器相当的性能,同时在推理过程中更加高效。

最后的思考

对于专注于人工智能的创始人,本文的主要建议是什么?

为模型将在 1-2 年内达到的位置去提前布局,而不仅仅是它们今天的位置。将大规模推理的挑战融入路线图。不要只是考虑提示一个巨型模型并获得答案。计划进行迭代的系统设计、工程和监控工作,以使你的 AI 产品比现有替代品表现得“好 10 倍”。

原文链接:https://foundationcapital.com/where-ai-is-headed-in-2025/

高端微信群介绍 | |

创业投资群 | AI、IOT、芯片创始人、投资人、分析师、券商 |

闪存群 | 覆盖5000多位全球华人闪存、存储芯片精英 |

云计算群 | 全闪存、软件定义存储SDS、超融合等公有云和私有云讨论 |

AI芯片群 | 讨论AI芯片和GPU、FPGA、CPU异构计算 |

5G群 | 物联网、5G芯片讨论 |

第三代半导体群 | 氮化镓、碳化硅等化合物半导体讨论 |

存储芯片群 | DRAM、NAND、3D XPoint等各类存储介质和主控讨论 |

汽车电子群 | MCU、电源、传感器等汽车电子讨论 |

光电器件群 | 光通信、激光器、ToF、AR、VCSEL等光电器件讨论 |

渠道群 | 存储和芯片产品报价、行情、渠道、供应链 |

< 长按识别二维码添加好友 >

加入上述群聊

带你走进万物存储、万物智能、

万物互联信息革命新时代