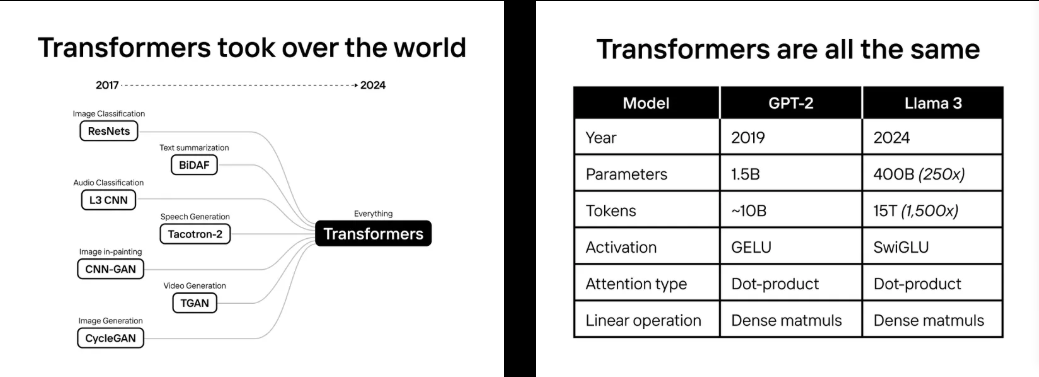

2022年,我们打赌说transformer会统治世界。

我们花了两年时间打造Sohu,这是世界上第一个用于transformer(ChatGPT中的“T”)的专用芯片。

将transformer架构烧到芯片中,我们无法运行大多数传统的AI模型:支持Instagram广告的DLRM,像AlphaFold 2这样的protein-folding模型,或者像Stable Diffusion 2这样的旧图像模型,也不能运行CNN、RNN或LSTM。

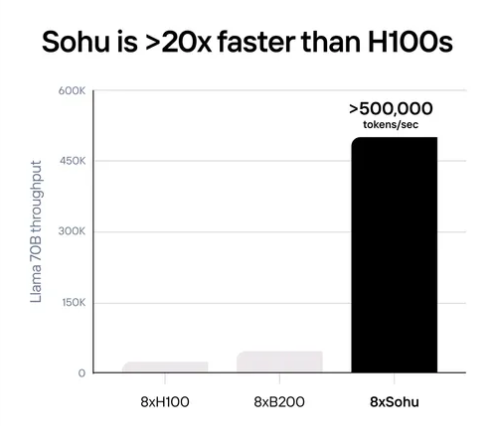

但对于transformer来说,Sohu是有史以来最快的芯片。

借助Llama 70B每秒超过50万个token的吞吐量,Sohu可以让您构建在GPU上无法实现的产品。Sohu甚至比英伟达(NVIDIA)的下一代Blackwell (B200) GPU更快、更便宜。

今天,每个最先进的AI模型都是一个transformer:ChatGPT,Sora, Gemini,Stable Diffusion 3等等。如果transformer被SSM、RWKV或任何新架构所取代,我们的芯片将毫无用处。

但如果我们是对的,Sohu将改变世界。这就是我们打这个赌的原因。

超级智能所需要的是规模扩展

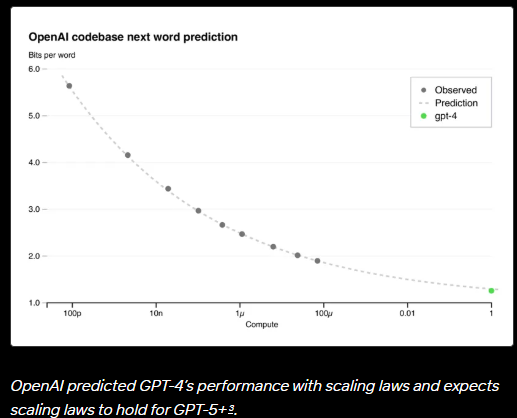

在五年内,AI模型在大多数标准化测试中变得比人类更聪明。因为Meta在训练Llama 400B (2024 SoTA,比大多数人都聪明)时使用的计算比OpenAI在GPT-2 (2019 SoTA)上使用的计算多5万倍。

通过给AI模型提供更多的算力和更好的数据,它们会变得更聪明。规模扩展是唯一一个几十年来一直有效的技巧,每一家大型AI公司(谷歌、OpenAI /微软、Anthropic /亚马逊等)在未来几年都将花费超过1000亿美元来保持扩展。我们生活在有史以来最大的基础设施建设中。

“我认为(我们)可以扩大到1000亿美元的规模,……我们将在几年内实现这一目标。”

——Dario Amodei, Anthropic CEO

扩展下一个1000倍将非常昂贵。下一代数据中心的成本将超过一个小国的GDP。以目前的速度,我们的硬件、电网和钱包都跟不上。

我们不担心数据耗尽。无论是通过合成数据、标注管道,还是新的AI标记数据源,我们认为数据问题实际上是一个推理计算问题。Mark Zuckerberg、Dario Amodei和Demis Hassabis似乎也同意这一点。

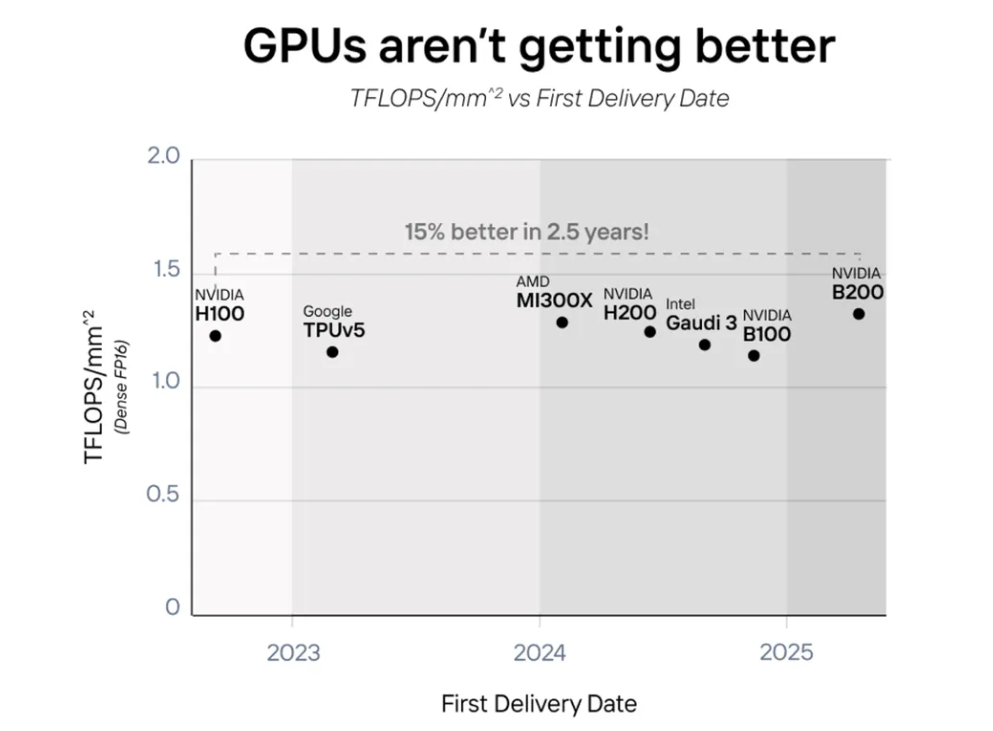

GPU正遇到壁垒

小秘密是GPU并没有变得更好,而是变得更大了。该芯片每面积的算力(TFLOPS)四年来几乎持平。

从2022年到2025年,AI芯片并没有变得更好,而是变得更大了。英伟达的B200、AMD的MI300、英特尔的Gaudi 3和亚马逊的Trainium2将两个芯片作为一张卡来“加倍”性能。2022-2025年间的所有GPU性能提升都使用了这个技巧,除了Etched。

随着摩尔定律的放缓,提高性能的唯一方法就是专业化。

专用芯片不可避免

在transformer占领世界之前,许多公司制造了灵活的AI芯片和GPU来处理数百种不同的架构。举几个例子:

NVIDIA’s GPUs

Google’s TPUs

Amazon’s Trainium

AMD’s accelerators

Graphcore’s IPUs

SambaNova SN Series

Cerebras’s CS-2

Groq’s GroqNode

Tenstorrent’s Grayskull

D-Matrix’s Corsair

Cambricon’s Siyuan

Intel’s Gaudi

目前还没有人开发出专门针对算法的AI芯片(ASIC)。芯片项目耗资5000 -1亿美元,需要数年时间才能投产。刚开始的时候,没有市场。

突然之间,情况发生了变化:

前所未有的需求:在ChatGPT之前,transformer推断市场约为5000万美元,而现在是数十亿美元。所有大型科技公司都使用transformer模型(OpenAI、b谷歌、亚马逊、微软、Facebook等)。

架构融合:AI模型过去经常发生变化。但自GPT-2以来,最先进的模型架构几乎保持相同!OpenAI的GPT家族,谷歌的PaLM, Facebook的LLaMa,甚至特斯拉的FSD都是transformer。

当模型的训练成本超过10亿美元,推理成本超过100亿美元时,专用芯片是不可避免的。在这个规模上,1%的改进将证明一个5000 -1亿美元的定制芯片项目是合理的。

实际上,ASIC比GPU要快几个数量级。2014年,当比特币进入市场时,扔掉GPU比用它们挖比特币更便宜。

随着数十亿美元的投入,AI也将面临同样的命运。

transformer惊人地相似:像SwiGLU激活和RoPE编码这样的调整无处不在:LLM、嵌入模型、图像绘制和视频生成。

虽然GPT-2和Llama-3是最先进的(SoTA)型号,但它们的架构几乎相同。唯一的主要区别是规模。

transformer有一条巨大的护城河

我们相信硬件抽奖:获胜的机型是那些在硬件上运行最快、最便宜的机型。transformer功能强大、有用、利润丰厚,足以在替代产品出现之前主导每一个主要的AI计算市场:

transformer为每一个大型AI产品提供动力:从代理到搜索再到聊天。为了优化用于transformer的GPU,AI实验室已经投入了数亿美元的研发资金。当前和下一代最先进的型号是transformer。

未来几年,随着模型规模从10亿美元扩大到100亿美元,再到1000亿美元的训练费用,测试新架构的风险也会飙升。与其重新测试缩放定律和性能,不如把时间花在构建transformer的特性上,比如multi-token预测。

今天的软件堆栈针对transformer进行了优化。每个流行的库(TensorRT-LLM, vLLM, Huggingface TGI等)都有专门的内核用于在GPU上运行transformer模型。在transformer之上构建的许多特性在替代方案中不容易得到支持(例如推测解码、树搜索)。

未来的硬件堆栈将针对transformer进行优化。NVIDIA的GB200对transformer(TransformerEngine)有特殊的支持。像Sohu这样的ASIC进入这个市场标志着不可能再回头了。transformer杀手需要在GPU上运行的速度比在Sohu上运行的速度快。如果发生这种情况,我们也将为此构建一个ASIC !

遇见Sohu

Sohu是世界上第一个transformer专用集成电路。一台8xSohu服务器替换160个H100 GPU。

通过专业化,Sohu获得了前所未有的业绩。一台8xSohu服务器每秒可以处理超过500,000个Llama 70B token。

基准是在FP8精度下的lama- 370B:无稀疏性,8倍模型并行,2048输入/128输出长度。

用TensorRT-LLM 0.10.08(最新版本)计算8xH100,估计8xGB200的数字。

Sohu只支持transformer推理,无论是Llama还是Stable Diffusion3。Sohu支持目前所有的模型(谷歌,Meta, Microsoft, OpenAI,Anthropic等),并可以处理对未来模型的调整。

由于Sohu只能运行一种算法,绝大多数控制流逻辑可以被移除,从而允许它拥有更多的数学块。因此,Sohu拥有超过90%的FLOPS利用率(相比之下,使用TRT-LLM的GPU7只有30%)。

怎么能在芯片上容纳比GPU更多的FLOPS呢?

NVIDIA H200具有989 TFLOPS的FP16/BF16无稀疏性计算。这是最先进的(甚至超过了谷歌的新Trillium芯片),而在2025年推出的GB200只多了25%的计算能力(每芯片1,250 TFLOPS)。

由于GPU的绝大部分区域都致力于可编程性,专门研究transformer可以让您适应更多的计算。你可以从第一原理中证明这一点:

构建单个FP16/BF16/FP8乘加电路需要10,000个晶体管,这是所有矩阵数学的构建模块。H100 SXM有528个张量核,每个核有4*8*16个FMA电路。乘法告诉我们H100有27亿个晶体管专用于张量核。

但是H100有800亿个晶体管!这意味着H100 GPU上只有3.3%的晶体管用于矩阵乘法!

这是英伟达和其他灵活AI芯片深思熟虑的设计决策。如果想支持各种模型(CNN、LSTM、SSM等),你不能做得比这更好了。

通过只运行transformer,我们可以在芯片上容纳更多的FLOPS,而不会降低精度或稀疏性。

推理的瓶颈不应该是在内存带宽上,而不是在计算上吗?

事实上,对于像Llama-3这样的现代模型来说,答案是no!

让我们使用NVIDIA和AMD的标准基准:2048个输入token和128个输出token。大多数AI产品的提示都比完成时间长得多(甚至一个新的Claude聊天在系统提示中也有1000多个token)。

在GPU和Sohu上,推理是批量运行的。每个批处理一次加载所有模型权重,并在批处理中的每个token上重用它们。一般来说,LLM的输入是计算绑定的,而LLM的输出是内存绑定的。当我们将输入和输出token与连续批处理结合在一起时,工作负载变得非常计算受限。

下面是LLM的连续批处理示例。这里我们正在运行具有四个输入token和四个输出token的序列;每种颜色都是不同的序列。

我们可以扩展同样的技巧来运行Llama-3-70B,使用2048个输入token和128个输出token。每个批处理包含一个序列的2048个输入token,以及127个不同序列的127个输出token。

如果我们这样做,每批将需要大约(2048 + 127)* 70B params *2字节/ param = 304 TFLOPs,而只需要加载70B params * 2字节/ param = 140 GB的模型权重和大约127 *64*8 *128*(2048 + 127)*2*2 = 72GB的KV缓存权重。这远远超过了内存带宽:一台H200需要6.8 PFLOPS的计算才能最大限度地利用其内存带宽。这是在100%利用率下,如果利用率是30%,你需要3倍以上计算负载。

由于Sohu有如此多的计算和非常高的利用率,我们可以运行巨大的吞吐量,而不会出现内存带宽的瓶颈。

在现实世界中,批处理要大得多,输入长度变化很大,请求以泊松分布到达。这种技术在这些情况下效果更好,但我们在这个例子中使用2048/128基准,因为NVIDIA和AMD使用它。

软件是如何工作的?

在GPU和TPU上,软件是一场噩梦。处理任意CUDA和PyTorch代码需要一个非常复杂的编译器。第三方AI芯片(AMD、英特尔、AWS等)在软件上总共花费了数十亿美元,但收效甚微。

但是Sohu只运行transformer,我们只需要为transformer编写软件!

大多数运行开源或内部模型的公司使用特定于transformer的推理库,如TensorRT-LLM、vLLM或HuggingFace的TGI。这些框架非常严格——虽然可以调整模型超参数,但并不真正支持更改底层模型代码。但这很好——因为所有的transformer模型都是如此相似(甚至是文本/图像/视频的),调整超参数是你真正需要的。

虽然这支持95%的AI公司,但最大的AI实验室都是定制的。他们有工程师团队手动调整GPU内核,以挤出更多的利用率,逆向工程,比如哪个寄存器对张量核心的延迟最低。

有了Etched,你再也不需要逆向工程了——我们的软件,从驱动程序到内核再到服务栈,都将是开源的。如果想实现自定义的transformer层,您的内核向导可以自由地这样做。

Etched将是第一个

如果这个赌注现在看起来很疯狂,想象一下在2022年实现它。刚开始的时候,ChatGPT还不存在!图像和视频生成模型是U-Nets,自动驾驶汽车是由CNN驱动的,transformer架构远未普及。

幸运的是,形势已经朝着有利于我们的方向转变。从语言到视觉,每个领域的顶级模型现在都是transformer。这种融合不仅证明了这一押注是正确的,而且也使Sohu成为这十年来最重要的硬件项目。

我们正在进行历史上最快的芯片发布之一:

顶尖的AI研究人员和硬件工程师离开了重大的AI芯片项目,加入我们;

我们已经直接与台积电合作开发他们的4nm工艺。我们已经从顶级供应商那里获得了足够的HBM和服务器供应,可以快速启动第一年的生产;

我们的早期客户已经预订了数千万美元的硬件.

如果我们是对的,Sohu将改变世界

如果AI模型一夜之间变得快20倍、便宜20倍,会发生什么?

今天,Gemini要花60秒回答一个关于视频的问题。编码代理的成本高于软件工程师,完成任务需要花费数小时。视频模型每秒生成一帧,甚至当ChatGPT注册用户达到1000万(仅占世界的0.15%)时,OpenAI的GPU容量也耗尽了。

我们并没有在解决这个问题的轨道上——即使我们继续让GPU变得更大,以每两年2.5倍的速度,也需要十年的时间才能实现实时视频生成。

但有了Sohu,这将是即时的。当实时视频、电话、代理和搜索最终正常工作时,会发生什么?

很快,你就会知道了。

原文链接:

https://www.etched.com/announcing-etched

高端微信群介绍 | |

创业投资群 | AI、IOT、芯片创始人、投资人、分析师、券商 |

闪存群 | 覆盖5000多位全球华人闪存、存储芯片精英 |

云计算群 | 全闪存、软件定义存储SDS、超融合等公有云和私有云讨论 |

AI芯片群 | 讨论AI芯片和GPU、FPGA、CPU异构计算 |

5G群 | 物联网、5G芯片讨论 |

第三代半导体群 | 氮化镓、碳化硅等化合物半导体讨论 |

存储芯片群 | DRAM、NAND、3D XPoint等各类存储介质和主控讨论 |

汽车电子群 | MCU、电源、传感器等汽车电子讨论 |

光电器件群 | 光通信、激光器、ToF、AR、VCSEL等光电器件讨论 |

渠道群 | 存储和芯片产品报价、行情、渠道、供应链 |

< 长按识别二维码添加好友 >

加入上述群聊

带你走进万物存储、万物智能、

万物互联信息革命新时代