当谷歌宣布其第二代专用集成电路来加速公司的机器学习处理时,笔者的电话开始响个不停,问这对半导体行业的潜在影响。世界上最大的数据中心“Super 7”的其它成员是否都急于为AI制造自己的芯片?这对AI芯片和平台的领先供应商NVIDIA、AMD、Intel等其它公司以及许多希望进入这个利润丰厚市场的初创公司有何影响?当GPU和FPGA开始看起来如此有前途的时候,它们的游戏结束了吗?为了回答这些问题,让我们进入这些互联网巨头的头脑,看看他们可能在计划什么。

AI的硅景观

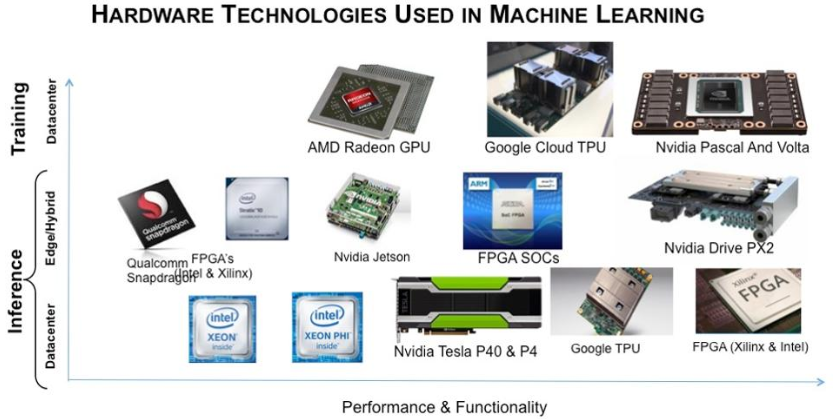

正如笔者在今年早些时候的一篇文章中所探讨的,有四种主要类型的技术可用于加速深度神经网络的训练和使用:CPU、GPU、FPGA和ASIC。老式备用CPU具有无限可编程的优势,性能不错,但不是很出色。它主要用于推理工作负载,其中训练好的神经网络引导计算对输入数据项做出准确的预测。另一方面,Intel和Xilinx的FPGA在极低功耗下提供出色的性能,但也提供了更大的灵活性,允许设计人员更改底层硬件以最好地支持不断变化的软件。FPGA主要用于机器学习推理,视频算法和成千上万的小批量专用应用。然而,编程FPGA硬件所需的技能很难获得,并且FPGA的性能在某些工作负载下无法接近高端GPU的性能。

如今,机器学习、训练和推理、云和边缘都使用了许多类型的硬件加速器。从技术上讲,GPU是一种用于处理图形算法的ASIC。不同之处在于,ASIC提供指令集和库,允许对GPU进行编程,以对本地存储的数据进行操作,作为许多并行算法的加速器。GPU擅长执行矩阵运算(主要是矩阵乘法),这是图形、AI和许多科学算法的基础。基本上,GPU是非常快速和相对灵活的。

另一种选择是设计一个专用于执行固定操作的定制ASIC,因为整个芯片的逻辑区域可以专用于一组特定功能。在谷歌TPU的情况下,它们可以很好地实现高度并行,而处理神经网络是一种“令人尴尬的并行”工作负载。把ASIC想象成一辆飙车;它可以跑得很快,但它只能载一个人直线行驶四分之一英里。你不能开着它绕着街区转,也不能开着它在椭圆形跑道上跑。

这里有一个问题:设计ASIC可能是一项昂贵的工作,耗资数千万甚至数亿美元,需要一个相当昂贵的工程师团队。支付所有这些开发费用意味着需要成千上万的芯片在设计的使用寿命(通常是2-3年)内摊销这些费用。此外,芯片需要经常更新,以跟上新技术和制造工艺的步伐。最后,由于设计师在开发过程的早期就冻结了逻辑,当新想法出现在快速发展的领域(如AI)时,他们将无法快速做出反应。另一方面,FPGA(在一定程度上甚至是GPU)可以重新编程以实现新功能。

谷歌为什么要制造TPU?

如果仔细想想谷歌的业务,就会发现它有三个特点,很可能促使它投资于AI定制芯片。检查这些因素可能有助于评估其它公司进行类似投资的潜在可能性。

战略意图

谷歌曾多次表示要成为一家“AI First”的公司。换句话说,AI技术在整个业务中发挥着战略作用:搜索、自动驾驶汽车、谷歌云、谷歌家庭,以及许多其它新的和现有的产品及服务。因此,谷歌想要控制自己的硬件(TPU)加速器和自己的软件框架(TensorFlow)是有道理的,他们将在这些框架上构建自己的产品和服务。该公司愿意投资,以使自己比其它拥有类似抱负的公司更有优势。

所需规模

谷歌的计算基础设施是世界上最大的,这种规模意味着它可能拥有所需的容量,以证明开发和维护自己的AI加速硬件平台的巨大成本是合理的。事实上,谷歌声称TPU使公司不必再建造12个数据中心来处理AI负载。

让我们做一些敏感性分析,以了解单个ASIC周期所需的可能规模。为了便于讨论,假设谷歌花费了1亿美元,包括掩模生产,每个芯片将为他们节省大约1K美元。作为参考,一个45 TFLOPS的单个Cloud TPU芯片可能比NVIDIA Volta GPU在峰值120 TFLOPS时的性能略高1/3,所以需要3个TPU芯片来取代一个高端GPU。这意味着谷歌部署100K的TPU,大概可以实现收支平衡(不考虑资金的时间价值)。

这对大多数公司来说都是很大的筹码,即使对谷歌来说也是如此。另一方面,如果开发芯片和TPU板只需要6000万美元,每个芯片节省2K美元,那么他们只需要30K芯片就可以实现收支平衡。因此,大型数据中心可能需要30-100K的芯片,才能在2-3年的时间内实现收支平衡。

谷歌云计算的重要性

谷歌的高管们不能满足于在全球云计算市场上落后于亚马逊和微软。在Diane Greene的领导下,他们在谷歌云上投入了大量资金,现在正在享受行业中最快的增长。谷歌可以利用谷歌云TPU的定价权和性能,以及TensorFlow的普及,在云计算机器学习发展中占据市场份额时发挥潜在显著优势。然而,谷歌表示,使用他们的云TPU的价格将与高端GPU的云访问价格相当。谷歌并不打算直接出售TPU。

还有谁像谷歌?

坦率地说,虽然所有其它Super 7成员(亚马逊、阿里巴巴、百度、Facebook、微软和腾讯)都有能力建立自己的加速器,但没有人能像百度那样在这三个方面都表现得如此出色。此外,在实际接近的公司中,有几家似乎正在朝着不同的方向发展:

百度最近公开表示,它正在与英伟达合作,在云、家庭和汽车领域开展AI计划。这并不意味着百度有朝一日不能也不会制造自己的芯片,但就目前而言,该公司似乎满足于专注于自己的软件和服务。此外,百度的云业务仍然是其业务中相对较小的一部分。

微软是第二大云服务提供商,拥有大量(5000名)稳定的AI工程师,并致力于通过其面向企业客户的工具和API使AI“民主化”。然而,该公司已经决定(至少目前)在Azure和Bing基础设施中使用英特尔的Altera FPGA,相信在快速变化的世界中,它可以从更灵活的硬件平台中受益。此外,微软使用NVIDIA的GPU来训练其神经网络。

亚马逊可能是最接近上述谷歌模式的。AWS规模庞大,该公司正在大力投资AI。虽然亚马逊可能倾向于使用Apache MXNet框架进行AI开发,但它的AWS AI云服务支持所有主要框架,使其成为AI开发领域的开放软件。此外,以英伟达为基础的Ying和以TPU为中心的Yang可能是一个有效的策略。亚马逊以前也走过ASIC的道路;为了削减AWS基础设施的成本和延迟,它在2012年收购了Ana Purna Labs。目前,该公司已经在以色列有了一个芯片团队。最后,像百度一样,亚马逊似乎热衷于使用FPGA,因为它们具有可编程的特性。

结论

笔者并不是在预测其它的Super 7公司都不会跳出GPU这条船,跳上自己的ASIC,但在笔者看来,很多公司都不太可能这么做——至少不会很快。

他们似乎都在用大量的数据开发机器学习模型,并忙于将这些模型应用于各种产品和服务中。构建ASIC和支持它的软件是一个持续且昂贵的提议,可能会分散注意力。或者,将用于训练的GPU的性能与用于推理的FPGA的灵活性和效率相结合,也有很大的希望。所以笔者个人并不认为GPU的天要塌下来了,至少在不久的将来不会。AMD当然相信对GPU有很大的需求,并将他们的Vega技术瞄准了这一点。

原文链接:

https://moorinsightsstrategy.com/will-asic-chips-become-the-next-big-thing-in-ai/

高端微信群介绍 | |

创业投资群 | AI、IOT、芯片创始人、投资人、分析师、券商 |

闪存群 | 覆盖5000多位全球华人闪存、存储芯片精英 |

云计算群 | 全闪存、软件定义存储SDS、超融合等公有云和私有云讨论 |

AI芯片群 | 讨论AI芯片和GPU、FPGA、CPU异构计算 |

5G群 | 物联网、5G芯片讨论 |

第三代半导体群 | 氮化镓、碳化硅等化合物半导体讨论 |

存储芯片群 | DRAM、NAND、3D XPoint等各类存储介质和主控讨论 |

汽车电子群 | MCU、电源、传感器等汽车电子讨论 |

光电器件群 | 光通信、激光器、ToF、AR、VCSEL等光电器件讨论 |

渠道群 | 存储和芯片产品报价、行情、渠道、供应链 |

< 长按识别二维码添加好友 >

加入上述群聊

带你走进万物存储、万物智能、

万物互联信息革命新时代