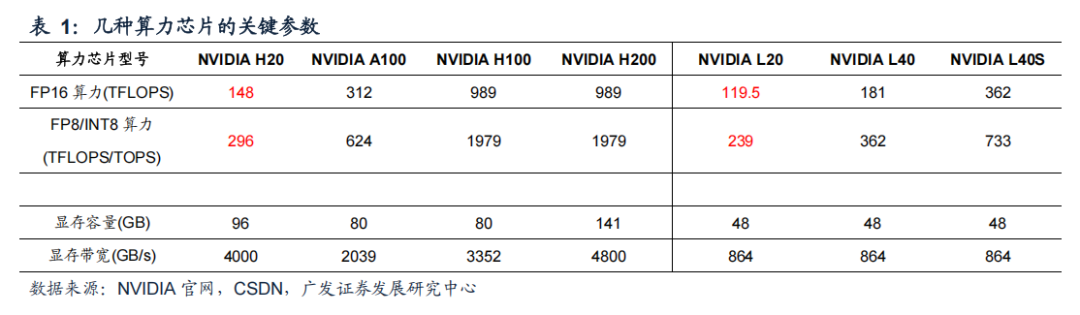

本文来自“AI的裂变时刻”系列报告合集(1)AI的裂变时刻”系列报告:为什么H20的推理性价比高?”,基于出口管制要求,NVIDIA为中国市场定制了H20、L20等产品。从表观参数来看,H20的FP16、INT8等主要算力参数仅为A100的不足1/2,更是仅为H100的约1/7;L20的主要算力参数相较于L40、L40S分别下降约1/3、2/3。

这些最新的针对中国市场定制的产品算力参数被大幅阉割,使得市场大多对其性能表现、性价比持悲观或怀疑态度。基于理论计算,研究了H20、L20等产品在大模型推理端的性能表现;推算结果显示,H20、L20均展现出较优异的推理性能。

5、《800+份重磅ChatGPT专业报告》

6、《92份GPU技术及白皮书汇总》

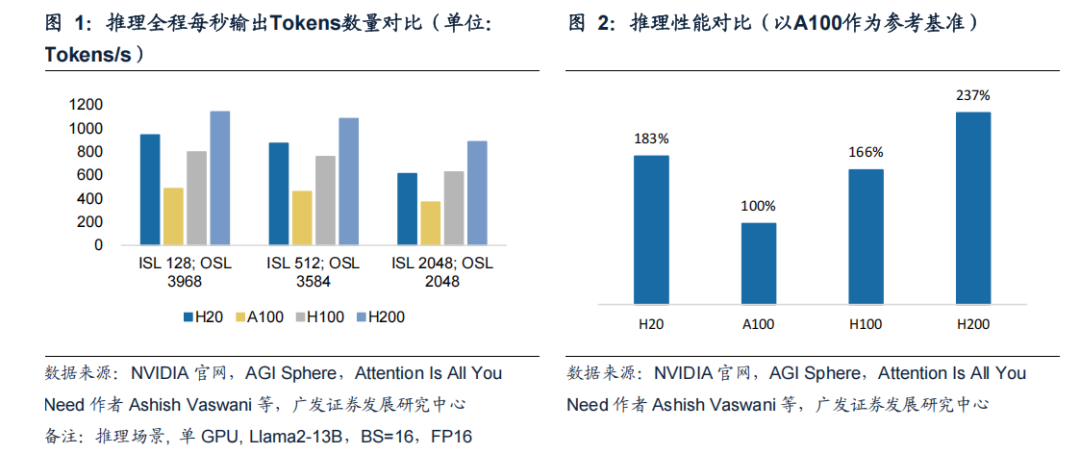

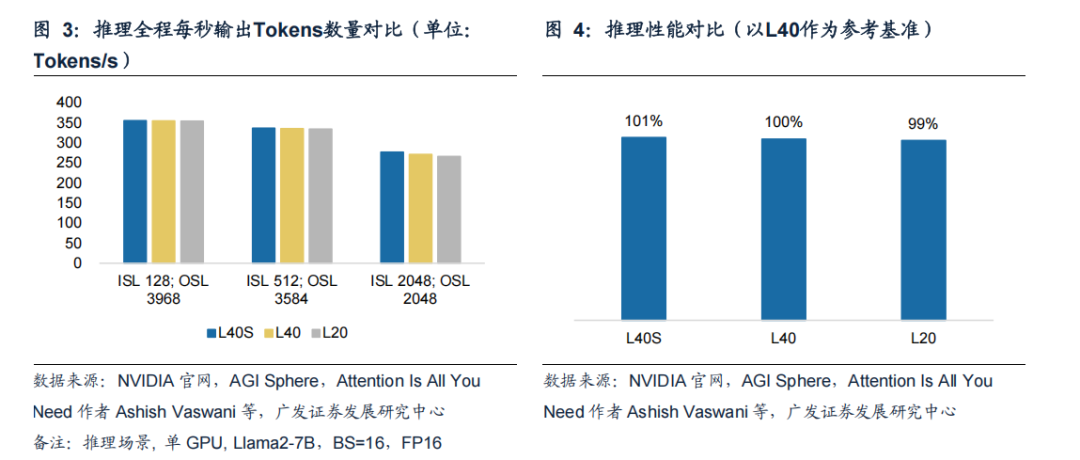

H20推理性能优于A100、H100,仅略逊于H200。分别使用单张H20、A100、H100、H200进行推理,推理场景为:Llama2-13B模型,数据格式FP16,Batch Size=16;3组输入输出,输入/输出Tokens数量分别为128/3968、512/3584、2048/2048。以整个推理阶段推理系统平均每秒输出(单位:Tokens/s)作为推理能力衡量标准。

参考图,在3组推理场景下,H20的推理速度均明显优于A100,;在前两组推理场景下,H20的推理速度优于H100,第三组推理场景下H20与H100推理速度基本持平。取三组平均值,H20平均推理速度是A100的1.8倍,是H100的1.1倍。

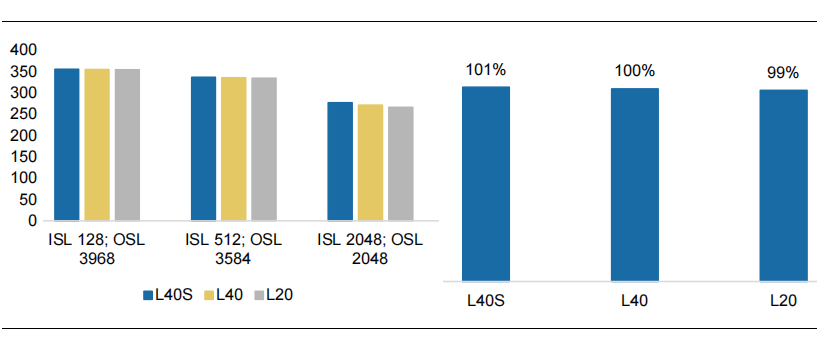

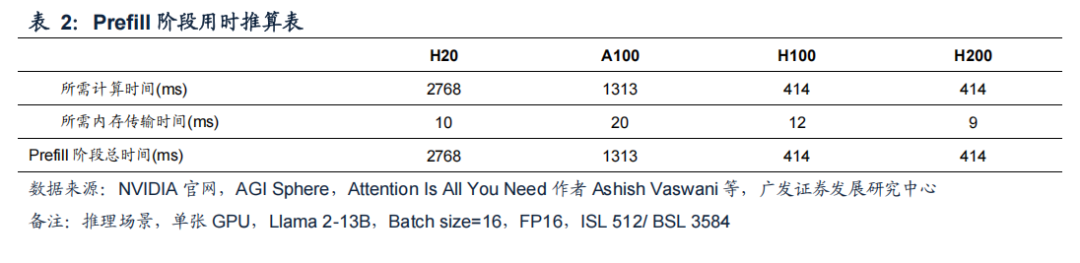

L20推理性能与L40、L40S基本相同。分别使用单张L40S、L40、L20进行推理,推理场景为:Llama2-7B模型,数据格式FP16,Batch Size=16;3组输入输出,输入/输出Tokens数量分别为128/3968、512/3584、2048/2048。以整个推理阶段推理系统平均每秒输出(单位:Tokens/s)作为推理能力衡量标准。

参考图,在前两组推理场景中,L40S、L40、L20的推理速度无明显差异;仅在最后一组场景(ISL/OSL2048/2048)中,L40S推理速度相较于L40、L20优势较明显。取三组平均值,L20推理速度仅比L40S速度慢约2%。

为什么算力被大幅阉割的H20会有如此优异的推理性能表现?

在接下来的两个章节,我们将分别分析推理过程中Prefill环节、Decode环节H20的推理性能表现。

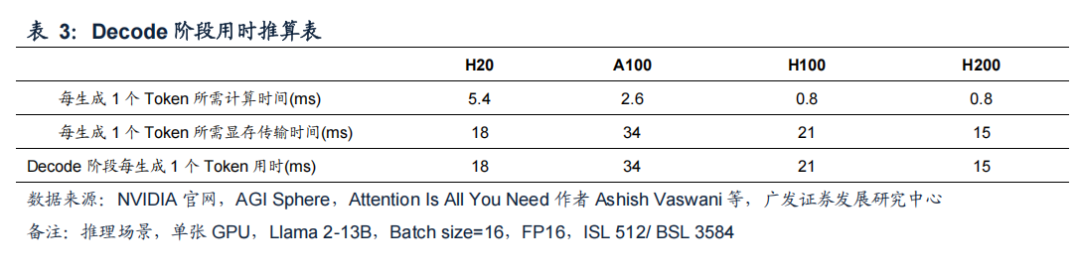

Prefill是算力密集场景,H20 受算力制约性能表现较弱

Prefill阶段算力负载体现在对用户所有输入Tokens进行一次并行计算;显存带宽负载主要体现在参数量从HBM向算力芯片的传输。在大多数推理场景下(如输入Tokens较长、或Batch Size较大),Prefill阶段计算耗时高于显存传输的耗时,因此该环节的耗时(也被称为First token latency)通常是由算力芯片的算力能力决定,Prefill阶段属于算力密集场景。

参考表,由于H20的算力较弱,在Prefill环节H20耗时明显高于其他三款芯片。这也意味着在使用H20进行推理时,用户从完成问题输入、到看到问题第一个文字的输出,中间需要等待较长时间。

Decode 是显存带宽密集场景,H20性能表现优异

在Prefill阶段结束后,大模型开始生成回答,该过程被称为Decode。由于Decode过程中,回答的Tokens必须逐个生成,且每个Token生成过程中,都需要重复一次参数从HBM向算力芯片的传输,且Decode阶段不断扩大的KV Cache也需要在HBM和算力芯片间往复传输,使得Decode阶段通常显存传输耗时明显高于计算耗时;Decode阶段属于显存带宽密集场景,更高的显存带宽对加速Decode至关重要。

参考表,由于H20具有较高的显存带宽,在Decode阶段H20每生成1个Token所需时间低于A100、H100,这也使得H20在整个推理过程具有较高的推理速度。

H20在多数推理场景中性能优异、性价比高

多数应用场景下,站在H20推理使用用户角度,在输入问题后,等待界面出现第一个回答文字的等待时间会较长(相较于使用A100/H100/H200进行推理),但考虑到这一时长也仅为2.8s,对用户使用体验的负面影响是有限的。(备注:实际用户等待时间还包括网络延迟、用户端侧延迟等)

而在回答开始后,使用H20的用户会体验到回答生成速度较快(相较于使用A100/H100进行推理),每秒57个Tokens的生成速度明显高于人类阅读速度。(备注:通常每秒生成20个及以上Tokens就能给用户带来较舒适的在线阅读体验)

站在H20持有人角度,持有人更关心一个推理系统Throughput的速度,因为对相同一套推理系统或成本相近的不同推理系统,平均Throughput(Tokens/s)越高,意味着每Token所平摊的系统硬件成本越低。从性价比角度看,假设H20与H100售价相近,在多数情况下,H20也有望成为性价比更高的推理芯片选择。

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。