01

01从2023年开始,政策支持和生成式AI需求驱动整个智算中心市场迎来爆发式增长。根据市场调研数据,2023年中国智算服务市场整体规模达到194.2亿元,其中2023年下半年整体规模达到114.1亿元,同比增长85.8%。

从2024年下半年开始,不少智算中心已完成投资建设工作,进入到运营阶段,如何精细化运营,最大化发挥算力资产价值,降低运营成本是每个智算中心关注的问题,存储产品选型是一项重要但又容易被忽视的工作。

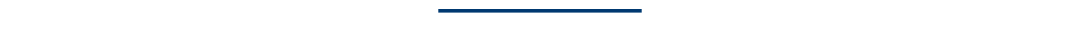

在智算中心建设阶段,存储占整体预算在5-10%,远低于占比60-70%的GPU投入,但在运营阶段,存储产品对提升算力利用率、降低运营成本起到了重要作用。

首先,英伟达等GPU产品算力持续不断提升,2023年多数智算中心采购的是A100 GPU,2024年普遍换成了H100,算力带宽从200G提升至400G,对存储软硬件架构提出新的要求。如果存储产品无法匹配400G带宽要求,这对智算中心运营商来说是算力的巨大浪费。

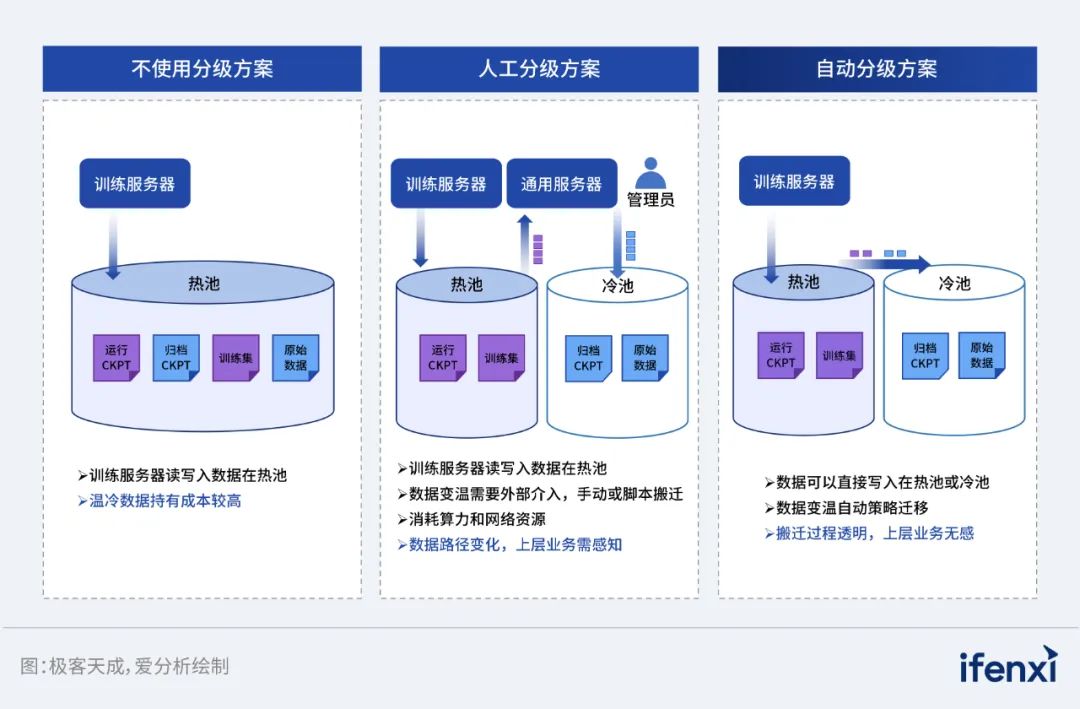

其次,通过数据自由流动、冷热分离等方式降低存储成本,是智算中心运营商都希望实现的功能,特别是在2024年闪存售价上涨15%的背景下。同时,智算中心希望尽可能降低运维成本,整个数据流动过程最好是业务无感知、自动化完成,对存储产品功能提出更高要求。

再次,很多智算中心为了满足当前信创要求,同时会购买华为、寒武纪等国产厂商的算力集群,每套算力集群单独搭配一个存储设备有些浪费,智算中心运营商希望通过统一存储来适配异构算力,这样可以节省空间和资源。

02

相比传统数据中心,智算中心对存储产品提出更高要求,新一代存储产品必须在存储介质、存储网络等方面有适配AI场景的技术特点。

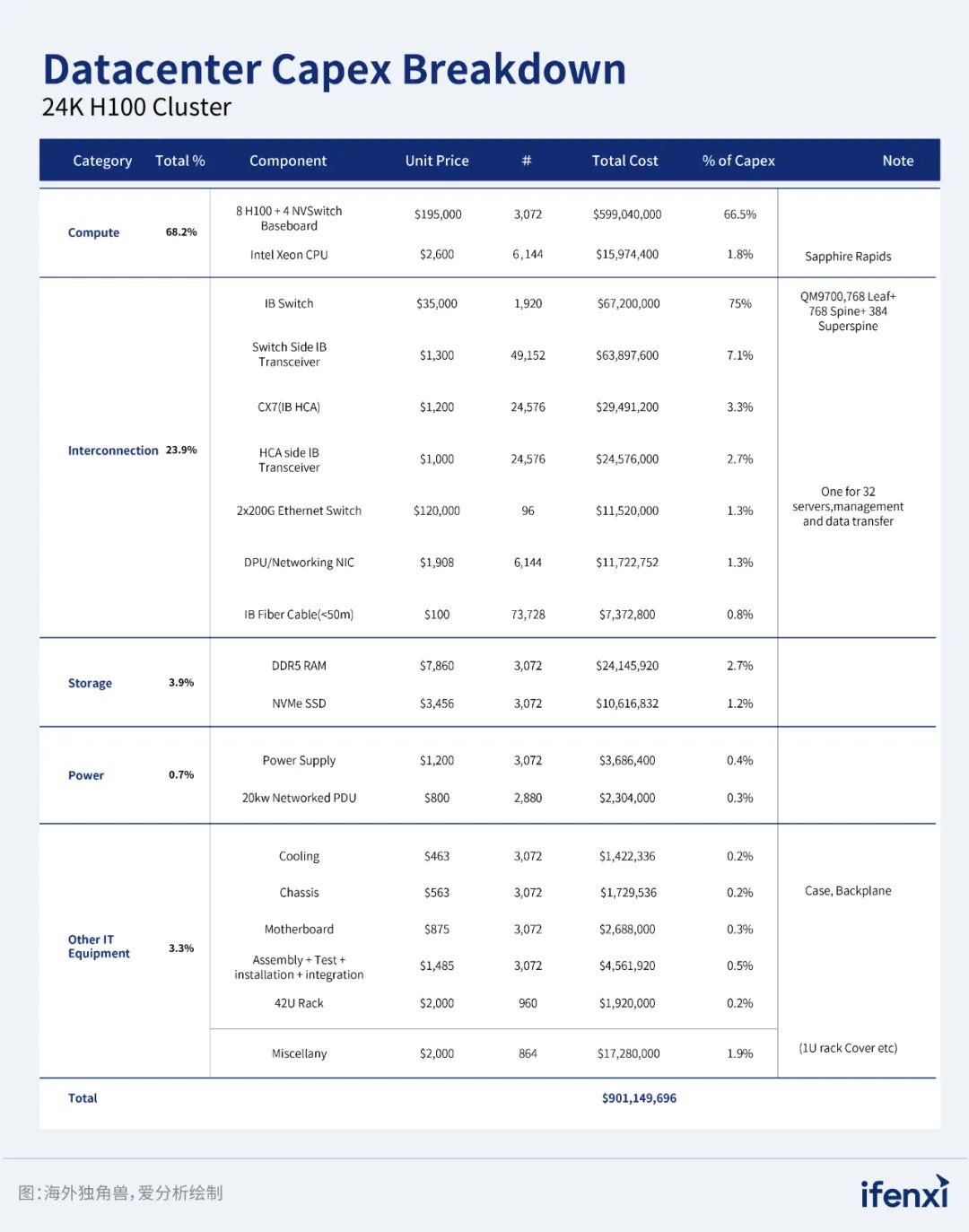

存储介质方面,目前全闪已经成为行业共识,混闪介质更多是服务于数据流动场景,用于冷数据存储等。在全闪阵列中,存储技术NVMe(Nonvolatile Memory Express)已经全面取代SATA(Serial Advanced Technology Attachment)成为主流,NVMe利用服务器中的PCIe高速总线,将其直连服务器,从而减少了CPU开销,降低延迟,提升IOPS和吞吐量。

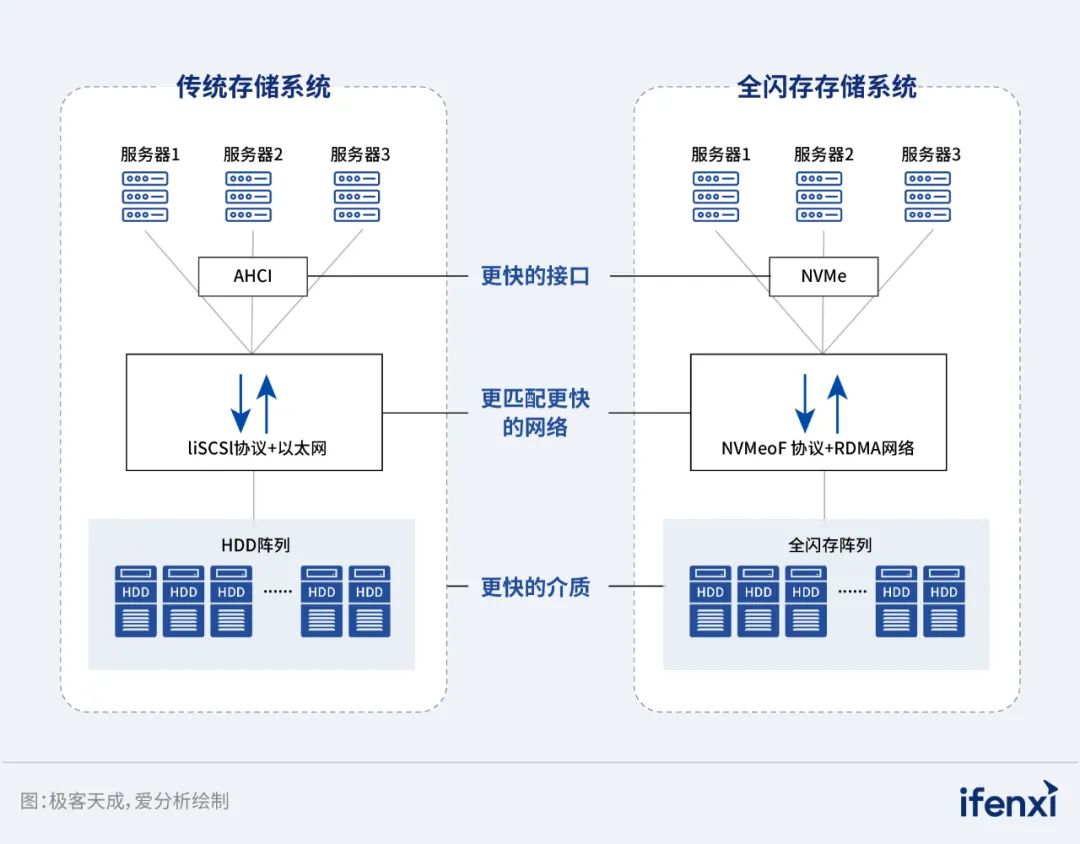

存储网络方面,越来越多用户开始接受RDMA(Remote Direct Memory Access)协议,替代传统TCP/IP协议。RDMA协议的特点是允许两台服务器直接读写对方的内存,而无需经过任何一台服务器,这带来两方面好处。一方面,基于RDMA协议能够实现高速传输数据,这在AI模型训练场景是至关重要的影响因素。另一方面,基于RDMA协议可以释放CPU,考虑到国产CPU产品的性能略逊于海外产品,这让CPU的性能劣势不会影响到存储产品性能。

03

AI存储厂商选型:性能、稳定可靠、功能

04

国内市场提供AI存储产品的原厂主要分成国际大厂和本土厂商。国际大厂包含IBM(GPFS)、DDN、VAST Data等,本土厂商一类是华为、中科曙光等IT综合服务商,另一类是以极客天成、焱融科技、XSKY为代表的专注存储产品厂商,极客天成作为一家2016年成立的基于RDMA技术的存储厂商值得关注。

极客天成的主要产品是极客追光全闪一体机,提供100% 的 NVMe 存储介质和多种高速连接主机接口选项。2U NVMe 平台是业界最快的存储解决方案之一,速度达120GB/s,并且以最小的外形尺寸交付多达24块 NVMe 固态硬盘(SSD),主要应用数据实时分析、深度学习、AI药物研发、大模型训练等场景。

相比其他存储厂商,极客天成在成立之初就确定了RDMA技术方向,分布式并行文件存储NVFile、分布式块存储NVMatrix、分布式对象存储NVObject都是基于RDMA技术底座。

尽管相较IT大厂,极客天成公司存续时间不长,但已经在金融证券、医疗、电信等领域有诸多客户案例,面向AIGC、量化投研等场景部署了千卡GPU训练集群,是专注存储产品厂商中落地部署千卡集群数量最多的厂商之一,产品的稳定可靠性得到初步验证。

注:点击左下角“阅读原文”,前往爱分析官网获取更多内容。