AIGC 是一种基于生成式 AI 技术的新型内容创作方式。本篇(更多内容参考“AIGC行业全景篇:算力、模型与应用的创新融合”)报告围绕 AIGC的发展历程与市场机遇、算力基础设施的发展趋势、大模型算法与商业模式的融合以及 AIGC 应用市场的创新发展来分析 AIGC 产业链的相关机会。

800+份重磅ChatGPT专业报告

1、人工智能的发展历程与AIGC 的市场机遇

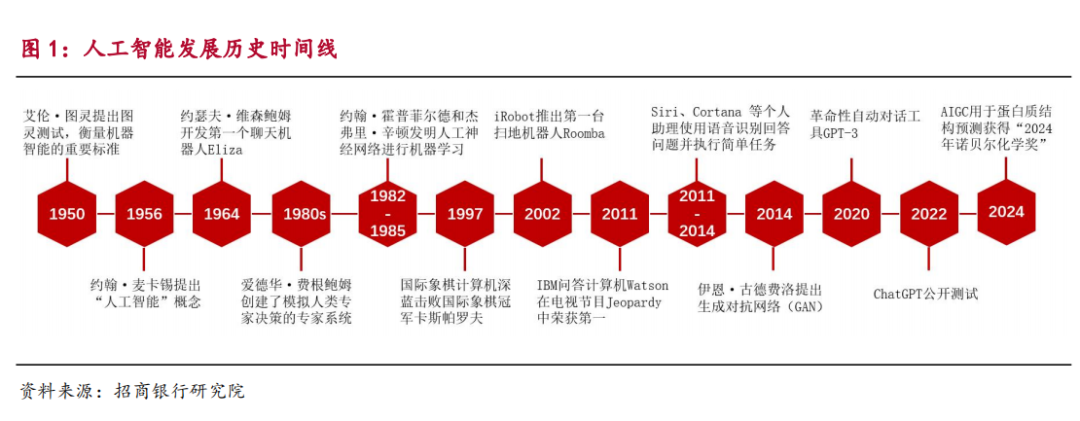

人工智能的历史可以追溯到 20 世纪 50 年代。1950 年,被誉为“人工智能之父”的艾伦·图灵(Alan Turing)提出了著名的图灵测试,借助“问”与“答”的方式来评估机器是否具备智能。

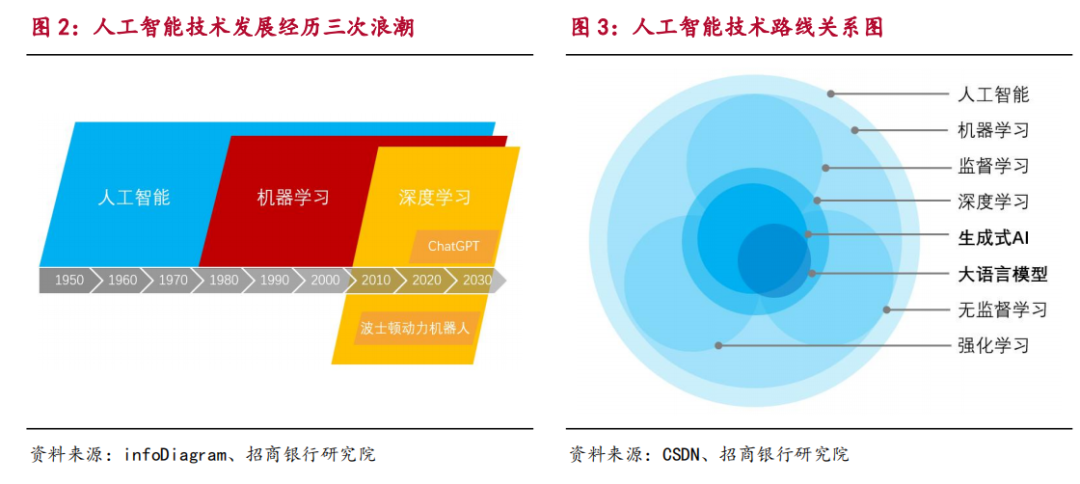

人工智能的发展历程可以划分为三次浪潮,从最初的逻辑推理和专家系统,到机器学习和深度学习,人工智能技术不断演进。

机器学习是人工智能的一个重要分支,使计算机系统能够从数据中汲取知识,进而做出预测或决策。现代人工智能技术广泛应用,如卷积神经网络(CNN)、递归神经网络(RNN)和生成对抗网络(GAN)等,特别是在自然语言处理(NLP)领域的突破,例如 BERT 和 GPT 系列模型,使得机器在理解和生成自然语言方面取得了显著进展。

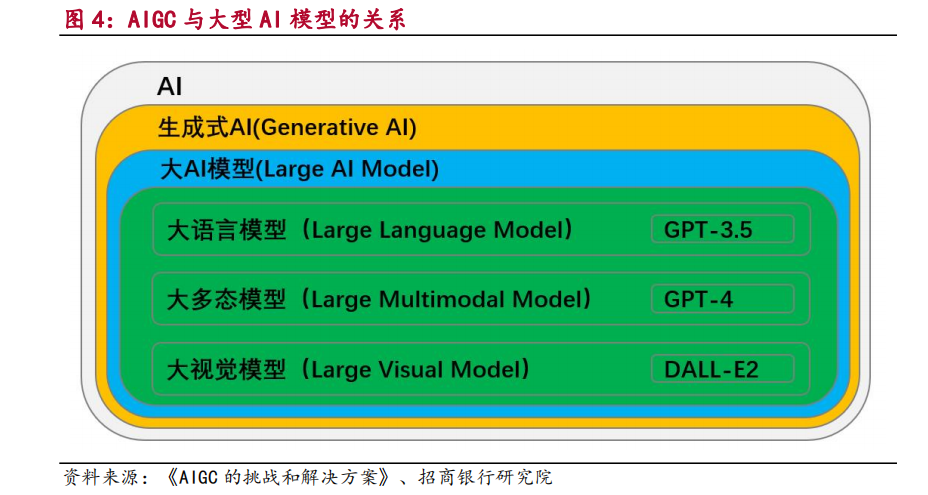

生成式 AI(Generative AI)作为深度学习的一个重要分支,是一种能够基于用户请求创造原创内容的人工智能技术。与传统 AI 主要关注于识别和预测现有数据模式不同,AIGC 则专注于创造全新的、有创意的数据。其核心原理在于学习和理解数据的分布,从而生成具有相似特征的新数据,能够生成文本、图像、音频、视频等多种形式的内容。

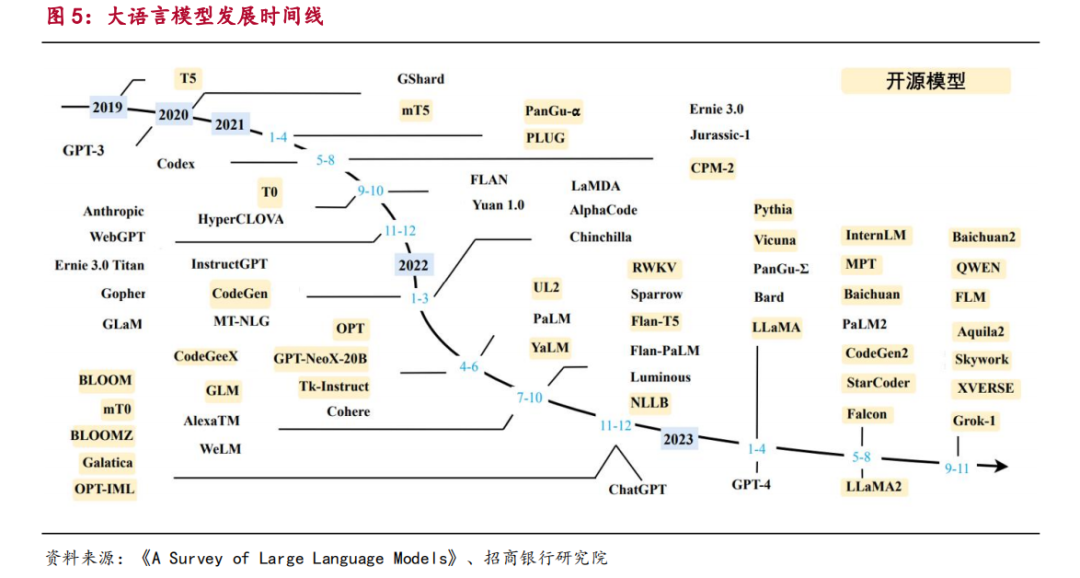

大语言模型的发展经历了基础模型、能力探索和突破发展三个阶段。2017年,Vaswani 等人提出的 Transformer 架构为大语言模型的演进奠定了坚实基础。自 2018 年以来,Google、OpenAI 和 Meta 等公司相继推出了多种大语言模型,如 OpenAI 的 GPT 系列、Google 的 Gemini 和 Meta 的 LLaMA 系列,推动了这一领域的迅猛发展。

2、AIGC 产业链结构与未来市场增长展望

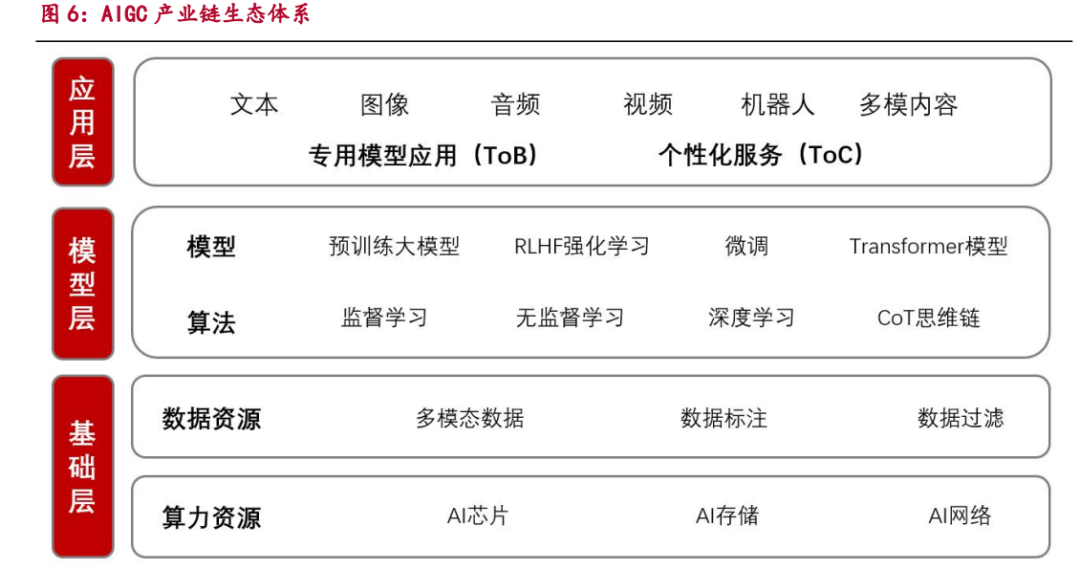

AI 产业链可分为基础层、模型层和应用层三个层面。基础层提供 AI 运行所需的底层算力资源和数据资源,其中算力资源涵盖 AI 芯片、存储、网络、安全及基础设施软件,数据资源则包括 AIGC 模型训练和优化所需的大量高质量多模态数据,以及数据分类、标记和清洗过滤的技术手段。模型层负责开发和优化模型算法,包括通用 AIGC 模型、行业应用微调模型,以及监督学习、无监督学习和强化学习等训练模型。应用层则涵盖针对企业的专用模型应用和针对个人用户的个性化服务,涉及文本、图像、音频、视频及多模态内容等多个应用服务方向。

基础层:大模型的技术发展推动算力需求激增,算力存储网络成为投资的主赛道

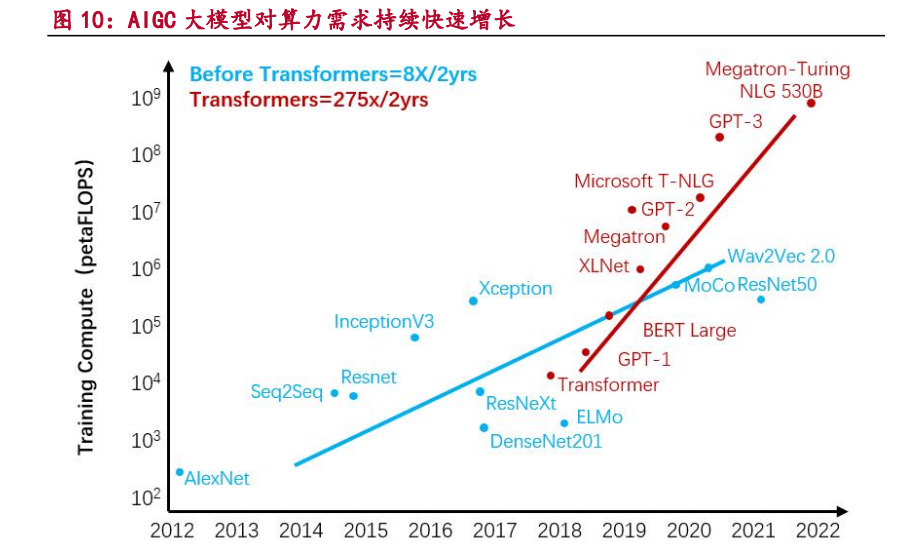

随着 AIGC 大模型性能的显著提升,对计算资源的需求也呈现出指数级的增长。以 GPT-4 为例,其训练过程需要约 2.15e25 FLOPS 的运算量,这通常需要动用约 25000 块 A100 GPU,且训练周期长达 90 至 100 天。此外,数据采集、模型优化和强化学习等环节的额外开销,使得整体成本变得更加高昂。

当前,人工智能领域的 AI 芯片家族日益壮大,主要包括 GPU(图形处理器)、FPGA(现场可编程门阵列)、ASIC(专用集成电路)和 NPU(神经拟态芯片)。其中,GPU 和 FPGA 属于成熟的通用型 AI 芯片,而 ASIC 则为特定 AI场景定制,如谷歌的 TPU、亚马逊的 Trainium 和微软的 Maia。

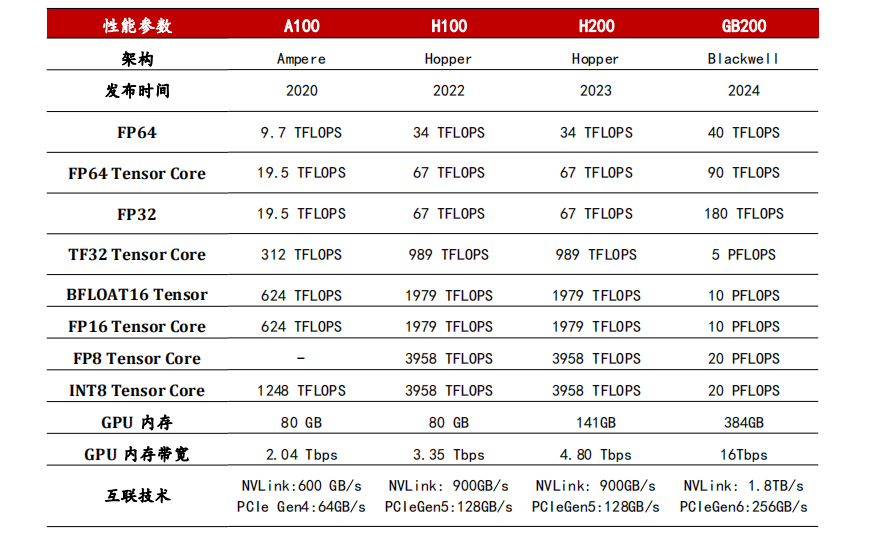

英伟达的 GPU 产品在 AIGC 的发展历程中扮演了至关重要的角色,其成功源于在硬件性能和软件生态方面的持续投入与创新。在硬件领域,英伟达推出了 Volta、Turing、Ampere、Hopper 和 Blackwell 等系列架构,这些架构配备了专为深度学习设计的 CUDA Core 和 Tensor Core,显著提升了 AI 训练与推理的效率。CUDA Core 负责基础运算,其数量通常与 FP32 计算单元相对应;而 Tensor Core 则在 Volta 及后续架构中引入,专门用于张量计算,与深度学习框架(如 TensorFlow 和 PyTorch)结合使用,带来了十几倍的效率提升。

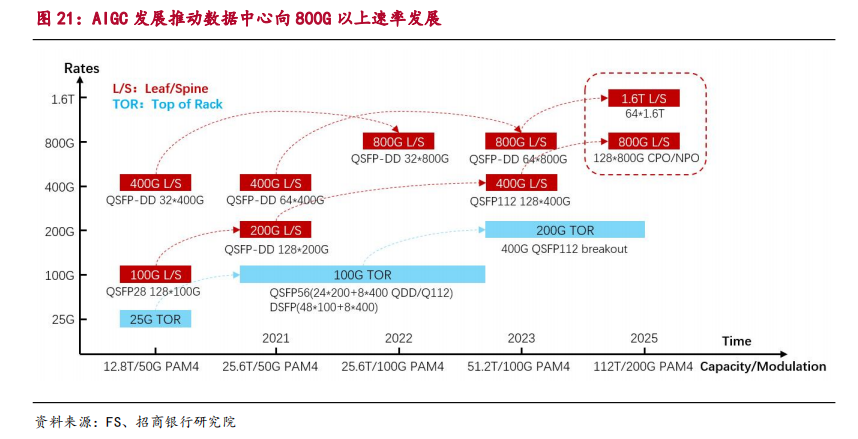

在 AIGC 算力架构中,高性能网络基础设施扮演着至关重要的角色。网络瓶颈可能导致 GPU 集群的利用率降低、大模型训练时间延长及训练成本增加。因此,为了满足 AIGC 计算的需求,尤其是在大规模 GPU 集群中,亟需大量高效的网络交换设备,以支持高速率、低时延、高吞吐量和高能效的数据传输。800G/1600G 网络技术的发展,能够提供更高的数据传输速率和更低的传输时延,从而加速 AIGC 模型的训练与推理过程。

模型层:算法进步、性能成本优化与商业模式多元化的融合

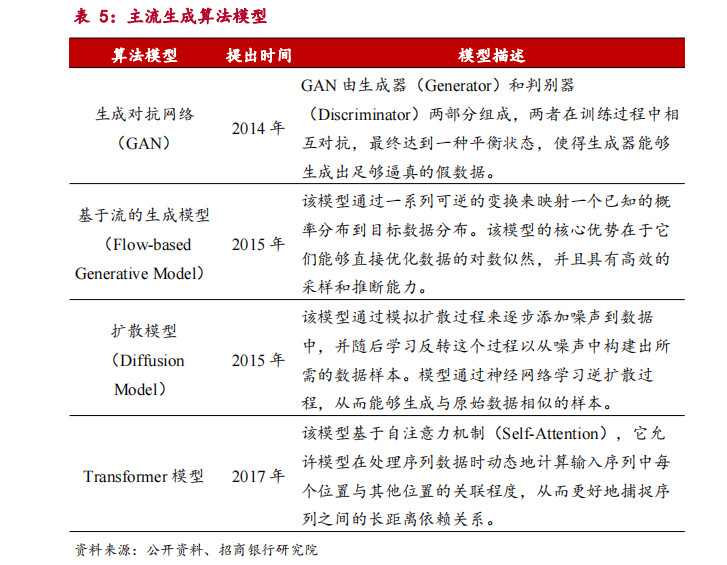

AIGC 的快速崛起得益于基础生成算法的持续创新与突破。核心生成算法,如生成对抗网络(Generative Adversarial Network,GAN)、扩散模型(Diffusion Model)和 Transformer 等,为 AIGC 的发展奠定了坚实的技术基础。这些算法的不断进步推动了 AIGC 的爆发,拓展了其在内容生成领域的应用潜力。

Transformer 模型引入了自注意力机制,使得模型能够根据输入序列中的不同部分分配不同的注意权重,从而更有效地捕捉语义关系。这一创新催生了众多变体,如 BERT、GPT 和 XLNet 等,这些模型在各自领域取得了显著成果,推动了自然语言处理等行业的发展。伴随着生成式算法的不断创新突破,AIGC 如今能够生成多种类型的内容和数据,包括文本、代码、图像、语音和视频物体等,展现了广泛的应用潜力。

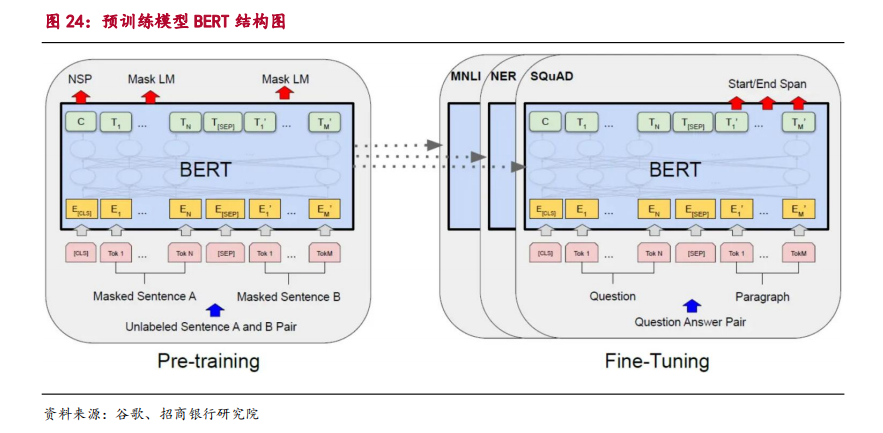

谷歌推出了基于 Transformer 架构的自然语言处理预训练模型BERT,标志着人工智能领域进入了一个以大规模预训练模型参数为核心的新纪元。BERT 的核心创新在于其双向训练策略,能够同时考虑单词左侧和右侧的上下文信息,使得其在理解单词含义时更为精准。通过在大量文本数据上的预训练,BERT 学习到了深层次的语言表示,这些表示可以迁移到多种下游 NLP任务中,如文本分类、问答系统和命名实体识别等。BERT 通过微调(Finetuning)进一步适应特定任务的需求,极大地提升了自然语言处理的效果和应用广度。

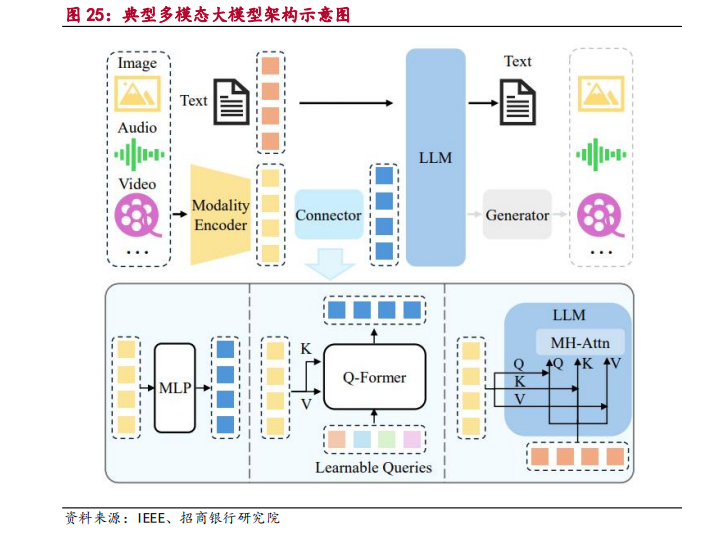

一个典型的多模态大型语言模型(MLLM)可以抽象为三个核心模块:预训练的模态编码器(Modality Encoder)、预训练的大型语言模型,以及连接它们的模态接口(Connector)。类比于人类,模态编码器相当于接收和预处理光学/声学信号的人类眼睛和耳朵,而大型语言模型则像是理解并推理处理信号的人类大脑。在这两者之间,模态接口的功能是对齐不同的模态。以 GPT-4V 为代表的多模态大型语言模型在多模态任务中展现出了前所未有的能力。

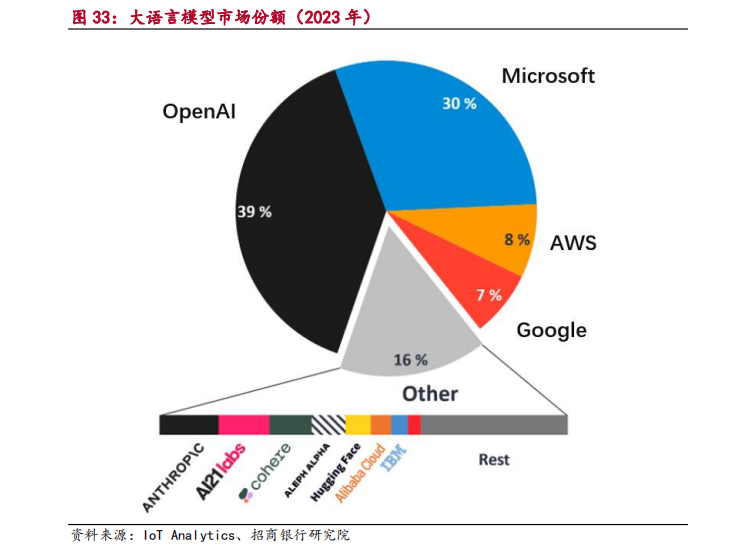

在大语言模型市场,OpenAI 凭借其卓越的技术成为市场的领头羊。根据IoT Analytics 的分析,OpenAI 在推出 ChatGPT 短短两个月内便实现了月活跃用户数突破 1 亿,成为有史以来用户增长速度最快的消费级应用程序。凭借ChatGPT 的成功,OpenAI 在大语言模型市场中以 39%的市场份额处于领先地位。紧随其后的是科技巨头微软(30%)、亚马逊(8%)和谷歌(7%)。

应用层:技术创新推动应用市场发展和传统行业变革

AIGC 技术在面向消费者(ToC)和面向企业(ToB)领域都有广泛的应用场景。随着技术的持续演进和迭代,这些应用场景和商业模式正不断拓展和演变。

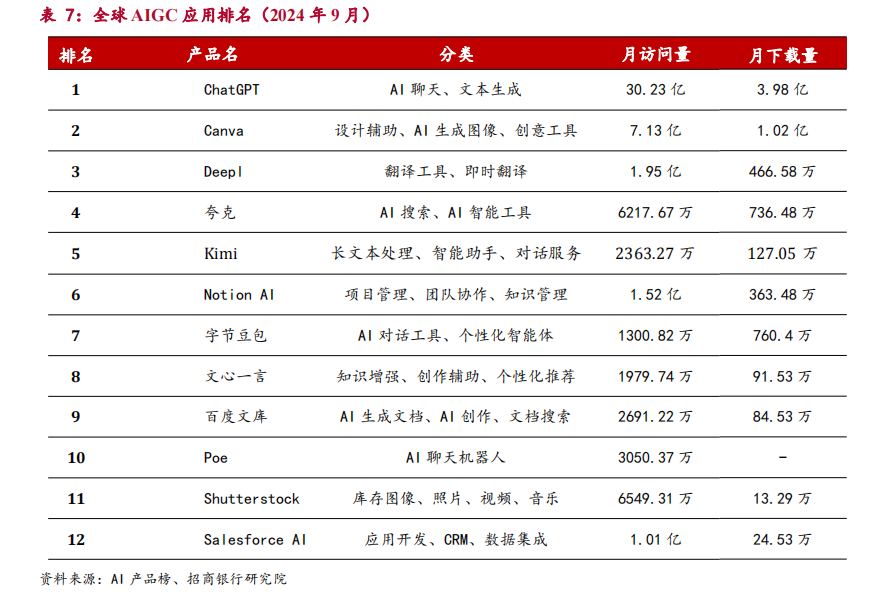

AIGC 应用产品种类繁多,其中 Chatbot 占据领先地位。根据 AI 产品榜的数据,全球市场上,ChatGPT 的月访问量已突破 30 亿次,使其成为全球第十一大网站。从产品分布来看,AIGC 赛道涵盖了多个领域,包括 Chatbot、内容创作、翻译、搜索、教育和知识管理等。在国内市场,前十的应用主要以Chatbot 为主,同时 AI 搜索的占比也在逐步提升。

AIGC 应用市场正呈现出多元化的竞争格局,发展态势持续演变。随着越来越多的初创企业和中小型公司进入市场,这些企业致力于推出针对特定行业的AIGC 产品,如医疗、广告、金融和教育等领域的定制化应用工具。

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。