一、 A100 VS A800

1. 推出背景与基本信息

💡A100:英伟达于 2020 年推出的一款具有重要影响力的 GPU。它是英伟达数据中心平台的关键引擎,是一款专为大规模数据处理和复杂计算任务设计的高端芯片。

🌟A800:2022 年第三季度投入生产,是英伟达面向中国推出的一款图形处理单元处理器,可看作是 A100 的一种替代产品。其诞生背景是在特定的市场环境和出口管制等因素影响下,为了满足中国市场的需求而推出。

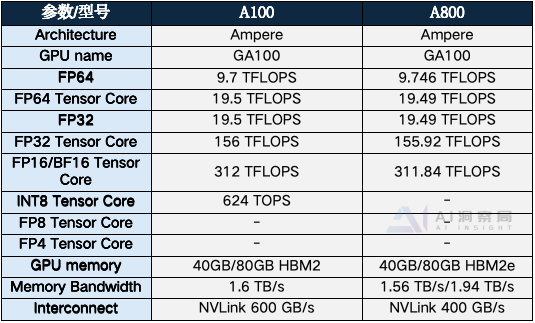

2. 核心参数对比

3. 应用场景

🔍A100:由于其强大的性能和优秀的计算能力,适用于对计算性能和显存要求较高的专业领域,如大型数据中心、人工智能研究机构、高性能计算中心等。它能够支持大规模的人工智能训练和推理、科学计算、数据分析等任务,是人工智能和高性能计算领域的重要计算设备。

🚀A800:更适合一般的图形渲染、普通的机器学习任务以及一些对计算性能要求不是特别高的应用场景。例如,中小型企业的数据分析、一些简单的人工智能应用等。

4. 价格与市场定位

💡 A100作为一款高端的 GPU,其价格相对较高,大约在1.5万美元左右,约合人民币10.8万元。A100是英伟达在高端计算市场的旗舰产品,旨在为专业的人工智能和高性能计算领域提供顶级的计算能力,是追求极致性能的用户的首选。

🌟A800价格相对较为亲民,售价大约在1.2万美元,约合人民币8.7万元人民币。A800是在特定市场环境下推出的一款产品,其市场定位更侧重于满足中国市场等特定区域的需求,以及那些对计算性能要求较高但预算相对有限的用户。

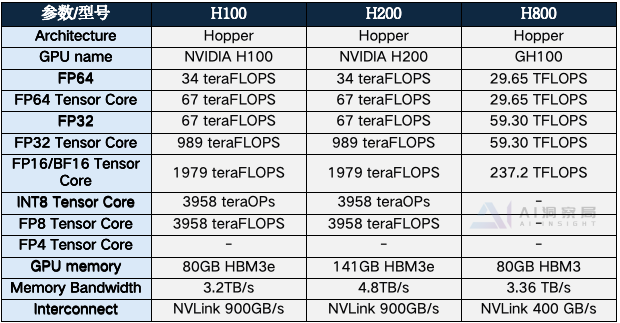

二、H100 VS H200 VS H800

1. 推出背景与基本信息

🔍H100:英伟达H100芯片是在2022年3月22日GTC技术大会上公布的一款全新架构的GPU芯片,H100旨在为AI训练和推理、HPC以及数据分析应用提供卓越性能,与上一代产品相比,可将大型语言模型的速度提高惊人的30倍。

🚀H200:英伟达H200是H100的升级版,于2023年11月13日正式宣布发布。H200拥有141GB的内存和4.8TB/秒的带宽,推理速度几乎达到了H100的两倍。

💡H800:是英伟达 H100 的中国特供版,在 2022 年美国对华半导体出口管制规定的背景下推出。

2. 核心参数对比

3. 应用场景

🌟H100(Hopper架构旗舰产品):

H100专为大规模AI和高性能计算(HPC)设计,提供了极高的计算性能和扩展能力。它适合用于以下场景:

大规模AI训练和推理、科学计算和模拟、数据中心和云计算。

🔍H200(针对中国市场的定制版本):

H200作为H100的后续版本,提供了更高的性能和能效,主要面向中国市场。它的应用场景包括:

高性能计算、人工智能、数据中心。

🚀H800(针对中国市场的定制版本):

H800是专为中国市场设计的GPU,它在H100的基础上进行了一些调整,可能在功耗管理和价格定位方面有所不同。H800的应用场景包括:

高性能计算和AI、云计算和数据中心

4. 价格与市场定位

💡H100 作为英伟达的高端 GPU,单卡价格在21万人民币至29万人民币之间,提供卓越的AI训练和推理性能。它拥有18432个CUDA核心和高速的HBM3显存,支持广泛的AI应用场景,尤其在大规模数据集处理和模型训练方面表现出色。

🌟H200作为英伟达在高性能计算领域进一步迭代升级的产品,其研发投入及性能提升也使得它在价格上处于较高水平,单卡的价格报价区间为245万-255万元人民币。H200与H100兼容,可以无缝替代H100,为用户提供升级路径。

🔍H800由于其特殊的市场定位和符合出口管制规定的特点,单卡的售价在2024年9月的市场报价为270万人民币。H800作为H100的衍生版本,它的市场定位可能更侧重于特定的应用场景,如在数据中心和云计算环境中提供高效能的数据处理和存储解决方案。

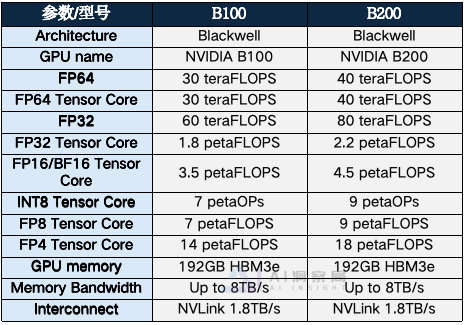

三、 B100 VS B200

1. 推出背景与基本信息

🚀B100:采用英伟达的 Blackwell 架构,这是英伟达在 GPU 技术上的一次重大升级。它采用专门定制的台积电 4N(4 纳米)工艺制造(是 H100/RTX40 4N 工艺的增强版),已经达到双倍光刻极限尺寸。这种先进的制造工艺为 B100 带来了更高的集成度和更低的功耗,能够在有限的空间内集成更多的晶体管和计算单元,从而提升芯片的性能。

💡B200:同样基于 Blackwell 架构,但它首次采用了 chiplet 晶粒封装技术,实际上包含两颗 B100。这种封装技术可以将多个小芯片组合成一个大芯片,提高芯片的性能和灵活性,同时也有助于降低成本。通过英伟达高带宽的片间互联技术,B200 的两颗 B100 芯片能够协同工作,实现更强大的计算能力。

2. 核心参数对比

3. 应用场景

🌟B100:高性能计算(HPC)、深度学习训练、数据分析

🔍B200 :超大规模数据中心、人工智能和机器学习、高性能计算(HPC)

4. 价格与市场定位

🚀B100:售价在 3 万至 3.5 万美元之间,按照当前汇率换算,约合人民币 21 万至 24.5 万元左右。B100是英伟达的一款 BlackWell 架构高端人工智能芯片,被视为 AI 计算领域的强大算力引擎。其主要面向数据中心、云计算、人工智能研究机构、大型科技企业等对高性能计算有极高需求的客户。

💡B200:目前关于 B200 单独的售价信息较少,但搭载 8 块 B200 GPU 的 NVIDIA DGX B200 AI 服务器在 broadberry 上的标价为 515410 美元(约合人民币 364.2 万元)。B200也是英伟达 BlackWell 架构下的一款高性能芯片。它主要应用于大规模的人工智能计算任务,特别是在对算力和内存带宽要求极高的场景中表现出色。

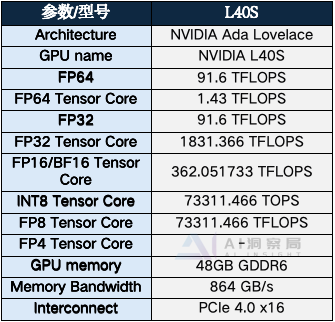

四、NVIDIA 旗下极为强大的 GPU -L40S

1. L40S基本信息介绍

🌟L40S 作为 NVIDIA 旗下极为强大的 GPU 之一,于 2023 年重磅推出。它旨在全力应对下一代数据中心所面临的各类工作负载,涵盖了生成式 AI、大型语言模型(LLM)的推理与训练、3D 图形渲染以及科学模拟等诸多重要场景。

🔍相较于前一代的 GPU,如 A100 和 H100,L40S 在推理性能方面展现出了卓越的优势。其能够提供高达 5 倍于部分前代产品的推理性能,并且在实时光线追踪(RT)性能上,更是达到了高达 2 倍的提升幅度,这无疑为其在相关领域的应用提供了更为强劲的性能支撑。

2. 性能参数

3. 应用场景

🚀L40S的应用场景包括:

模型训练、高性能推理、生成式AI、光线追踪与3D图形渲染、流媒体和视频处理。

L40S就是L40的一个变化体,前身L4(适合75瓦或更小的功率包络,旨在处理人工智能推理以及数据中心的图形和视频编码工作负载)。

4. 价格与市场定位

💡英伟达L40S显卡在2024年4月的批发价格大约在七八万元人民币。这一价格相较于其最初的价格有所下降,当时的价格约为12万元人民币。

🌟英伟达L40s是一款专为边缘计算和物联网设计的高性能GPU。它采用了NVIDIA Turing架构,具有出色的计算性能和能效。这款GPU可以轻松应对各种复杂的计算任务,包括深度学习、计算机视觉和高性能计算等领域。此外,L40s还具备低功耗和高扩展性的特点,使得它能够在各种场景下稳定运行。

来源:AI洞察局

作者:Z同学

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。