本文来自“谷歌TPU:为更专业的AI计算而生”,上篇“十年一剑,TPU引领AI芯片时代”。除谷歌外,国产 TPU 厂商中昊芯英逐渐崭露头角。从产品上看,公司首款 TPU 芯片刹那已于 23 年底量产,为国内 AI 产业提供自主可控方案。

谷歌视角:如何理解 TPU 的生态位?

自2015 年谷歌推出自研的 TPU以来,尽管谷歌没有对外出售自研的 TPU,但随着谷歌 TPU 的不断发展,其出货量随着每一代新 TPU 的推出而加速增长。随着 TPU v4(2021 年推出)和大型语言模型的出现,谷歌芯片业务的规模显着增加,23 年 TPU 已经突破了 200 万颗量级。

不对外售卖,以租赁方式作为主要盈利来源。根据 Capvision,Google AI 算力一直采用自建租赁模式。自家 TPU 平均每 1-1.5 年更新一代,其中 70%-80%的算力用于内部业务场景(搜索,广告,视频,Gemini 等)使用,剩余 20%-30%以租赁方式供外使用。

据集微网,目前全球已经有多家科技公司使用谷歌的 TPU 芯片。超过 60%获得融资的生成式 AI 初创公司和近 90%生成式 AI 独角兽都在使用谷歌 Cloud 的 AI基础设施和 Cloud TPU 服务,并广泛应用于社会经济各个领域。例如 Anthropic、Midjourney、Salesforce、Hugging Face 和 AssemblyAI 等知名 AI 创企在大量使用 CloudTPU。

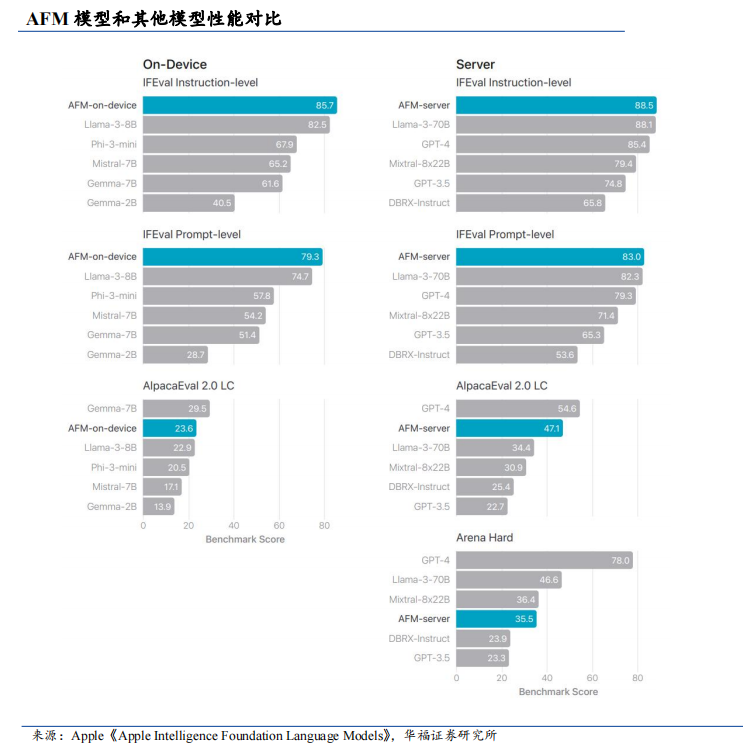

24 年7 月,苹果公布其使用了 2048 片 TPUv5p 芯片来训练拥有 27.3 亿参数的设备端模型 AFM-on-device,以及 8192 片 TPUv4 芯片来训练其为私有云计算环境量身定制的大型服务器端模型 AFM-server。Apple 整体战略部署上早年就意识到NVIDIA CUDA 闭源模式弊端不利于自身生态的长远发展,自 TPUv3 时代便开始使用 Google TPU+GPU 算力,并借助 JAX 开源平台与 CUDA 底层逻辑相似性,实现快速部署迁移训练(Google 开源的 JAX 以其与 CUDA 相似的开发框架逻辑,降低用户学习与迁移成本,实现市场突破)。另加之 2023 年全球市场 N 卡排队,进一步促进双方合作。

为什么谷歌 TPU 能够成功?

首先,自产自销,算力与算法紧密联结。若将 TPU 理解为 ASIC 芯片的一种,ASIC 作为依产品需求不同而定制化的特殊规格集成电路,具有高性能、低功耗优势,但它们只能执行特定算法。ASIC 生产成本高,因此当出货量较小时,采用 ASIC 并不经济。而当需求开始增加,芯片出货量增加,可通过芯片代工厂批量生产来降低成本。谷歌能够预估和规划自己在哪个阶段需要多少计算资源,也清晰地知道通用GPU上的哪些功能单元是用不到的,这也是为什么谷歌不选择使用现有的GPU芯片,而是自行研发生产 TPU 的重要原因。

其次,自身能力过硬,对 AI 理解深入且前瞻。业界普遍认为没有厂商比谷歌更懂 AI 用户的需求,所以谷歌根据自己的需求定制化开发的 TPU 芯片一经发布就引发了大量讨论。站在此时去回看,也会发现谷歌引领了 AI 芯片的发展方向。

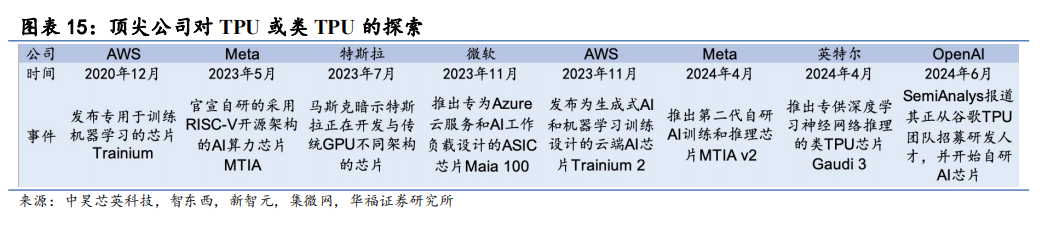

TPU 浪潮初现,更多 AI 科技龙头开始探索 TPU 或类 TPU。除谷歌外,全球越来越多的顶尖科技公司开始研发或使用 TPU 或类 TPU 架构的 AI 专用芯片。科技巨头们在尖端 AI 训练方面开始寻求更多元化的解决方案的趋势。

国产 TPU 厂商中昊芯英崭露头角

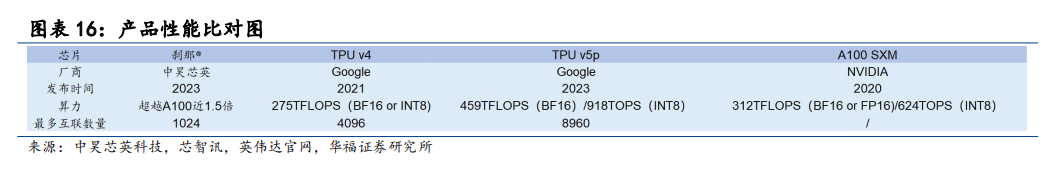

在 AI 芯片领域,TPU 厂商并不多见,除谷歌外,国产 TPU 厂商中昊芯英逐渐崭露头角。从产品上看,中昊芯英首款 TPU 已量产,为国内 AI 产业提供自主可控方案。中昊芯英历时近五年研发的刹那 TPU AI 芯片已于 23 年底实现量产,拥有完全自主可控的 IP 核、全自研指令集与计算平台。在处理大规模 AI 模型计算任务时,相较于英伟达 2020 年推出的 A100,刹那的计算性能超越其近 1.5 倍,在完成相同AI 大模型计算任务量时的能耗降低 30%,单位算力成本仅为其 42%。刹那以独特的高达 1024 片芯片高速片间互联的能力构建大规模智算集群泰则,系统集群性能远超传统 GPU 数十倍,可支撑超千亿参数 AIGC 大模型计算需求。该成就不仅打破了国外企业在高端 AI 芯片领域的垄断地位,更为国内 AI 产业的发展提供了自主可控的解决方案,解决了卡脖子难题。

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。