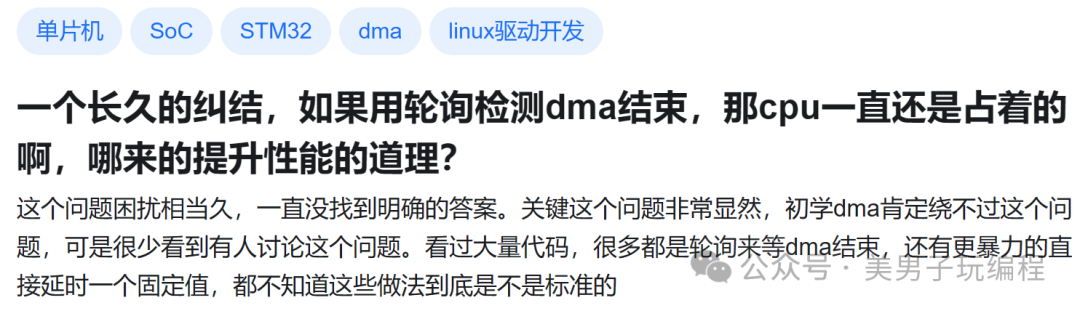

来源于小伙伴提问。

你提出的确是一个非常经典的DMA问题,而且很容易让人一开始觉得有些“鸡肋”。

既然要提升性能,那为什么还要在CPU上做轮询呢?这其中确实有一些技术上的细节和设计考量值得深挖。

1

DMA的核心理念与CPU解放

DMA(直接内存访问)的主要设计理念是让数据传输不再依赖CPU的参与,从而释放CPU资源,使它可以处理其他任务。

而在没有DMA的情况下,数据传输往往是通过CPU来一字节或一字一字地搬运数据,这显然是低效的,尤其是在需要高速传输的数据流(比如音视频传输或图像处理)中,CPU忙于传输就会限制它执行其他更重要的任务。

2

轮询等待 vs 中断等待

你提到的轮询检测DMA完成的方式确实是存在的,但这并不意味着这种方式是“标准”的。

轮询和中断是两种检测DMA完成的方法,各有优缺点:

轮询:CPU不停地检查DMA传输状态,这样会占用CPU时间。对于小型、快速传输的DMA任务,轮询有时是比较“省事”的方式,因为通过轮询,CPU可以马上知道DMA何时完成。然而,对于长时间传输或多任务系统,轮询会消耗CPU资源,不是理想选择。

中断:更理想的方式通常是通过中断等待,DMA完成后触发中断,由中断处理程序告知CPU数据传输结束。中断可以让CPU在DMA传输期间执行其他任务,避免了不必要的轮询。但中断也有缺陷,频繁的中断可能会增加上下文切换的开销,而且对响应时间有较高要求的应用,频繁中断会导致性能波动。

3

为什么有时候看到代码用轮询或者固定延时?

在实际代码中,很多时候我们确实会见到开发者使用轮询甚至固定延时来等待DMA完成,这种做法往往是为了简化逻辑或是因为性能需求不高的情况下选择的折中方案。

轮询的优势在于简单直观,开发者可以直接控制等待的逻辑,不需要处理复杂的中断响应,尤其是对于较小的数据传输任务,轮询的CPU消耗可能并不明显。

延时等待,如设置一个固定时间,基本上是“低技术含量”的解决方法,在一些资源受限的系统或者简单的应用场景下,这种方法“够用”就行。

但这种方式在实际传输时间难以准确预估时很不稳定,因此更像是一种快速原型或简化测试用法。

4

高效DMA设计中的几种方案

要想真正提高效率,通常会结合DMA特性和实际应用的需求来选择合适的方法。

以下是一些更合理的方案:

中断与任务调度结合:在一些RTOS或嵌入式操作系统中,DMA中断可以用来唤醒特定任务,这样在等待DMA的同时,CPU可以去执行其他任务。当DMA完成时,通过中断触发调度器恢复等待DMA完成的任务。

双缓冲/多缓冲技术:如果是需要持续数据流(比如音视频),可以设置双缓冲,甚至是多缓冲。这样当一个缓冲区的数据传输完成后,DMA可以自动切换到下一个缓冲区,而CPU则可以处理已经完成的数据。这种方式能提高数据处理的并行性,但需要稍复杂的缓冲管理。

中断优先级控制:在多任务环境下,可以对DMA完成中断设置较低的优先级,从而不会打断高优先级的任务处理;当系统进入空闲状态时再去响应DMA的完成中断。这种设计需要精细的优先级控制,但能保证CPU资源的合理分配。

5

DMA轮询的实际适用场景

虽然轮询存在上述限制,但在一些特殊场景下仍然会有实际应用:

小规模、短周期的数据传输:在一些低功耗、资源受限的场景下,DMA传输量小而频繁,DMA完成时间短,此时轮询带来的性能损失较小。

紧耦合硬件模块:有时CPU和DMA在紧密耦合的硬件中(如MCU中的一些外设),传输时间已知且很短。这种情况下,轮询可能是直接而高效的选择。

在一般场景下,轮询检测确实不算最佳实践,因为它会占用CPU时间,没有实现DMA的“解放CPU”理念。

大多数场景下更推荐中断的方式处理DMA完成,尤其是在复杂的嵌入式系统和多任务系统中。

选择哪种方案主要取决于具体应用对CPU利用率的要求、实时性需求和系统复杂度。

实际上,轮询、延时等方式更多是为快速实现某个功能或原型验证,而非最佳的工程方案。

这些方法虽然简单,但在性能要求高的生产环境中通常会被优化掉。