本周,亚特兰大 SC24 会议上热议的 11 月份 Top500 超级计算机排名较 5 月份在德国汉堡 ISC24 会议上发布的 6 月份名单有了很大变化,而且正在安装的新机器也有一些有趣的进展。

当然,最大的新闻是,期待已久的“El Capitan”系统由惠普企业公司打造,采用 AMD 的混合 CPU-GPU 计算引擎,现已投入运行,并且不出所料,成为排行榜上新的flopper。而且,它远远领先于美国的竞争对手,以及中国传闻的百亿亿次级机器的规格。

El Capitan 的很大一部分(截至撰写本文时我们还不知道它到底有多大),包括 43,808 台 AMD“Antares-A”Instinct MI300A 设备(根据我们的计算),已经由劳伦斯利弗莫尔国家实验室根据各种基准进行了测试,包括自 1993 年以来用于对超级计算机进行排名的高性能 Linpack 测试。使用 HPL 测试的 El Capitan 部分的峰值理论性能为 2,746.4 petaflops,明显高于我们预期的 2.3 exaflops 到 2.5 exaflops。(当然,这是针对 64 位精度的浮点运算而言的。)HPL 测试的峰值持续性能为 1,742 petaflops,计算效率为 63.4%。这是我们对新加速系统进入市场时所期望的效率水平(我们的标准是 65%),我们预计在 2025 年的后续排名中,El Capitan 将在基准测试中发挥更多的理论容量,因为该系统正在逐步获得劳伦斯利弗莫尔的认可。

提醒一下,MI300A 于 2023 年 12 月与其兄弟 MI300X(具有八个 GPU 芯片组,没有 CPU 内核)一起发布。MI300A 有三个芯片组,总共有二十四个“Genoa”Epyc 内核和六个 Antares GPU 流式多处理器芯片组,运行频率为 1.8 GHz。在 Cray EX 系统中,所有 MI300A 计算引擎都通过 HPE 的“Rosetta”Slingshot 11 以太网互连相互连接。总而言之,在测试的 El Capitan 部分中,GPU 芯片组上有 105 万个 Genoa 内核和略低于 1000 万个流式多处理器。这显然需要管理大量的并发。但这并不疯狂。位于中国无锡国家超级计算中心的神威“太湖之光”超级计算机自 2016 年以来一直位列 Top500 排行榜,至今仍是全球第十五强大的机器(至少在使用 HPL 测试的机器中),总共拥有 1065 万个核心。

在劳伦斯·利弗莫尔 (Lawrence Livermore) 于 SC24 进行简报之后,我们将单独深入研究 El Capitan 机器的架构,并且我们将在这里链接到该故事。

每一份 Top500 榜单都是新旧机器的混合体,随着新机器使用 HPL 进行测试,其所有者提交结果,之前榜单上性能较差的机器将被淘汰,不再是 Top500 的一部分——即使它们仍在使用。此外,美国、欧洲和中国的许多机器并不将 HPC 模拟和建模作为日常工作,但这些机器也被列入榜单,因为公司及其 OEM 合作伙伴想要操纵榜单。通用集群上的 HPL 信息很有趣,但它会扭曲所谓超级计算机的排名。说实话,我们长期以来只将 Top50 机器视为真正的超级计算机,并一直在努力想出一些方法让这个排名更有用。

早在 6 月份,我们就决定只关注榜单上的新进入者,试图以此作为衡量 HPC 领域发展情况的指标。我们将再次对 2024 年 11 月的排名进行细分,看看人们最近购买和测试了什么。有一些有趣的趋势,我们打算从现在开始以这种方式关注这些变化。

根据 2024 年 6 月的排名,Top500 榜单上有 49 台新机器,这些新机器在 64 位浮点精度下的总峰值性能为 1,226.7 petaflops,其中七台新超级计算机(它们确实是执行 HPC 工作的超级计算机)基于 Nvidia 的“Grace”Arm 服务器 CPU 和“Hopper”H100 GPU 加速器,总峰值为 663.7 petaflops,占 2024 年 6 月榜单新增容量的 54.1%。使用 AMD Epyc 处理器与 Nvidia GPU 相结合的系统占新计算能力的另外 8.1%,使用 Intel Xeon 处理器与 Nvidia GPU 相结合的系统占 2023 年 11 月下旬至 2024 年 6 月初安装并使用 HPL 测试的容量的另外 17.5%。另外还有 23 台全 CPU 机器,这些机器在许多 HPC 环境中出于软件兼容性的原因仍然是必需的,但这些机器的总计算量仍然只占所有新 64 位浮点运算的 12.1%。

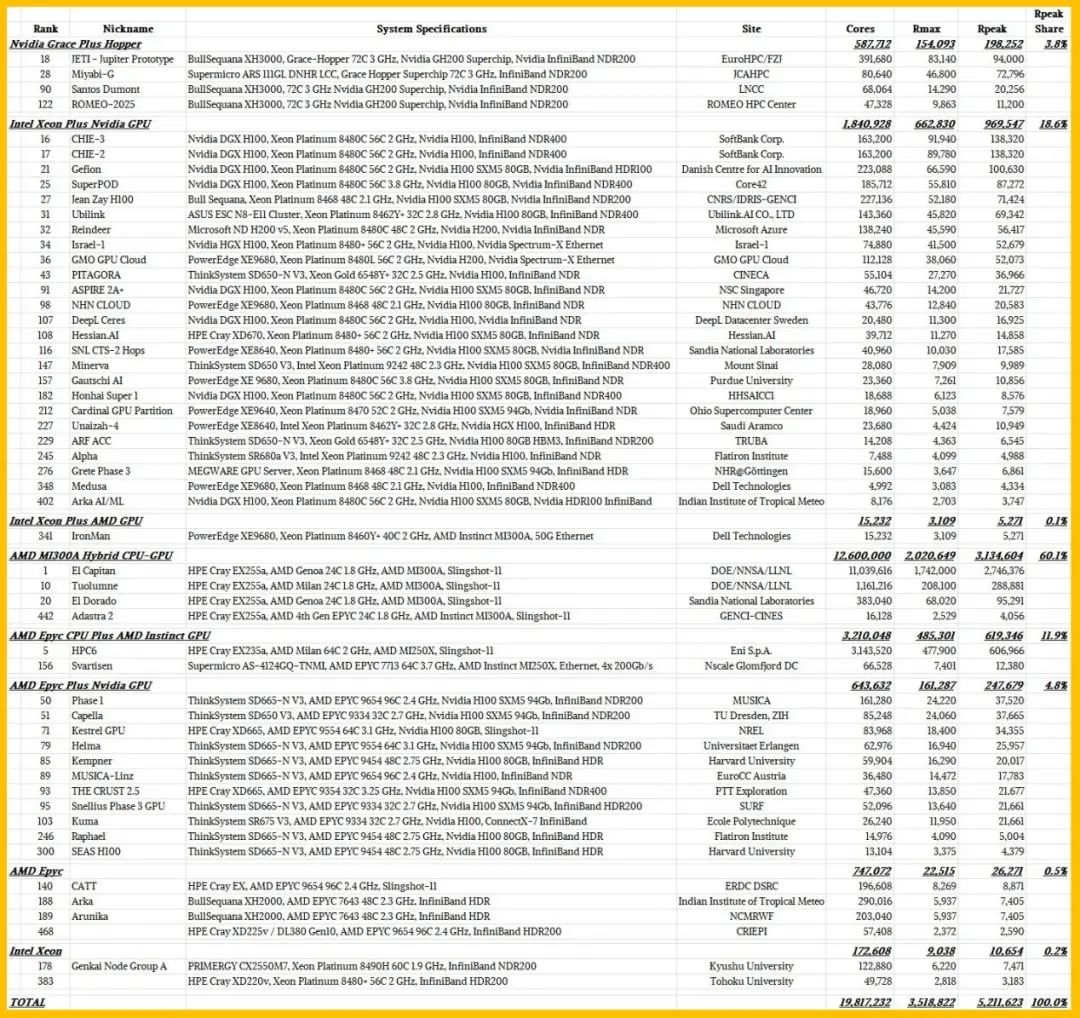

这次,在 2024 年 11 月的 Top500 排名中,AMD 在增加 HPC 基础容量方面是最大赢家。列表中有 61 台新机器,这里按计算引擎架构排序:

这次,只有 4 台新的 Grace-Hopper 系统,规模相当适中,仅占名单上新机器总峰值性能 5,211.6 petaflops 的 3.8%。

不过,有 25 台新机器在主机上安装了 Intel Xeon CPU,并以 Nvidia GPU 作为卸载引擎,这些机器合计拥有 969.6 petaflops 的计算能力,占榜单上新计算总量的 18.6%。有趣的是,戴尔为自己制造了一台 5.3 petaflops 的机器,绰号“钢铁侠”,将 AMD Instinct MI300A 加速器与 Intel Xeon CPU 配对。(为什么?) 还有 11 台机器拥有支持 Nvidia GPU 加速器的 AMD Epyc CPU 主机,峰值性能总计为 247.7 petaflops。合并后的 Nvidia GPU 机器占 2024 年 11 月 Top500 榜单新增总计算量的 39%。

这次,El Capitan 及其四款基于 MI300A 混合计算引擎的小型同类产品完全击败了 Nvidia,FP64 性能达到 3,134.6 千万亿次浮点运算,占总计算量的 60.1%,是当前 Top500 榜单中首次亮相的机型。这在很大程度上要归功于意大利 Eni SpA 安装的 HPC6 机器(我们在 1 月份写过这台机器),它基本上是安装在美国橡树岭国家实验室的“Frontier”超级计算机的小型克隆版,11 月榜单中又增加了 619.3 千万亿次浮点运算,这是两台基于 AMD CPU 和 AMD MI250X GPU 的机器的功力。

总而言之,AMD GPU 为 2024 年 11 月的排名贡献了 72.1% 的新增性能。

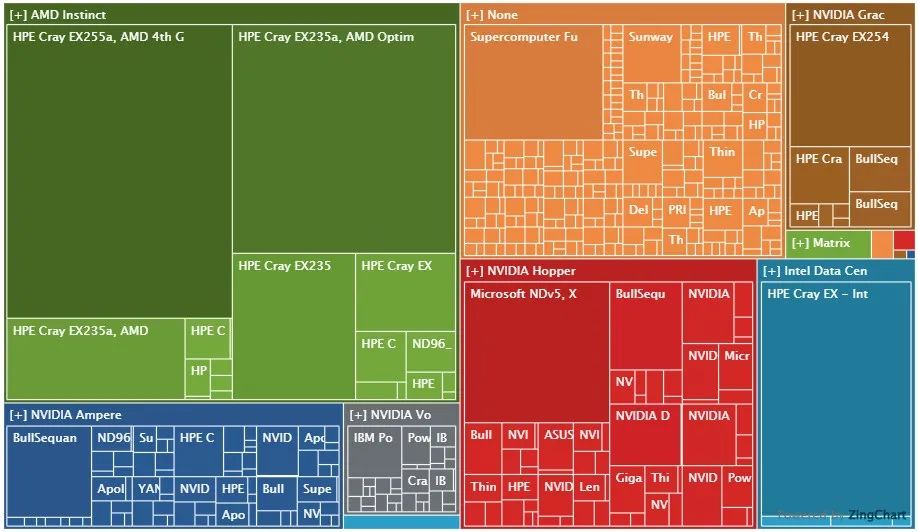

现在,让我们将目光放宽到 11 月份的完整 Top500 榜单,并查看榜单中所有 209 个加速系统。看看这个漂亮的树形图中是如何细分的:

上图中的框大小代表 HPL 的总体持续表现。

左上角的绿色区域以 El Capitan 和 Frontier 为基准,包括所有使用 AMD CPU 和 GPU 组合的机器。Nvidia Grace-Hopper 机器位于右上方,使用各种 Nvidia GPU 的机器位于蓝色、灰色和红色框中;Intel GPU 机器(少数)位于右下方的青色中,焦橙色机器是仅使用 CPU 的系统。

只是为了好玩,我们根据加速器类型和总系统数量、峰值每秒万亿次浮点运算次数以及按架构划分的总核心数对列表中的 209 台加速机器进行了排序。请看下面:

目前,使用英特尔“Ponte Vecchio”Max GPU 加速器的机器仅占 4 个系统(500 台中的 1.9%),但占峰值性能的 14%,其中绝大部分来自安装在阿贡国家实验室的“Aurora”系统。

有 183 台机器在任何主机上使用 Nvidia GPU,它们占 2024 年 11 月列表中已安装加速机器的 87.6%,但仅占 FP64 精度总峰值容量的 40.3%。有 19 台机器使用 AMD GPU 进行大部分计算,这仅占加速机器的 9.1%。但这占 FP64 总峰值容量的 44.9%。得益于 El Capitan、Frontier、HPC6 和其他 16 台机器,AMD 现在在 Top500 榜单上在这方面击败了 Nvidia。

如果你查看列表中的所有 500 台机器,加速系统占 2024 年 11 月列表中机器总数的 41.8%,总计 17,705 千万亿次浮点运算的 83.4%,以及总核心数 1.286 亿个加上流式多处理器的 55.4%。

突破百亿亿次级障碍比很多人想象的要困难得多,这主要是由于预算和功耗的限制,而不是任何潜在的技术问题。中国的百亿亿次级机器——“天河三号”和“海洋之光”——尚未向 Top500 组织者提交正式的 HPL 性能结果,因此没有排名,但它们表明,如果您不关心使用了多少电力或机器的成本,那么几年前在现场使用百亿亿次级机器不仅是可能的,而且已经做到了。(一年前我们最好的猜测是天河三号的峰值 FP64 性能为 2.05 百亿亿次浮点运算,而海洋之光的峰值为 1.5 百亿亿次浮点运算。)

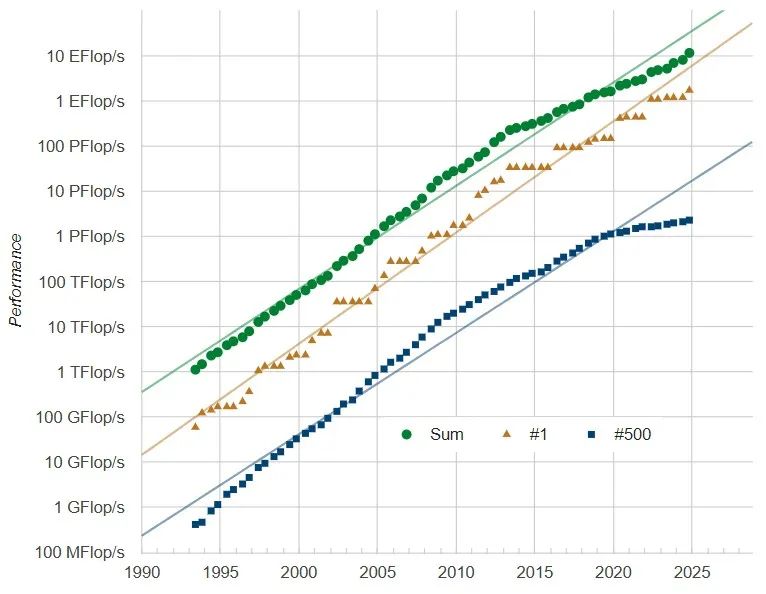

Top500 榜单的末尾确实很难跟上我们过去对 HPC 系统所预期的对数图,而且我们也没有理由相信,未来 10 百亿亿次浮点运算和更大的机器(如果它们实现的话)会拉高同类平均水平。如果我们想回到对数曲线上,机器必须变得更便宜,而即使每单位性能的成本不断下降,它们的价格也在不断上涨。

这一次,要进入 Top500,需要一台在 HPL 基准测试中至少有 2.31 千万亿次浮点运算的机器。进入 Top100 的机器是 12.8 千万亿次浮点运算。有趣的是,名单上的总体 HPL 性能为 11.72 百亿亿次浮点运算,高于 2024 年 6 月的 8.21 百亿亿次浮点运算、2023 年 11 月的 7.01 百亿亿次浮点运算和 2023 年 6 月的 5.24 百亿亿次浮点运算。这些大型机器正在提高总体性能,但较小的 HPC 中心增加容量的速度不够快,无法在名单上的五百台机器上每两年翻一番。这可能与云端 HPC 的兴起相吻合,也可能不相吻合。如果没有来自云构建者的一些数据,很难说。

“El Capitan”超级计算机,开创先河

每隔几年,劳伦斯利弗莫尔国家实验室就会安装世界上速度最快的超级计算机。值得庆幸的是,该 HPC 中心通常选择的机器不仅能够完成管理美国军方核武器库存的使命,而且还能选择能够推动超级计算技术发展的各种技术。

历史告诉我们,劳伦斯·利弗莫尔会做到这些,而今天在 SC24 超级计算机大会上发布的“El Capitan”系统,历史确实在重演。但这一次略有不同,因为 El Capitan 是在地球历史上最大规模的超级计算能力建设中启动的。

据我们和劳伦斯利弗莫尔的专家所知,从许多指标来看,El Capitan 可以与超大规模企业和云构建者为 AI 训练运行而启动的大型机器相媲美。El Capitan 是一台专门为运行有史以来最复杂、最密集的模拟和建模工作负载而定制的机器,它恰好在 GenAI 革命的核心——新型大型语言模型方面表现相当出色。

而且得益于 Cray 设计的“Rosetta” Slingshot 11 互连和惠普企业销售的 EX 系列系统的核心组件,El Capitan 已经采用了 HPC 增强型可扩展以太网,这与超级以太网联盟 (Ultra Ethernet Consortium) 试图推进的技术路线类似,因为超大规模企业和云构建者厌倦了为他们的 AI 集群支付 InfiniBand 网络的高昂费用。

但也许更重要的是——人们对此考虑得不够——劳伦斯利弗莫尔将获得一台极其强大的 HPC/AI 超级计算机,而其价格比如今的超大规模计算公司、云构建商和大型 AI 初创公司支付的价格要低得多。很难准确地说出两者之间的差异,但我们初步粗略计算得出,El Capitan 每单位 FP16 性能的成本是 Microsoft Azure、Meta Platforms、xAI 和其他公司正在构建的大型“Hopper”H100 集群的一半。

作为国家安全不可或缺的一部分,像 El Capitan 那样突破系统设计的架构极限,以及拥有渴望证明其在设计混合 CPU-GPU 计算引擎方面的勇气,并且将超快的 HBM 内存输入到这些融合设备之间的共享内存空间,都有好处。

最后,El Capitan 与超大规模企业、云构建者和 AI 初创公司正在构建的野兽机器之间还有一个巨大差异。El Capitan 将管理核武器,而核武器反过来可能导致我们星球上发生灭绝级事件(或者根据你的观点,通过相互保证摧毁原则避免灭绝),而 AI 集群本身就是可能导致地球发生灭绝级事件的机器。(让我们希望 El Capitan 的 AI 处于强大的沙箱中。)

美国库存中的核武器需要进行模拟,以确保其正常运行——《禁止核试验条约》禁止我们通过引爆来确认其功能。还需要重新设计库存中的核武器并重新使用其炸药,但禁止核试验意味着这必须通过模拟才能完成。因此,美国能源部为超级计算投入了巨额预算。

2019 年 8 月,惠普企业 (Hewlett Packard Enterprise) 获得了价值数百万美元的 El Capitan 合同,当时我们只知道这台机器将使用 Slingshot 互连,成本约为 5 亿美元,并提供至少 1.5 百亿亿次浮点运算的持续性能。就在几个月前,HPE 表示将以 13 亿美元收购 Cray,我们认为,与美国能源部正在建造的三个百亿亿次级系统的庞大物料清单相比,Cray 的规模相对较小,这可能是 HPE 一开始就被“鼓励”收购 Cray 的原因之一。

无论如何,当时,El Capitan 的持续性能预计至少是 IBM 为实验室构建的“Sierra”混合 CPU-GPU 系统的 10 倍,并且功率范围为 30 兆瓦。2020 年 3 月,劳伦斯利弗莫尔表示,它正在与 AMD 合作开发 El Capitan 的计算引擎,并进一步表示,该系统的峰值理论 FP64 性能将超过 2 百亿亿次浮点运算——实际系统可以以 64 位分辨率进行计算——功耗约为 40 兆瓦,成本不超过 6 亿美元。(“升级!”)

El Capitan 混合 CPU-GPU 系统已在劳伦斯利弗莫尔安装并几乎满负荷运行,人们一致认为这是世界上传统模拟和建模工作负载性能最高的系统。其中包括传闻中的中国“天河三号”(2.05 百亿亿次浮点运算)和“海洋之光”(1.5 百亿亿次浮点运算)超级计算机的峰值性能。

2022 年 6 月,劳伦斯利弗莫尔和 AMD 宣布他们将采用融合的 CPU-GPU 设备(AMD 几十年来一直将其称为加速处理单元或 APU)作为 El Capitan 系统的主要计算引擎。从那时起,每个人都在试图猜测“Antares”Instinct MI300A 设备的时钟速度是多少,设备中有多少个 GPU 计算单元,以及它们将以什么时钟速度运行。事实证明,我们认为 MI300A 的时钟会更高,因此需要更少的时钟才能达到性能。我们还认为,劳伦斯利弗莫尔获得的机器比预期的还要快,因此性价比甚至比预期的还要好。

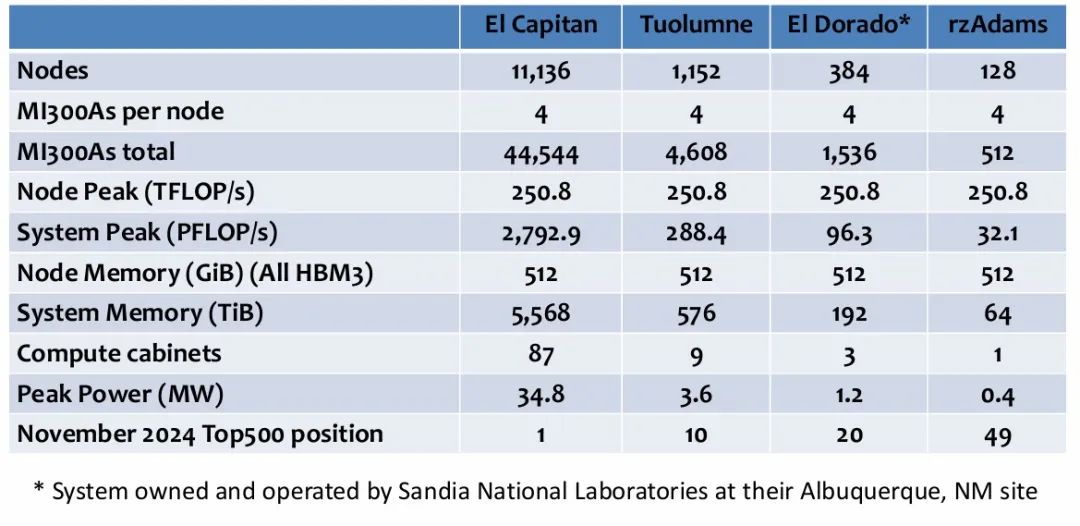

劳伦斯利弗莫尔国家实验室利弗莫尔计算部门首席技术官 Bronis de Supinski 告诉The Next Platform,El Capitan 系统中共有 87 个计算机架,还有数十个额外的机架用于容纳其“Rabbit”NVM-Express 快速存储阵列,我们早在 2021 年 3 月就详细介绍过它。

El Capitan 在液冷 Cray EX 机架中总共拥有 11,136 个节点,每个节点有四个 MI300A 计算引擎,整个系统共有 44,544 个设备。每个设备都有 128 GB 的 HBM3 主内存,由 CPU 和 GPU 芯片共享,运行频率为 5.2 GHz,可为 CPU 和 GPU 芯片提供总计 5.3 TB/秒的总带宽。

根据 11 月份 Top500 排行榜的数据,MI300A CPU 芯片组的运行频率为 1.8 GHz,而 AMD 规格表显示 GPU 芯片组的峰值运行频率为 2.1 GHz。有三个“Genoa”X86 计算复合体,每个复合体有八个核心,总共 24 个核心,采用台湾半导体制造公司的 5 纳米工艺蚀刻而成。MI300A 设备上的六个 Antares GPU 芯片组上有 228 个 GPU 计算单元,总共有 912 个矩阵核心和 14,592 个流处理器。在矢量单元上,MI300A 的峰值 FP64 性能为 61.3 万亿次浮点运算,在矩阵单元上,FP64 是其两倍,为 122.6 万亿次浮点运算。

每个 El Capitan 节点的峰值 FP64 性能为 250.8 teraflops,将所有这些节点连接在一起时,您将获得 2,792.9 petaflops 的 FP64 总性能,前端有 5.475 PB 的 HBM3 内存。CPU 和 GPU 计算芯片下方有四个 I/O 芯片,用于将这些元素粘合在一起并连接到 HBM3 内存;这些芯片采用台积电的 6 纳米工艺蚀刻而成。

有趣的是,MI300A 封装上仍有六个计算芯片(AMD 术语中为 XCD),它们与六个 GPU 芯片完美平衡。橡树岭的“Frontier”超级计算机是 El Capitan 的姊妹机型,其定制“Trento”CPU XCD(单个芯片中每个节点八个)与四个独立的双芯片“Aldebaran”MI250X GPU 的比例也是一比一。这种一比一封装在多代 Cray 超级计算机的 CPU 和加速器之间一直保持着,这可能并非偶然。从某种意义上说,MI300A 是一个六路 X86 CPU 服务器,与六路 GPU 系统板交叉耦合。

下面是一个汇总表,显示了 El Capitan 系统及其位于劳伦斯利弗莫尔的 El Capitan 区块的“Toulumne”和“rzAdams”芯片以及位于桑迪亚国家实验室的“El Dorado”系统的进给和速度:

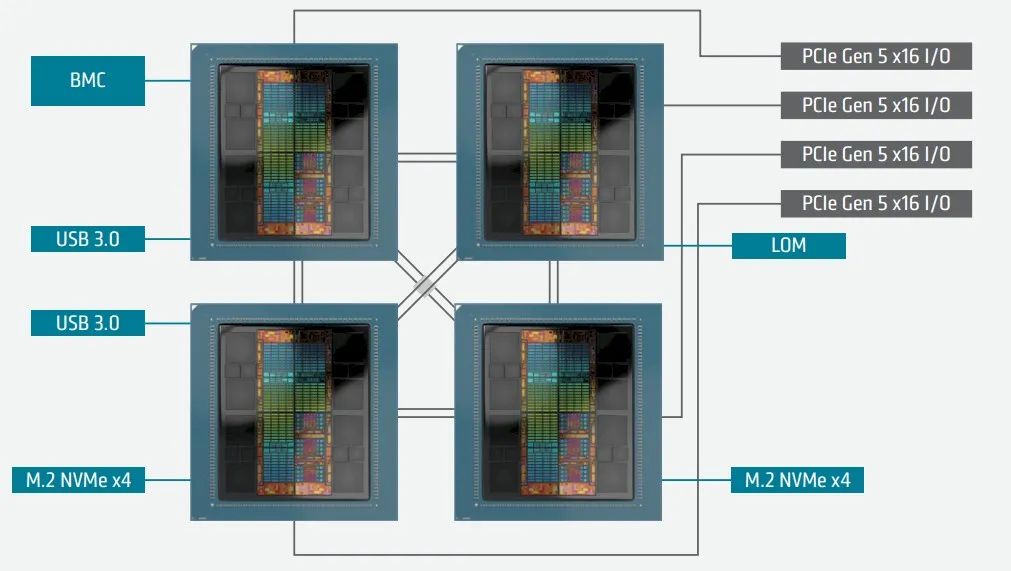

El Capitan 服务器节点的示意图如下:

如您所见,有四个 Infinity Fabric x16 端口,具有 128 GB/秒的总带宽,以内存一致的方式将四个 MI300A 设备相互连接。

另外还有四个端口,每个 APU 一个,来自 MI300A,可以配置为 PCI-Express 5.0 x16 插槽或 Infinity Fabric x16 插槽,在这种情况下,它们设置为前者,以允许插入 Slingshot 11 网络接口卡,这些接口卡实际上通过 Slingshot 11 结构将整个系统中的 APU 相互连接起来。

最后,关于 El Capitan 系统的一个有趣的想法是,从技术上讲,该系统在用于运行用于对超级计算机进行排名的高性能 Linpack 基准测试的那部分机器上的性能为 2,746.38 千万亿次浮点运算。(如果物理机器上总共有 44,544 个 APU,则该部分机器激活了 43,808 个 APU,占机器容量的 98.3%。)额定性能末尾的 46 千万亿次浮点运算(性能的第三和第四位有效数字)比 2024 年 11 月 Top500 榜单上除 34 台机器之外的所有机器都要大。当您说“2.7 百亿亿次浮点运算”时丢弃的那些四舍五入数字几乎与巴塞罗那超级计算中心的“MareNostrum 5”超级计算机的大小相同。

如果 Lawrence Livermore 让 HPL 在系统中的所有 APU 上运行,El Capitan 的性能将再提高 1.65%,我们认为,计算、内存和互连相互作用的改进可以使其性能再提高 5% 左右。如果 Lawrence Livermore 能够将软件和网络调优性能提高 7.5%,那么该机器的峰值 HPL 容量将突破 3 百亿亿次浮点运算,我们希望实验室能够实现这一目标,因为这很有趣。这将是五年前项目启动时 El Capitan 最初预期性能的两倍——而且按时按预算进行。

TensorWave 计划打造全球最大的 AMD GPU 集群

专注于 AMD 人工智能硬件的高端云服务提供商 (CSP) TensorWave 宣布正在开发基于 Team Red 魔法的全球最大 GPU 集群,该集群由 Instinct MI300X、MI325X和MI350X加速器提供支持。

TensorWave 计划让 AMD 的产品更具竞争力,旨在打破 NVIDIA 的垄断,计划使用 MI300X、MI325X、MI350X AI 加速器制造千兆瓦级 GPU 集群。

TensorWave 在互联网上广为流传,主要是因为它对AMD 的 AI 加速器持乐观态度,并且该公司的“AI 计算”产品组合都围绕着 Team Red 的产品。TensorWave 的主要目标是“使 AI 民主化”,它与 AMD 站在一起,并向潜在客户推广其“Instinct”系列 AI 加速器。

现在,根据 TensorWave 首席执行官 Darrick Horton发布的公告,该公司正在利用 Instinct MI300X、MI325X 和下一代 MI350X 加速器构建世界上“最大的”AMD GPU 集群。

TensorWave 计划利用即将推出的 AI 集群实现约 1 千兆瓦的“惊人”功耗,这表明我们应该期待 TensorWave 未来的项目具有强大的计算能力,尽管该公司目前尚未透露更多细节。另一个值得一提的有趣事实是,TensorWave 计划利用新推出的“超级以太网”互连标准,据说这是 AI 集群领域的卓越实现。

当你看到 NVIDIA 在 AI 市场中占据如此大的份额时,它确实为 AMD 等公司创造了“看涨”立场,这些公司正在努力填补红队留下的空白。虽然说我们看到的是一种“垄断市场”的形式并不为过,但 AMD 在保持竞争力方面仍然全力以赴,并不断完善其 AI 产品组合以吸引市场兴趣。

TensorWave 等 CSP 正在寻求让 AMD 在市场上占据主导地位,这就是为什么 Team Red 的 AI 领域仍然具有巨大的增长空间,前提是该公司坚持其一致性和计划。

免责声明

本平台所刊载的所有资料及图表仅供参考使用。刊载这些文档并不构成对任何股份的收购、购买、认购、抛售或持有的邀约或意图。投资者依据本网站提供的信息、资料及图表进行金融、证券等投资项目所造成的盈亏与本网站无关。除原创作品外,本平台所使用的文章、图片、视频及音乐属于原权利人所有,因客观原因,或会存在不当使用的情况,如部分文章或文章部分引用内容未能及时与原作者取得联系,或作者名称及原始出处标注错误等情况,非恶意侵犯原权利人相关权益,敬请相关权利人谅解并与我们联系及时处理,共同维护良好的网络创作环境。

芯通社

- SemiWebs -

专注半导体-手机通信-人工智能

请长按下面二维码关注芯通社

▼

伙伴们

错过也许就是一辈子

还不快关注我们?