编者注:应知识星球的星友要求,笔者与版权方协商提供知识星球版本(SSD闪存技术基础知识全解),已经上传至星球,请星友免费下载(仅用于学习用途),下载地址:SSD闪存技术基础知识全解(知识星球版)、服务器基础知识全解(知识星球版),存储系统基础知识全解(知识星球版)。

服务器行业报告:AI和东数西算双轮驱动,服务器在启航(2024)800+份重磅ChatGPT专业报告(合集)

服务器作为网络的节点,存储、处理网络上80%的数据、信息,被称为互联网的灵魂。它不仅是一个简单的机器,更像是一个精密的工程,由多个关键组件相互配合,以实现高效的数据处理和存储。

服务器是在网络中为其他客户机提供服务的高性能计算机;具有高速的CPU运算能力,能够长时间的可靠运行,有强大的I/O外部数据吞吐能力以及更好的扩展性服务器的内部结构与普通计算机内部结构类似(CPU、硬盘、内存、系统总线等)服务器Server:间接服务于多人;个人计算机PC:直接服务于个人工业场景使用比较多的就是架式服务器(一般2U )和刀片服务器(架式服务器的高密度版,一般8U或10U),插拔的每一个刀片都可以理解为是一个服务器)1.塔式服务器:外形以及结构跟立式PC的主机差不多3.刀片式服务器:机架式机箱内插装多个卡式的服务器单元(比较贵)X86架构:AMD、Intel做的比较好,32位的x86处理器

X86-64架构:64位的x86扩展处理器,有时也称为x64、IA-32、EMT64等架构手机端CPU厂商有高通骁龙、华为麒麟、联发科、三星猎户等,MCU端有STM32、GD32等服务器处理器有华为海思鲲鹏、Ampere、亚马逊Craviton3.MPIS架构、PowerPC架构、SPARC架构(可扩展处理器架构)Inter IA-64架构、AMD Athlon 64架构 05 也可以简单把服务器分为X86服务器和非X86服务器 X86:PC服务器,基于CISC复杂指令集(即我们使用的个人笔记本也可以理解为X86服务器)非X86:主要包括大型机、小型机和Unix服务器,这类服务器一般需要使用专门的操作系统(像X86只需要windows或linux就可以)1.X86我们一般都称之为微型机,而非X86的运算能力和性能要高很多,在服务器市场的定位为中高端,价格昂贵。(但是随着云计算的提出以及并行计算思想的提出,我们可以将一个大任务分为多个小任务,并将其分配过不同的机器进行运算,就可以使用多个微型机来实现大型的运算,因此虽然X86服务器的性能和可靠性并没有提升,但是整个X86集群的可靠性和性能得到了提升)@网 络 工 程 师 俱 乐 部(例如Hypersion软件,对于所有的X86服务器,虚拟化软件都可以使用-KVM、VMware等虚拟化软件就可以在所有X86服务器上运行)(不同厂商的非X86服务器需要定制化的操作系统、定制化的虚拟化软件-厂商A的非X86服务器的虚拟化软件就不能运行在厂商B的非X86服务器上),所以非X86服务器的横向兼容性和扩展性就很差。IO(阵列卡、网卡、HBA卡、HCA卡-应用于IB网络上的网卡等)管理模块(带内-消耗服务器资源/带外管理,服务器有专门的管理口-连接的是服务器内部的一个管理组件)固件(系统固件、硬件固件-例如BIOS/UEFI)系统软件(编程语言程序、操作系统、数据库管理系统等) 01 中央处理器CPU

CPU主要由ALU算数逻辑运算单元、Cache高速缓冲存储器、Bus总线组成CPU的时钟频率,指的是每秒CPU能够运算的次数,一般而言主频越高,CPU的速度越快超频:主频并不是固定不变的,在一些场景下可以超频运行,不过会伤害CPU的使用寿命降频:在节能模式下,系统CPU会进行降频,增强续航表示CPU的并行处理能力,核数越多并行处理速度越快指的是处理器的逻辑线程数量,一般一个核数对应一个线程超线程:一个物理核可以对应多个线程(将一个核心分为多个小的核心进行并行计算),实现单核可以并行处理多个事务,提高效率高速缓存也可以称为多级缓存,用来缓解内存带来的瓶颈;目前有2级、3级缓存。缓存量越大越好(因为目前内存发展滞后于CPU的)当芯片达到最大负荷时热量释放的指标,是电脑的冷却系统必须有能力驱散热量的最大限度VT是Inter的技术,AND对应的是ADM-v技术 02 内存

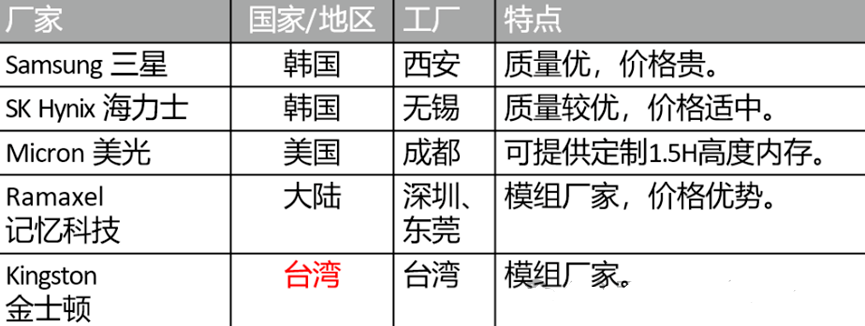

内存是和CPU配合工作的,CPU用于计算的时候会将所需要的数据和指令缓存在内存中,内存同时也需要和硬盘进行通信。1.内存主要分为RAM(随机存储器)、ROM(只读存储器)、Cache(高速缓存)(1)RAM:与CPU直接交换的内部存储器,也叫主存(内存),可以随时读写(2)ROM:一般在内存制造时就将相关数据写入到ROM中(一般存放计算机基本程序和数据),里面的信息只能读出;断电不会丢失(3)Cache:高速缓冲存储器,位于CPU和内存之间,是一个读写速度比主存更快的存储器(向主存进行数据的读写时,这些数据业户别存储进高速缓冲存储器中)当进行数据读取与访问时,CPU直接从高速缓冲存储器读取,而不是访问较慢的主存;如果需要的数据在Cache中没有,则CPU再去主存读取数据。内存主要分为SRAM静态随机读写内存,DRAM动态随机读写内存。SRAM的速度比DRAM快,功耗也较低,但是SRAM的成本比较高,一般用于高速缓存(如L1、L2、L3缓存)。DRAM通常就是我们使用的内存,主要由以下几种类型EDO DRAM(扩展数据输出动态随机存取存储器)DDR(双倍率同步动态随机存取存储器)、DDR2、DDR3、DDR4(主流)、DDR5与CPU主频一样,代表内存所能达到的最高工作频率,一般用来表示内存的速度。现在内存中都会配置高速缓存,通过分级高速缓存,来保证内存跟CPU通讯的速度越来越快。@网 络 工 程 师 俱 乐 部4、8GB内存为主流配置;SDRAM内存条有双面和单面两种设计,每一面采用8颗或9颗(多出的一颗为ECC)内存颗粒(内存芯片)。内存存取数据所需的延迟时间,就是内存接到CPU的指令后的反应速度。数据传送时采用的一种校正数据错误的一种方式,分为奇校验和偶校验两种(一般企业级的内存才会有ECC校验)。单位为ns(纳秒),数值越小,存取速度越快,价格越高。2Rx4:指的是该内存条有两面,每面有4个内存颗粒。有些内存条DDRx的型号是通过PCx来表示的(即 PC3也表示DDR3)。 03 硬盘

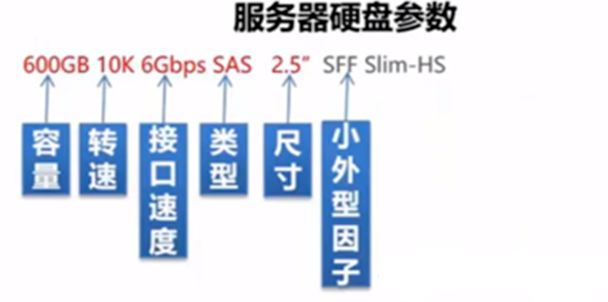

1.服务器有前置硬盘和后置硬盘,区别是什么——不绝对一般服务器后面插的硬盘我们称为本地盘(安装服务器的操作系统、应用软件等)。前面的硬盘可以用作配超融合的虚拟存储(即:在服务器上配置虚拟机的时候,一般分配前置硬盘的资源)。还有一种HHD混合硬盘(不仅有机械硬盘必备的磁头、碟片、马达等,还内置了NAND闪存颗粒)常见的扩容插槽为M.2和PCI-E--服务器为PCI-E,云终端为M.2 04 网卡、存储卡、RAID卡

这三类卡都通过PCI插槽插在服务器的主板上(与主板的接口一般是PCI接口、现在也有PCI-X、PCI-E接口)*普通场景使用电口网卡、但是在一些工业场景可能需要使用到光口网卡来提供更高速的网络连接。NIC:特指以太网卡,支持TCP/IP协议,应用于以太网络中CAN:融合网卡,本质上是以太网卡,但支持FCoE功能(FC over Ethernet)HCA:特指Infiniband网卡,即IB卡,应用于高带宽、低时延的高性能计算项目中HBA:FC-HBA网卡连接光纤交换机;iSCSI-HBA网卡,连接存储设备光口网卡:LC/SC/FC/ST接口(需要和光模块一起使用)用来实现光电转换,发送端把电信号转为光信号,通过光纤传送后,接收端再把光信号转为电信号(通过光纤可以传输很远的距离,并且传输速率高)。(1)根据接口速率可以分为SFP(1G)、SFP+(10G)、SFP28(25G)、QSFP+(40G)、QSFP28(100G)、XFP等。(2)根据传输距离可以分为单模、多模,单模传输距离远(更贵),多模传输距离近。用来做设备到光纤布线链路的跳接线(指的就是不同设备之间通过光纤布线链路来连接)LC(小方型卡接式-比SC个头小)、SC(大方型卡接式-路由器交换机使用的最多)、FC(圆型带螺纹-配线架上使用的最多)、ST(圆形卡扣连接)等。服务器通过存储卡可以直接和存储设备进行连接,使得存储设备为服务器提供存储服务。@网 络 工 程 师 俱 乐 部HBA卡就可以称为存储卡,常用的有FC-HBA(连接光纤交换机),iSCSI-HBA(连接存储设备)。解决本地磁盘配置RAID的问题,通过RAID卡这个硬件可以直接将本地磁盘配置为RAID组(也有软件方式)。https://mp.weixin.qq.com/s/6rtLiPeuQ9YjnIryTr1I-g关于CPU、服务器和存储详细技术及资料获取,请参考“下载提醒:服务器基础知识全解(终极版)”,“2023年服务器计算机CPU行业报告”、“2023年机架式服务器行业洞察”、“2023~2025服务器CPU路线图”、“2023服务器产业链及市场竞争格局”、“存储系统关键技术全解(终极版)”、“更新下载:存储系统基础知识全解(终极版)”、“存储芯片技术基础知识介绍(2023)”等等。ARM vs x86云数据库性能深度测评与对比

从Arm v8到v9,服务器发展之路

ARM与x86:有何区别?

Arm增长突出,中国服务器市场占比达16%

分布式软件:X86/ARM CPU混合部署

Arm竞争加剧,全球众多巨头涌入

ARM处理器架构和天梯图解析

信创始于芯:Arm64体系结构编程与实践

ARM v8处理器概述、架构、及技术介绍

飞腾系和鲲鹏系:国产Arm架构CPU服务器正在崛起

Fujitsu A64FX:继承SPARC64架构的Arm超级处理器

收藏:从全球超算战略看ARM指令架构在HPC领域的发展

众多科技巨头涌入ARM,国内研发进展及玩家详解

亚马逊最新Arm服务器芯片详解

计算芯片变革:ARM取代x86成为趋势

国内外AI芯片、算力综合对比

华为算力编年史(2023)

AI算力研究框架(2023)

大模型训练,英伟达Turing、Ampere和Hopper算力分析

AI大语言模型原理、演进及算力测算

大算力模型,HBM、Chiplet和CPO等技术打破技术瓶颈

走进芯时代:AI算力GPU行业深度报告

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。