Celestial AI公司在其芯片中采用了一种热稳定的光学调制器,功耗数百瓦。这种设计消除了对数字信号处理器(DSP)的需求,因为其具有高信噪比(SNR)、低比特错误率(BER),光学元件实现了电子元件的优势。

来源:Celestial AI

Celestial的光互联模块(Photonic Fabric Module)拥有2.07TB的内存容量,并且提供7.2Tbps的带宽,延迟仅为100纳秒。该公司的设备包含916个模块,能够支持高达115Tbps的网络交换,为后端/扩展AI提供33Tb的内存容量。

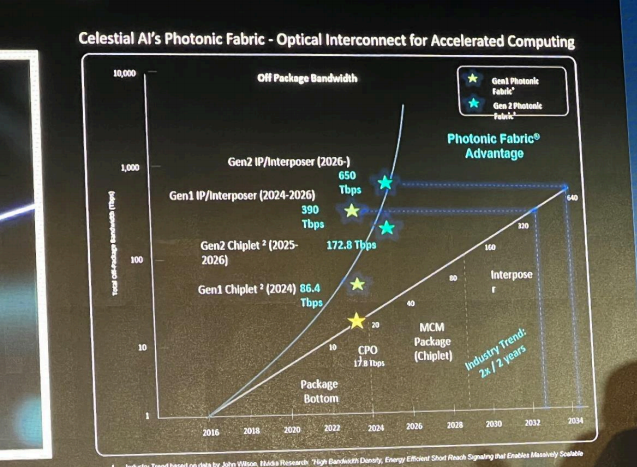

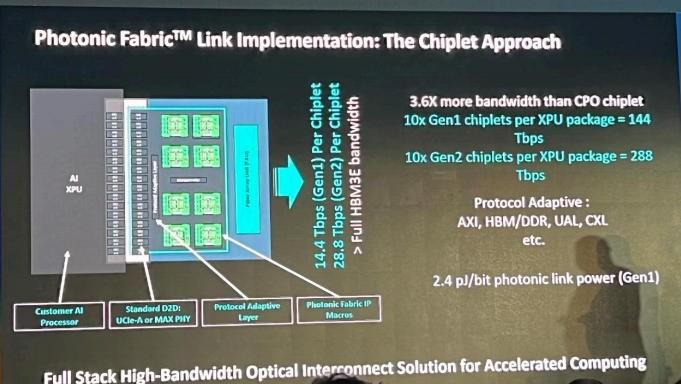

在光纤的另一端,是一个光学芯片,其提供的带宽是CPO(Chiplet Process Optical)芯片的3.6倍。它比HBM堆叠所需的空间更少。

一个连接到光互联设备的16-XPU系统能够处理具有10T参数的模型!

来源:Celestial AI

对于推理而言,一个传统的AI服务器,配备3TB的HBM,只会有大约1.2Tb的可用内存。而这个方案的16-XPU系统能够提供34.2TB的可用内存。在芯片级别,带宽提高了3.6倍,RDMA延迟降低了5倍,能效降低了8倍,并且每GB的成本降低了26倍。

实际上,这有助于降低AI的成本,有效处理非常大的模型,支持更长的上下文长度,加速多模态,简化软件堆栈,并减轻能源需求。

内容来源:AI Hardware Summit 2024

高端微信群介绍 | |

创业投资群 | AI、IOT、芯片创始人、投资人、分析师、券商 |

闪存群 | 覆盖5000多位全球华人闪存、存储芯片精英 |

云计算群 | 全闪存、软件定义存储SDS、超融合等公有云和私有云讨论 |

AI芯片群 | 讨论AI芯片和GPU、FPGA、CPU异构计算 |

5G群 | 物联网、5G芯片讨论 |

第三代半导体群 | 氮化镓、碳化硅等化合物半导体讨论 |

存储芯片群 | DRAM、NAND、3D XPoint等各类存储介质和主控讨论 |

汽车电子群 | MCU、电源、传感器等汽车电子讨论 |

光电器件群 | 光通信、激光器、ToF、AR、VCSEL等光电器件讨论 |

渠道群 | 存储和芯片产品报价、行情、渠道、供应链 |

< 长按识别二维码添加好友 >

加入上述群聊

带你走进万物存储、万物智能、

万物互联信息革命新时代