过去的十几年是通算中心(传统数据中心)快速发展的阶段,主要以云计算为主。随着生成式人工智能(AIDC)的横空出世,人工智能(AI)在医疗、金融、制造业、零售业和交通运输等领域产生了广泛的应用需求,通算中心(传统数据中心)已经逐渐无法满足日益增长的计算需求。

智算中心(AIDC)应运而生,它支持大规模的数据处理、机器学习、深度学习和其他智能算法的运算需求,得益于人工智能的革命性发展,智算中心的规模和处理能力正在呈指数级增长,以满足日益增长的算力需求。智算中心已成为通算中心(传统数据中心)升级发展的必然趋势。

算力分类:按照系统构成、技术特征和应用领域的差异,算力可分为三类:通用算力、超算算力和智能算力。

由于超算中心属于高度定制化的算力中心,不在本白皮书的讨论范围内。本白皮书将重点讨论通用算力中心(简称通算中心,即传统数据中心)向人工智能(AI)算力中心(简称智算中心)的演进。

智算业务:智算业务在应用中包括两个环节:训练和推理。

智算业务发展趋势:根据IDC的统计数据,2022年部署的智算算力里,训练算力占比为41.5%,推理算力占比达到58.5%;预计到2026年,推理算力的占比将会提升到62.2%,训练算力降低到37.8%。这种趋势也符合智算被广泛应用的科学的比例变化,而随着推理算力的普及,生成式人工智能(AIGC)的应用将引起范式革命。

智算芯片结构演进

智算算力(智算中心)和通用算力(传统数据中心)在服务器芯片结构上存在本质的差异。

通用算力芯片架构相对单一,主要以CPU为算力核心,基于CPU和云存储集群提供的相关云服务,通常由多个物理服务器组成,通过网络连接形成一个虚拟化的计算环境。

智算算力则通常采用芯片异构计算架构,结合CPU、GPU、NPU、TPU等多种芯片,形成高并发的分布式计算系统,应用于神经网络模型的训练及推理等。

除算力芯片外,智算中心的存储芯片也存在差异化的需求,例如更大的DRAM和NAND容量,以及存算一体技术的应用,以解决冯·诺依曼架构中的存储墙问题等。

从芯片结构演进来看,通算中心(传统数据中心)侧重于通用计算任务的性价比和灵活性,而智算中心注重人工智能(AI)类型的特定计算需求及运算效率,并要求具有强大的图形处理功能,需要制定人工智能(AI)算力硬件和存储解决方案,以满足其人工智能(AI)高性能计算需求。

智算用户诉求演进

智算中心的用户诉求则来自于智算训练业务。为确保大模型训练的效率和成本最优,智算训练业务需要建立高度集中化的GPU集群。这是因为,基于GPU的分布式工作原理,如果需要在减少训练时间的同时降低训练的成本,那么,必须在更小的物理空间内部署更多的GPU服务器,从而突破分布式计算因带宽和传输距离产生的运算瓶颈,提高集群算效,因此,智算训练业务需要建立高度集中化的GPU集群。

风冷机柜

国产GPU,以华为910B为例,单机柜部署2台风冷智算服务器,功耗约11.2kW。

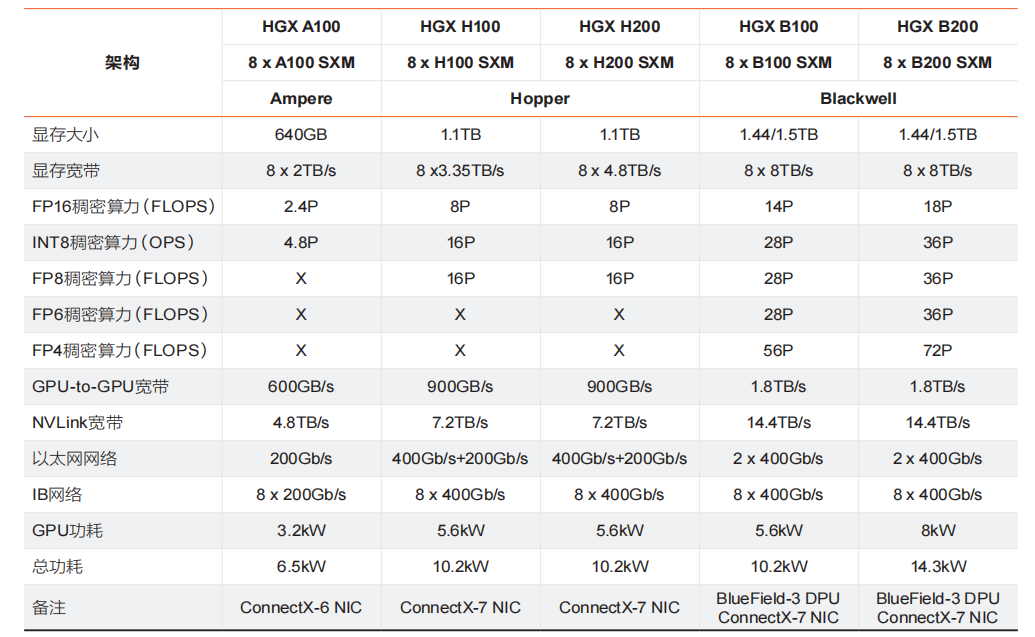

英伟达(NVIDIA)以HGX服务器为例,HGX是NVIDIA的高性能服务器,通常一台机器包含8个或4个GPU,以8个H100为例,单台服务器功耗约10.2kW,若选用B200芯片,单台服务器设计功耗14.3kW。在智算中心的规划中,通常会考虑到IB线缆等综合成本,单机柜部署2台HGX风冷智算服务器,含上IB交换机等,单机柜功耗高达24kW左右

液冷机柜

国产GPU,单机柜8台液冷智算服务器,总功耗约42.4kW。

英伟达(NVIDIA)GPU,从NVL32机柜到NVL72机柜,单机柜部署4台服务器至9台服务器,GPU数量从32颗到72颗,总功耗也从44kW(为推测的数据)增加到120kW。

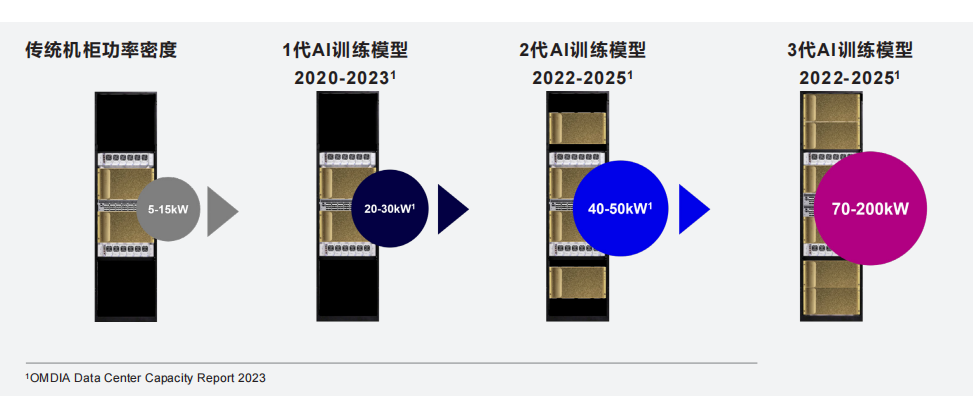

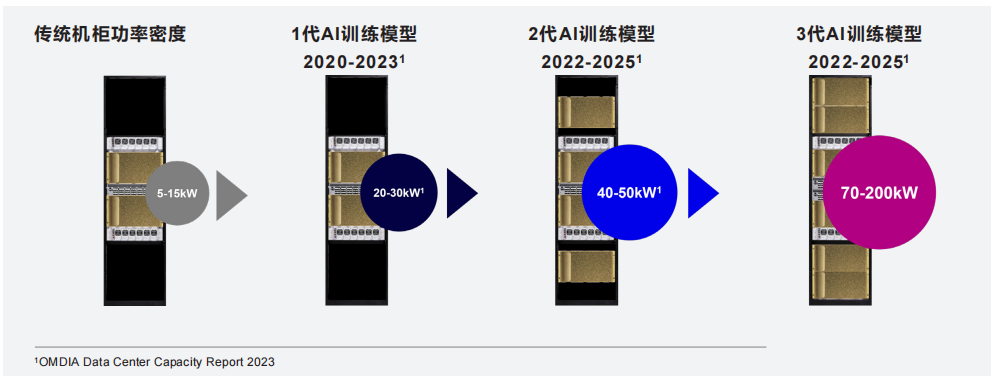

因此,单机柜功耗从通算中心(传统数据中心)的4~6KW的逐渐增加至智算中心(AIDC)的20~40kW,未来逐步发展至40~120kW甚至还要更高,智算中心机柜呈现高密度化趋势。这将导致智算中心在IT负载和市电引入规模上大大高于通算中心,也意味着将消耗更多的能源,同时也对资源产生众多新的需求,这些内容在接下来的章节中将会进行详细描述。

智算中心选址

通算中心(传统数据中心)的选址通常选在经济发达的城市及周边区域,靠近终端客户,可以有效降低网络时延。智算中心的选址会趋向于靠近终端客户的核心城市还是资源丰富的偏远地区?

这些偏远地区在能源、电价、气候和政策方面的优势,可以降低智算中心的建设和运营成本,提高智算中心的市场竞争力。另外,智算中心选址的决策,并非只关注电价,还需全面考量整体资源设施(如水资源是否充沛)、政策环境、市场需求等多重因素,以寻找经济活动丰富与能源费用的平衡点。

网络规划和部署,目前已成为智算中心应用的趋势。当然,这样做法的同时必须满足当地消防要求,并采取相应的漏水封堵措施。另外,在层高和承重方面,智算中心也提出了相应的提升要求。

层高方面,采用风冷或风液混合制冷方案的智算中心,由于智算中心的功率密度更高,单位空间内需要部署更多的管线,因此对层高提出更高要求,通常智算中心的层高普遍在5.0~6.5米。

承重方面,TIA-942-C标准对Rated-3和Rated-4级对数据中心楼层活载荷的要求是不低于12KN/M²,而对于智算中心来说,对楼层活载荷的要求可能会更高,例如为部署液冷,楼层活载荷的要求达到18KN/M²甚至更高。

智算中心制冷系统架构

智算中心的单机柜功耗已经有大幅提升。从单机柜20~30KW,到单机柜40~50kW,到单机柜70~132kW,以及未来可能达到的的200kW超高功率密度单机柜,智算中心呈现加速高密化的趋势。

房间级风冷空调远端送风型式的散热能力上限为单机柜25kW,当单机柜功耗超过25kW时,房间级风冷空调很难满足服务器的散热需求。

对于单机柜功耗在25~80kW的高密度散热需求,可采用列间空调、背板式风冷、薄板风墙等近端送风或冷板液冷技术,其中液冷技术因具有高效散热、低能耗、低噪声、占地面积小等突出的优势,成为智算中心制冷系统的优先选择。

现阶段风冷高密和液冷高密方案并存,液冷采用冷板式液冷的型式居多,至于选择风液混合还是全风冷则取决于不同的需求及项目条件。

智算中心预制模块化技术发展趋势

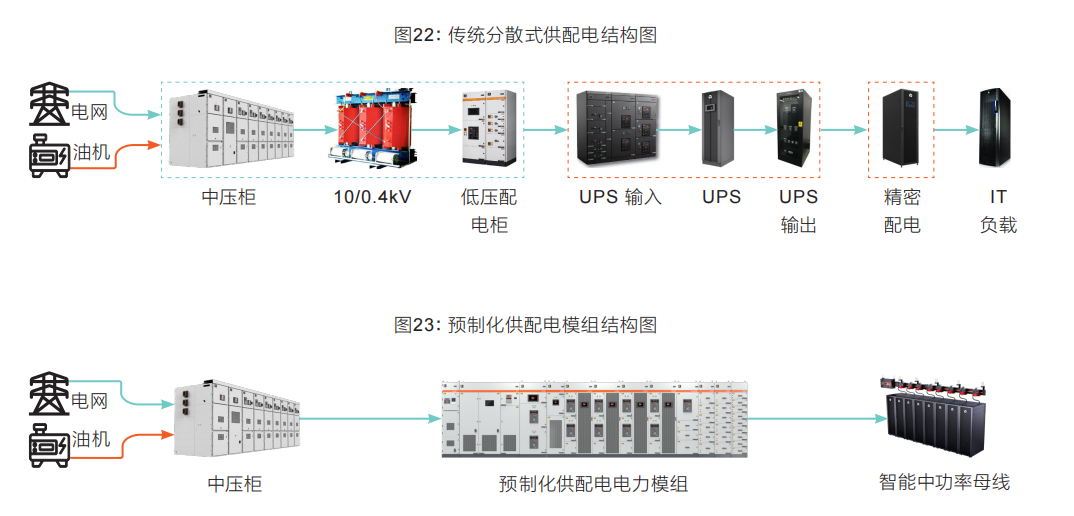

从智算中心的业务启动开始,如何对其近期和长期成本曲线做到更多的掌控,以便能选择最适合其业务需求的运营成本模型,并在新的算力上线时提供可预测和透明的成本结构,是智算中心重点考虑的问题。因此,成本确定性及灵活

可扩容性将是衡量智算中心业务可行性及可持续发展的的重要标准之一。

预制模块化技术在智算中心项目中大范围的使用,可有效加快建设进度。预制模块化技术将建造过程从现场搭建转移到工厂生产线进行,因其不受场地空间及设备现场安装工序的限制,可实现多模块的并行生产和流水线式的撬装总成,以批量化和标准化的方式生产数据中心模块、功能设备模块(例如,电力模块、空调模块等)、软件环境等组件,通过标准化生产和工程化管理,大幅缩短智算中心的建设周期。

这种多系统融合的预制模块化解决方案(见图28),按规模可分为:

机柜级推理与边缘人工智能(AI)(70kW/柜),适用于需要快速设置且空间有限的场景,例如远程办公室、分支机构、边缘计算站点等

行级&房间级企业和数据中心(40~100kW/柜),适用于人工智能(AI)实验室、推理及模型训练以及既有数据中心的空白间

基础设施&数据中心级(132kW/柜),为整体预制模块化数据中心,适用于人工智能(AI)大模型训练及人工智能(AI)数据中心

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。